دليل معالجة الصوت

يغطي هذا الدليل كيفية إعداد طرق إدخال صوتية مختلفة لتغذية بيانات الصوت إلى مولدات مزامنة الشفاه الخاصة بك. تأكد من إكمال دليل الإعداد قبل المتابعة.

معالجة إدخال الصوت

تحتاج إلى إعداد طريقة لمعالجة إدخال الصوت. هناك عدة طرق للقيام بذلك اعتمادًا على مصدر الصوت الخاص بك.

- الميكروفون (في الوقت الحقيقي)

- الميكروفون (إعادة التشغيل)

- تحويل النص إلى كلام (محلي)

- تحويل النص إلى كلام (واجهات برمجة تطبيقات خارجية)

- من ملف/مخزن مؤقت للصوت

- مخزن مؤقت للصوت بالبث

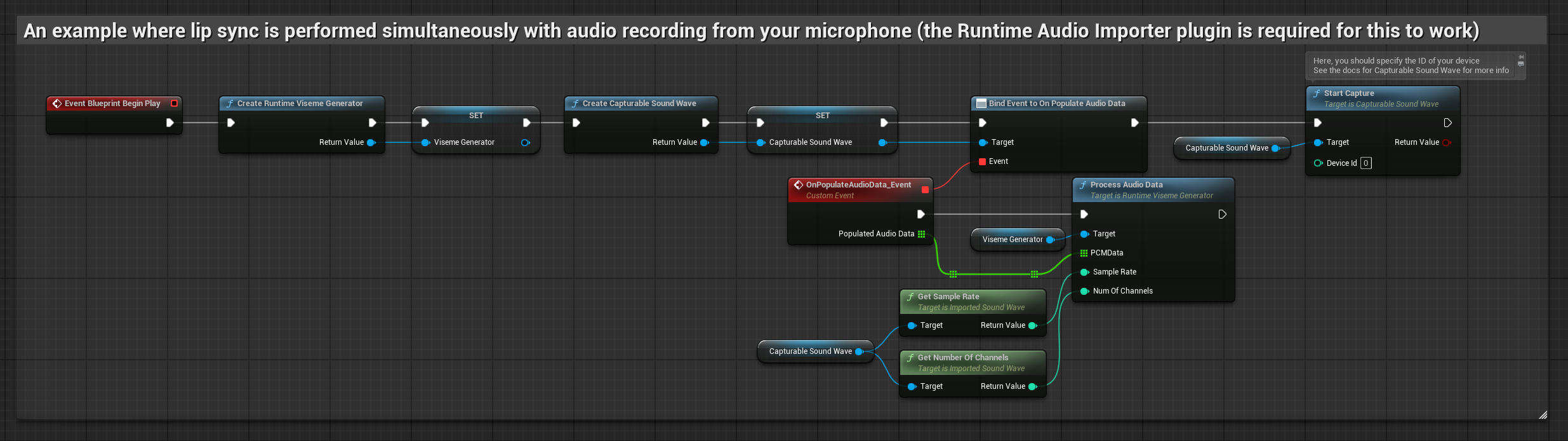

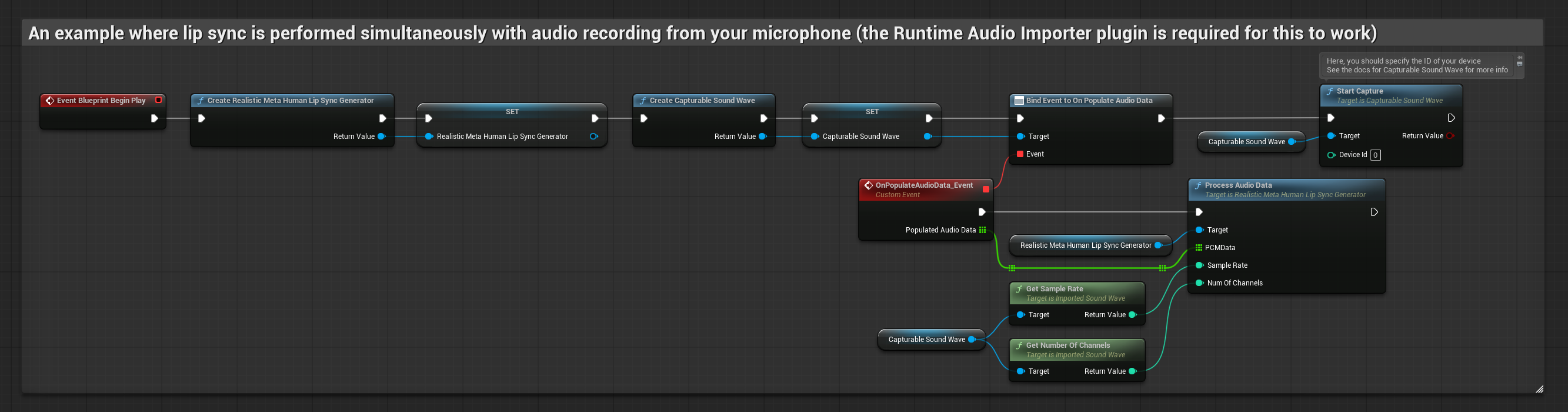

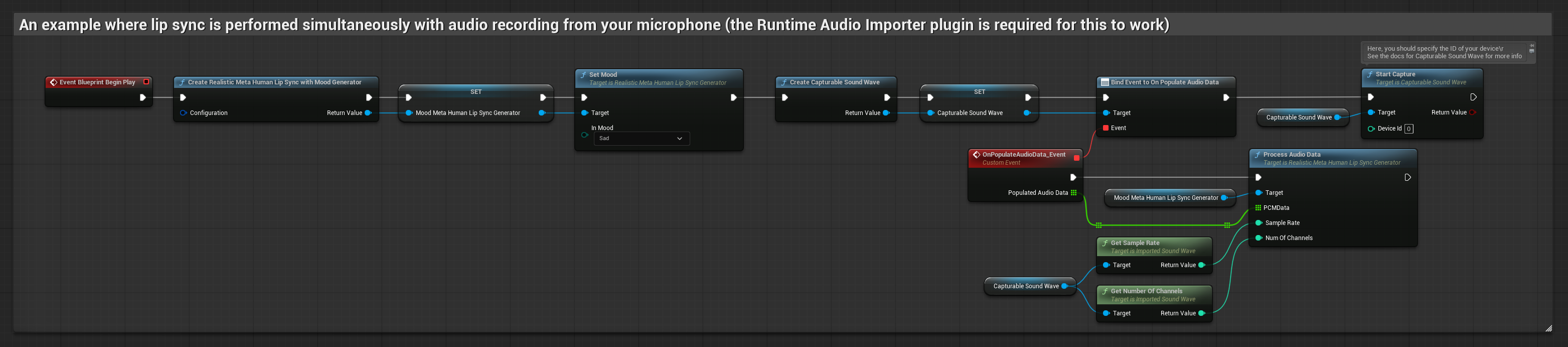

يقوم هذا النهج بأداء مزامنة الشفاه في الوقت الحقيقي أثناء التحدث في الميكروفون:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- قم بإنشاء Capturable Sound Wave باستخدام Runtime Audio Importer

- بالنسبة لنظام Linux مع Pixel Streaming، استخدم Pixel Streaming Capturable Sound Wave بدلاً من ذلك

- قبل البدء في التقاط الصوت، قم بالربط مع مندوب

OnPopulateAudioData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك - ابدأ في التقاط الصوت من الميكروفون

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

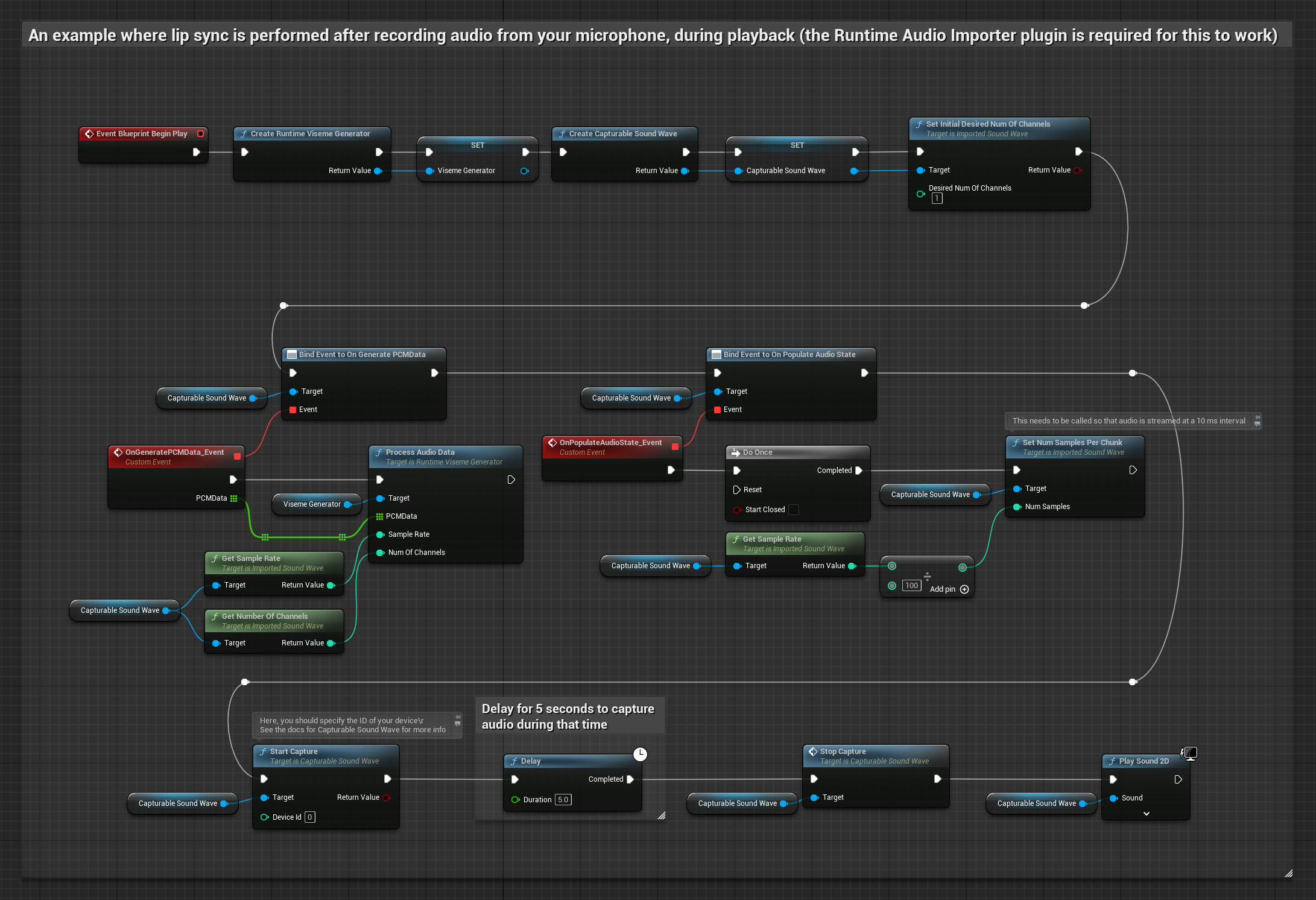

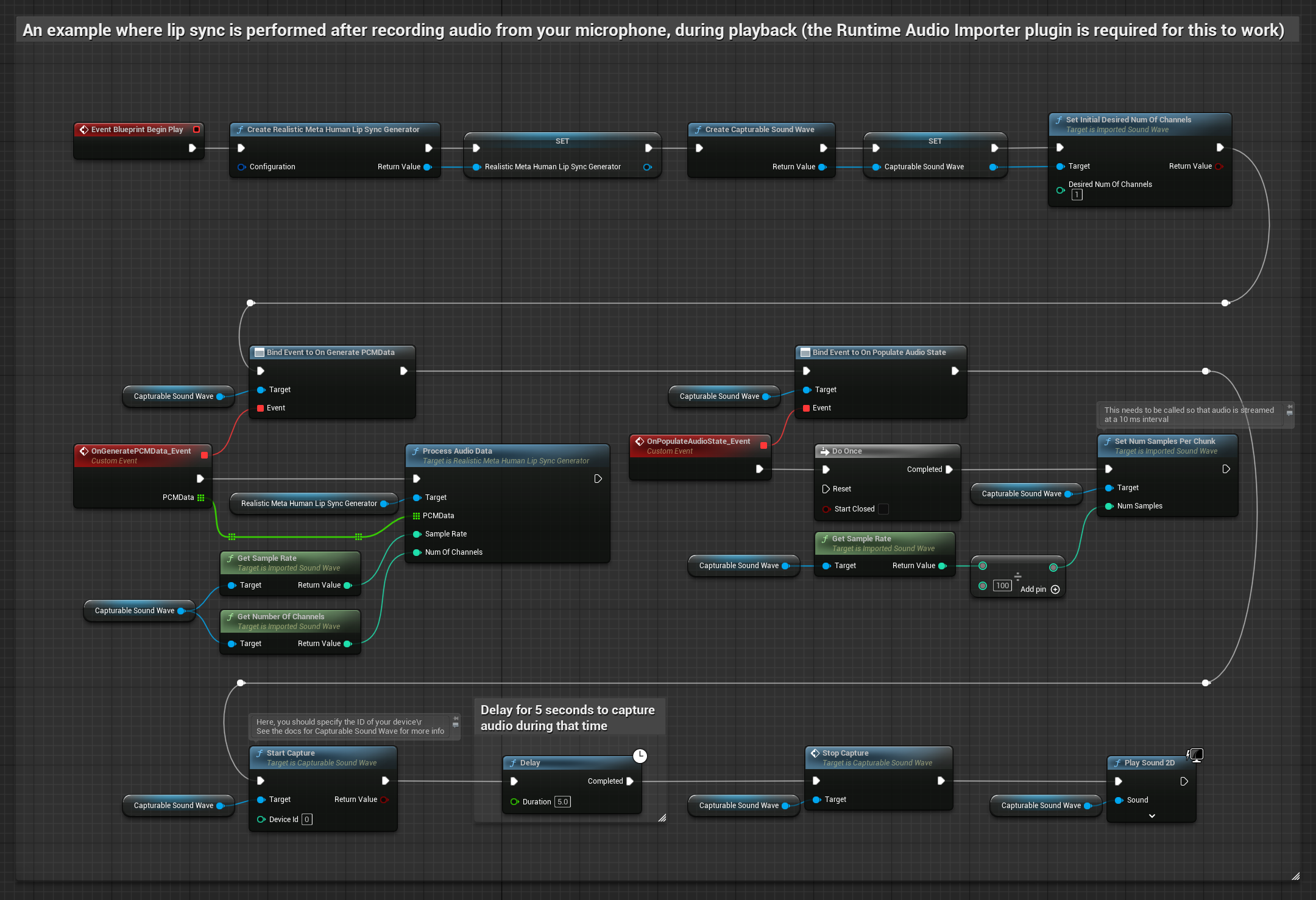

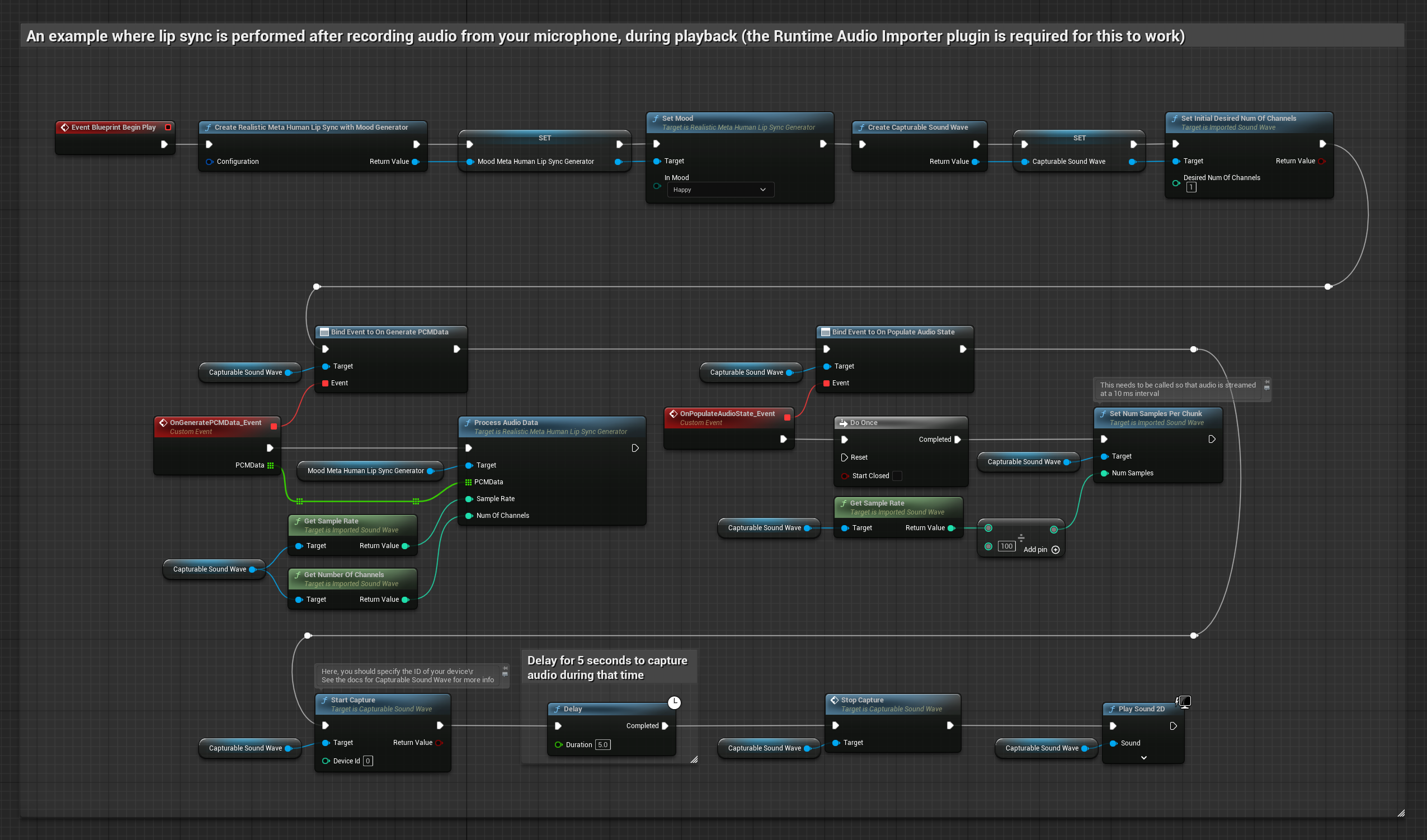

يقوم هذا النهج بالتقاط الصوت من ميكروفون، ثم يعيد تشغيله مع مزامنة الشفاه:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- قم بإنشاء Capturable Sound Wave باستخدام Runtime Audio Importer

- بالنسبة لنظام Linux مع Pixel Streaming، استخدم Pixel Streaming Capturable Sound Wave بدلاً من ذلك

- ابدأ في التقاط الصوت من الميكروفون

- قبل إعادة تشغيل Capturable Sound Wave، قم بالربط مع مندوبه

OnGeneratePCMData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

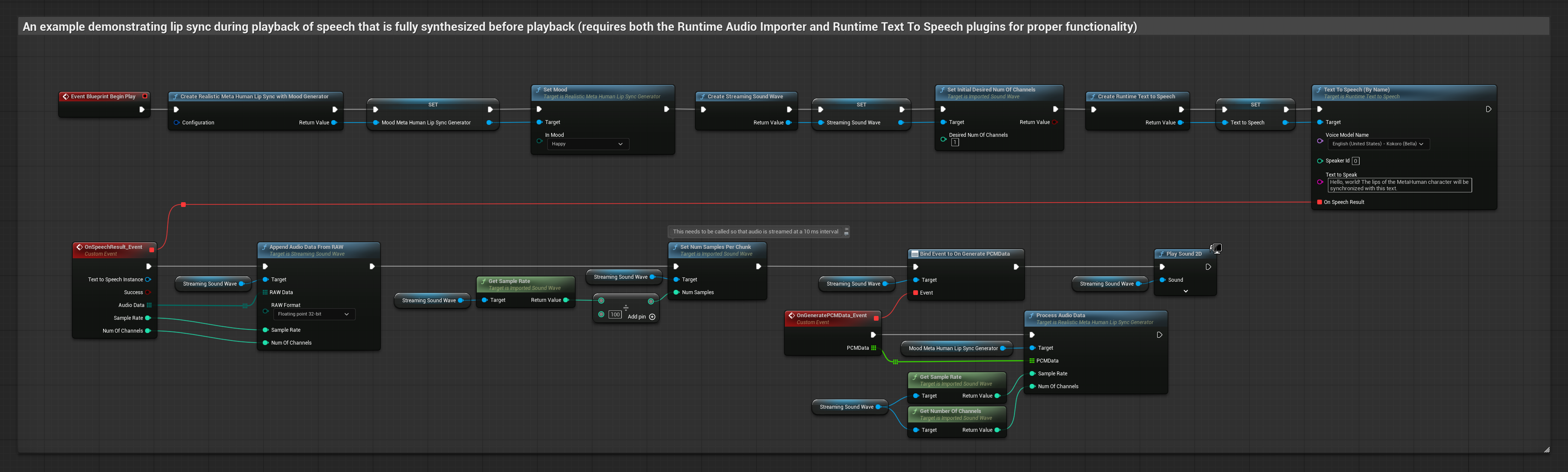

- عادي

- بث

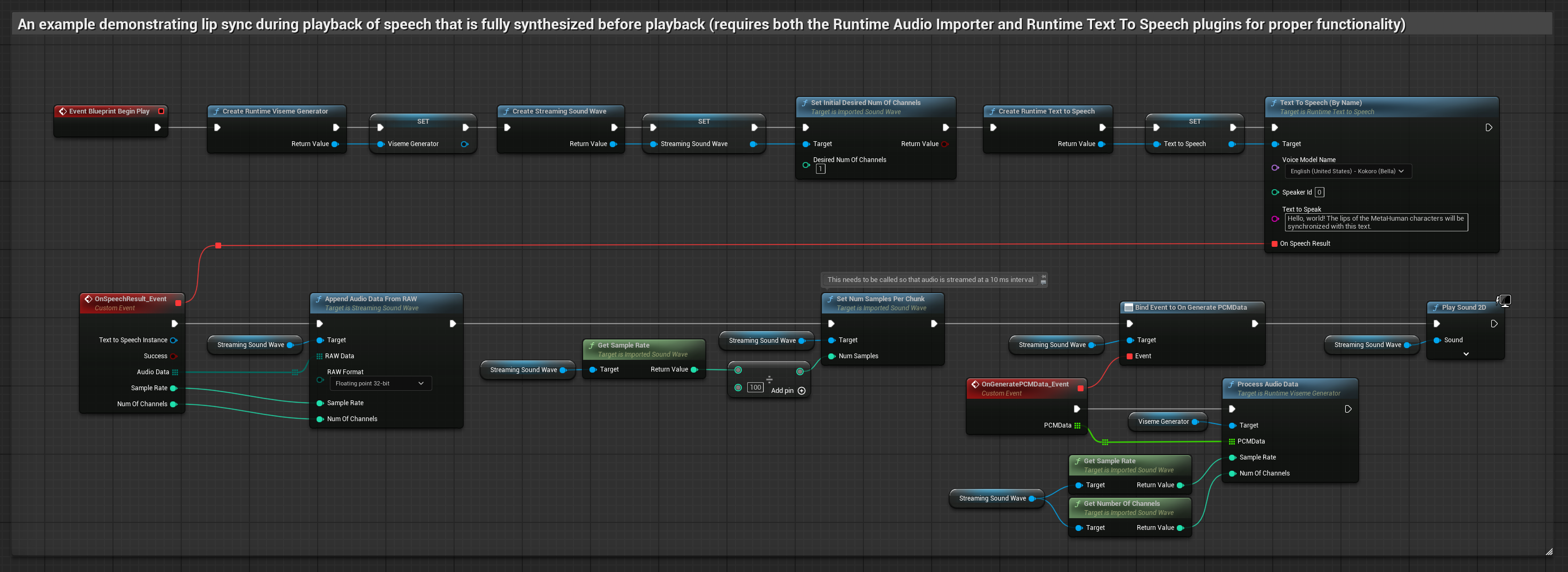

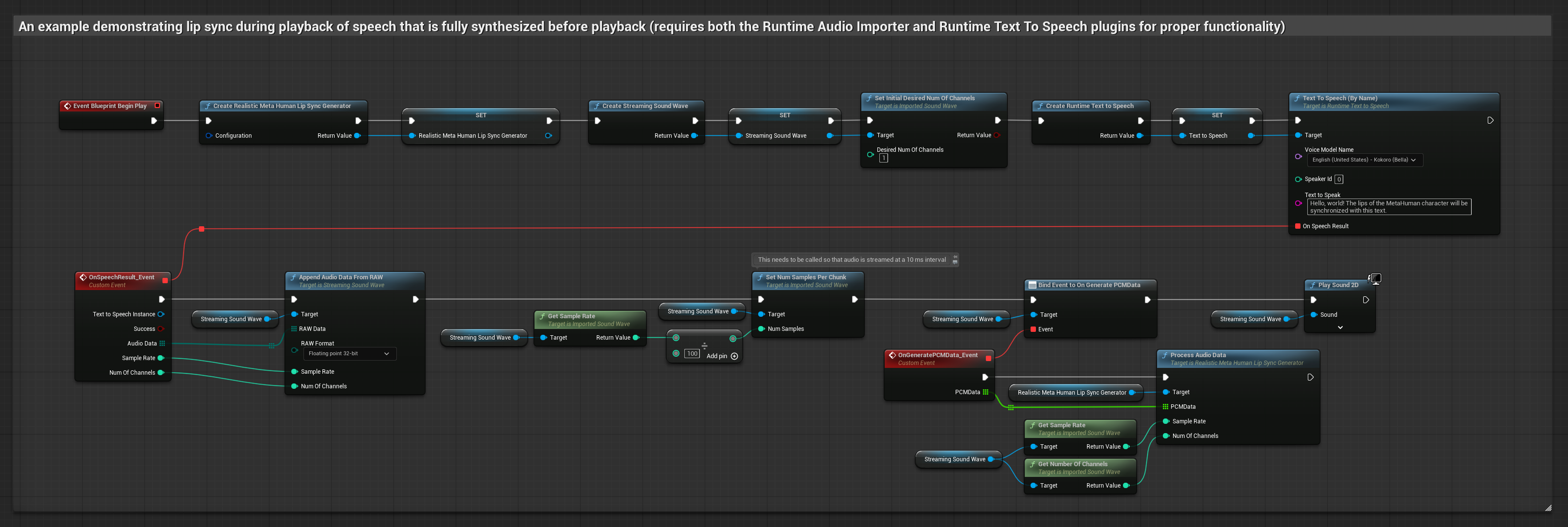

يقوم هذا النهج بتركيب الكلام من النص باستخدام TTS محلي ويقوم بأداء مزامنة الشفاه:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- استخدم Runtime Text To Speech لتوليد الكلام من النص

- استخدم Runtime Audio Importer لاستيراد الصوت المركب

- قبل إعادة تشغيل الصوت المستورد، قم بالربط مع مندوبه

OnGeneratePCMData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

يستخدم هذا النهج تركيب تحويل النص إلى كلام بالبث مع مزامنة الشفاه في الوقت الحقيقي:

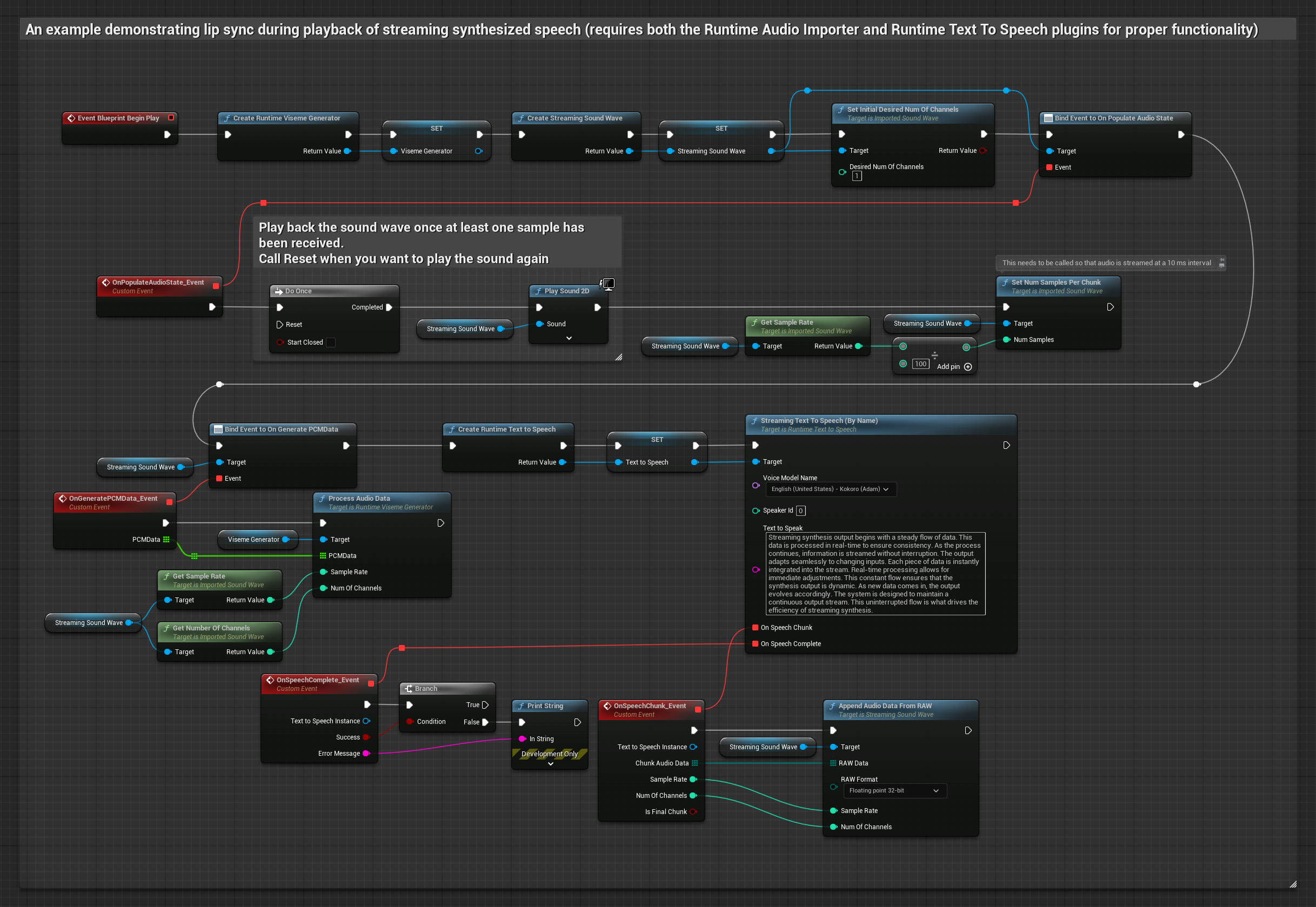

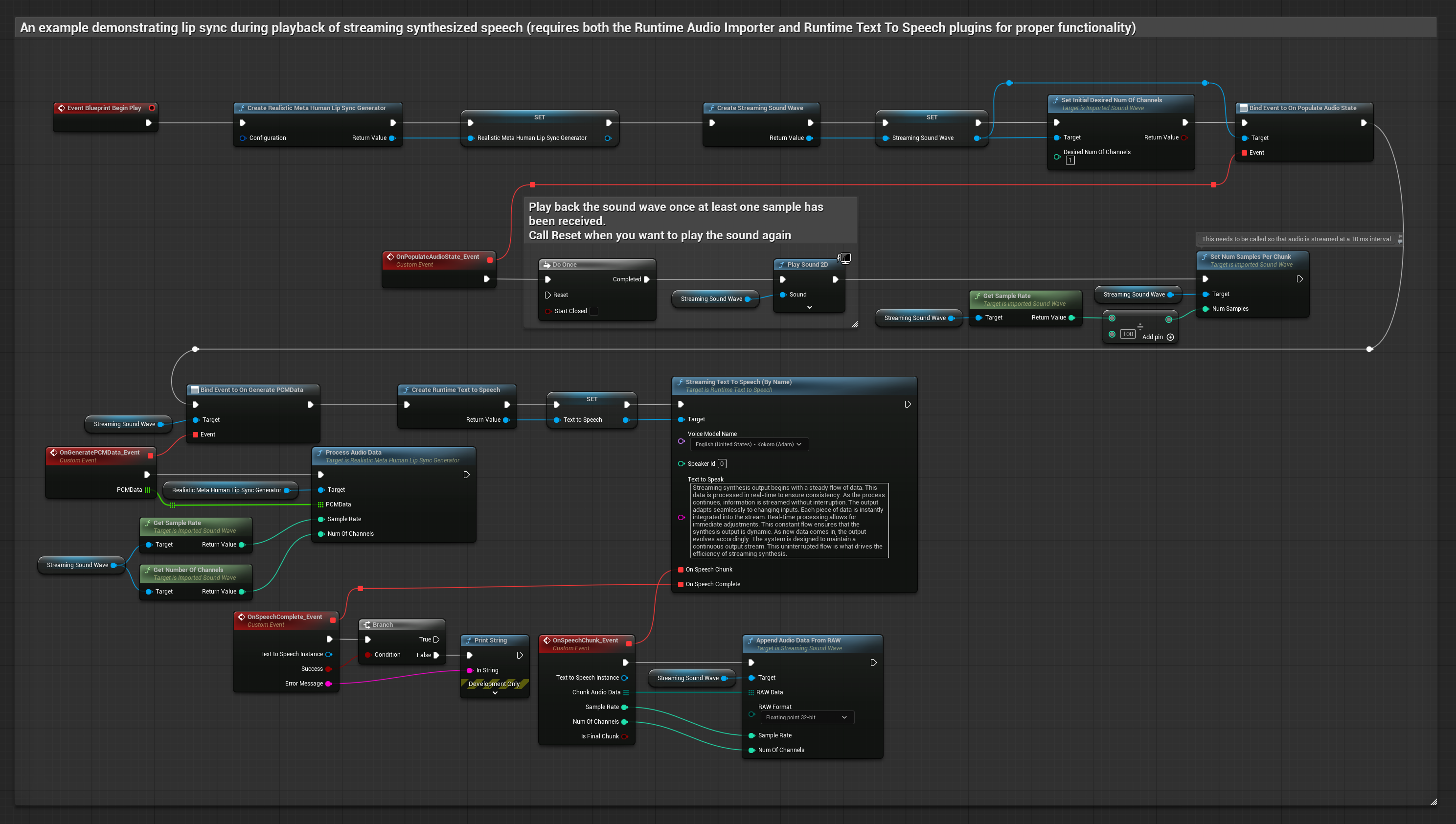

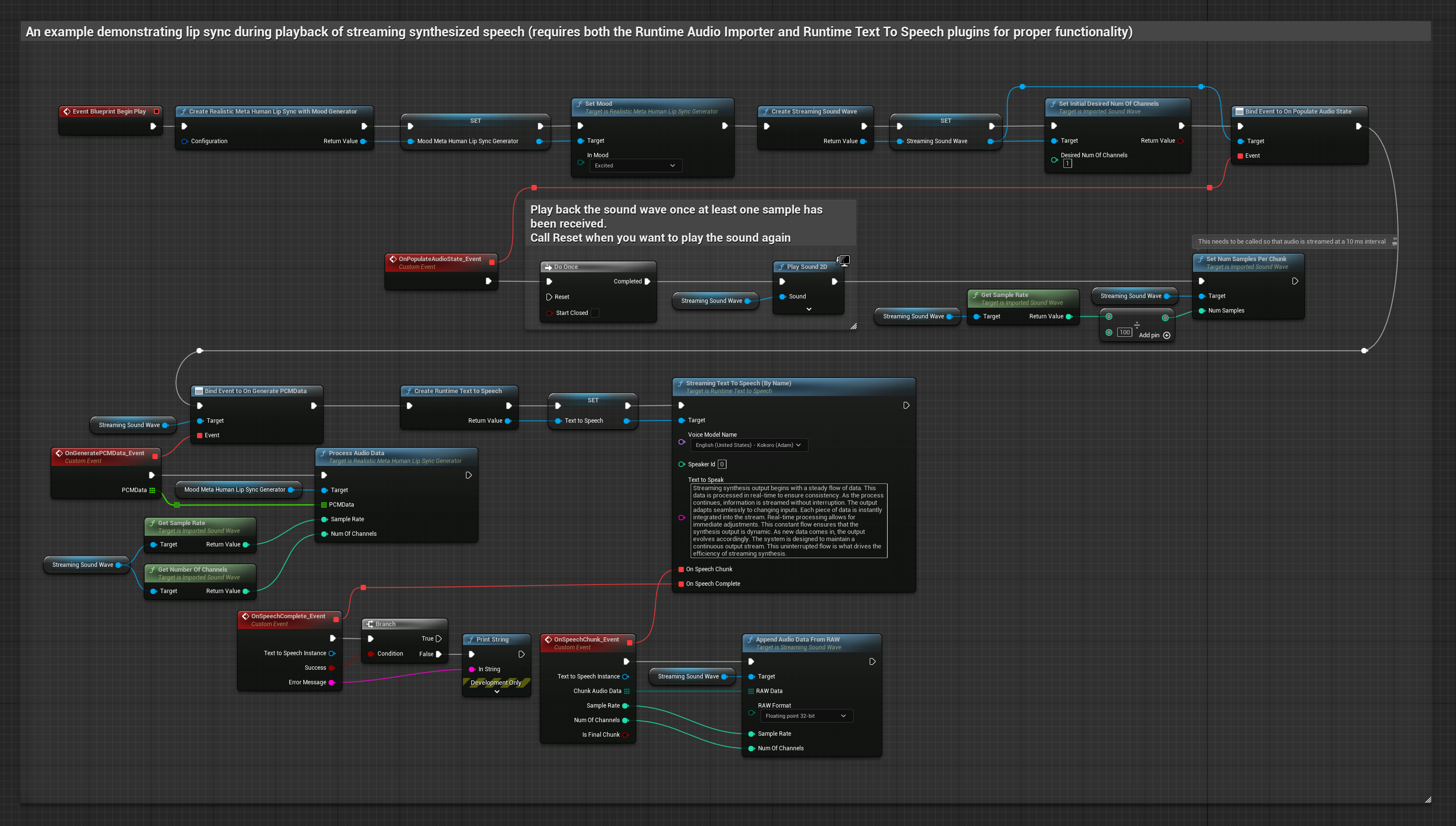

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- استخدم Runtime Text To Speech لتوليد كلام بالبث من النص

- استخدم Runtime Audio Importer لاستيراد الصوت المركب

- قبل إعادة تشغيل الصوت بالبث، قم بالربط مع مندوبه

OnGeneratePCMData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

- عادي

- بث

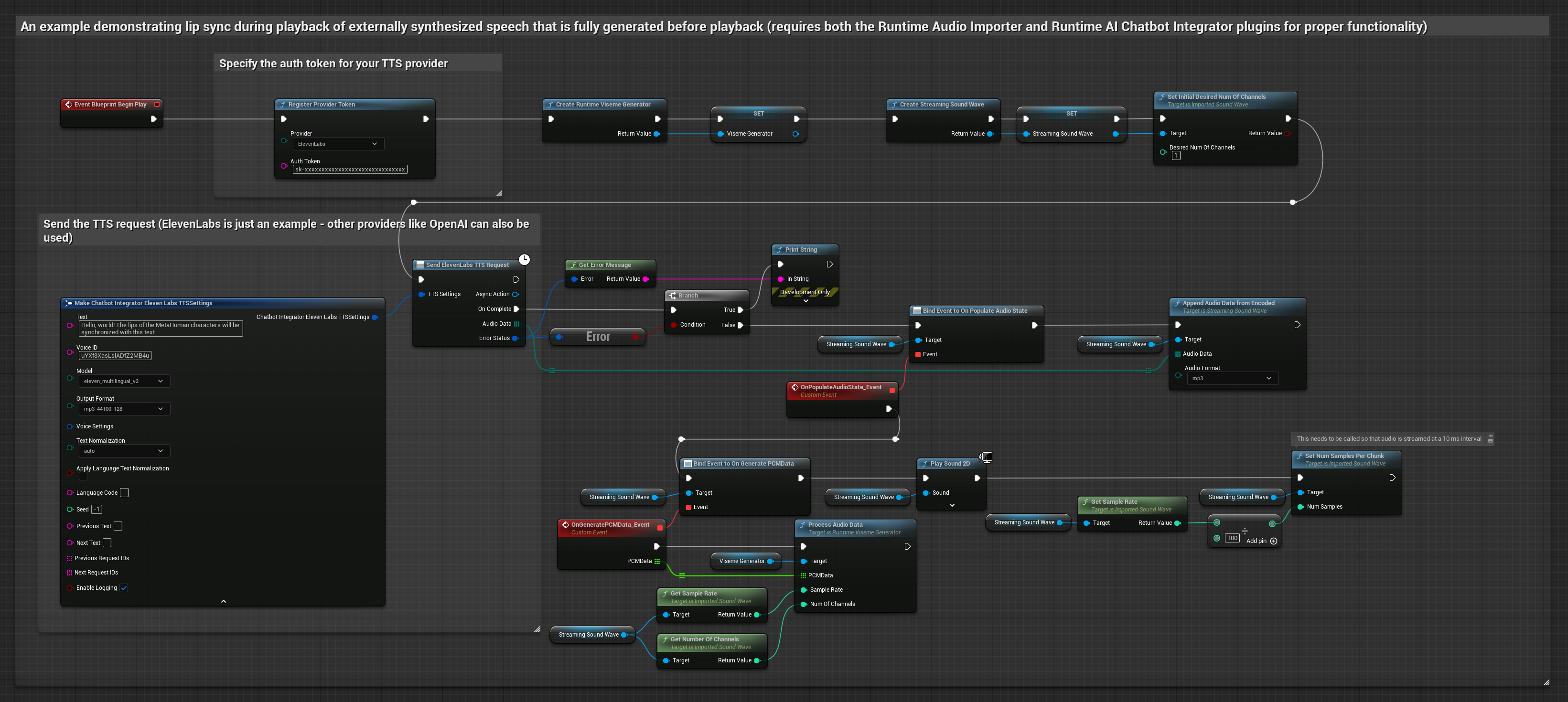

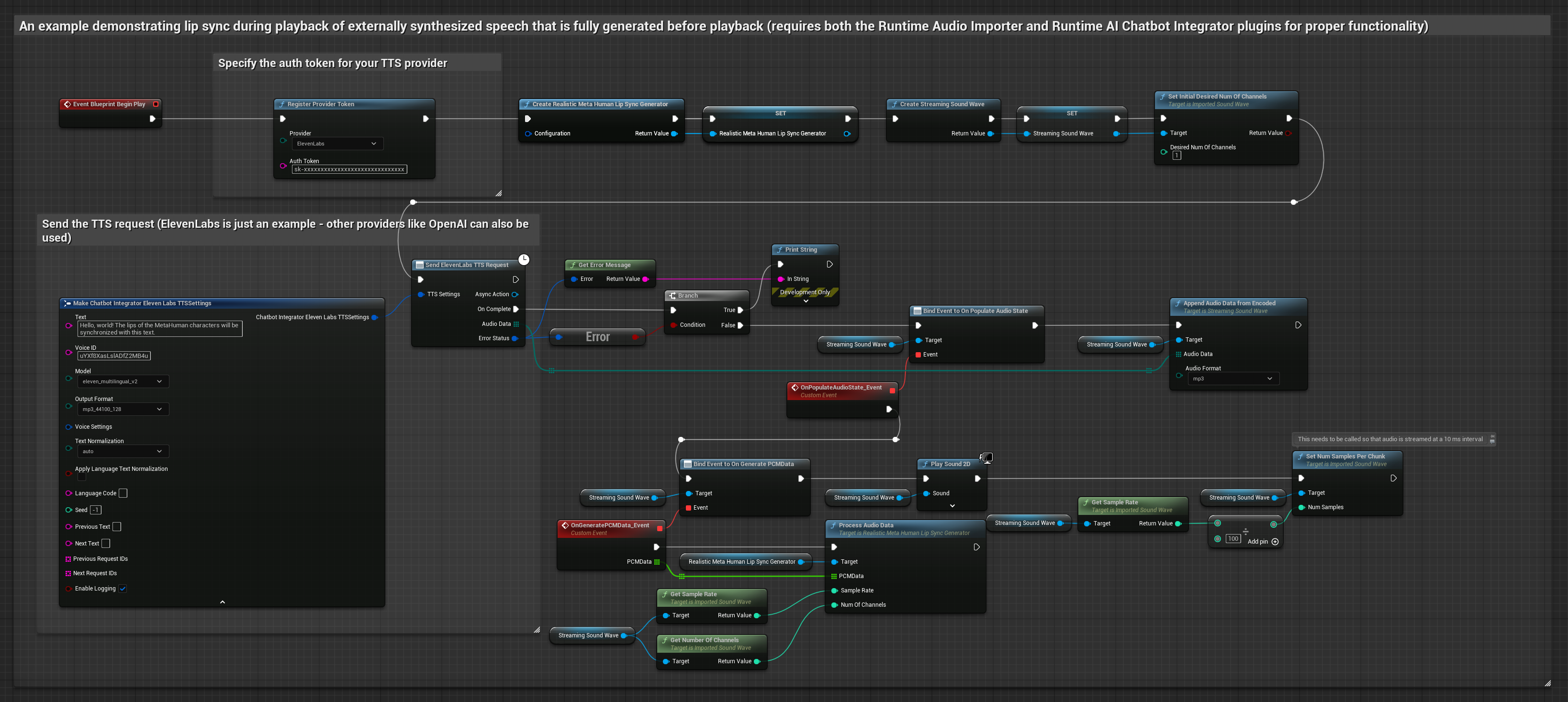

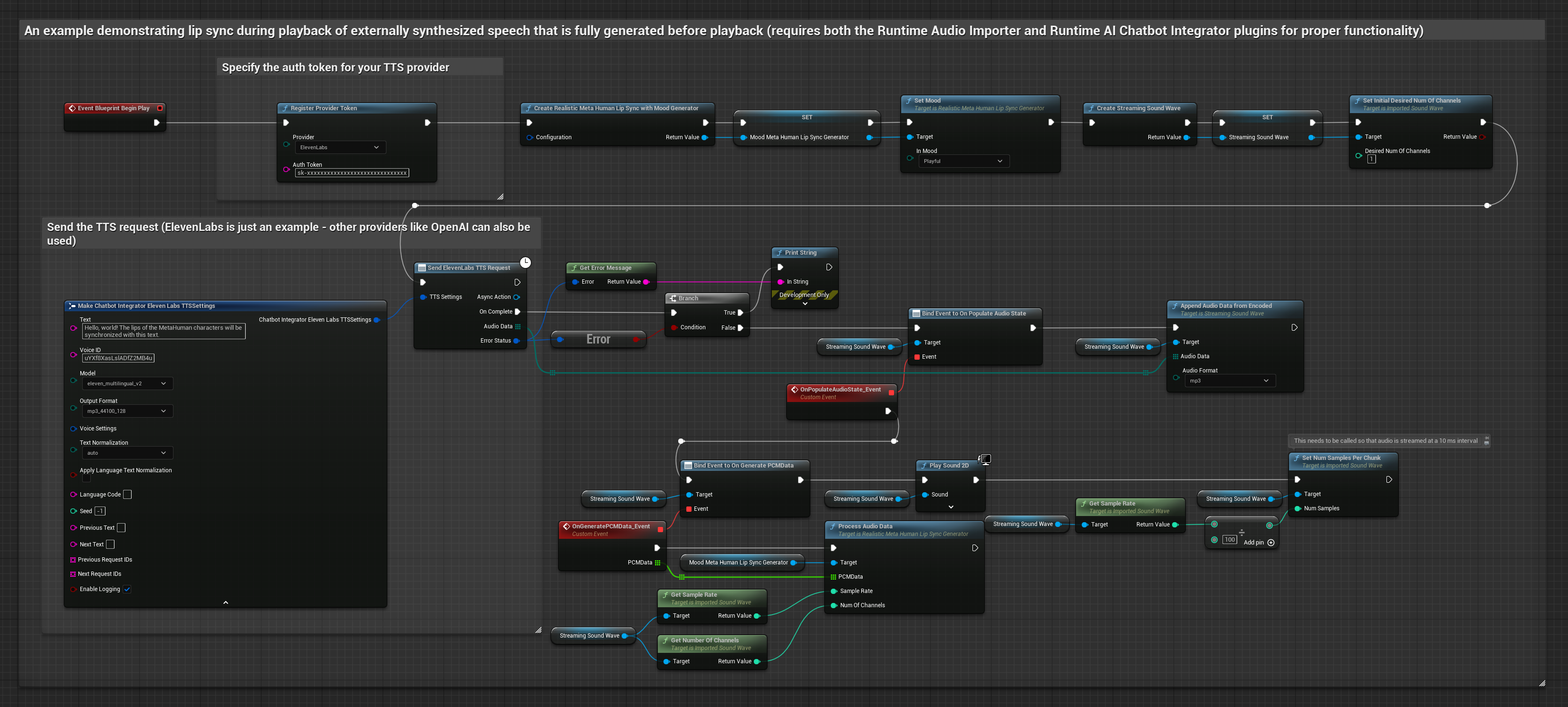

يستخدم هذا النهج إضافة Runtime AI Chatbot Integrator لتوليد كلام مركب من خدمات الذكاء الاصطناعي (OpenAI أو ElevenLabs) وأداء مزامنة الشفاه:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- استخدم Runtime AI Chatbot Integrator لتوليد الكلام من النص باستخدام واجهات برمجة تطبيقات خارجية (OpenAI، ElevenLabs، إلخ.)

- استخدم Runtime Audio Importer لاستيراد بيانات الصوت المركبة

- قبل إعادة تشغيل الصوت المستورد، قم بالربط مع مندوبه

OnGeneratePCMData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

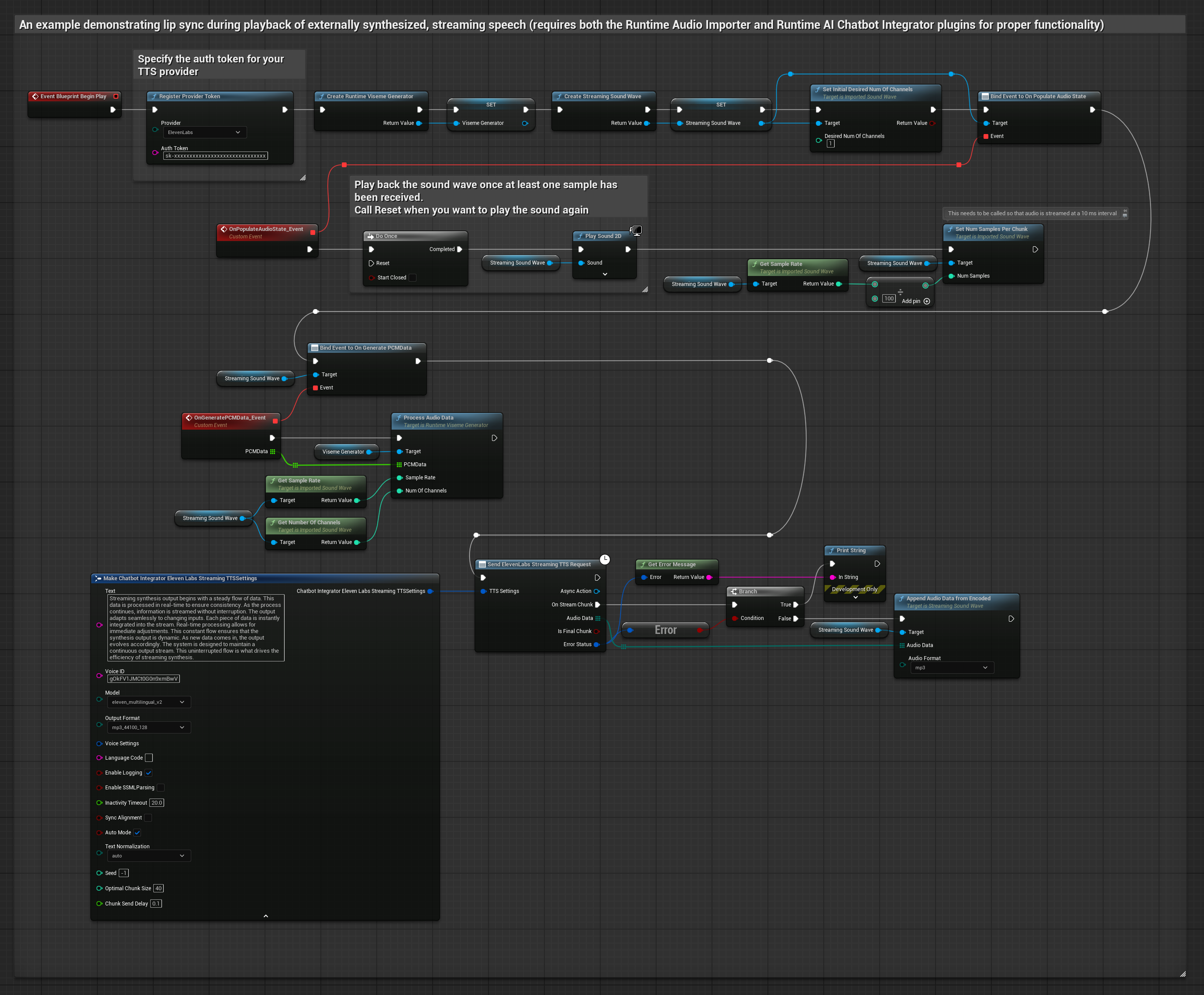

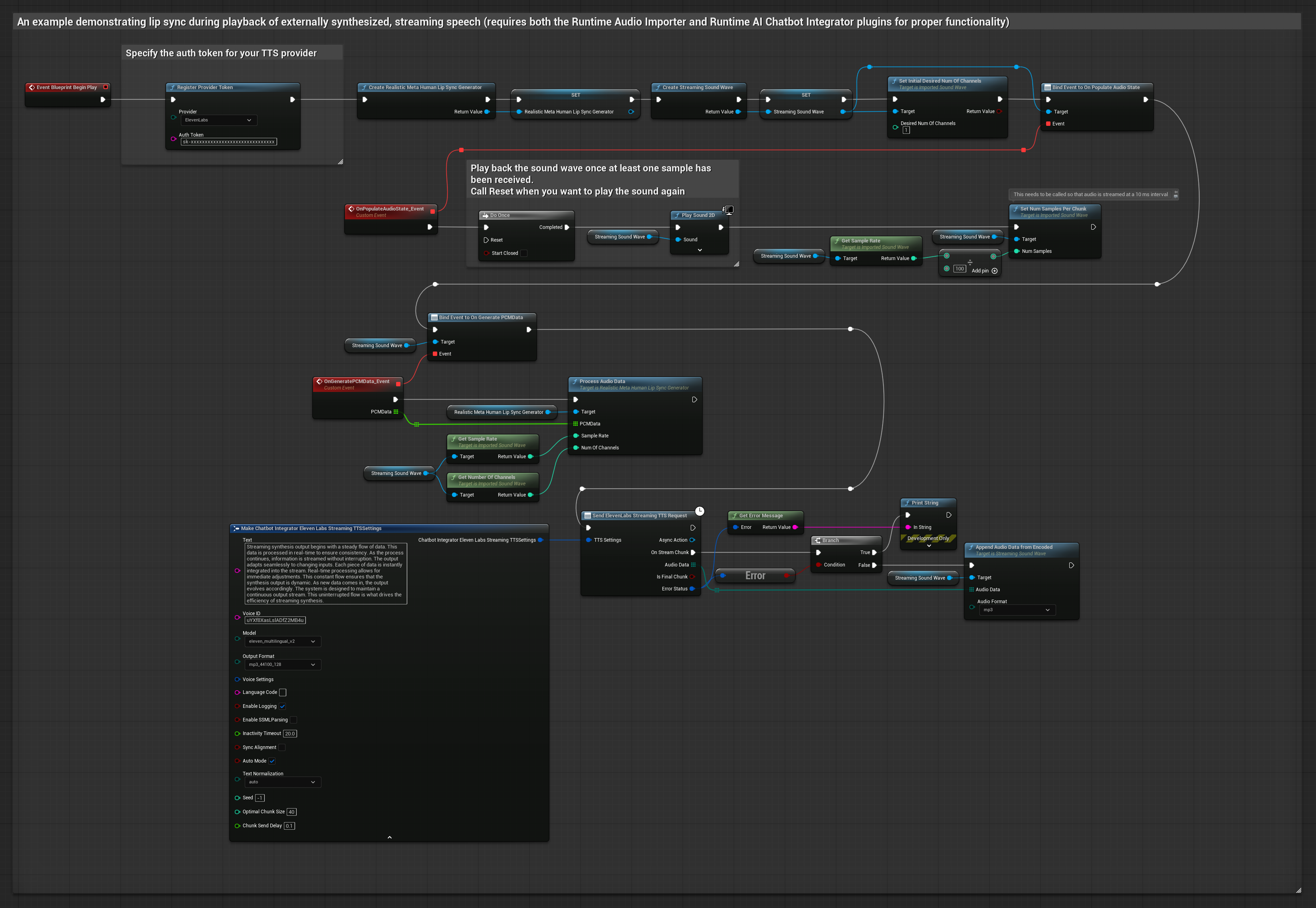

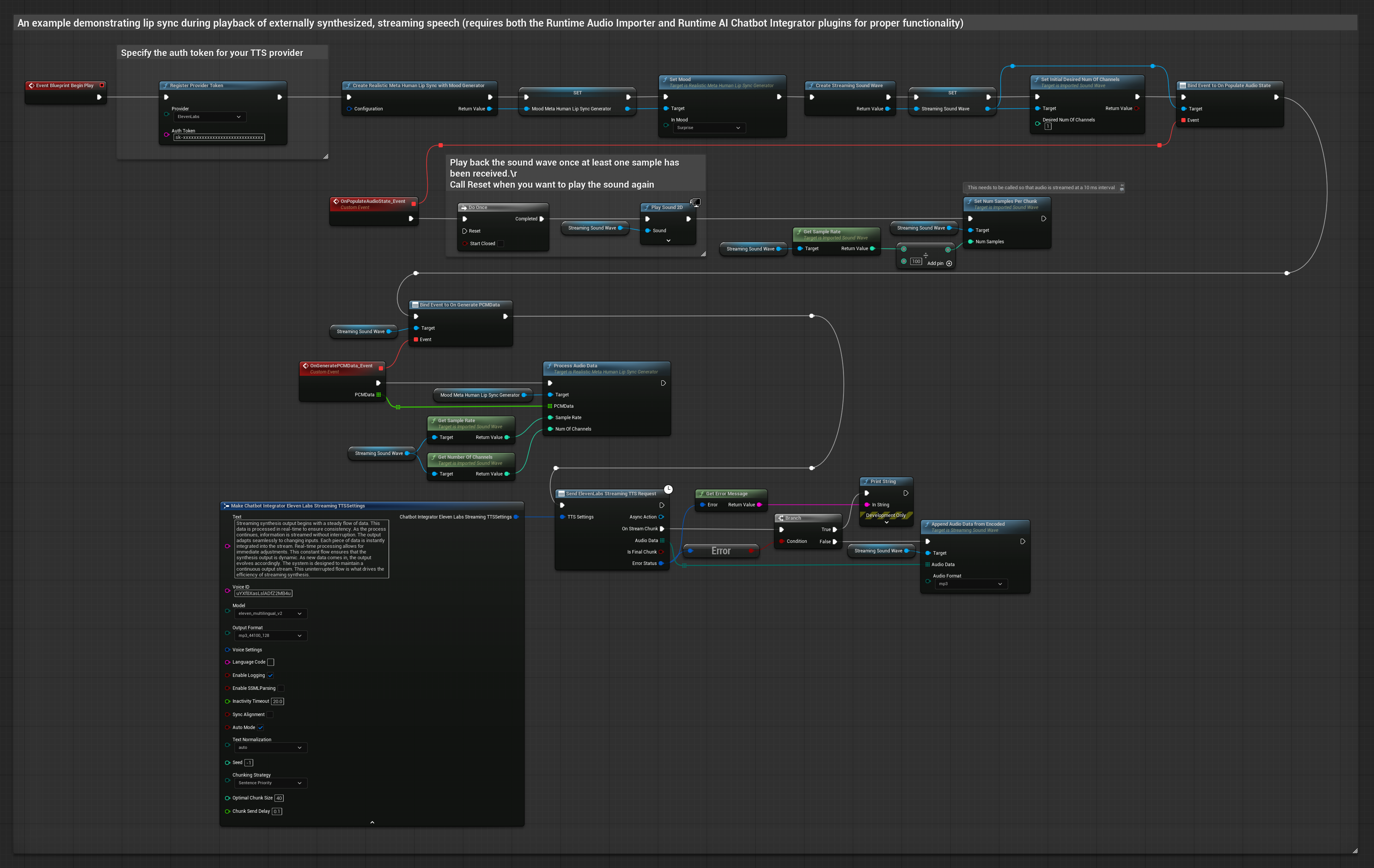

يستخدم هذا النهج إضافة Runtime AI Chatbot Integrator لتوليد كلام مركب بالبث من خدمات الذكاء الاصطناعي (OpenAI أو ElevenLabs) وأداء مزامنة الشفاه:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- استخدم Runtime AI Chatbot Integrator للاتصال بواجهات برمجة تطبيقات TTS بالبث (مثل ElevenLabs Streaming API)

- استخدم Runtime Audio Importer لاستيراد بيانات الصوت المركبة

- قبل إعادة تشغيل الصوت بالبث، قم بالربط مع مندوبه

OnGeneratePCMData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

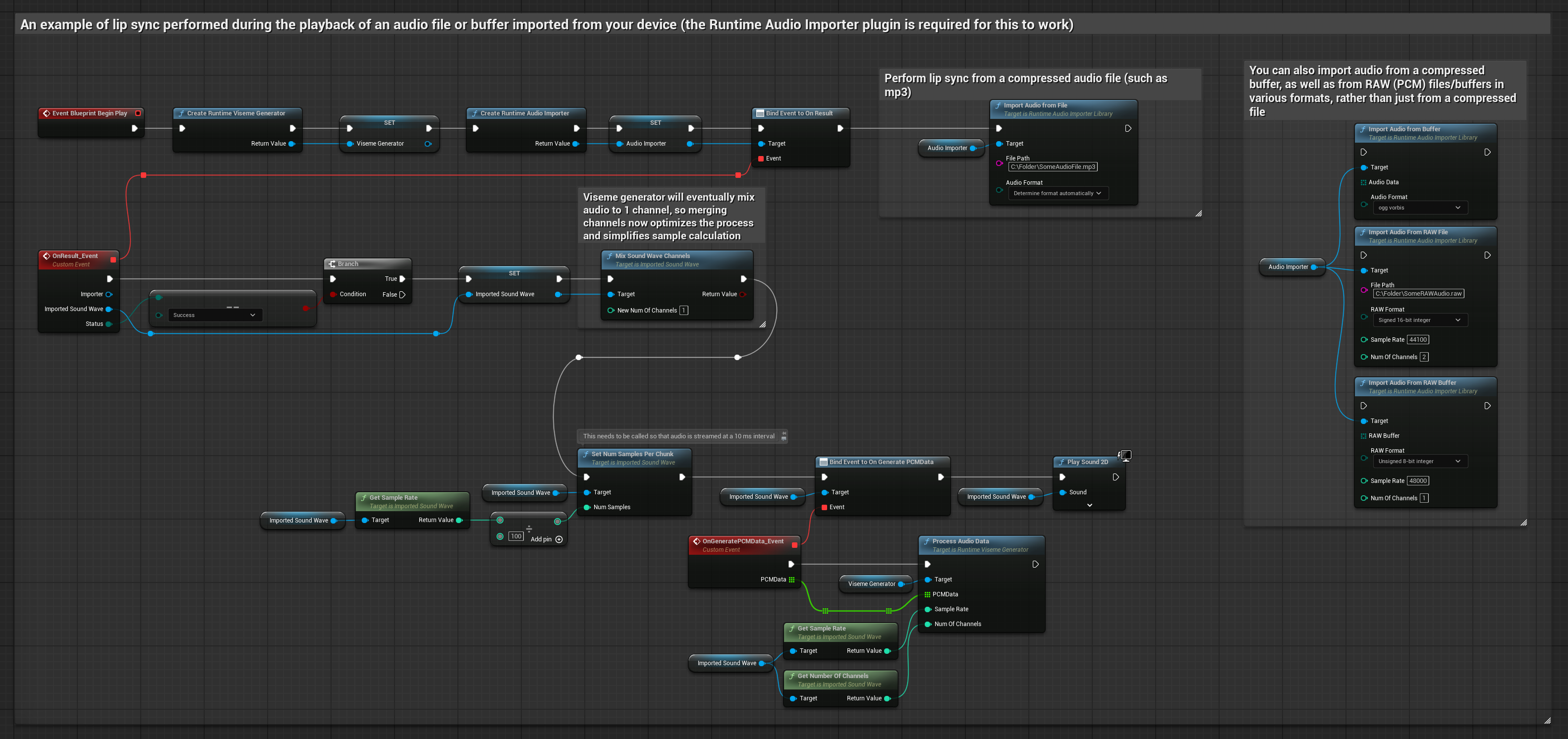

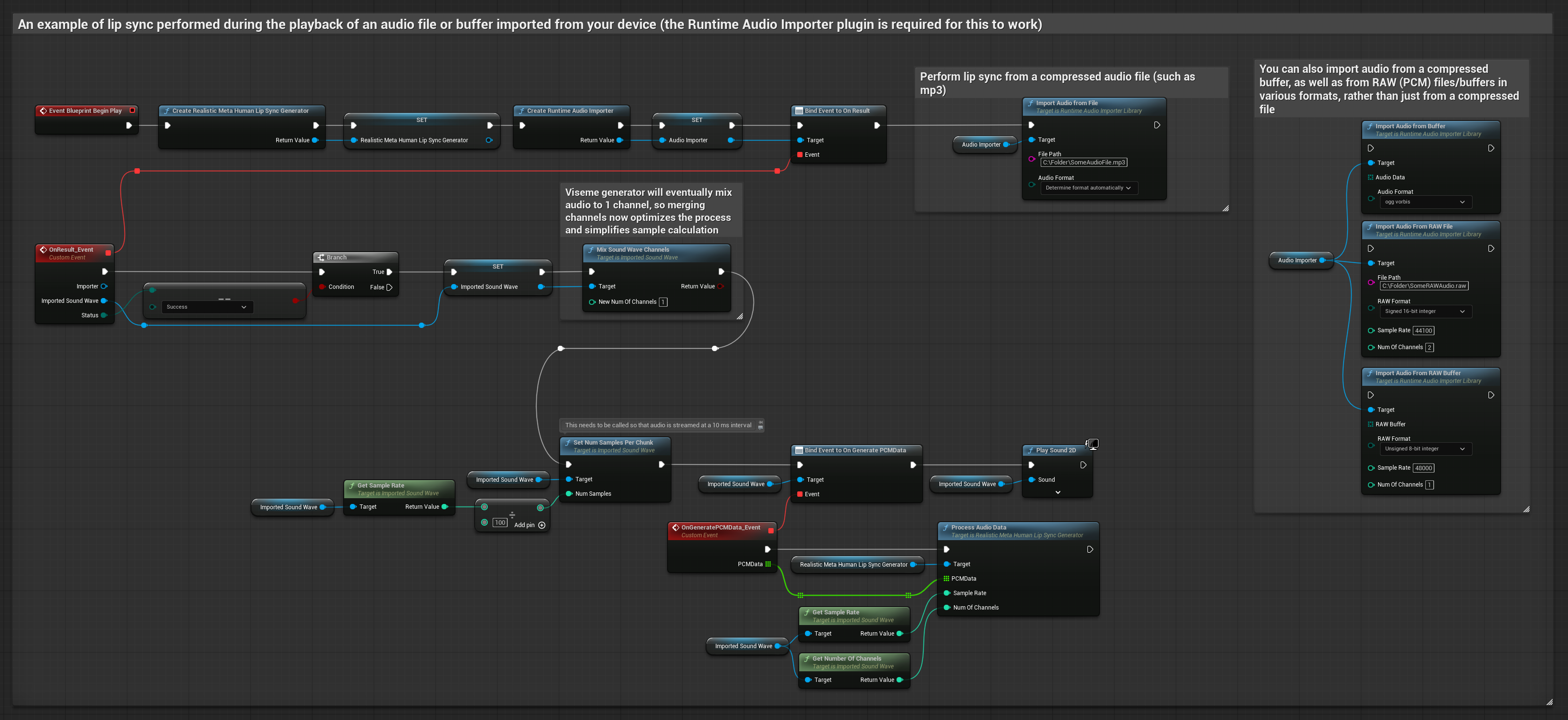

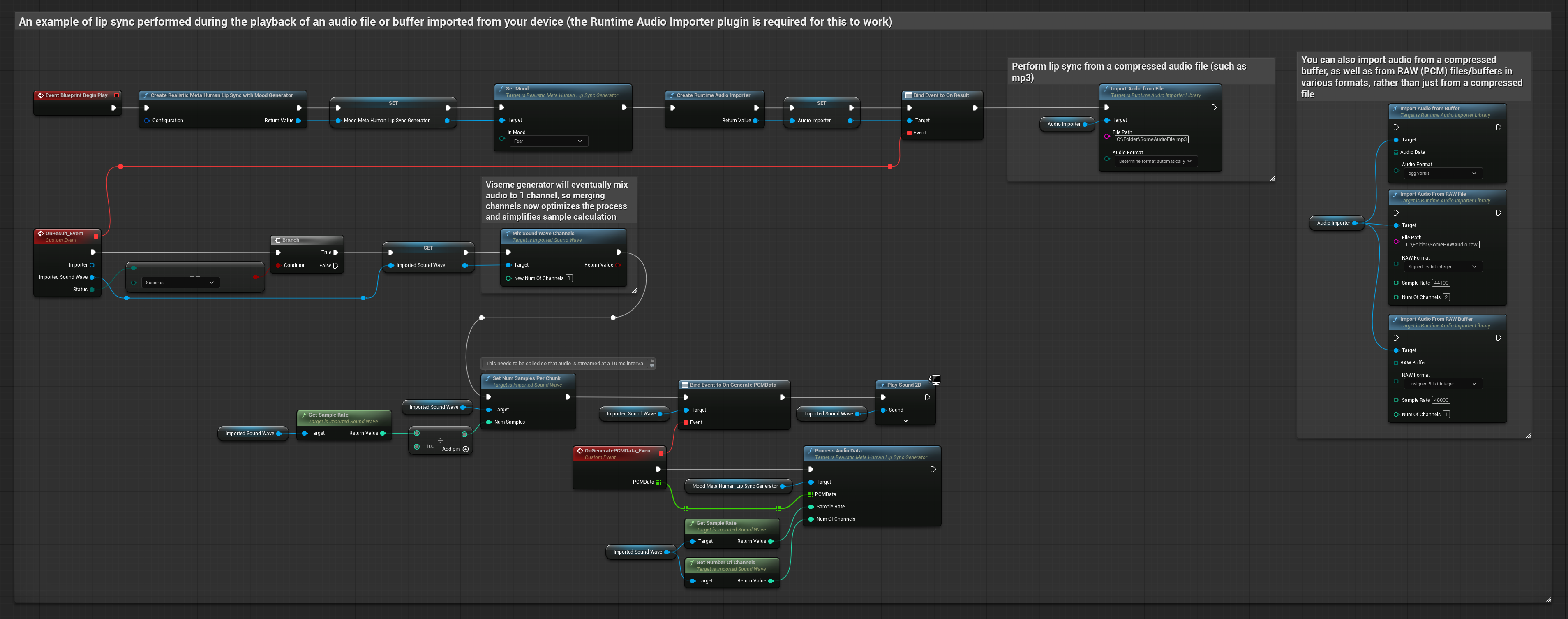

يستخدم هذا النهج ملفات صوت مسجلة مسبقًا أو مخازن مؤقتة للصوت لمزامنة الشفاه:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- استخدم Runtime Audio Importer لاستيراد ملف صوت من القرص أو الذاكرة

- قبل إعادة تشغيل الصوت المستورد، قم بالربط مع مندوبه

OnGeneratePCMData - في الوظيفة المرتبطة، استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك - شغل الصوت المستورد ولاحظ حركة مزامنة الشفاه

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

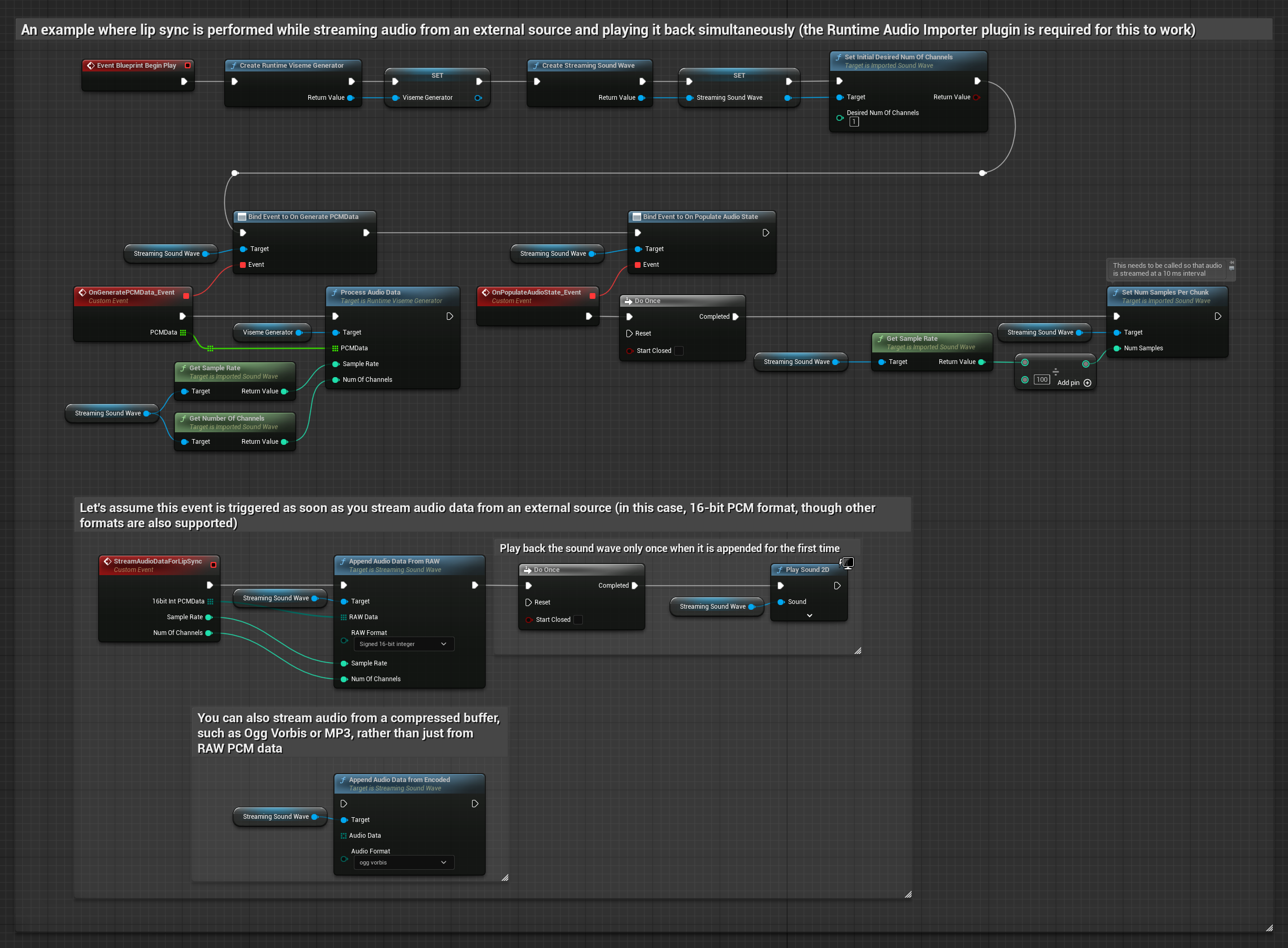

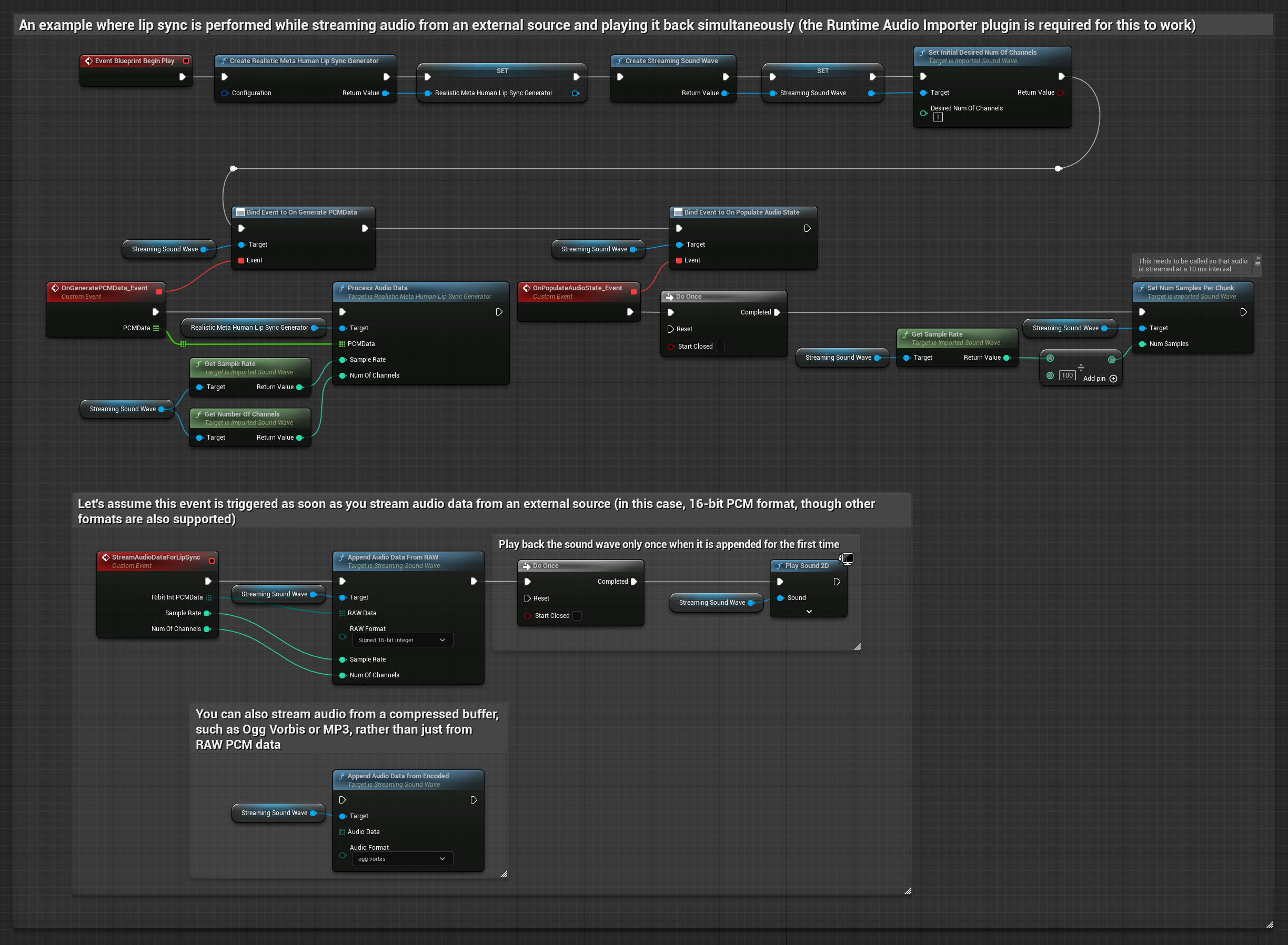

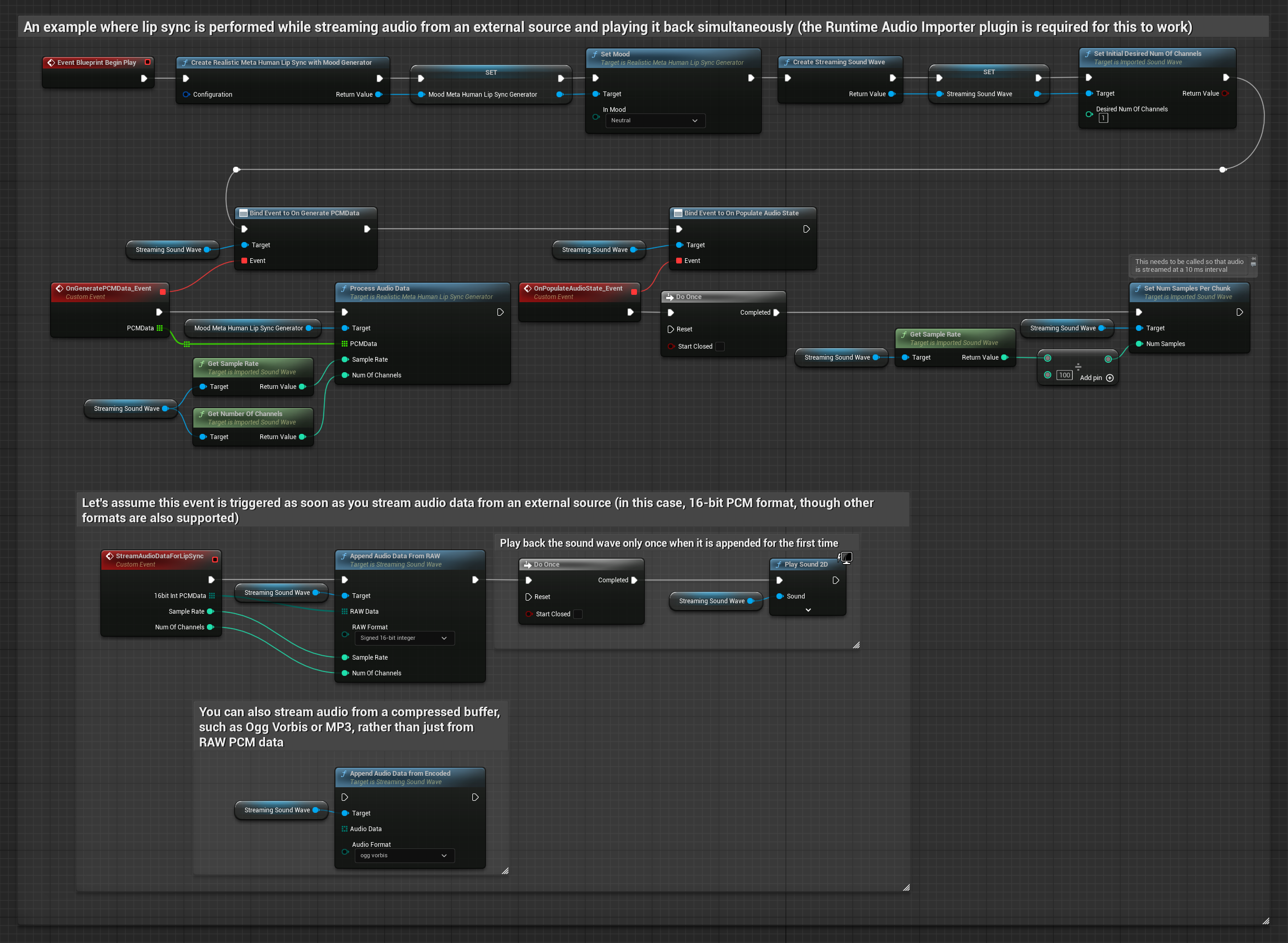

لبيانات الصوت بالبث من مخزن مؤقت، تحتاج إلى:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

- بيانات صوت بتنسيق PCM عائم (مصفوفة من عينات النقطة العائمة) متاحة من مصدر البث الخاص بك (أو استخدم Runtime Audio Importer لدعم المزيد من التنسيقات)

- معدل العينات وعدد القنوات

- استدعِ

ProcessAudioDataمن Runtime Viseme Generator الخاص بك مع هذه المعلمات عند توفر أجزاء الصوت

يستخدم النموذج الواقعي نفس سير عمل معالجة الصوت مثل النموذج القياسي، ولكن مع متغير RealisticLipSyncGenerator بدلاً من VisemeGenerator.

يستخدم النموذج المدعوم بالمزاج نفس سير عمل معالجة الصوت، ولكن مع متغير MoodMetaHumanLipSyncGenerator وقدرات تكوين مزاج إضافية.

ملاحظة: عند استخدام مصادر صوت بالبث، تأكد من إدارة توقيت تشغيل الصوت بشكل مناسب لتجنب تشويه التشغيل. راجع توثيق Streaming Sound Wave لمزيد من المعلومات.

نصائح أداء المعالجة

-

حجم الجزء: إذا كنت تريد معالجة بيانات الصوت في أجزاء أصغر لمزامنة شفاه أكثر استجابة، اضبط الحساب في وظيفة

SetNumSamplesPerChunk. على سبيل المثال، قسمة معدل العينات على 150 (بث كل ~6.67 مللي ثانية) بدلاً من 100 (بث كل 10 مللي ثانية) سيوفر تحديثات مزامنة شفاه أكثر تكرارًا. -

إدارة المخزن المؤقت: يعالج النموذج المدعوم بالمزاج الصوت في إطارات مكونة من 320 عينة (20 مللي ثانية عند 16 كيلو هرتز). تأكد من محاذاة توقيت إدخال الصوت الخاص بك مع هذا للحصول على أداء مثالي.

-

إعادة إنشاء المولد: لتشغيل موثوق مع النماذج الواقعية، أعد إنشاء المولد في كل مرة تريد فيها تغذية بيانات صوت جديدة بعد فترة من عدم النشاط.

الخطوات التالية

بمجرد إعداد معالجة الصوت، قد ترغب في:

- التعرف على خيارات التكوين لضبط سلوك مزامنة الشفاه الخاص بك

- إضافة حركة الضحك لتحسين التعبير

- دمج مزامنة الشفاه مع حركات الوجه الحالية باستخدام تقنيات الطبقات الموضحة في دليل التكوين