دليل الإعداد

يأخذك هذا الدليل خلال عملية الإعداد الأساسية لتزامن الشفاه في الوقت الفعلي لـ MetaHuman مع شخصيات MetaHuman الخاصة بك.

ملاحظة: يعمل تزامن الشفاه في الوقت الفعلي لـ MetaHuman مع كل من شخصيات MetaHuman والشخصيات المخصصة. للحصول على تعليمات مفصلة حول إعداد الشخصيات المخصصة، راجع دليل إعداد الشخصية المخصصة.

المتطلبات الأساسية

قبل البدء، تأكد من:

-

متطلبات إضافة MetaHuman:

- UE 5.5 والإصدارات السابقة: قم بتمكين إضافة MetaHuman في مشروعك

- UE 5.6 والإصدارات اللاحقة: قم بتمكين إضافة MetaHuman Core Tech في مشروعك

إضافات MetaHuman الإضافيةاعتمادًا على كيفية إنشاء شخصيات MetaHuman الخاصة بك، قد تحتاج إلى إضافات إضافية. على سبيل المثال، إذا كنت تنوي إنشاء MetaHuman باستخدام نظام MetaHuman Creator الجديد الذي تم تقديمه في UE 5.6، فستحتاج أيضًا إلى تمكين إضافة MetaHuman Creator. لمزيد من المعلومات حول هذا النظام، راجع توثيق MetaHuman Creator.

-

لديك شخصية MetaHuman واحدة على الأقل تم تنزيلها ومتاحة في مشروعك

-

تم تثبيت إضافة Runtime MetaHuman Lip Sync

إضافة النموذج القياسي

إذا كنت تخطط لاستخدام النموذج القياسي، فستحتاج إلى تثبيت الإضافة الإضافية:

- قم بتنزيل إضافة Standard Lip Sync Extension plugin من Google Drive

- استخرج المجلد من الأرشيف الذي تم تنزيله إلى مجلد

Pluginsالخاص بمشروعك (قم بإنشاء هذا المجلد إذا لم يكن موجودًا) - تأكد من إعداد مشروعك كمشروع C++ (حتى إذا لم يكن لديك أي كود C++)

- أعد بناء مشروعك

- هذه الإضافة الإضافية مطلوبة فقط إذا كنت تريد استخدام النموذج القياسي. إذا كنت تحتاج فقط إلى النماذج الواقعية، يمكنك تخطي هذه الخطوة.

- لمزيد من المعلومات حول كيفية بناء الإضافات يدويًا، راجع درس بناء الإضافات

إضافات إضافية

- إذا كنت تخطط لاستخدام التقاط الصوت (على سبيل المثال، إدخال الميكروفون)، قم بتثبيت إضافة Runtime Audio Importer.

- إذا كنت تخطط لاستخدام وظيفة تحويل النص إلى كلام:

- لـ تحويل النص إلى كلام محلي (النموذج القياسي والنموذج الواقعي المدعوم بالمزاج)، قم بتثبيت إضافة Runtime Text To Speech.

- لـ مزودي تحويل النص إلى كلام خارجيين (ElevenLabs، OpenAI، Google Cloud، Azure)، قم بتثبيت إضافة Runtime AI Chatbot Integrator.

إعداد مخططات الحركة

الخطوة 1: تحديد وتعديل مخطط الوجه المتحرك

- UE 5.5 والإصدارات السابقة (أو MetaHumans القديمة في UE 5.6+)

- شخصيات منشئ MetaHuman في UE 5.6+

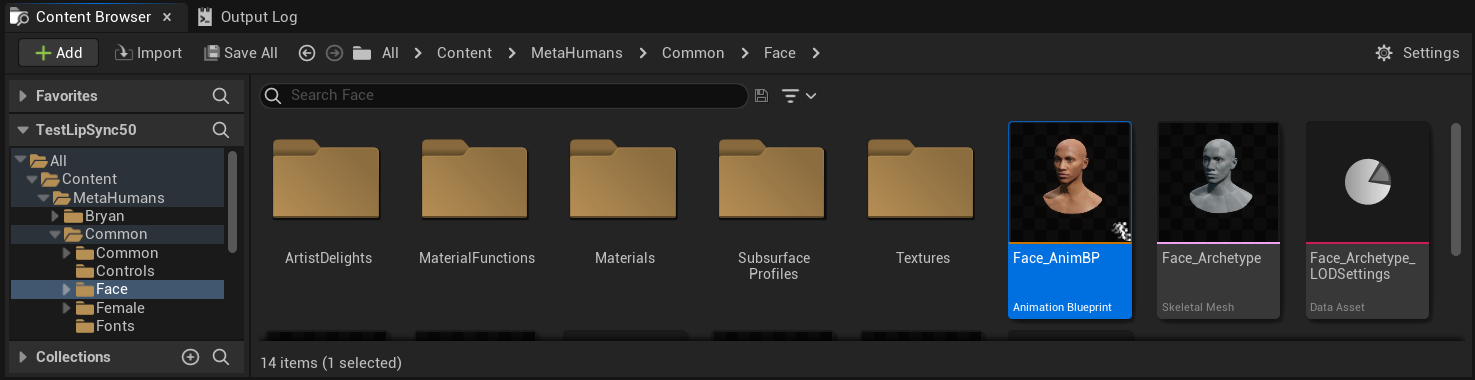

تحتاج إلى تعديل مخطط حركي (Animation Blueprint) سيُستخدم لتحريك وجه شخصية MetaHuman الخاصة بك. مخطط الوجه المتحرك الافتراضي لـ MetaHuman موجود في:

Content/MetaHumans/Common/Face/Face_AnimBP

لديك عدة خيارات لتنفيذ وظيفة مزامنة الشفاه:

- تحرير الأصل الافتراضي (الخيار الأبسط)

- إنشاء نسخة مكررة

- استخدام مخطط الحركة المخصص

افتح Face_AnimBP الافتراضي مباشرة وقم بإجراء تعديلاتك. أي تغييرات ستؤثر على جميع شخصيات MetaHuman التي تستخدم مخطط الحركة هذا.

ملاحظة: هذا النهج مريح ولكنه سيؤثر على جميع الشخصيات التي تستخدم مخطط الحركة الافتراضي.

- انسخ

Face_AnimBPوأعطها اسمًا وصفيًا - حدد موقع فئة مخطط الشخصية الخاصة بك (على سبيل المثال، للشخصية "Bryan"، ستكون في

Content/MetaHumans/Bryan/BP_Bryan) - افتح مخطط الشخصية وابحث عن مكون Face

- غيّر خاصية Anim Class إلى مخطط الحركة المكرر الجديد الخاص بك

ملاحظة: هذا النهج يسمح لك بتخصيص مزامنة الشفاه لشخصيات محددة مع ترك الآخرين دون تغيير.

يمكنك تنفيذ مزج مزامنة الشفاه في أي مخطط حركة لديه إمكانية الوصول إلى عظام الوجه المطلوبة:

- أنشئ أو استخدم مخطط حركة مخصص موجود

- تأكد من أن مخطط الحركة الخاص بك يعمل مع هيكل عظمي يحتوي على نفس عظام الوجه الموجودة في

Face_Archetype_Skeletonالافتراضي لـ MetaHuman

ملاحظة: هذا النهج يمنحك أقصى مرونة للتكامل مع أنظمة الرسوم المتحركة المخصصة.

بدءًا من UE 5.6، تم تقديم نظام MetaHuman Creator الجديد. بالنسبة لهذه الشخصيات، يوفر المكون الإضافي مخطط حركة للوجه موجود في:

Content/LipSyncData/LipSync_Face_AnimBP

يوجد مخطط الحركة هذا في مجلد محتوى الإضافة وسيتم الكتابة فوقه مع كل تحديث للإضافة. لمنع فقدان التخصيصات الخاصة بك:

- انسخ هذا الأصل إلى مجلد المحتوى الخاص بمشروعك (على سبيل المثال، إلى

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - استخدم النسخة التي نسختها في إعداد شخصيتك

- أجرِ جميع التعديلات الخاصة بك على النسخة المنسوخة

استخدام مخطط حركة الوجه الخاص بالإضافة:

- حدد فئة مخطط الشخصية الخاصة بشخصية MetaHuman Creator الخاصة بك

- افتح مخطط الشخصية وابحث عن مكون الوجه

- غيّر خاصية فئة الحركة إلى

LipSync_Face_AnimBPالخاصة بالإضافة - تابع مع الخطوات التالية لتكوين وظيفة Runtime MetaHuman Lip Sync

الخطوة 2: إعداد مخطط الأحداث

افتح مخطط حركة الوجه الخاص بك وانتقل إلى Event Graph. ستحتاج إلى إنشاء مُنشئ سيعالج بيانات الصوت ويُنشئ رسوم متحركة لمزامنة الشفاه.

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالمزاج

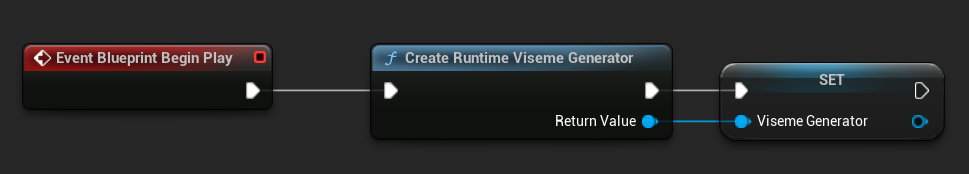

- أضف عقدة

Event Blueprint Begin Playإذا لم تكن موجودة بالفعل - أضف عقدة

Create Runtime Viseme Generatorووصّلها بحدث Begin Play - احفظ الناتج كمتغير (مثل "VisemeGenerator") لاستخدامه في أجزاء أخرى من المخطط

للحصول على خيارات التكوين التفصيلية، راجع قسم تكوين النموذج القياسي.

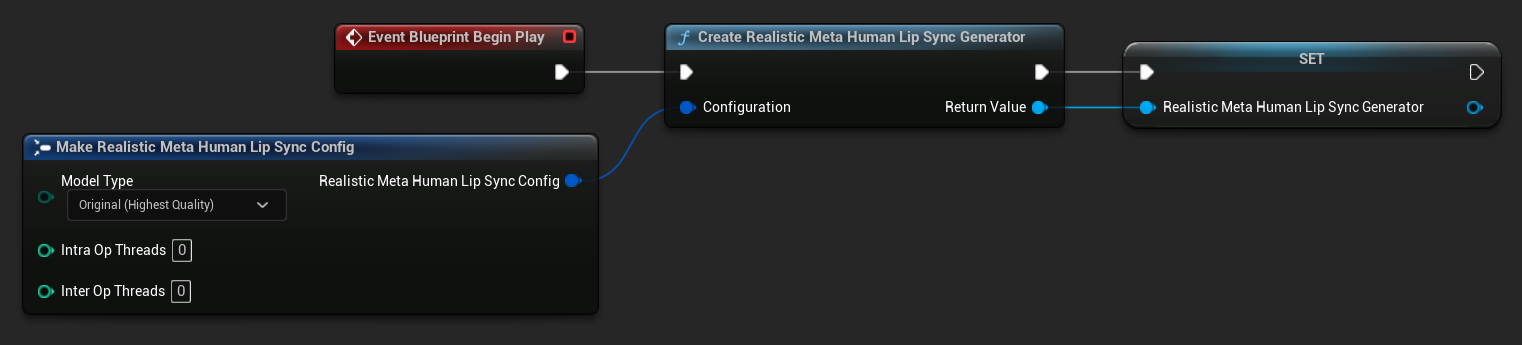

- أضف عقدة

Event Blueprint Begin Playإذا لم تكن موجودة بالفعل - أضف عقدة

Create Realistic MetaHuman Lip Sync Generatorووصّلها بحدث Begin Play - احفظ الناتج كمتغير (مثل "RealisticMetaHumanLipSyncGenerator") لاستخدامه في أجزاء أخرى من المخطط

- (اختياري) قم بتكوين إعدادات المُنشئ باستخدام معامل Configuration

للحصول على خيارات التكوين التفصيلية بما في ذلك أنواع النماذج وإعدادات الأداء ومعاملات المعالجة، راجع قسم تكوين النموذج الواقعي.

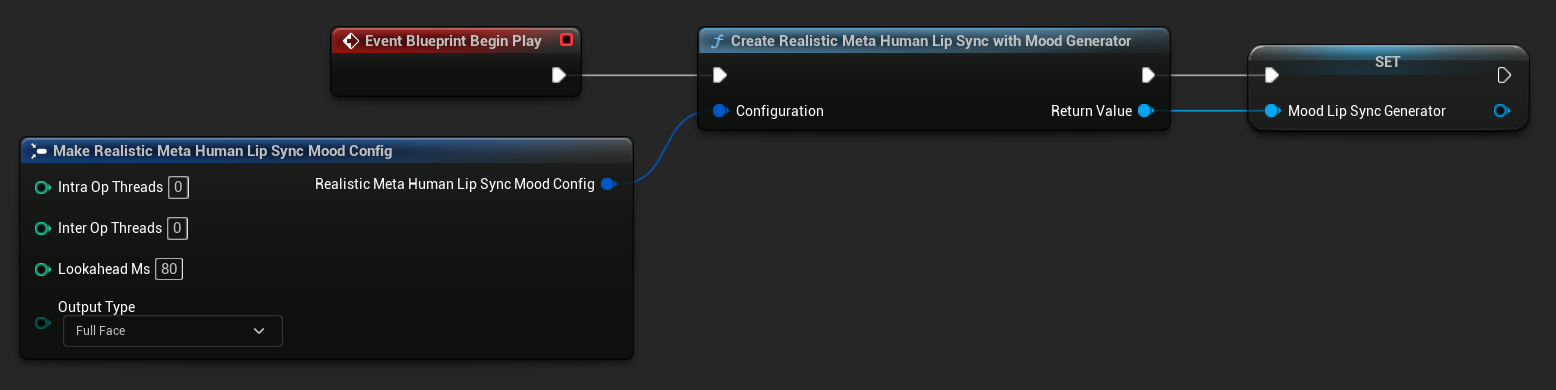

- أضف عقدة

Event Blueprint Begin Playإذا لم تكن موجودة بالفعل - أضف عقدة

Create Realistic MetaHuman Lip Sync With Mood Generatorووصّلها بحدث Begin Play - احفظ الناتج كمتغير (مثل "MoodMetaHumanLipSyncGenerator") لاستخدامه في أجزاء أخرى من المخطط

- (اختياري) قم بتكوين إعدادات المُنشئ باستخدام معامل Configuration

للحصول على تكوين المزاج التفصيلي بما في ذلك أنواع الحالة المزاجية، إعدادات الشدة، توقيت التطلع المسبق، واختيار نوع الإخراج، راجع قسم تكوين النموذج المدعوم بالحالة المزاجية.

الخطوة 3: إعداد الرسم البياني للرسوم المتحركة

بعد إعداد الرسم البياني للأحداث، انتقل إلى Anim Graph لربط المُولِّد برسوميات الشخصية:

- النموذج القياسي

- النموذج الواقعي

- النموذج الواقعي المدعوم بالحالة المزاجية

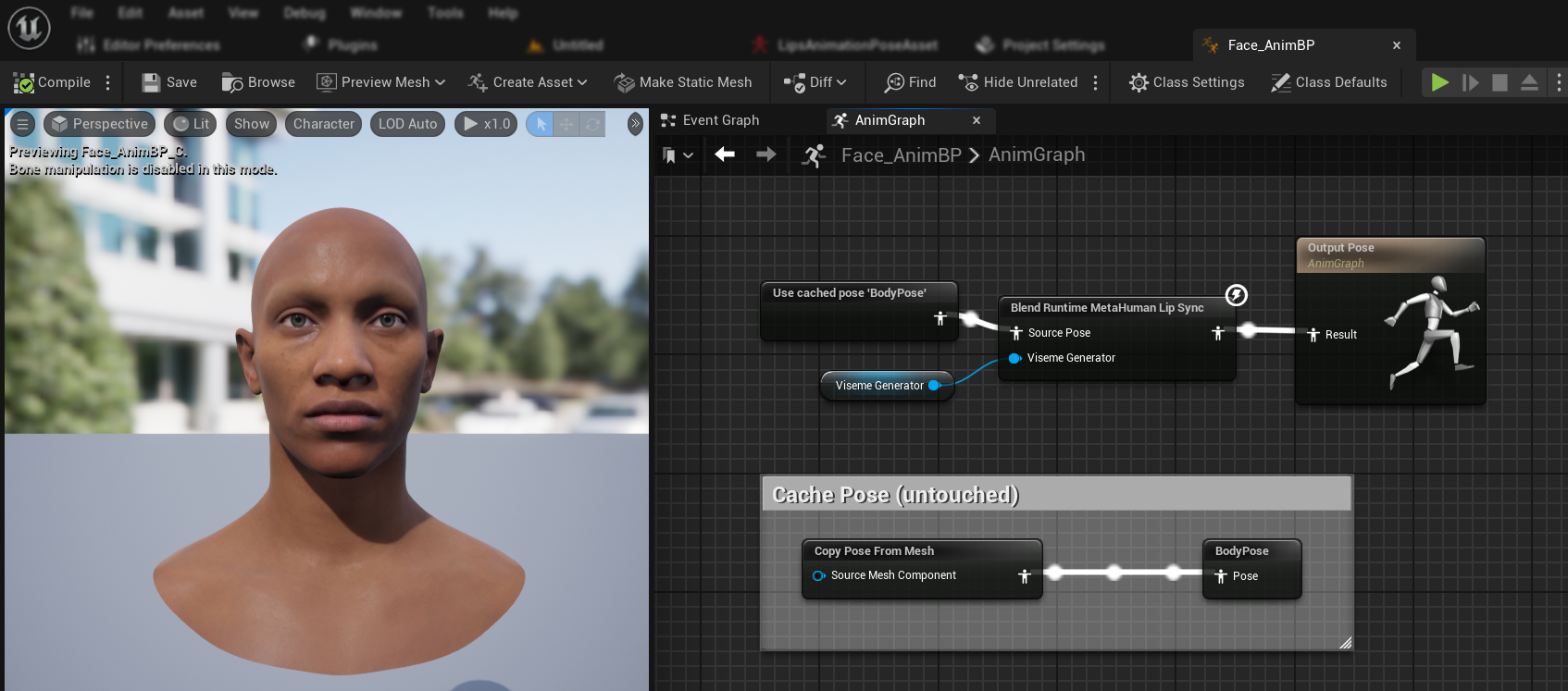

- حدد الوضعية التي تحتوي على وجه MetaHuman (عادة من

Use cached pose 'Body Pose') - أضف عقدة

Blend Runtime MetaHuman Lip Sync - صل الوضعية بـ

Source Poseالخاصة بعقدةBlend Runtime MetaHuman Lip Sync - صل متغير

VisemeGeneratorالخاص بك بـViseme Generator - صل إخراج عقدة

Blend Runtime MetaHuman Lip SyncبـResultالخاصة بـOutput Pose

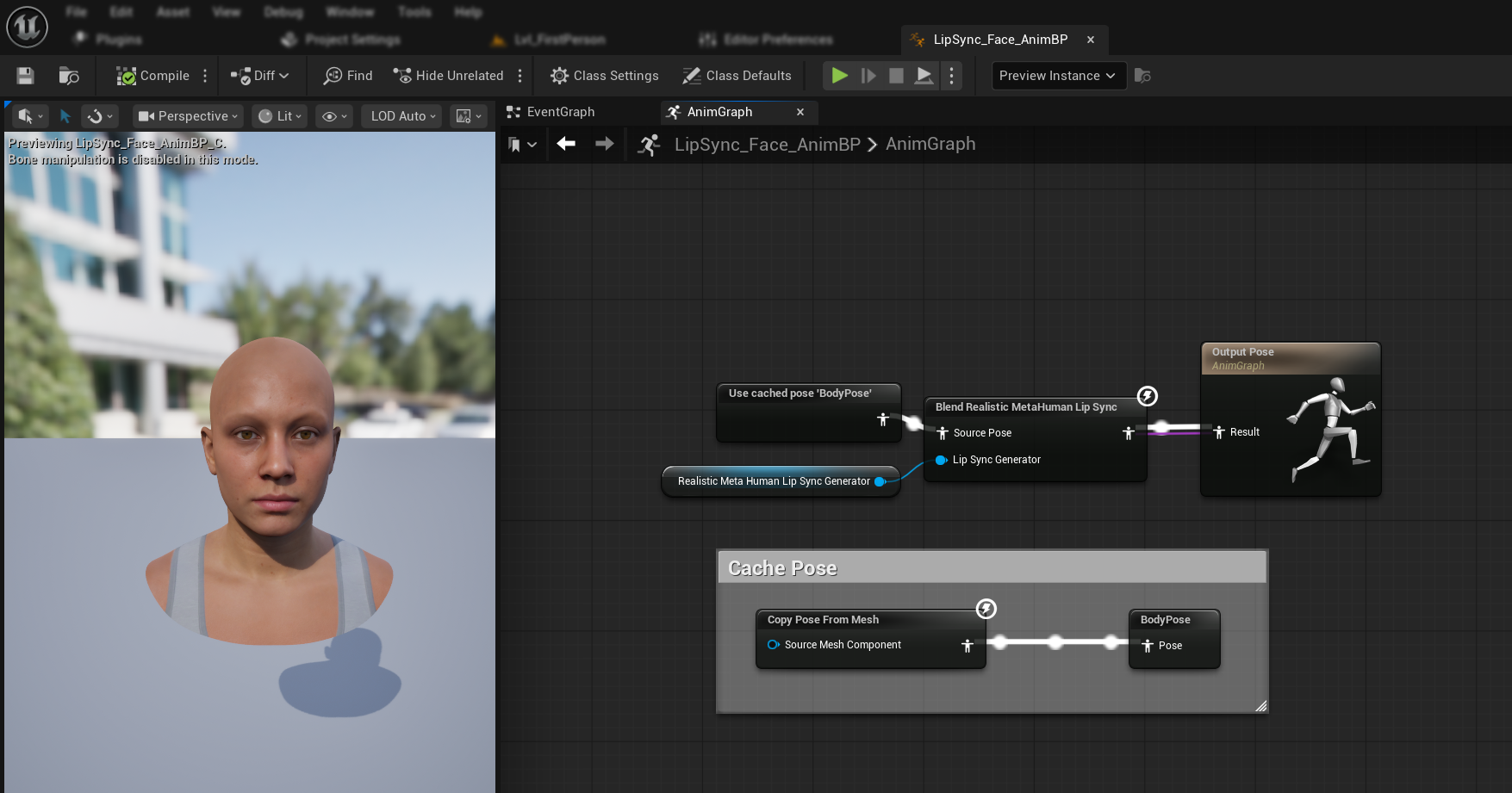

- حدد الوضعية التي تحتوي على وجه MetaHuman (عادة من

Use cached pose 'Body Pose') - أضف عقدة

Blend Realistic MetaHuman Lip Sync - صل الوضعية بـ

Source Poseالخاصة بعقدةBlend Realistic MetaHuman Lip Sync - صل متغير

RealisticMetaHumanLipSyncGeneratorالخاص بك بـLip Sync Generator - صل إخراج عقدة

Blend Realistic MetaHuman Lip SyncبـResultالخاصة بـOutput Pose

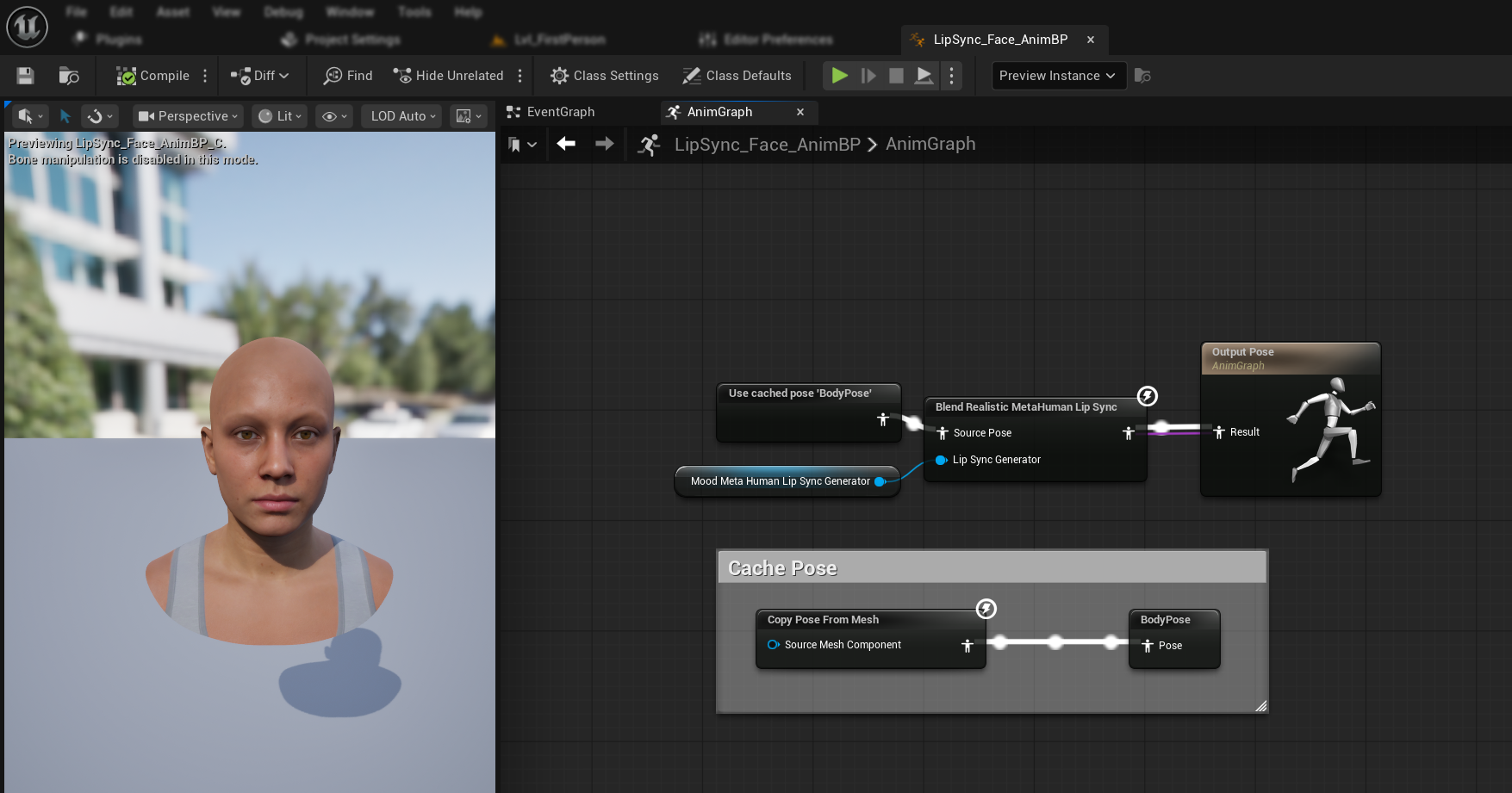

- حدد الوضعية التي تحتوي على وجه MetaHuman (عادة من

Use cached pose 'Body Pose') - أضف عقدة

Blend Realistic MetaHuman Lip Sync(نفس العقدة المستخدمة في النموذج الواقعي العادي) - صل الوضعية بـ

Source Poseالخاصة بعقدةBlend Realistic MetaHuman Lip Sync - صل متغير

MoodMetaHumanLipSyncGeneratorالخاص بك بـLip Sync Generator - صل إخراج عقدة

Blend Realistic MetaHuman Lip SyncبـResultالخاصة بـOutput Pose

ملاحظة: يستخدم النموذج المدعوم بالحالة المزاجية نفس عقدة Animation Blueprint المستخدمة في النموذج الواقعي العادي. يتم التعامل مع وظيفة الحالة المزاجية داخليًا بواسطة المُولِّد.

الخطوات التالية

الآن بعد أن أكملت الإعداد الأساسي لـ Animation Blueprint، ستحتاج إلى تكوين معالجة إدخال الصوت لتغذية بيانات الصوت إلى مُولِّد مزامنة الشفاه الخاص بك.

تابع إلى دليل معالجة الصوت لتتعلم كيفية إعداد طرق إدخال الصوت المختلفة بما في ذلك التقاط الميكروفون، تحويل النص إلى كلام، ومعالجة ملفات الصوت. للخيارات المتقدمة للتكوين والضبط الدقيق، راجع دليل التكوين.