Übersetzungsanbieter

Der AI Localization Automator unterstützt fünf verschiedene KI-Anbieter, jeder mit einzigartigen Stärken und Konfigurationsoptionen. Wählen Sie den Anbieter, der am besten zu den Anforderungen, dem Budget und den Qualitätsanforderungen Ihres Projekts passt.

Ollama (Lokale KI)

Am besten geeignet für: Datenschutzsensible Projekte, Offline-Übersetzung, unbegrenzte Nutzung

Ollama führt KI-Modelle lokal auf Ihrem Rechner aus und bietet vollständige Privatsphäre und Kontrolle ohne API-Kosten oder Internetanforderungen.

Beliebte Modelle

- llama3.2 (Empfohlen für allgemeine Zwecke)

- mistral (Effiziente Alternative)

- codellama (Code-bewusste Übersetzungen)

- Und viele weitere Community-Modelle

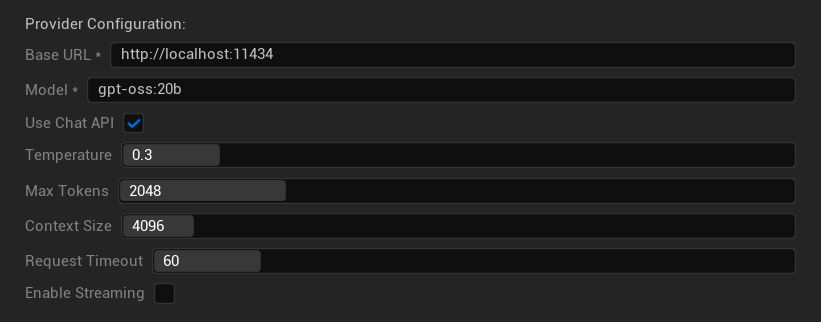

Konfigurationsoptionen

- Basis-URL: Lokaler Ollama-Server (Standard:

http://localhost:11434) - Modell: Name des lokal installierten Modells (erforderlich)

- Chat-API verwenden: Für bessere Konversationsbehandlung aktivieren

- Temperatur: 0,0-2,0 (0,3 empfohlen)

- Maximale Tokens: 1-8.192 Tokens

- Kontextgröße: 512-32.768 Tokens

- Anfrage-Timeout: 10-300 Sekunden (lokale Modelle können langsamer sein)

- Streaming aktivieren: Für Echtzeit-Antwortverarbeitung

Stärken

- ✅ Vollständige Privatsphäre (keine Daten verlassen Ihren Rechner)

- ✅ Keine API-Kosten oder Nutzungslimits

- ✅ Funktioniert offline

- ✅ Vollständige Kontrolle über Modellparameter

- ✅ Große Auswahl an Community-Modellen

- ✅ Kein Vendor Lock-in

Überlegungen

- 💻 Erfordert lokale Einrichtung und leistungsfähige Hardware

- ⚡ Allgemein langsamer als Cloud-Anbieter

- 🔧 Technisch anspruchsvollere Einrichtung erforderlich

- 📊 Übersetzungsqualität variiert stark je nach Modell (einige können Cloud-Anbieter übertreffen)

- 💾 Großer Speicherbedarf für Modelle

Einrichtung von Ollama

- Ollama installieren: Laden Sie es von ollama.ai herunter und installieren Sie es auf Ihrem System

- Modelle herunterladen: Verwenden Sie

ollama pull llama3.2, um Ihr gewähltes Modell herunterzuladen - Server starten: Ollama läuft automatisch oder starten Sie es mit

ollama serve - Plugin konfigurieren: Legen Sie Basis-URL und Modellnamen in den Plugin-Einstellungen fest

- Verbindung testen: Das Plugin überprüft die Konnektivität, wenn Sie die Konfiguration anwenden

OpenAI

Am besten geeignet für: Höchste allgemeine Übersetzungsqualität, umfangreiche Modellauswahl

OpenAI bietet branchenführende Sprachmodelle über ihre API an, einschließlich der neuesten GPT-Modelle und des neuen Responses API-Formats.

Verfügbare Modelle

- gpt-5 (Neuestes Flaggschiff-Modell)

- gpt-5-mini (Kleinere, schnellere Variante)

- gpt-4.1 und gpt-4.1-mini

- gpt-4o und gpt-4o-mini (Optimierte Modelle)

- o3 und o3-mini (Fortgeschrittenes Reasoning)

- o1 und o1-mini (Vorherige Generation)

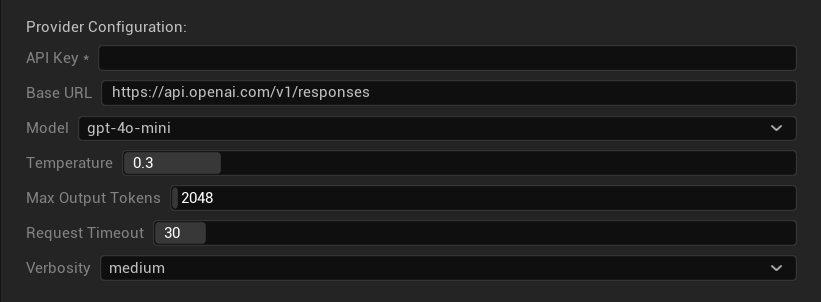

Konfigurationsoptionen

- API-Schlüssel: Ihr OpenAI API-Schlüssel (erforderlich)

- Basis-URL: API-Endpunkt (Standard: OpenAIs Server)

- Modell: Aus verfügbaren GPT-Modellen wählen

- Temperatur: 0,0-2,0 (0,3 für Übersetzungskonsistenz empfohlen)

- Maximale Ausgabe-Tokens: 1-128.000 Tokens

- Anfrage-Timeout: 5-300 Sekunden

- Ausführlichkeit: Detaillierungsgrad der Antworten steuern

Stärken

- ✅ Durchgehend hochwertige Übersetzungen

- ✅ Hervorragendes Kontextverständnis

- ✅ Starke Formatierungserhaltung

- ✅ Breite Sprachunterstützung

- ✅ Zuverlässige API-Verfügbarkeit

Überlegungen

- 💰 Höhere Kosten pro Anfrage

- 🌐 Internetverbindung erforderlich

- ⏱️ Nutzungslimits basierend auf Tier

Anthropic Claude

Am besten für: Nuancierte Übersetzungen, kreative Inhalte, sicherheitsfokussierte Anwendungen

Claude-Modelle zeichnen sich durch ein hervorragendes Verständnis von Kontext und Nuancen aus, was sie ideal für erzähllastige Spiele und komplexe Lokalisierungsszenarien macht.

Verfügbare Modelle

- claude-opus-4-1-20250805 (Neuestes Flaggschiff)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Schnell und effizient)

- claude-3-haiku-20240307

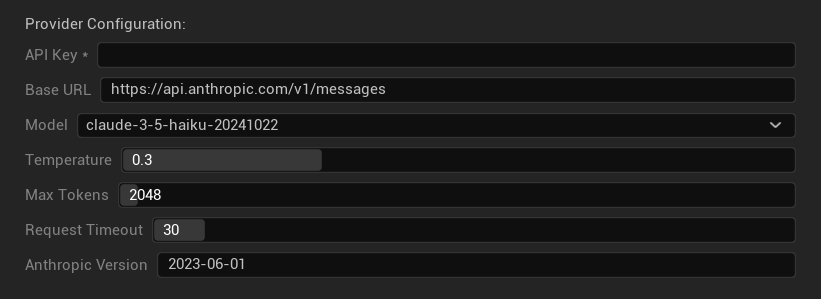

Konfigurationsoptionen

- API-Schlüssel: Ihr Anthropic API-Schlüssel (erforderlich)

- Basis-URL: Claude API-Endpunkt

- Modell: Aus der Claude-Modellfamilie auswählen

- Temperatur: 0,0-1,0 (0,3 empfohlen)

- Maximale Tokens: 1-64.000 Tokens

- Anfrage-Timeout: 5-300 Sekunden

- Anthropic Version: API-Versions-Header

Stärken

- ✅ Außergewöhnliches Kontextbewusstsein

- ✅ Großartig für kreative/erzählerische Inhalte

- ✅ Starke Sicherheitsfunktionen

- ✅ Detaillierte Fähigkeiten zur Schlussfolgerung

- ✅ Hervorragende Befolgung von Anweisungen

Überlegungen

- 💰 Premium-Preismodell

- 🌐 Internetverbindung erforderlich

- 📏 Token-Limits variieren je nach Modell

DeepSeek

Am besten für: Kosteneffiziente Übersetzung, hohen Durchsatz, budgetbewusste Projekte

DeepSeek bietet wettbewerbsfähige Übersetzungsqualität zu einem Bruchteil der Kosten anderer Anbieter, was es ideal für groß angelegte Lokalisierungsprojekte macht.

Verfügbare Modelle

- deepseek-chat (Allgemeiner Zweck, empfohlen)

- deepseek-reasoner (Erweiterte Fähigkeiten zur Schlussfolgerung)

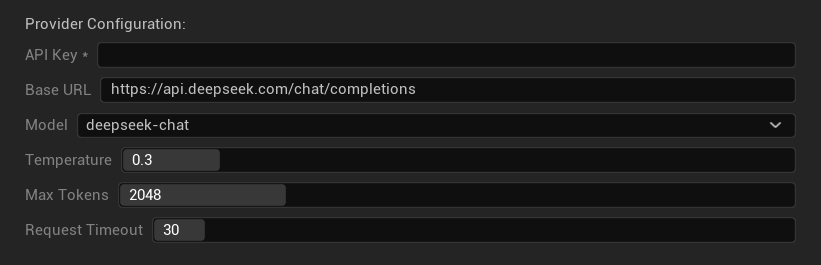

Konfigurationsoptionen

- API-Schlüssel: Ihr DeepSeek API-Schlüssel (erforderlich)

- Basis-URL: DeepSeek API-Endpunkt

- Modell: Wählen Sie zwischen Chat- und Reasoner-Modellen

- Temperatur: 0,0-2,0 (0,3 empfohlen)

- Maximale Tokens: 1-8.192 Tokens

- Anfrage-Timeout: 5-300 Sekunden

Stärken

- ✅ Sehr kosteneffektiv

- ✅ Gute Übersetzungsqualität

- ✅ Schnelle Antwortzeiten

- ✅ Einfache Konfiguration

- ✅ Hohe Ratenlimits

Überlegungen

- 📏 Niedrigere Token-Limits

- 🆕 Neuerer Anbieter (weniger Erfahrungswerte)

- 🌐 Internetverbindung erforderlich

Google Gemini

Am besten geeignet für: Mehrsprachige Projekte, kostengünstige Übersetzungen, Integration in das Google-Ökosystem

Gemini-Modelle bieten starke mehrsprachige Fähigkeiten mit wettbewerbsfähigen Preisen und einzigartigen Funktionen wie den Denkmodus für verbessertes Schlussfolgern.

Verfügbare Modelle

- gemini-2.5-pro (Neuestes Flaggschiff mit Denkmodus)

- gemini-2.5-flash (Schnell, mit Denkmodus-Unterstützung)

- gemini-2.5-flash-lite (Leichtgewichtige Variante)

- gemini-2.0-flash und gemini-2.0-flash-lite

- gemini-1.5-pro und gemini-1.5-flash

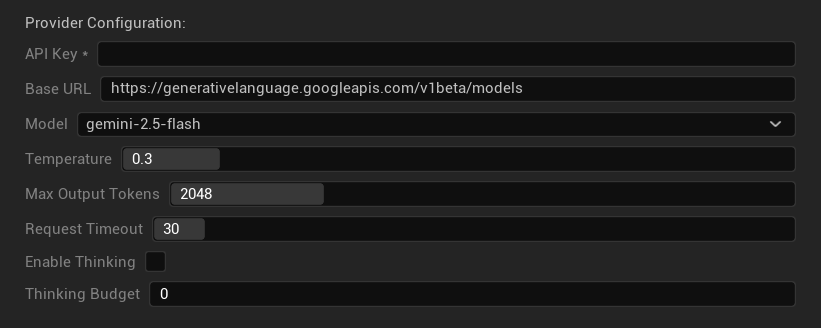

Konfigurationsoptionen

- API-Schlüssel: Ihr Google AI API-Schlüssel (erforderlich)

- Basis-URL: Gemini API-Endpunkt

- Modell: Aus der Gemini-Modellfamilie auswählen

- Temperatur: 0,0-2,0 (0,3 empfohlen)

- Maximale Ausgabe-Tokens: 1-8.192 Tokens

- Anfrage-Timeout: 5-300 Sekunden

- Denkmodus aktivieren: Erweitertes Schlussfolgern für 2.5-Modelle aktivieren

- Denk-Budget: Steuerung der Token-Zuweisung für den Denkmodus

Stärken

- ✅ Starke mehrsprachige Unterstützung

- ✅ Wettbewerbsfähige Preise

- ✅ Erweitertes Schlussfolgern (Denkmodus)

- ✅ Integration in das Google-Ökosystem

- ✅ Regelmäßige Modell-Updates

Überlegungen

- 🧠 Der Denkmodus erhöht den Token-Verbrauch

- 📏 Variable Token-Limits je nach Modell

- 🌐 Internetverbindung erforderlich

Den richtigen Anbieter auswählen

| Anbieter | Am besten geeignet für | Qualität | Kosten | Einrichtung | Datenschutz |

|---|---|---|---|---|---|

| Ollama | Datenschutz/Offline | Variabel* | Kostenlos | Fortgeschritten | Lokal |

| OpenAI | Höchste Qualität | ⭐⭐⭐⭐⭐ | 💰💰💰 | Einfach | Cloud |

| Claude | Kreative Inhalte | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Einfach | Cloud |

| DeepSeek | Budget-Projekte | ⭐⭐⭐⭐ | 💰 | Einfach | Cloud |

| Gemini | Mehrsprachig | ⭐⭐⭐⭐ | 💰 | Einfach | Cloud |

*Die Qualität bei Ollama variiert erheblich basierend auf dem verwendeten lokalen Modell - einige moderne lokale Modelle können Cloud-Anbieter erreichen oder übertreffen.

Tipps zur Anbieterkonfiguration

Für alle Cloud-Anbieter:

- API-Schlüssel sicher speichern und nicht in die Versionskontrolle einbinden

- Mit konservativen Temperatureinstellungen (0,3) beginnen, um konsistente Übersetzungen zu erhalten

- Ihre API-Nutzung und Kosten überwachen

- Vor großen Übersetzungsläufen mit kleinen Stapeln testen

Für Ollama:

- Ausreichend RAM sicherstellen (8GB+ für größere Modelle empfohlen)

- SSD-Speicher für eine bessere Modell-Ladeleistung verwenden

- GPU-Beschleunigung für schnellere Inferenz in Betracht ziehen

- Lokal testen, bevor man sich für Produktionsübersetzungen darauf verlässt