So verwenden Sie das Plugin

Der Runtime AI Chatbot Integrator bietet zwei Hauptfunktionen: Text-zu-Text-Chat und Text-zu-Sprache (TTS). Beide Funktionen folgen einem ähnlichen Arbeitsablauf:

- Registrieren Sie Ihren API-Provider-Token

- Konfigurieren Sie funktionsspezifische Einstellungen

- Senden Sie Anfragen und verarbeiten Sie Antworten

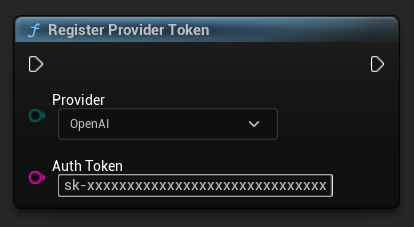

Provider-Token registrieren

Bevor Sie Anfragen senden, registrieren Sie Ihren API-Provider-Token mit der Funktion RegisterProviderToken.

- Blueprint

- C++

// Register an OpenAI provider token, as an example

UAIChatbotCredentialsManager::RegisterProviderToken(

EAIChatbotIntegratorOrgs::OpenAI,

TEXT("sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxx")

);

// Register other providers as needed

UAIChatbotCredentialsManager::RegisterProviderToken(

EAIChatbotIntegratorOrgs::Anthropic,

TEXT("sk-ant-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxx")

);

UAIChatbotCredentialsManager::RegisterProviderToken(

EAIChatbotIntegratorOrgs::DeepSeek,

TEXT("sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxx")

);

etc

Text-zu-Text-Chat-Funktionalität

Das Plugin unterstützt zwei Chat-Anfragemodi für jeden Anbieter:

Nicht-Streaming-Chatanfragen

Erhalten Sie die vollständige Antwort in einem einzigen Aufruf.

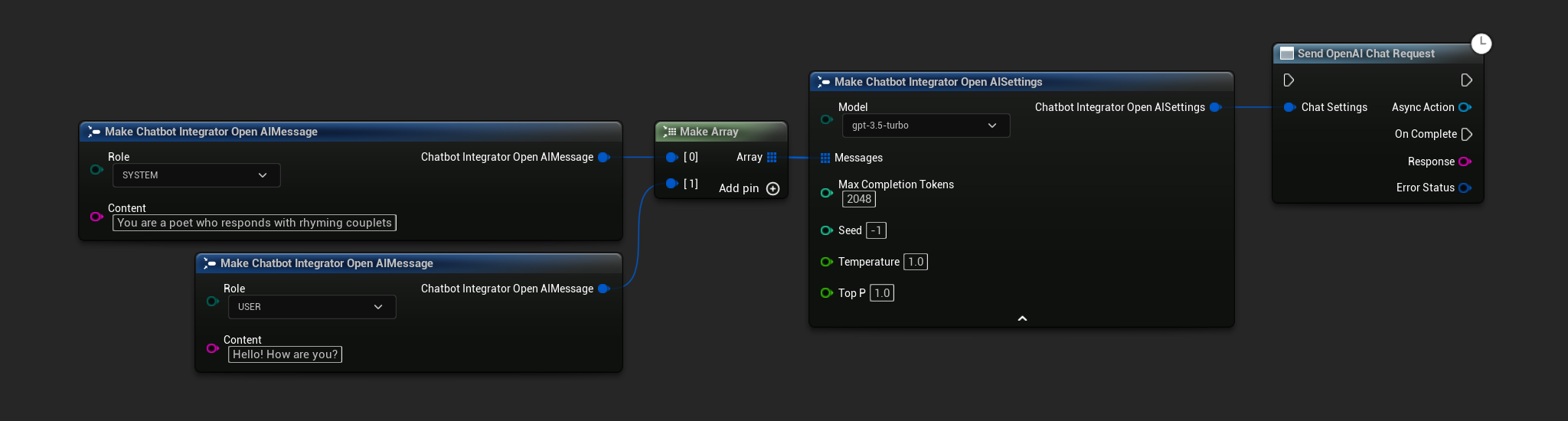

- OpenAI

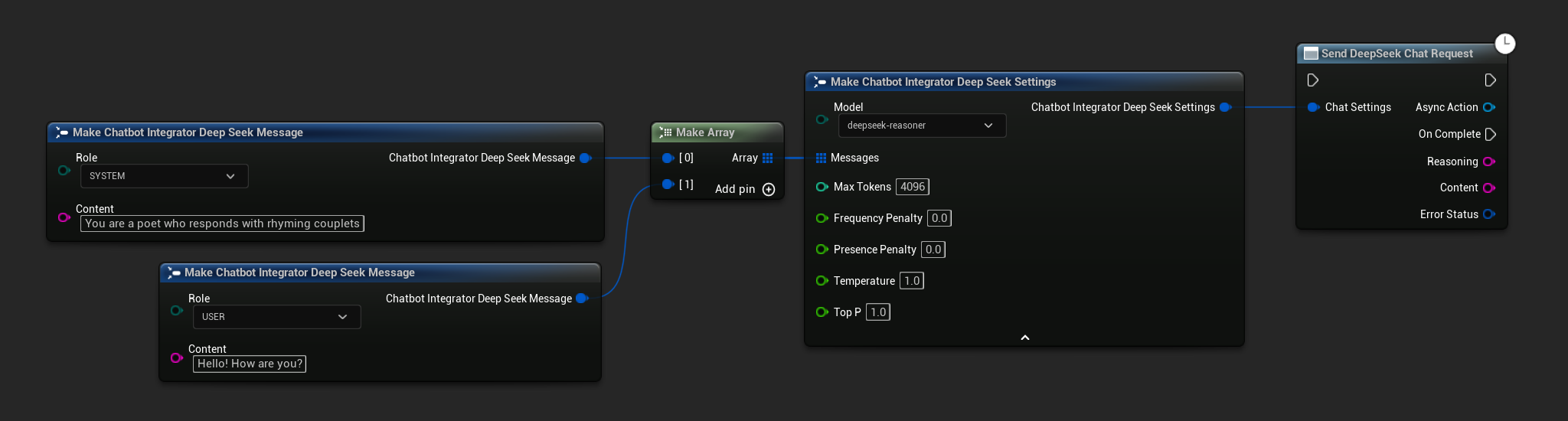

- DeepSeek

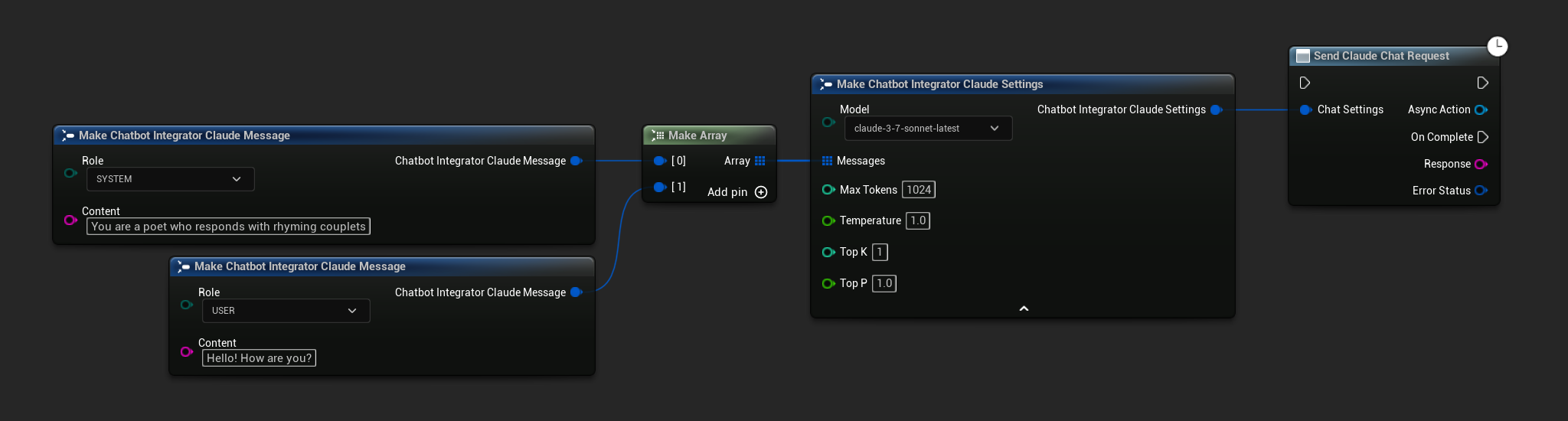

- Claude

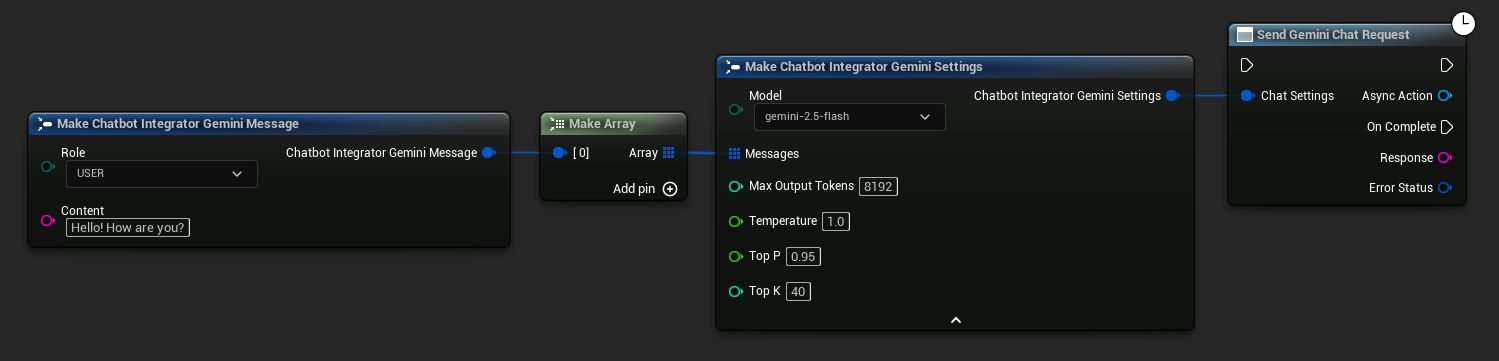

- Gemini

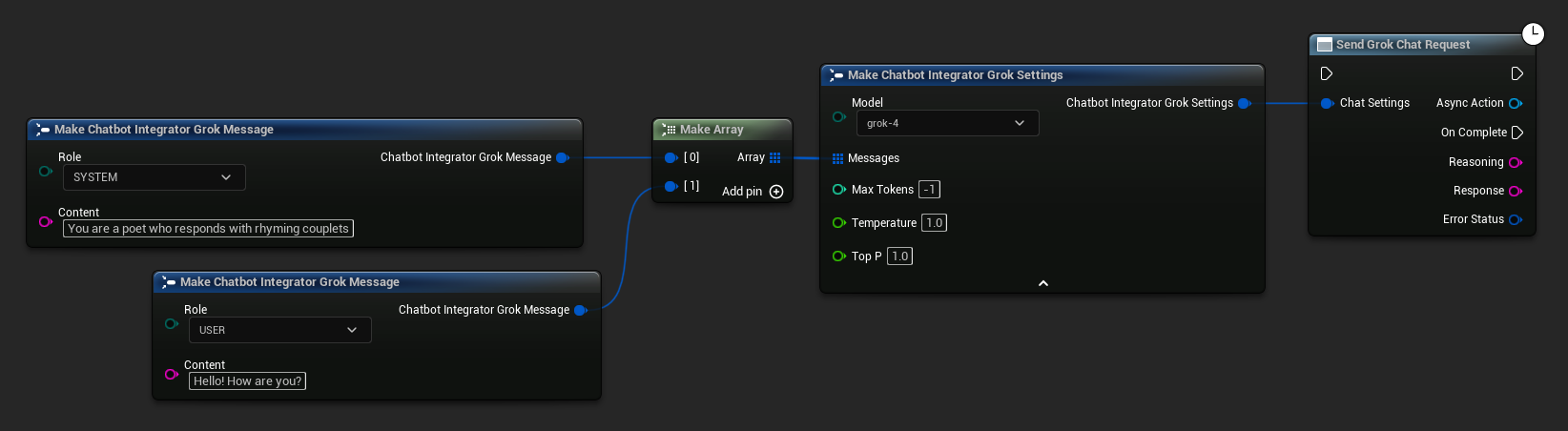

- Grok

- Blueprint

- C++

// Example of sending a non-streaming chat request to OpenAI

FChatbotIntegrator_OpenAISettings Settings;

Settings.Messages.Add(FChatbotIntegrator_OpenAIMessage{

EChatbotIntegrator_OpenAIRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_OpenAIMessage{

EChatbotIntegrator_OpenAIRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorOpenAI::SendChatRequestNative(

Settings,

FOnOpenAIChatCompletionResponseNative::CreateWeakLambda(

this,

[this](const FString& Response, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Chat completion response: %s, Error: %d: %s"),

*Response, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a non-streaming chat request to DeepSeek

FChatbotIntegrator_DeepSeekSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_DeepSeekMessage{

EChatbotIntegrator_DeepSeekRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_DeepSeekMessage{

EChatbotIntegrator_DeepSeekRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorDeepSeek::SendChatRequestNative(

Settings,

FOnDeepSeekChatCompletionResponseNative::CreateWeakLambda(

this,

[this](const FString& Reasoning, const FString& Content, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Chat completion reasoning: %s, Content: %s, Error: %d: %s"),

*Reasoning, *Content, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a non-streaming chat request to Claude

FChatbotIntegrator_ClaudeSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_ClaudeMessage{

EChatbotIntegrator_ClaudeRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_ClaudeMessage{

EChatbotIntegrator_ClaudeRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorClaude::SendChatRequestNative(

Settings,

FOnClaudeChatCompletionResponseNative::CreateWeakLambda(

this,

[this](const FString& Response, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Chat completion response: %s, Error: %d: %s"),

*Response, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a non-streaming chat request to Gemini

FChatbotIntegrator_GeminiSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_GeminiMessage{

EChatbotIntegrator_GeminiRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorGemini::SendChatRequestNative(

Settings,

FOnGeminiChatCompletionResponseNative::CreateWeakLambda(

this,

[this](const FString& Response, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Chat completion response: %s, Error: %d: %s"),

*Response, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a non-streaming chat request to Grok

FChatbotIntegrator_GrokSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_GrokMessage{

EChatbotIntegrator_GrokRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_GrokMessage{

EChatbotIntegrator_GrokRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorGrok::SendChatRequestNative(

Settings,

FOnGrokChatCompletionResponseNative::CreateWeakLambda(

this,

[this](const FString& Reasoning, const FString& Response, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Chat completion reasoning: %s, Response: %s, Error: %d: %s"),

*Reasoning, *Response, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

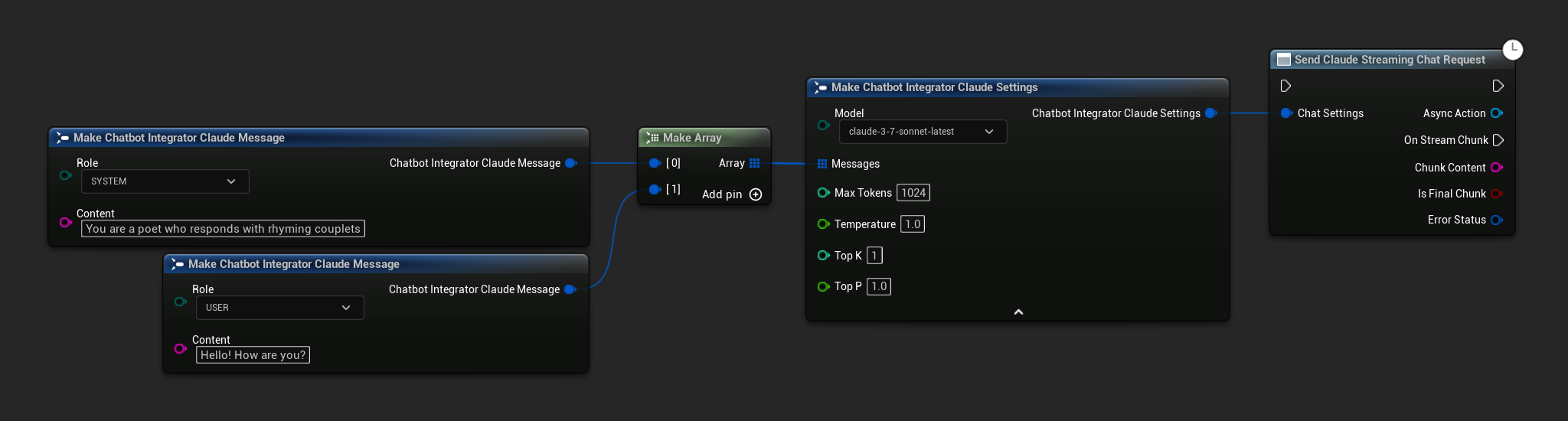

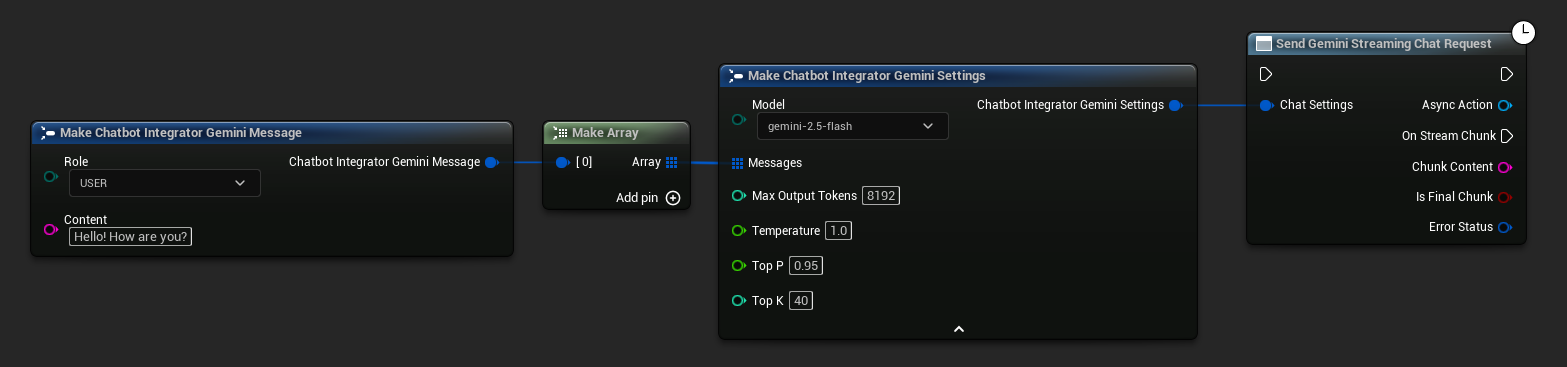

Streaming-Chat-Anfragen

Empfangen Sie Antwort-Chunks in Echtzeit für eine dynamischere Interaktion.

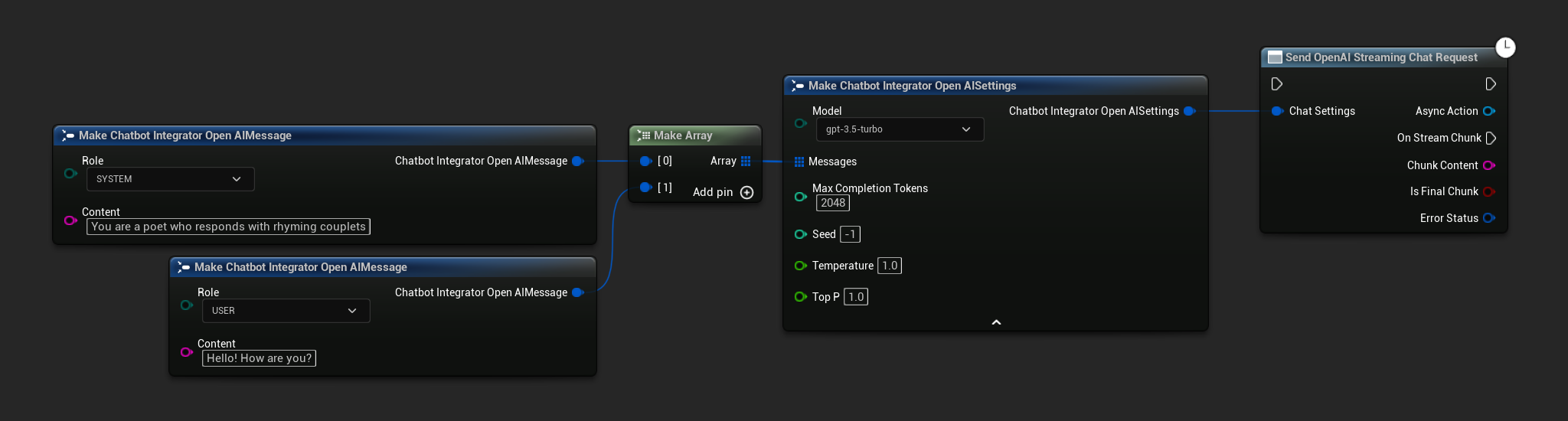

- OpenAI

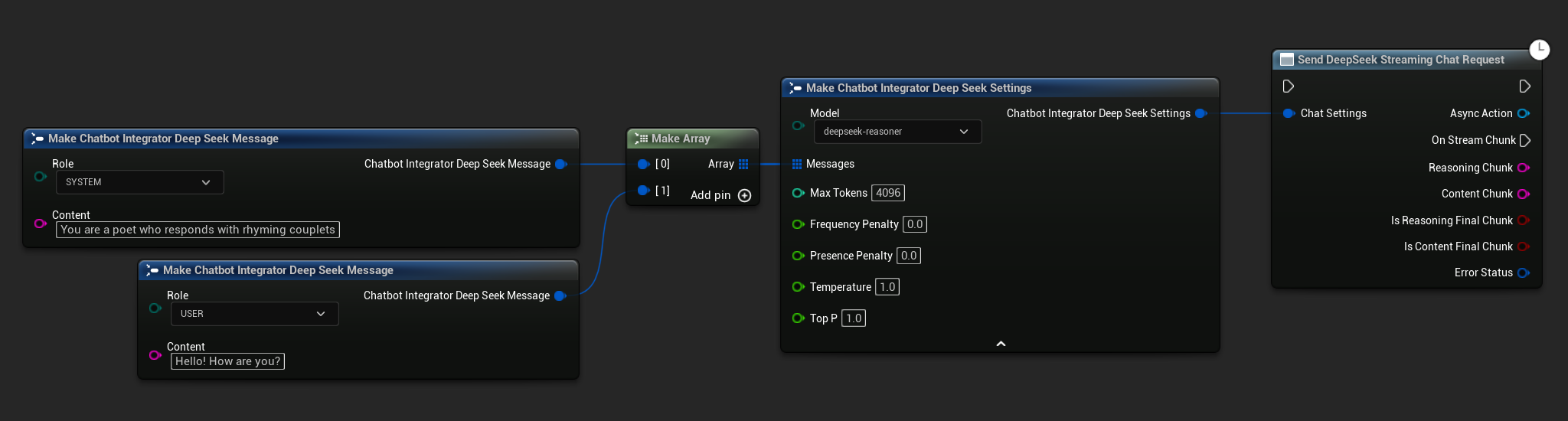

- DeepSeek

- Claude

- Gemini

- Grok

- Blueprint

- C++

// Example of sending a streaming chat request to OpenAI

FChatbotIntegrator_OpenAIStreamingSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_OpenAIMessage{

EChatbotIntegrator_OpenAIRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_OpenAIMessage{

EChatbotIntegrator_OpenAIRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorOpenAIStream::SendStreamingChatRequestNative(

Settings,

FOnOpenAIChatCompletionStreamNative::CreateWeakLambda(

this,

[this](const FString& ChunkContent, bool IsFinalChunk, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Streaming chat chunk: %s, IsFinalChunk: %d, Error: %d: %s"),

*ChunkContent, IsFinalChunk, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a streaming chat request to DeepSeek

FChatbotIntegrator_DeepSeekSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_DeepSeekMessage{

EChatbotIntegrator_DeepSeekRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_DeepSeekMessage{

EChatbotIntegrator_DeepSeekRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorDeepSeekStream::SendStreamingChatRequestNative(

Settings,

FOnDeepSeekChatCompletionStreamNative::CreateWeakLambda(

this,

[this](const FString& ReasoningChunk, const FString& ContentChunk,

bool IsReasoningFinalChunk, bool IsContentFinalChunk,

const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Streaming reasoning: %s, content: %s, Error: %d: %s"),

*ReasoningChunk, *ContentChunk, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a streaming chat request to Claude

FChatbotIntegrator_ClaudeSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_ClaudeMessage{

EChatbotIntegrator_ClaudeRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_ClaudeMessage{

EChatbotIntegrator_ClaudeRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorClaudeStream::SendStreamingChatRequestNative(

Settings,

FOnClaudeChatCompletionStreamNative::CreateWeakLambda(

this,

[this](const FString& ChunkContent, bool IsFinalChunk, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Streaming chat chunk: %s, IsFinalChunk: %d, Error: %d: %s"),

*ChunkContent, IsFinalChunk, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a streaming chat request to Gemini

FChatbotIntegrator_GeminiSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_GeminiMessage{

EChatbotIntegrator_GeminiRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorGeminiStream::SendStreamingChatRequestNative(

Settings,

FOnGeminiChatCompletionStreamNative::CreateWeakLambda(

this,

[this](const FString& ChunkContent, bool IsFinalChunk, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Streaming chat chunk: %s, IsFinalChunk: %d, Error: %d: %s"),

*ChunkContent, IsFinalChunk, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

- Blueprint

- C++

// Example of sending a streaming chat request to Grok

FChatbotIntegrator_GrokSettings Settings;

Settings.Messages.Add(FChatbotIntegrator_GrokMessage{

EChatbotIntegrator_GrokRole::SYSTEM,

TEXT("You are a helpful assistant.")

});

Settings.Messages.Add(FChatbotIntegrator_GrokMessage{

EChatbotIntegrator_GrokRole::USER,

TEXT("What is the capital of France?")

});

UAIChatbotIntegratorGrokStream::SendStreamingChatRequestNative(

Settings,

FOnGrokChatCompletionStreamNative::CreateWeakLambda(

this,

[this](const FString& ReasoningChunk, const FString& ContentChunk,

bool IsReasoningFinalChunk, bool IsContentFinalChunk,

const FChatbotIntegratorErrorStatus& ErrorStatus)

{

UE_LOG(LogTemp, Log, TEXT("Streaming reasoning: %s, content: %s, Error: %d: %s"),

*ReasoningChunk, *ContentChunk, ErrorStatus.bIsError, *ErrorStatus.ErrorMessage);

}

)

);

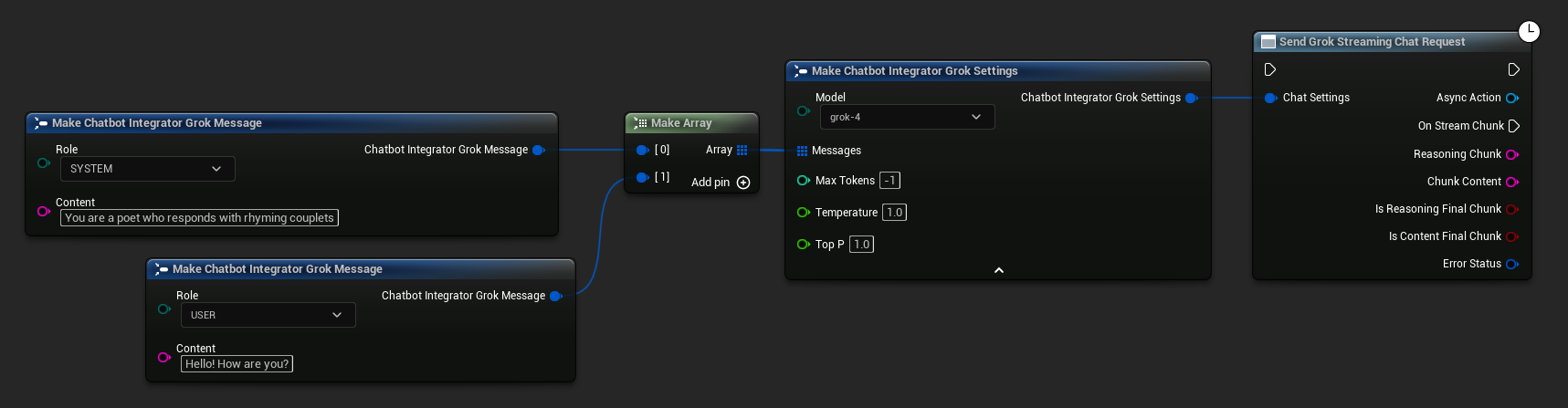

Text-to-Speech (TTS)-Funktionalität

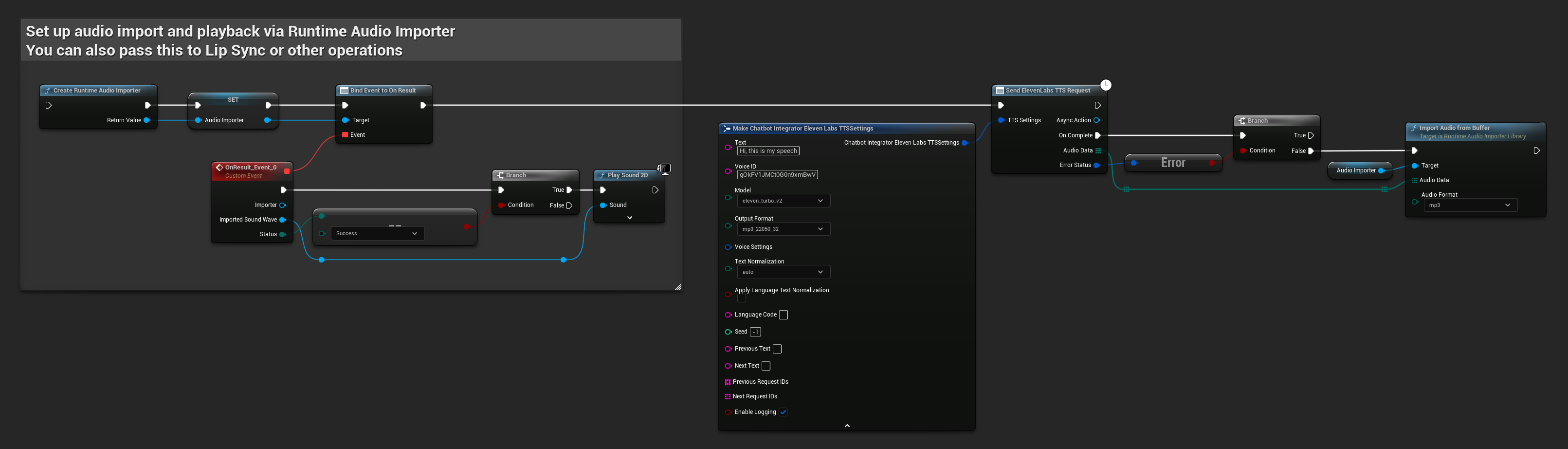

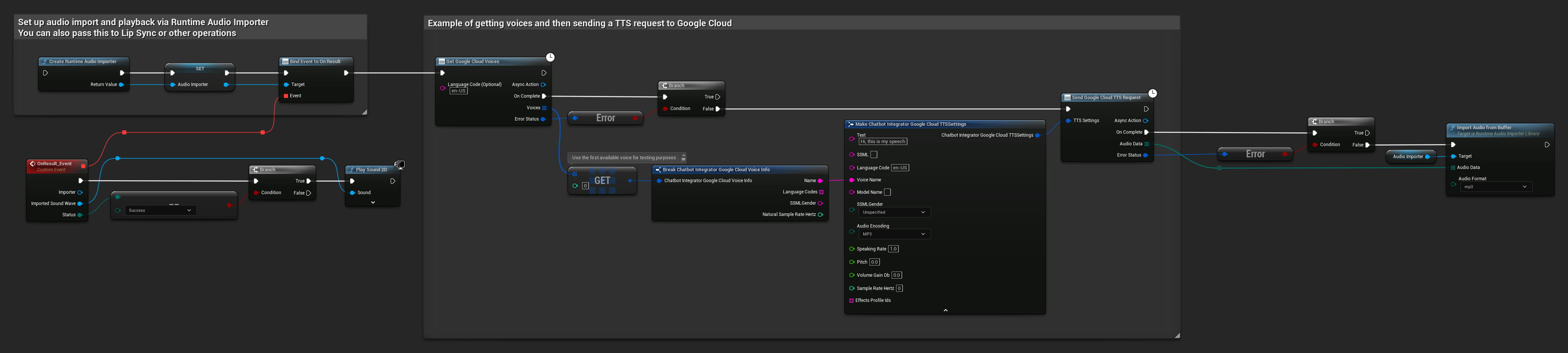

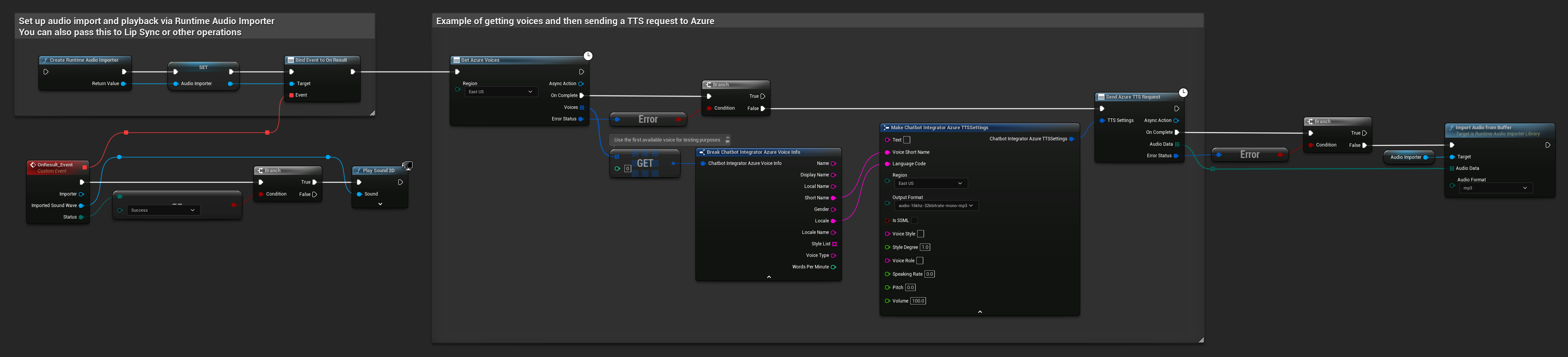

Konvertieren Sie Text in hochwertige Sprach-Audio mit führenden TTS-Anbietern. Das Plugin gibt Roh-Audiodaten (TArray<uint8>) zurück, die Sie entsprechend den Anforderungen Ihres Projekts verarbeiten können.

Während die folgenden Beispiele die Audioverarbeitung für die Wiedergabe mit dem Runtime Audio Importer-Plugin demonstrieren (siehe Audio-Import-Dokumentation), ist der Runtime AI Chatbot Integrator flexibel gestaltet. Das Plugin gibt einfach die Roh-Audiodaten zurück und gibt Ihnen damit volle Freiheit, wie Sie diese für Ihren spezifischen Anwendungsfall verarbeiten. Dies kann Audio-Wiedergabe, Speichern in Dateien, weitere Audioverarbeitung, Übertragung an andere Systeme, benutzerdefinierte Visualisierungen und mehr umfassen.

Nicht-Streaming TTS-Anfragen

Nicht-Streaming TTS-Anfragen liefern die vollständigen Audiodaten in einer einzigen Antwort, nachdem der gesamte Text verarbeitet wurde. Dieser Ansatz eignet sich für kürzere Texte, bei denen das Warten auf das vollständige Audio kein Problem darstellt.

- OpenAI TTS

- ElevenLabs TTS

- Google Cloud TTS

- Azure TTS

- Blueprint

- C++

// Example of sending a TTS request to OpenAI

FChatbotIntegrator_OpenAITTSSettings TTSSettings;

TTSSettings.Input = TEXT("Hello, this is a test of text-to-speech functionality.");

TTSSettings.Voice = EChatbotIntegrator_OpenAITTSVoice::NOVA;

TTSSettings.Speed = 1.0f;

TTSSettings.ResponseFormat = EChatbotIntegrator_OpenAITTSFormat::MP3;

UAIChatbotIntegratorOpenAITTS::SendTTSRequestNative(

TTSSettings,

FOnOpenAITTSResponseNative::CreateWeakLambda(

this,

[this](const TArray<uint8>& AudioData, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError)

{

// Process the audio data using Runtime Audio Importer plugin

UE_LOG(LogTemp, Log, TEXT("Received TTS audio data: %d bytes"), AudioData.Num());

URuntimeAudioImporterLibrary* RuntimeAudioImporter = URuntimeAudioImporterLibrary::CreateRuntimeAudioImporter();

RuntimeAudioImporter->AddToRoot();

RuntimeAudioImporter->OnResultNative.AddWeakLambda(this, [this](URuntimeAudioImporterLibrary* Importer, UImportedSoundWave* ImportedSoundWave, ERuntimeImportStatus Status)

{

if (Status == ERuntimeImportStatus::SuccessfulImport)

{

UE_LOG(LogTemp, Warning, TEXT("Successfully imported audio"));

// Handle ImportedSoundWave playback

}

Importer->RemoveFromRoot();

});

RuntimeAudioImporter->ImportAudioFromBuffer(AudioData, ERuntimeAudioFormat::Mp3);

}

}

)

);

- Blueprint

- C++

// Example of sending a TTS request to ElevenLabs

FChatbotIntegrator_ElevenLabsTTSSettings TTSSettings;

TTSSettings.Text = TEXT("Hello, this is a test of text-to-speech functionality.");

TTSSettings.VoiceID = TEXT("your-voice-id");

TTSSettings.Model = EChatbotIntegrator_ElevenLabsTTSModel::ELEVEN_TURBO_V2;

TTSSettings.OutputFormat = EChatbotIntegrator_ElevenLabsTTSFormat::MP3_44100_128;

UAIChatbotIntegratorElevenLabsTTS::SendTTSRequestNative(

TTSSettings,

FOnElevenLabsTTSResponseNative::CreateWeakLambda(

this,

[this](const TArray<uint8>& AudioData, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError)

{

UE_LOG(LogTemp, Log, TEXT("Received TTS audio data: %d bytes"), AudioData.Num());

// Process audio data as needed

}

}

)

);

- Blueprint

- C++

// Example of getting voices and then sending a TTS request to Google Cloud

// First, get available voices

UAIChatbotIntegratorGoogleCloudVoices::GetVoicesNative(

TEXT("en-US"), // Optional language filter

FOnGoogleCloudVoicesResponseNative::CreateWeakLambda(

this,

[this](const TArray<FChatbotIntegrator_GoogleCloudVoiceInfo>& Voices, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError && Voices.Num() > 0)

{

// Use the first available voice

const FChatbotIntegrator_GoogleCloudVoiceInfo& FirstVoice = Voices[0];

UE_LOG(LogTemp, Log, TEXT("Using voice: %s"), *FirstVoice.Name);

// Now send TTS request with the selected voice

FChatbotIntegrator_GoogleCloudTTSSettings TTSSettings;

TTSSettings.Text = TEXT("Hello, this is a test of text-to-speech functionality.");

TTSSettings.LanguageCode = FirstVoice.LanguageCodes.Num() > 0 ? FirstVoice.LanguageCodes[0] : TEXT("en-US");

TTSSettings.VoiceName = FirstVoice.Name;

TTSSettings.AudioEncoding = EChatbotIntegrator_GoogleCloudAudioEncoding::MP3;

UAIChatbotIntegratorGoogleCloudTTS::SendTTSRequestNative(

TTSSettings,

FOnGoogleCloudTTSResponseNative::CreateWeakLambda(

this,

[this](const TArray<uint8>& AudioData, const FChatbotIntegratorErrorStatus& TTSErrorStatus)

{

if (!TTSErrorStatus.bIsError)

{

UE_LOG(LogTemp, Log, TEXT("Received TTS audio data: %d bytes"), AudioData.Num());

// Process the audio data using Runtime Audio Importer plugin

URuntimeAudioImporterLibrary* RuntimeAudioImporter = URuntimeAudioImporterLibrary::CreateRuntimeAudioImporter();

RuntimeAudioImporter->AddToRoot();

RuntimeAudioImporter->OnResultNative.AddWeakLambda(this, [this](URuntimeAudioImporterLibrary* Importer, UImportedSoundWave* ImportedSoundWave, ERuntimeImportStatus Status)

{

if (Status == ERuntimeImportStatus::SuccessfulImport)

{

UE_LOG(LogTemp, Warning, TEXT("Successfully imported audio"));

// Handle ImportedSoundWave playback

}

Importer->RemoveFromRoot();

});

RuntimeAudioImporter->ImportAudioFromBuffer(AudioData, ERuntimeAudioFormat::Mp3);

}

else

{

UE_LOG(LogTemp, Error, TEXT("TTS request failed: %s"), *TTSErrorStatus.ErrorMessage);

}

}

)

);

}

else

{

UE_LOG(LogTemp, Error, TEXT("Failed to get voices: %s"), *ErrorStatus.ErrorMessage);

}

}

)

);

- Blueprint

- C++

// Example of getting voices and then sending a TTS request to Azure

// First, get available voices

UAIChatbotIntegratorAzureGetVoices::GetVoicesNative(

EChatbotIntegrator_AzureRegion::EAST_US,

FOnAzureVoiceListResponseNative::CreateWeakLambda(

this,

[this](const TArray<FChatbotIntegrator_AzureVoiceInfo>& Voices, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError && Voices.Num() > 0)

{

// Use the first available voice

const FChatbotIntegrator_AzureVoiceInfo& FirstVoice = Voices[0];

UE_LOG(LogTemp, Log, TEXT("Using voice: %s (%s)"), *FirstVoice.DisplayName, *FirstVoice.ShortName);

// Now send TTS request with the selected voice

FChatbotIntegrator_AzureTTSSettings TTSSettings;

TTSSettings.Text = TEXT("Hello, this is a test of text-to-speech functionality.");

TTSSettings.VoiceShortName = FirstVoice.ShortName;

TTSSettings.LanguageCode = FirstVoice.Locale;

TTSSettings.Region = EChatbotIntegrator_AzureRegion::EAST_US;

TTSSettings.OutputFormat = EChatbotIntegrator_AzureTTSFormat::AUDIO_16KHZ_32KBITRATE_MONO_MP3;

UAIChatbotIntegratorAzureTTS::SendTTSRequestNative(

TTSSettings,

FOnAzureTTSResponseNative::CreateWeakLambda(

this,

[this](const TArray<uint8>& AudioData, const FChatbotIntegratorErrorStatus& TTSErrorStatus)

{

if (!TTSErrorStatus.bIsError)

{

UE_LOG(LogTemp, Log, TEXT("Received TTS audio data: %d bytes"), AudioData.Num());

// Process the audio data using Runtime Audio Importer plugin

URuntimeAudioImporterLibrary* RuntimeAudioImporter = URuntimeAudioImporterLibrary::CreateRuntimeAudioImporter();

RuntimeAudioImporter->AddToRoot();

RuntimeAudioImporter->OnResultNative.AddWeakLambda(this, [this](URuntimeAudioImporterLibrary* Importer, UImportedSoundWave* ImportedSoundWave, ERuntimeImportStatus Status)

{

if (Status == ERuntimeImportStatus::SuccessfulImport)

{

UE_LOG(LogTemp, Warning, TEXT("Successfully imported audio"));

// Handle ImportedSoundWave playback

}

Importer->RemoveFromRoot();

});

RuntimeAudioImporter->ImportAudioFromBuffer(AudioData, ERuntimeAudioFormat::Mp3);

}

else

{

UE_LOG(LogTemp, Error, TEXT("TTS request failed: %s"), *TTSErrorStatus.ErrorMessage);

}

}

)

);

}

else

{

UE_LOG(LogTemp, Error, TEXT("Failed to get voices: %s"), *ErrorStatus.ErrorMessage);

}

}

)

);

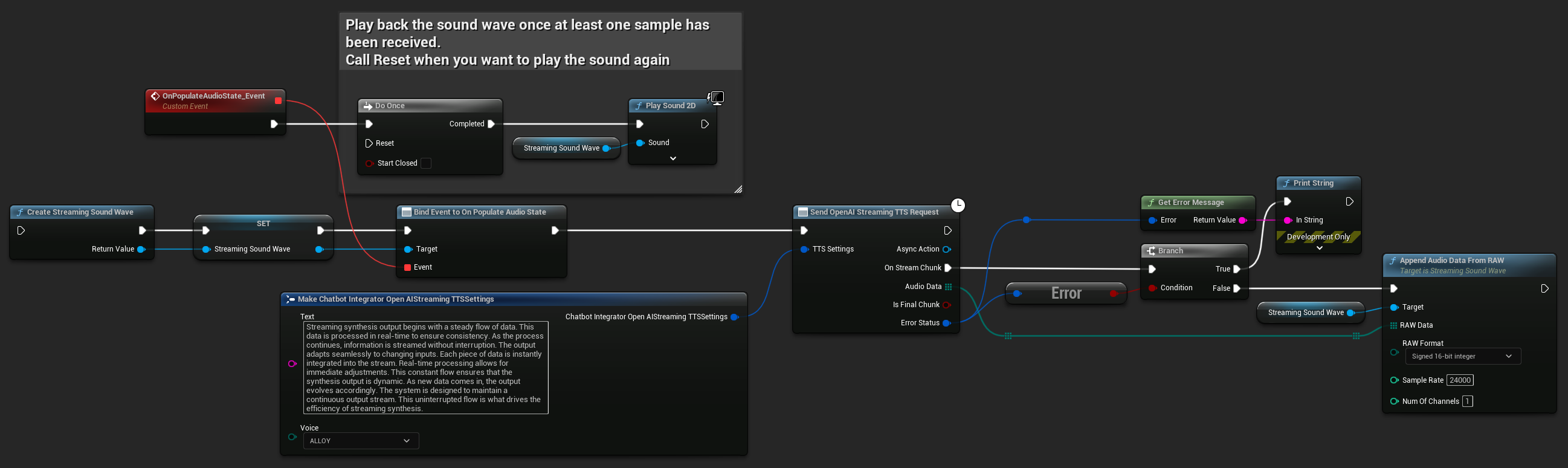

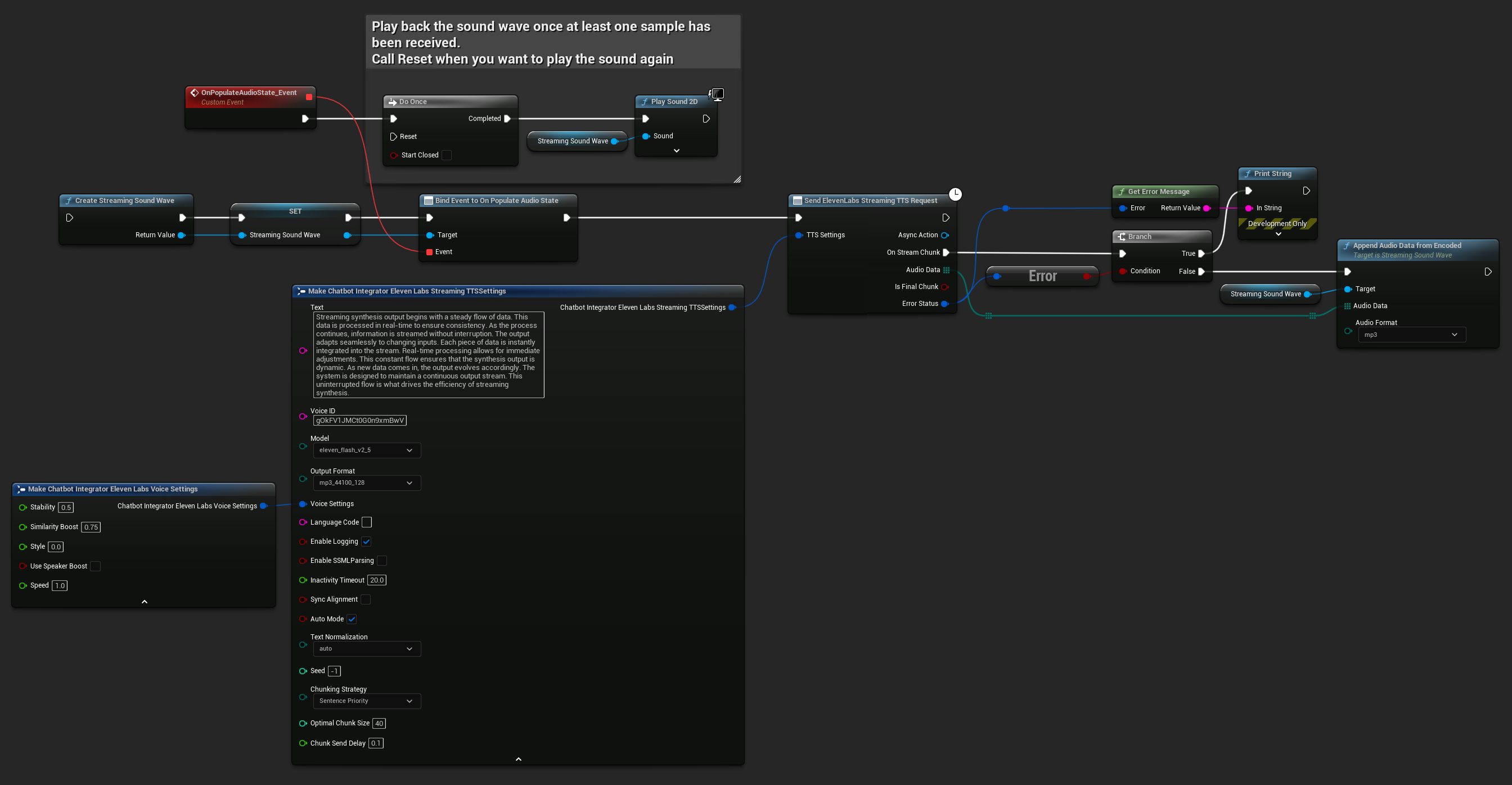

Streaming TTS-Anfragen

Streaming TTS liefert Audio-Chunks, sobald sie generiert werden, und ermöglicht es Ihnen, Daten inkrementell zu verarbeiten, anstatt auf die vollständige Synthese des Audios zu warten. Dies reduziert die wahrgenommene Latenz für längere Texte erheblich und ermöglicht Echtzeitanwendungen. ElevenLabs Streaming TTS unterstützt auch erweiterte Chunked-Streaming-Funktionen für Szenarien mit dynamischer Texterzeugung.

- OpenAI Streaming TTS

- ElevenLabs Streaming TTS

- Blueprint

- C++

UPROPERTY()

UStreamingSoundWave* StreamingSoundWave;

UPROPERTY()

bool bIsPlaying = false;

UFUNCTION(BlueprintCallable)

void StartStreamingTTS()

{

// Create a sound wave for streaming if not already created

if (!StreamingSoundWave)

{

StreamingSoundWave = UStreamingSoundWave::CreateStreamingSoundWave();

StreamingSoundWave->OnPopulateAudioStateNative.AddWeakLambda(this, [this]()

{

if (!bIsPlaying)

{

bIsPlaying = true;

UGameplayStatics::PlaySound2D(GetWorld(), StreamingSoundWave);

}

});

}

FChatbotIntegrator_OpenAIStreamingTTSSettings TTSSettings;

TTSSettings.Text = TEXT("Streaming synthesis output begins with a steady flow of data. This data is processed in real-time to ensure consistency.");

TTSSettings.Voice = EChatbotIntegrator_OpenAIStreamingTTSVoice::ALLOY;

UAIChatbotIntegratorOpenAIStreamTTS::SendStreamingTTSRequestNative(TTSSettings, FOnOpenAIStreamingTTSNative::CreateWeakLambda(this, [this](const TArray<uint8>& AudioData, bool IsFinalChunk, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError)

{

UE_LOG(LogTemp, Log, TEXT("Received TTS audio chunk: %d bytes"), AudioData.Num());

StreamingSoundWave->AppendAudioDataFromRAW(AudioData, ERuntimeRAWAudioFormat::Int16, 24000, 1);

}

}));

}

ElevenLabs Streaming TTS unterstützt sowohl den Standard-Streaming-Modus als auch den erweiterten Chunked-Streaming-Modus, was Flexibilität für verschiedene Anwendungsfälle bietet.

Standard-Streaming-Modus

Der Standard-Streaming-Modus verarbeitet vordefinierten Text und liefert Audio-Chunks, sobald sie generiert werden.

- Blueprint

- C++

UPROPERTY()

UStreamingSoundWave* StreamingSoundWave;

UPROPERTY()

bool bIsPlaying = false;

UFUNCTION(BlueprintCallable)

void StartStreamingTTS()

{

// Create a sound wave for streaming if not already created

if (!StreamingSoundWave)

{

StreamingSoundWave = UStreamingSoundWave::CreateStreamingSoundWave();

StreamingSoundWave->OnPopulateAudioStateNative.AddWeakLambda(this, [this]()

{

if (!bIsPlaying)

{

bIsPlaying = true;

UGameplayStatics::PlaySound2D(GetWorld(), StreamingSoundWave);

}

});

}

FChatbotIntegrator_ElevenLabsStreamingTTSSettings TTSSettings;

TTSSettings.Text = TEXT("Streaming synthesis output begins with a steady flow of data. This data is processed in real-time to ensure consistency.");

TTSSettings.Model = EChatbotIntegrator_ElevenLabsTTSModel::ELEVEN_TURBO_V2_5;

TTSSettings.OutputFormat = EChatbotIntegrator_ElevenLabsTTSFormat::MP3_22050_32;

TTSSettings.VoiceID = TEXT("YOUR_VOICE_ID");

TTSSettings.bEnableChunkedStreaming = false; // Standard streaming mode

UAIChatbotIntegratorElevenLabsStreamTTS::SendStreamingTTSRequestNative(GetWorld(), TTSSettings, FOnElevenLabsStreamingTTSNative::CreateWeakLambda(this, [this](const TArray<uint8>& AudioData, bool IsFinalChunk, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError)

{

UE_LOG(LogTemp, Log, TEXT("Received TTS audio chunk: %d bytes"), AudioData.Num());

StreamingSoundWave->AppendAudioDataFromEncoded(AudioData, ERuntimeAudioFormat::Mp3);

}

}));

}

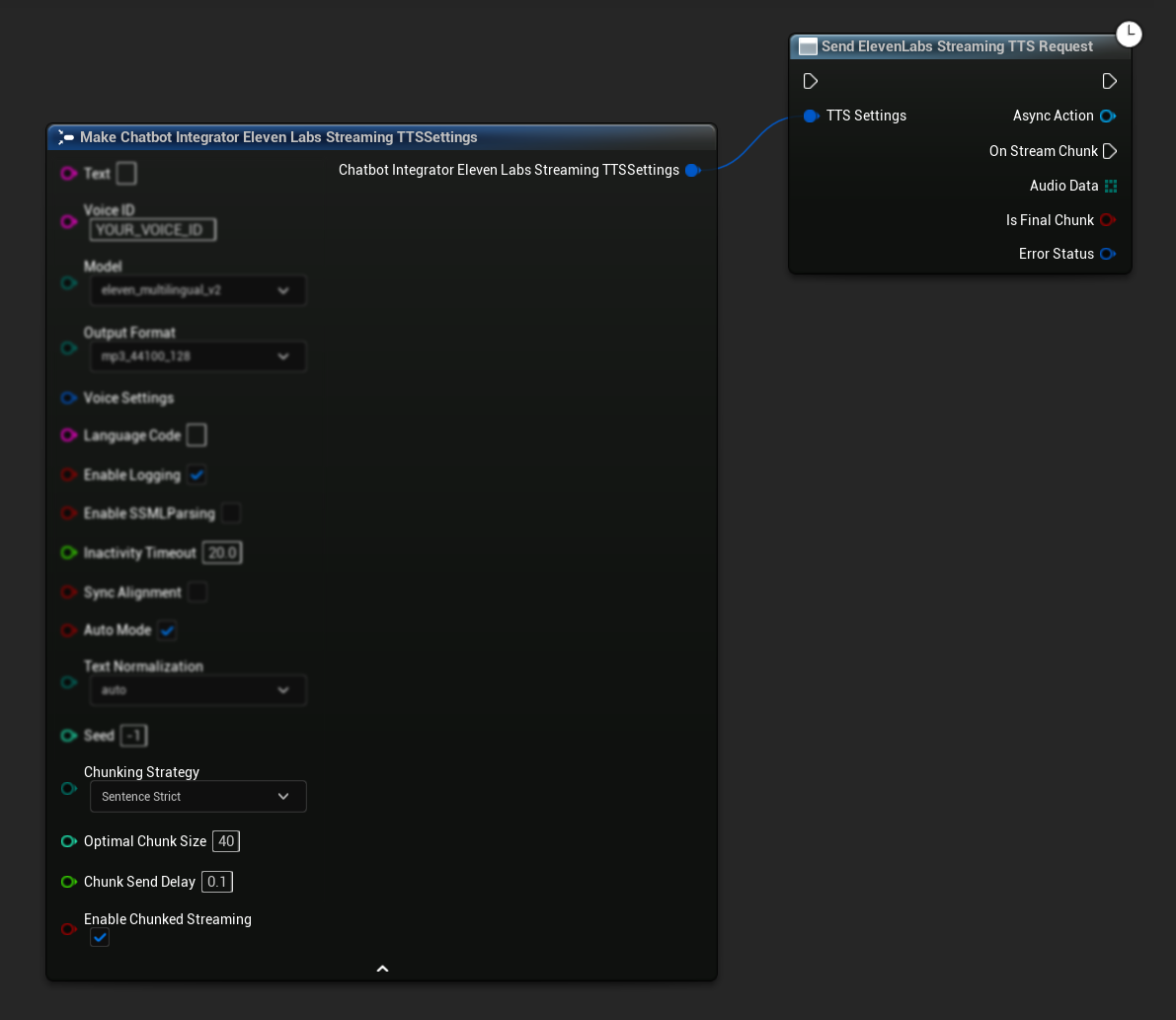

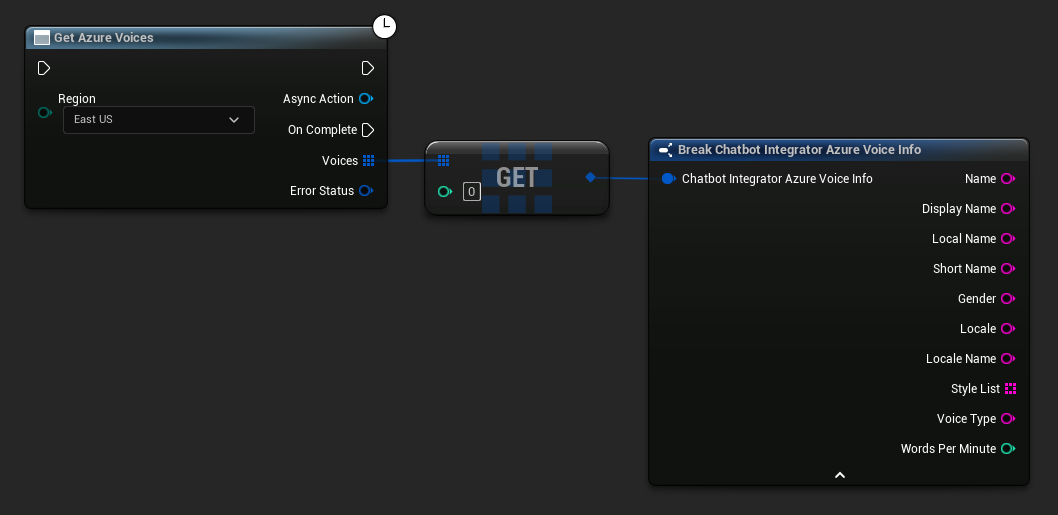

Modus für gestückeltes Streaming

Der Modus für gestückeltes Streaming ermöglicht es Ihnen, Text während der Synthese dynamisch anzuhängen, perfekt für Echtzeitanwendungen, in denen Text inkrementell generiert wird (z. B. KI-Chat-Antworten, die synthetisiert werden, während sie generiert werden). Um diesen Modus zu aktivieren, setzen Sie bEnableChunkedStreaming in Ihren TTS-Einstellungen auf true.

- Blueprint

- C++

Ersteinrichtung: Richten Sie gestückeltes Streaming ein, indem Sie den gestückelten Streaming-Modus in Ihren TTS-Einstellungen aktivieren und die initiale Anfrage erstellen. Die Anfragefunktion gibt ein asynchrones Aktionsobjekt zurück, das Methoden zur Verwaltung der gestückelten Streaming-Sitzung bereitstellt:

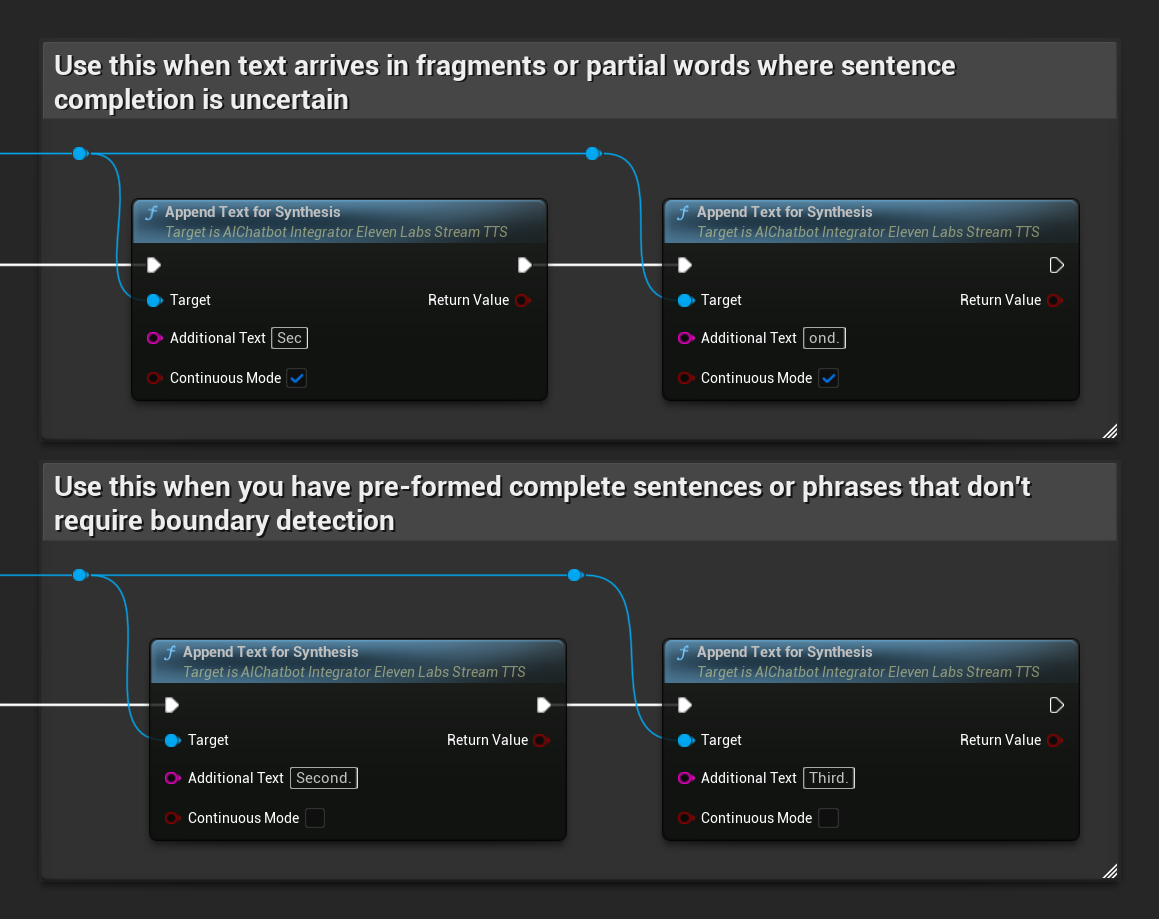

Text zur Synthese anhängen:

Verwenden Sie diese Funktion auf dem zurückgegebenen asynchronen Aktionsobjekt, um während einer aktiven gestückelten Streaming-Sitzung dynamisch Text hinzuzufügen. Der Parameter bContinuousMode steuert, wie der Text verarbeitet wird:

- Wenn

bContinuousModetrueist: Text wird intern gepuffert, bis vollständige Satzgrenzen erkannt werden (Punkte, Ausrufezeichen, Fragezeichen). Das System extrahiert automatisch vollständige Sätze zur Synthese, während unvollständiger Text im Puffer bleibt. Verwenden Sie dies, wenn Text in Fragmenten oder Teilwörtern ankommt, bei denen die Satzvollständigkeit ungewiss ist. - Wenn

bContinuousModefalseist: Text wird sofort ohne Pufferung oder Satzgrenzenanalyse verarbeitet. Jeder Aufruf führt zu sofortiger Chunk-Verarbeitung und Synthese. Verwenden Sie dies, wenn Sie vorgeformte, vollständige Sätze oder Phrasen haben, die keine Grenzenerkennung erfordern.

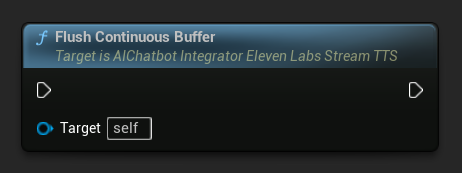

Kontinuierlichen Puffer leeren: Erzwingt die Verarbeitung von gepuffertem kontinuierlichem Text auf dem asynchronen Aktionsobjekt, selbst wenn keine Satzgrenze erkannt wurde. Nützlich, wenn Sie wissen, dass eine Weile kein weiterer Text mehr kommen wird:

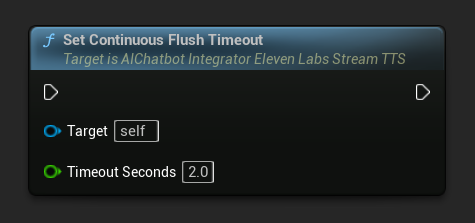

Kontinuierlichen Leerungs-Timeout setzen: Konfiguriert das automatische Leeren des kontinuierlichen Puffers auf dem asynchronen Aktionsobjekt, wenn innerhalb des angegebenen Timeouts kein neuer Text eintrifft:

Auf 0 setzen, um automatisches Leeren zu deaktivieren. Empfohlene Werte sind 1-3 Sekunden für Echtzeitanwendungen.

Gestückeltes Streaming beenden: Schließt die gestückelte Streaming-Sitzung auf dem asynchronen Aktionsobjekt und markiert die aktuelle Synthese als final. Rufen Sie dies immer auf, wenn Sie mit dem Hinzufügen von Text fertig sind:

UPROPERTY()

UAIChatbotIntegratorElevenLabsStreamTTS* ChunkedTTSRequest;

UPROPERTY()

UStreamingSoundWave* StreamingSoundWave;

UPROPERTY()

bool bIsPlaying = false;

UFUNCTION(BlueprintCallable)

void StartChunkedStreamingTTS()

{

// Create a sound wave for streaming if not already created

if (!StreamingSoundWave)

{

StreamingSoundWave = UStreamingSoundWave::CreateStreamingSoundWave();

StreamingSoundWave->OnPopulateAudioStateNative.AddWeakLambda(this, [this]()

{

if (!bIsPlaying)

{

bIsPlaying = true;

UGameplayStatics::PlaySound2D(GetWorld(), StreamingSoundWave);

}

});

}

FChatbotIntegrator_ElevenLabsStreamingTTSSettings TTSSettings;

TTSSettings.Text = TEXT(""); // Start with empty text in chunked mode

TTSSettings.Model = EChatbotIntegrator_ElevenLabsTTSModel::ELEVEN_TURBO_V2_5;

TTSSettings.OutputFormat = EChatbotIntegrator_ElevenLabsTTSFormat::MP3_22050_32;

TTSSettings.VoiceID = TEXT("YOUR_VOICE_ID");

TTSSettings.bEnableChunkedStreaming = true; // Enable chunked streaming mode

// Store the returned async action object to call chunked streaming functions on it

ChunkedTTSRequest = UAIChatbotIntegratorElevenLabsStreamTTS::SendStreamingTTSRequestNative(

GetWorld(),

TTSSettings,

FOnElevenLabsStreamingTTSNative::CreateWeakLambda(this, [this](const TArray<uint8>& AudioData, bool IsFinalChunk, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError && AudioData.Num() > 0)

{

UE_LOG(LogTemp, Log, TEXT("Received TTS audio chunk: %d bytes"), AudioData.Num());

StreamingSoundWave->AppendAudioDataFromEncoded(AudioData, ERuntimeAudioFormat::Mp3);

}

if (IsFinalChunk)

{

UE_LOG(LogTemp, Log, TEXT("Chunked streaming session completed"));

ChunkedTTSRequest = nullptr;

}

})

);

// Now you can append text dynamically as it becomes available

// For example, from an AI chat response stream:

AppendTextToTTS(TEXT("Hello, this is the first part of the message. "));

}

UFUNCTION(BlueprintCallable)

void AppendTextToTTS(const FString& AdditionalText)

{

// Call AppendTextForSynthesis on the returned async action object

if (ChunkedTTSRequest)

{

// Use continuous mode (true) when text is being generated word-by-word

// and you want to wait for complete sentences before processing

bool bContinuousMode = true;

bool bSuccess = ChunkedTTSRequest->AppendTextForSynthesis(AdditionalText, bContinuousMode);

if (bSuccess)

{

UE_LOG(LogTemp, Log, TEXT("Successfully appended text: %s"), *AdditionalText);

}

}

}

// Configure continuous text buffering with custom timeout

UFUNCTION(BlueprintCallable)

void SetupAdvancedChunkedStreaming()

{

// Call SetContinuousFlushTimeout on the async action object

if (ChunkedTTSRequest)

{

// Set automatic flush timeout to 1.5 seconds

// Text will be automatically processed if no new text arrives within this timeframe

ChunkedTTSRequest->SetContinuousFlushTimeout(1.5f);

}

}

// Example of handling real-time AI chat response synthesis

UFUNCTION(BlueprintCallable)

void HandleAIChatResponseForTTS(const FString& ChatChunk, bool IsStreamFinalChunk)

{

if (ChunkedTTSRequest)

{

if (!IsStreamFinalChunk)

{

// Append each chat chunk in continuous mode

// The system will automatically extract complete sentences for synthesis

ChunkedTTSRequest->AppendTextForSynthesis(ChatChunk, true);

}

else

{

// Add the final chunk

ChunkedTTSRequest->AppendTextForSynthesis(ChatChunk, true);

// Flush any remaining buffered text and finish the session

ChunkedTTSRequest->FlushContinuousBuffer();

ChunkedTTSRequest->FinishChunkedStreaming();

}

}

}

// Example of immediate chunk processing (bypassing sentence boundary detection)

UFUNCTION(BlueprintCallable)

void AppendImmediateText(const FString& Text)

{

// Call AppendTextForSynthesis with continuous mode = false on the async action object

if (ChunkedTTSRequest)

{

// Use continuous mode = false for immediate processing

// Useful when you have complete sentences or phrases ready

ChunkedTTSRequest->AppendTextForSynthesis(Text, false);

}

}

UFUNCTION(BlueprintCallable)

void FinishChunkedTTS()

{

// Call FlushContinuousBuffer and FinishChunkedStreaming on the async action object

if (ChunkedTTSRequest)

{

// Flush any remaining buffered text

ChunkedTTSRequest->FlushContinuousBuffer();

// Mark the session as finished

ChunkedTTSRequest->FinishChunkedStreaming();

}

}

Wichtige Funktionen von ElevenLabs Chunked Streaming:

- Kontinuierlicher Modus: Wenn

bContinuousModetrueist, wird Text gepuffert, bis vollständige Satzgrenzen erkannt werden, und dann für die Synthese verarbeitet - Sofortiger Modus: Wenn

bContinuousModefalseist, wird Text sofort als separate Chunks ohne Pufferung verarbeitet - Automatisches Leeren: Konfigurierbares Timeout verarbeitet gepufferten Text, wenn innerhalb des angegebenen Zeitrahmens keine neue Eingabe eintrifft

- Satzgrenzenerkennung: Erkennt Satzenden (., !, ?) und extrahiert vollständige Sätze aus gepuffertem Text

- Echtzeit-Integration: Unterstützt inkrementelle Texteingabe, bei der Inhalte im Laufe der Zeit in Fragmenten eintreffen

- Flexible Text-Chunking: Mehrere Strategien verfügbar (Sentence Priority, Sentence Strict, Size Based) zur Optimierung der Syntheseverarbeitung

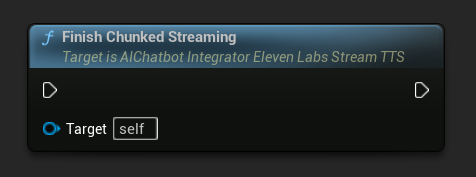

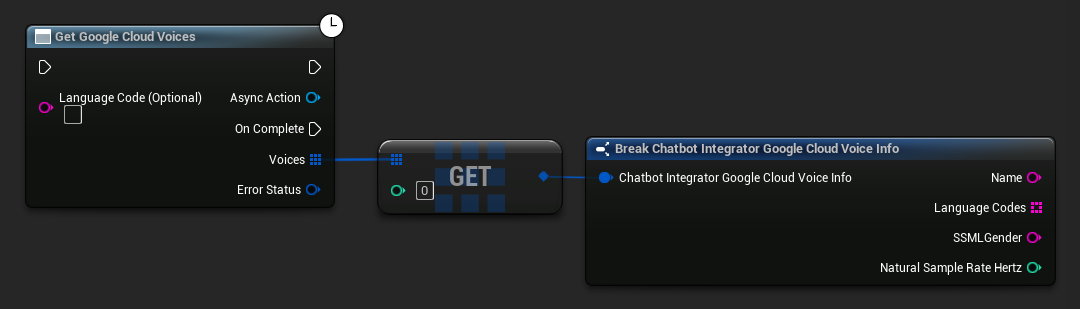

Verfügbare Stimmen abrufen

Einige TTS-Anbieter bieten Voice-Listing-APIs an, um verfügbare Stimmen programmatisch zu ermitteln.

- Google Cloud Voices

- Azure Voices

- Blueprint

- C++

// Example of getting available voices from Google Cloud

UAIChatbotIntegratorGoogleCloudVoices::GetVoicesNative(

TEXT("en-US"), // Optional language filter

FOnGoogleCloudVoicesResponseNative::CreateWeakLambda(

this,

[this](const TArray<FChatbotIntegrator_GoogleCloudVoiceInfo>& Voices, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError)

{

for (const auto& Voice : Voices)

{

UE_LOG(LogTemp, Log, TEXT("Voice: %s (%s)"), *Voice.Name, *Voice.SSMLGender);

}

}

}

)

);

- Blueprint

- C++

// Example of getting available voices from Azure

UAIChatbotIntegratorAzureGetVoices::GetVoicesNative(

EChatbotIntegrator_AzureRegion::EAST_US,

FOnAzureVoiceListResponseNative::CreateWeakLambda(

this,

[this](const TArray<FChatbotIntegrator_AzureVoiceInfo>& Voices, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (!ErrorStatus.bIsError)

{

for (const auto& Voice : Voices)

{

UE_LOG(LogTemp, Log, TEXT("Voice: %s (%s)"), *Voice.DisplayName, *Voice.Gender);

}

}

}

)

);

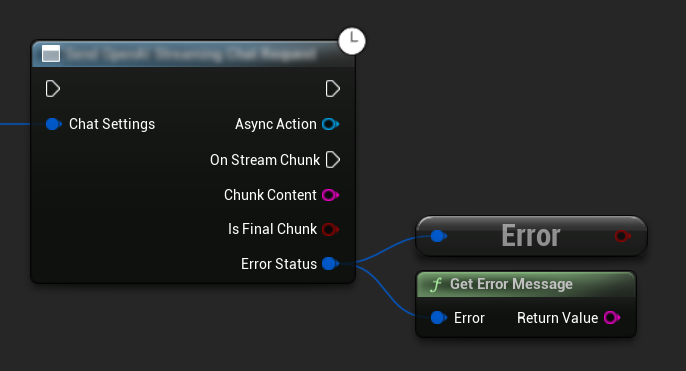

Fehlerbehandlung

Beim Senden von Anfragen ist es entscheidend, potenzielle Fehler zu behandeln, indem Sie den ErrorStatus in Ihrem Callback überprüfen. Der ErrorStatus liefert Informationen über Probleme, die während der Anfrage auftreten können.

- Blueprint

- C++

// Example of error handling in a request

UAIChatbotIntegratorOpenAI::SendChatRequestNative(

Settings,

FOnOpenAIChatCompletionResponseNative::CreateWeakLambda(

this,

[this](const FString& Response, const FChatbotIntegratorErrorStatus& ErrorStatus)

{

if (ErrorStatus.bIsError)

{

// Handle the error

UE_LOG(LogTemp, Error, TEXT("Chat request failed: %s"), *ErrorStatus.ErrorMessage);

}

else

{

// Process the successful response

UE_LOG(LogTemp, Log, TEXT("Received response: %s"), *Response);

}

}

)

);

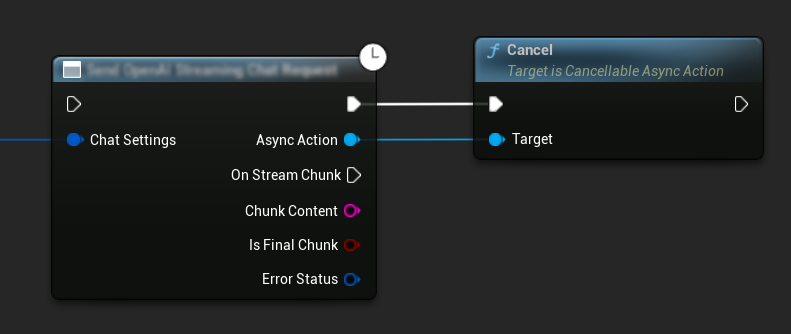

Anfragen abbrechen

Das Plugin ermöglicht es Ihnen, sowohl Text-zu-Text- als auch TTS-Anfragen abzubrechen, während sie noch laufen. Dies kann nützlich sein, wenn Sie eine lang laufende Anfrage unterbrechen oder den Gesprächsverlauf dynamisch ändern möchten.

- Blueprint

- C++

// Example of cancelling requests

UAIChatbotIntegratorOpenAI* ChatRequest = UAIChatbotIntegratorOpenAI::SendChatRequestNative(

ChatSettings,

ChatResponseCallback

);

// Cancel the chat request at any time

ChatRequest->Cancel();

// TTS requests can be cancelled similarly

UAIChatbotIntegratorOpenAITTS* TTSRequest = UAIChatbotIntegratorOpenAITTS::SendTTSRequestNative(

TTSSettings,

TTSResponseCallback

);

// Cancel the TTS request

TTSRequest->Cancel();

Best Practices

- Behandeln Sie potenzielle Fehler immer durch Überprüfung des

ErrorStatusin Ihrem Callback - Achten Sie auf API-Ratenlimits und Kosten für jeden Anbieter

- Verwenden Sie den Streaming-Modus für langfristige oder interaktive Konversationen

- Erwägen Sie, Anfragen abzubrechen, die nicht mehr benötigt werden, um Ressourcen effizient zu verwalten

- Verwenden Sie Streaming-TTS für längere Texte, um die wahrgenommene Latenz zu reduzieren

- Für die Audioverarbeitung bietet das Runtime Audio Importer Plugin eine praktische Lösung, Sie können jedoch basierend auf Ihren Projektanforderungen eine benutzerdefinierte Verarbeitung implementieren

- Wenn Sie Reasoning-Modelle (DeepSeek Reasoner, Grok) verwenden, behandeln Sie sowohl die Reasoning- als auch die Inhaltsausgaben angemessen

- Entdecken Sie verfügbare Stimmen mithilfe von Voice-Listing-APIs, bevor Sie TTS-Funktionen implementieren

- Für ElevenLabs Chunked Streaming: Verwenden Sie den kontinuierlichen Modus, wenn Text inkrementell generiert wird (wie KI-Antworten), und den sofortigen Modus für vorgeformte Textblöcke

- Konfigurieren Sie angemessene Flush-Timeouts für den kontinuierlichen Modus, um Reaktionsfähigkeit mit natürlichem Sprachfluss auszugleichen

- Wählen Sie optimale Chunk-Größen und Sendeverzögerungen basierend auf den Echtzeitanforderungen Ihrer Anwendung

Troubleshooting

- Überprüfen Sie, ob Ihre API-Anmeldedaten für jeden Anbieter korrekt sind

- Überprüfen Sie Ihre Internetverbindung

- Stellen Sie sicher, dass alle von Ihnen verwendeten Audioverarbeitungsbibliotheken (wie Runtime Audio Importer) ordnungsgemäß installiert sind, wenn Sie mit TTS-Funktionen arbeiten

- Vergewissern Sie sich, dass Sie das richtige Audioformat bei der Verarbeitung von TTS-Antwortdaten verwenden

- Stellen Sie für Streaming-TTS sicher, dass Sie Audioblöcke korrekt verarbeiten

- Stellen Sie für Reasoning-Modelle sicher, dass Sie sowohl Reasoning- als auch Inhaltsausgaben verarbeiten

- Überprüfen Sie die anbieterspezifische Dokumentation auf Modellverfügbarkeit und -fähigkeiten

- Für ElevenLabs Chunked Streaming: Stellen Sie sicher, dass Sie

FinishChunkedStreamingaufrufen, wenn Sie fertig sind, um die Sitzung ordnungsgemäß zu schließen - Bei Problemen mit dem kontinuierlichen Modus: Überprüfen Sie, ob Satzgrenzen in Ihrem Text korrekt erkannt werden

- Für Echtzeitanwendungen: Passen Sie Chunk-Sendeverzögerungen und Flush-Timeouts basierend auf Ihren Latenzanforderungen an