Einrichtungsanleitung

Diese Anleitung führt Sie durch den grundlegenden Einrichtungsprozess für Runtime MetaHuman Lip Sync mit Ihren MetaHuman-Charakteren.

Hinweis: Runtime MetaHuman Lip Sync funktioniert sowohl mit MetaHuman- als auch mit benutzerdefinierten Charakteren. Detaillierte Anweisungen zur Einrichtung benutzerdefinierter Charaktere finden Sie in der Anleitung zur Einrichtung benutzerdefinierter Charaktere.

Voraussetzungen

Stellen Sie vor dem Start sicher:

-

MetaHuman-Plugin-Anforderungen:

- UE 5.5 und früher: Aktivieren Sie das MetaHuman-Plugin in Ihrem Projekt

- UE 5.6 und später: Aktivieren Sie das MetaHuman Core Tech-Plugin in Ihrem Projekt

Zusätzliche MetaHuman-PluginsJe nachdem, wie Sie Ihre MetaHuman-Charaktere erstellen, benötigen Sie möglicherweise zusätzliche Plugins. Wenn Sie beispielsweise einen MetaHuman mit dem neuen MetaHuman Creator-System erstellen möchten, das in UE 5.6 eingeführt wurde, müssen Sie auch das MetaHuman Creator-Plugin aktivieren. Weitere Informationen zu diesem System finden Sie in der MetaHuman Creator-Dokumentation.

-

Sie haben mindestens einen MetaHuman-Charakter heruntergeladen und in Ihrem Projekt verfügbar

-

Das Runtime MetaHuman Lip Sync-Plugin ist installiert

Standard-Modell-Erweiterungs-Plugin

Wenn Sie das Standard-Modell verwenden möchten, müssen Sie das Erweiterungs-Plugin installieren:

- Laden Sie das Standard Lip Sync Extension plugin von Google Drive herunter

- Extrahieren Sie den Ordner aus dem heruntergeladenen Archiv in den

Plugins-Ordner Ihres Projekts (erstellen Sie diesen Ordner, falls er nicht existiert) - Stellen Sie sicher, dass Ihr Projekt als C++-Projekt eingerichtet ist (auch wenn Sie keinen C++-Code haben)

- Bauen Sie Ihr Projekt neu

- Diese Erweiterung ist nur erforderlich, wenn Sie das Standard-Modell verwenden möchten. Wenn Sie nur die Realistischen Modelle benötigen, können Sie diesen Schritt überspringen.

- Weitere Informationen zum manuellen Erstellen von Plugins finden Sie im Tutorial zum Erstellen von Plugins

Zusätzliche Plugins

- Wenn Sie Audioaufnahme verwenden möchten (z. B. Mikrofoneingang), installieren Sie das Runtime Audio Importer-Plugin.

- Wenn Sie Text-zu-Sprache-Funktionalität verwenden möchten:

- Für lokale TTS (Standard-Modell und stimmungsfähiges realistisches Modell), installieren Sie das Runtime Text To Speech-Plugin.

- Für externe TTS-Anbieter (ElevenLabs, OpenAI, Google Cloud, Azure), installieren Sie das Runtime AI Chatbot Integrator-Plugin.

Animation Blueprint Setup

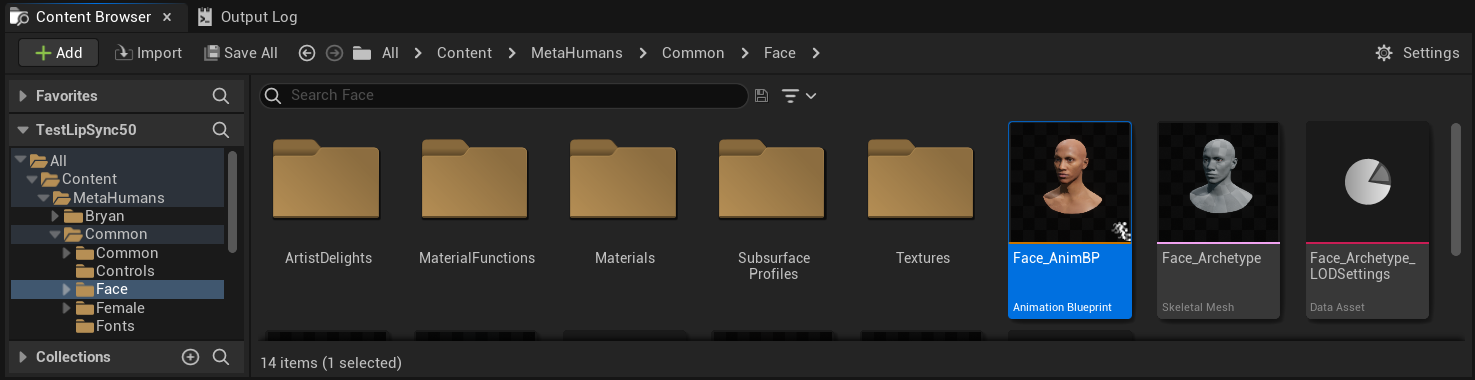

Schritt 1: Suchen und ändern Sie die Gesichtsanimations-Blueprint

- UE 5.5 und früher (oder Legacy MetaHumans in UE 5.6+)

- UE 5.6+ MetaHuman Creator Charaktere

Sie müssen eine Animation Blueprint ändern, die für die Gesichtsanimationen Ihres MetaHuman-Charakters verwendet wird. Die standardmäßige MetaHuman-Gesichtsanimations-Blueprint befindet sich unter:

Content/MetaHumans/Common/Face/Face_AnimBP

Sie haben mehrere Optionen zur Implementierung der Lippen-Synchronisations-Funktionalität:

- Standard-Asset bearbeiten (Einfachste Option)

- Duplikat erstellen

- Benutzerdefiniertes Animation Blueprint verwenden

Öffnen Sie die standardmäßige Face_AnimBP direkt und nehmen Sie Ihre Änderungen vor. Alle Änderungen wirken sich auf alle MetaHuman-Charaktere aus, die dieses Animation Blueprint verwenden.

Hinweis: Dieser Ansatz ist bequem, wirkt sich jedoch auf alle Charaktere aus, die das Standard-Animation Blueprint verwenden.

- Duplizieren Sie

Face_AnimBPund geben Sie ihm einen beschreibenden Namen - Suchen Sie die Blueprint-Klasse Ihres Charakters (z.B. für Charakter "Bryan" unter

Content/MetaHumans/Bryan/BP_Bryan) - Öffnen Sie die Charakter-Blueprint und finden Sie die Face-Komponente

- Ändern Sie die Anim Class-Eigenschaft auf Ihr neu dupliziertes Animation Blueprint

Hinweis: Dieser Ansatz ermöglicht es Ihnen, die Lippen-Synchronisation für bestimmte Charaktere anzupassen, während andere unverändert bleiben.

Sie können das Lippen-Synchronisations-Blending in jedem Animation Blueprint implementieren, das Zugriff auf die erforderlichen Gesichtsknochen hat:

- Erstellen oder verwenden Sie ein vorhandenes benutzerdefiniertes Animation Blueprint

- Stellen Sie sicher, dass Ihr Animation Blueprint mit einem Skelett funktioniert, das dieselben Gesichtsknochen wie das Standard-MetaHuman-

Face_Archetype_Skeletonenthält

Hinweis: Dieser Ansatz bietet Ihnen maximale Flexibilität für die Integration in benutzerdefinierte Animationssysteme.

Ab UE 5.6 wurde das neue MetaHuman Creator-System eingeführt. Für diese Charaktere stellt das Plugin ein Gesichts-Animation Blueprint bereit, das sich befindet unter:

Content/LipSyncData/LipSync_Face_AnimBP

Dieses Animation Blueprint befindet sich im Plugin-Content-Ordner und wird mit jedem Plugin-Update überschrieben. Um Ihre Anpassungen nicht zu verlieren:

- Kopieren Sie dieses Asset in den Content-Ordner Ihres Projekts (zum Beispiel nach

IhrProjekt/Content/MetaHumans/LipSync_Face_AnimBP) - Verwenden Sie Ihre kopierte Version in Ihrem Charakter-Setup

- Nehmen Sie alle Ihre Änderungen an der kopierten Version vor

Verwendung des Face Animation Blueprint des Plugins:

- Suchen Sie die Blueprint-Klasse Ihres MetaHuman Creator-Charakters

- Öffnen Sie die Charakter-Blueprint und finden Sie die Face-Komponente

- Ändern Sie die Anim Class-Eigenschaft auf das

LipSync_Face_AnimBPdes Plugins - Fahren Sie mit den nächsten Schritten fort, um die Runtime MetaHuman Lip Sync-Funktionalität zu konfigurieren

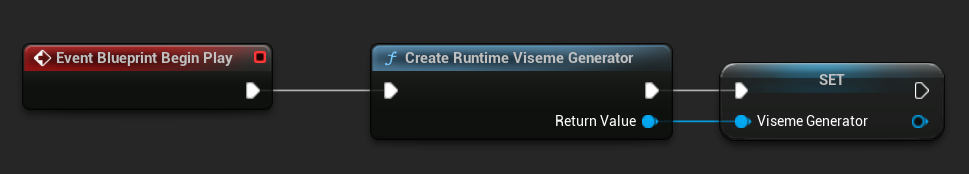

Schritt 2: Event Graph-Einrichtung

Öffnen Sie Ihr Face Animation Blueprint und wechseln Sie zum Event Graph. Sie müssen einen Generator erstellen, der Audiodaten verarbeitet und Lippen-Sync-Animationen erzeugt.

- Standard-Modell

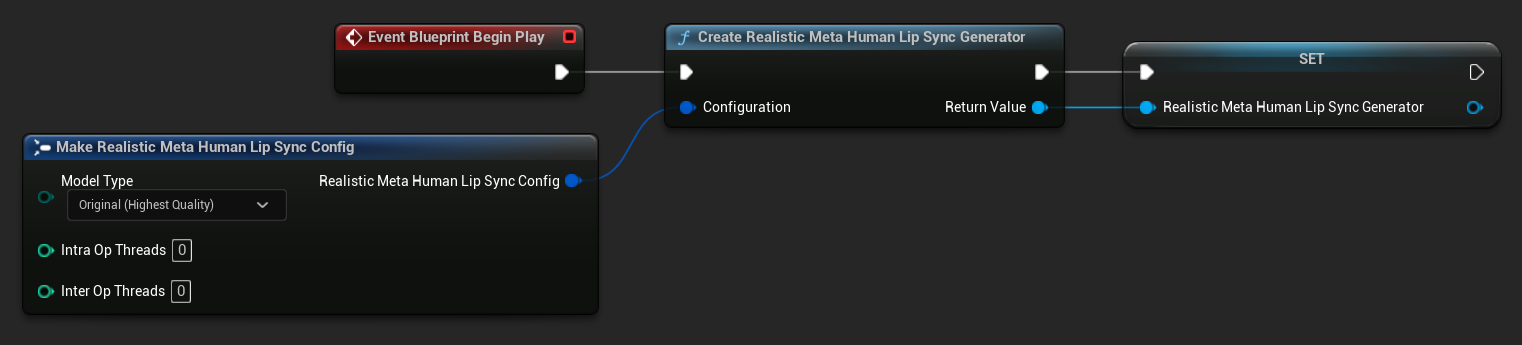

- Realistisches Modell

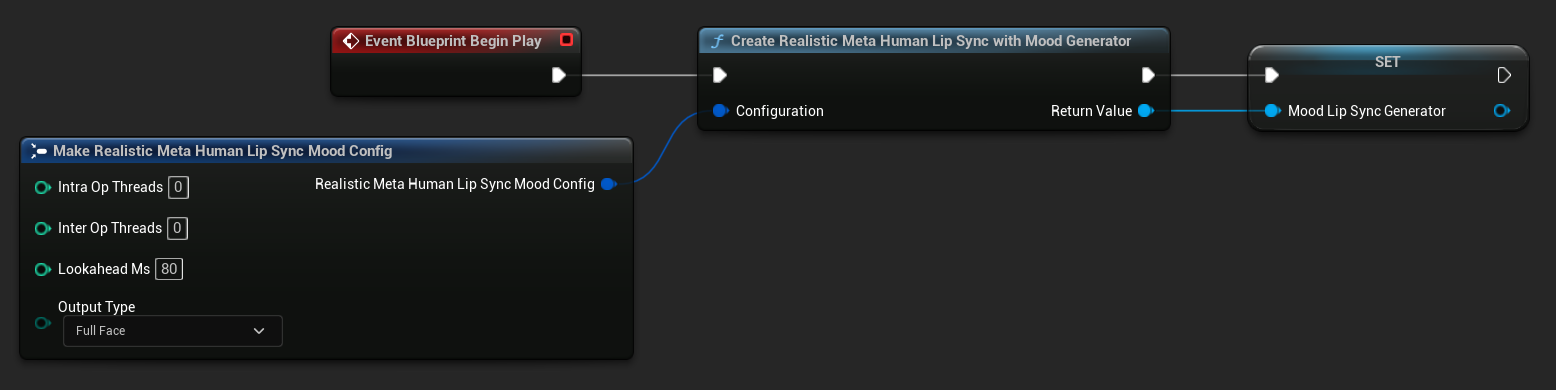

- Stimmungsfähiges Realistisches Modell

- Fügen Sie den

Event Blueprint Begin Play-Knoten hinzu, falls er noch nicht existiert - Fügen Sie den

Create Runtime Viseme Generator-Knoten hinzu und verbinden Sie ihn mit dem Begin Play-Ereignis - Speichern Sie die Ausgabe als Variable (z.B. "VisemeGenerator") zur Verwendung in anderen Teilen des Graphen

Detaillierte Konfigurationsoptionen finden Sie im Abschnitt Standard-Modell-Konfiguration.

- Fügen Sie den

Event Blueprint Begin Play-Knoten hinzu, falls er noch nicht existiert - Fügen Sie den

Create Realistic MetaHuman Lip Sync Generator-Knoten hinzu und verbinden Sie ihn mit dem Begin Play-Ereignis - Speichern Sie die Ausgabe als Variable (z.B. "RealisticMetaHumanLipSyncGenerator") zur Verwendung in anderen Teilen des Graphen

- (Optional) Konfigurieren Sie die Generator-Einstellungen mit dem Configuration-Parameter

Detaillierte Konfigurationsoptionen einschließlich Modelltypen, Leistungseinstellungen und Verarbeitungsparameter finden Sie im Abschnitt Realistic-Modell-Konfiguration.

- Fügen Sie den

Event Blueprint Begin Play-Knoten hinzu, falls er noch nicht existiert - Fügen Sie den

Create Realistic MetaHuman Lip Sync With Mood Generator-Knoten hinzu und verbinden Sie ihn mit dem Begin Play-Ereignis - Speichern Sie die Ausgabe als Variable (z.B. "MoodMetaHumanLipSyncGenerator") zur Verwendung in anderen Teilen des Graphen

- (Optional) Konfigurieren Sie die Generator-Einstellungen mit dem Configuration-Parameter

Detaillierte Stimmungskonfiguration einschließlich Stimmungstypen, Intensitätseinstellungen, Lookahead-Timing und Ausgabetypauswahl finden Sie im Abschnitt Konfiguration des stimmungsfähigen Modells.

Schritt 3: Anim Graph Einrichtung

Nachdem Sie den Event Graph eingerichtet haben, wechseln Sie zum Anim Graph, um den Generator mit der Animation der Figur zu verbinden:

- Standardmodell

- Realistisches Modell

- Stimmungsfähiges realistisches Modell

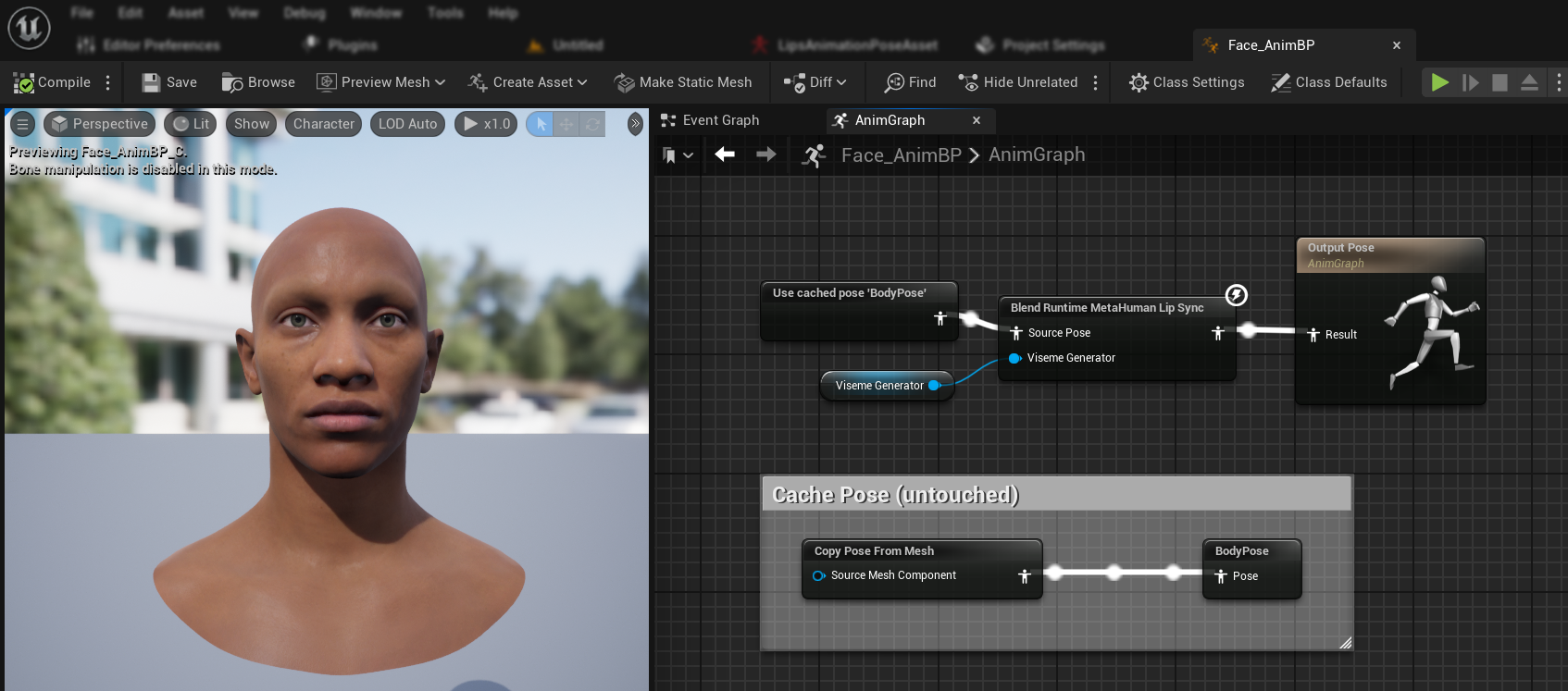

- Suchen Sie die Pose, die das MetaHuman-Gesicht enthält (typischerweise von

Use cached pose 'Body Pose') - Fügen Sie den

Blend Runtime MetaHuman Lip Sync-Node hinzu - Verbinden Sie die Pose mit dem

Source Pose-Eingang desBlend Runtime MetaHuman Lip Sync-Nodes - Verbinden Sie Ihre

VisemeGenerator-Variable mit demViseme Generator-Pin - Verbinden Sie die Ausgabe des

Blend Runtime MetaHuman Lip Sync-Nodes mit demResult-Pin derOutput Pose

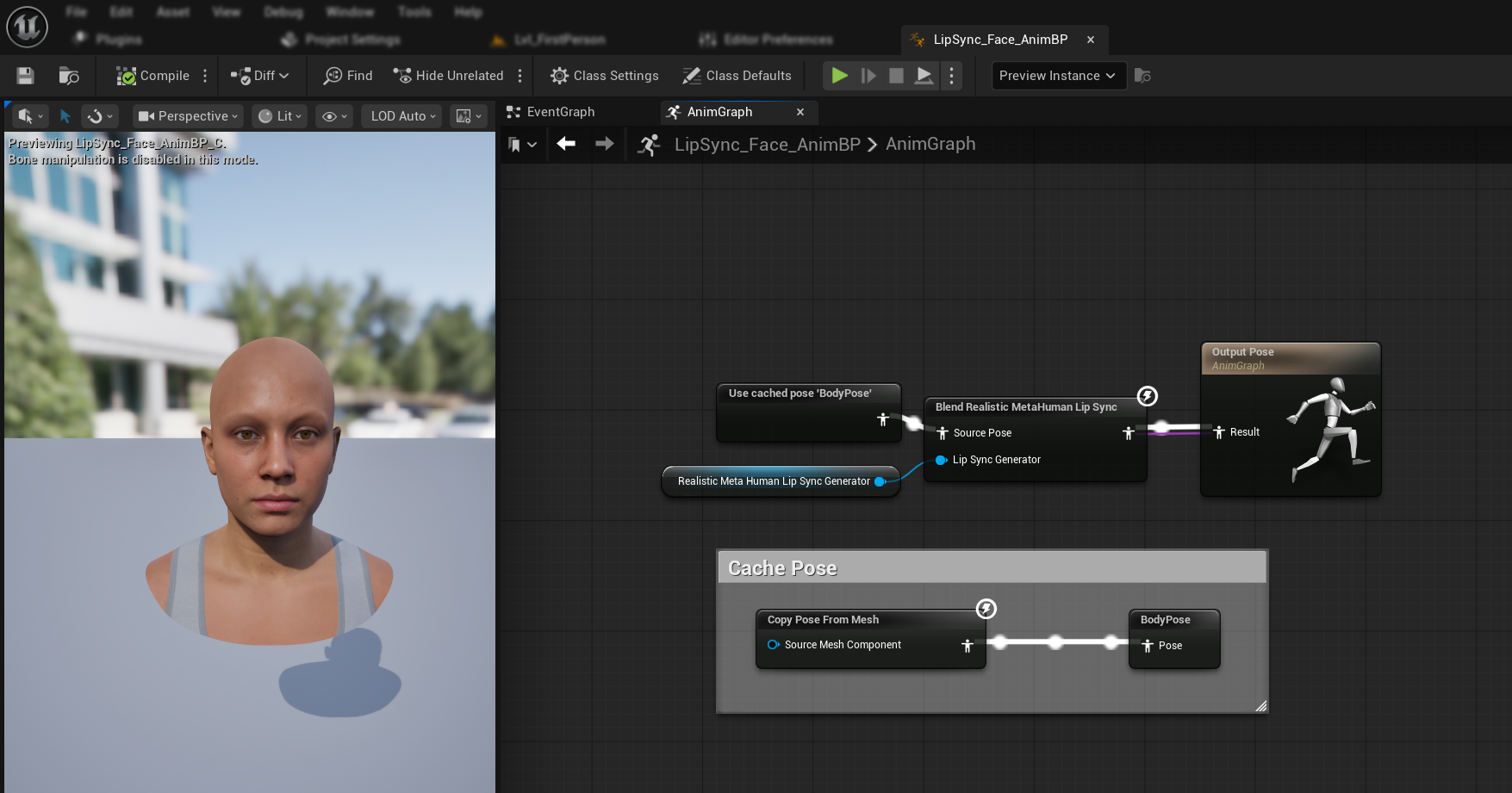

- Suchen Sie die Pose, die das MetaHuman-Gesicht enthält (typischerweise von

Use cached pose 'Body Pose') - Fügen Sie den

Blend Realistic MetaHuman Lip Sync-Node hinzu - Verbinden Sie die Pose mit dem

Source Pose-Eingang desBlend Realistic MetaHuman Lip Sync-Nodes - Verbinden Sie Ihre

RealisticMetaHumanLipSyncGenerator-Variable mit demLip Sync Generator-Pin - Verbinden Sie die Ausgabe des

Blend Realistic MetaHuman Lip Sync-Nodes mit demResult-Pin derOutput Pose

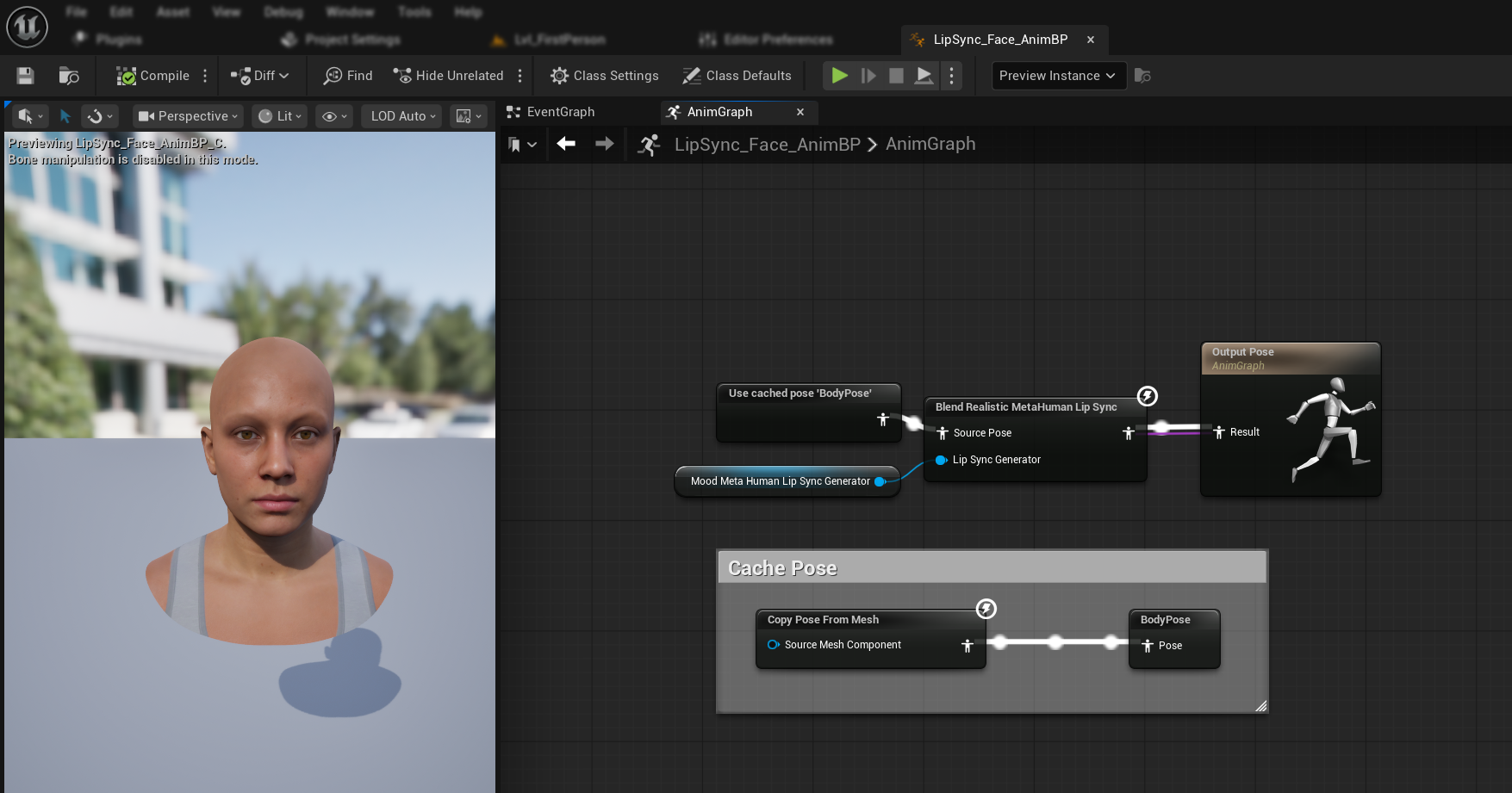

- Suchen Sie die Pose, die das MetaHuman-Gesicht enthält (typischerweise von

Use cached pose 'Body Pose') - Fügen Sie den

Blend Realistic MetaHuman Lip Sync-Node hinzu (derselbe Node wie beim regulären realistischen Modell) - Verbinden Sie die Pose mit dem

Source Pose-Eingang desBlend Realistic MetaHuman Lip Sync-Nodes - Verbinden Sie Ihre

MoodMetaHumanLipSyncGenerator-Variable mit demLip Sync Generator-Pin - Verbinden Sie die Ausgabe des

Blend Realistic MetaHuman Lip Sync-Nodes mit demResult-Pin derOutput Pose

Hinweis: Das stimmungsfähige Modell verwendet denselben Animation Blueprint-Node wie das reguläre realistische Modell. Die Stimmungsfunktionalität wird intern vom Generator verarbeitet.

Nächste Schritte

Nachdem Sie die grundlegende Animation Blueprint-Einrichtung abgeschlossen haben, müssen Sie nun die Audioeingabeverarbeitung konfigurieren, um Audiodaten an Ihren Lippen-Sync-Generator zu liefern.

Fahren Sie mit dem Audio-Verarbeitungsleitfaden fort, um zu erfahren, wie Sie verschiedene Audioeingabemethoden einrichten, einschließlich Mikrofonaufnahme, Text-zu-Sprache und Audiodateiverarbeitung. Für erweiterte Konfigurationsoptionen und Feinabstimmung siehe die Konfigurationsanleitung.