Proveedores de Traducción

El AI Localization Automator admite cinco proveedores de IA diferentes, cada uno con puntos fuertes únicos y opciones de configuración. Elige el proveedor que mejor se adapte a las necesidades, el presupuesto y los requisitos de calidad de tu proyecto.

Ollama (IA Local)

Ideal para: Proyectos sensibles a la privacidad, traducción sin conexión, uso ilimitado

Ollama ejecuta modelos de IA localmente en tu máquina, proporcionando privacidad y control completos sin costes de API ni requisitos de internet.

Modelos Populares

- llama3.2 (Recomendado para propósito general)

- mistral (Alternativa eficiente)

- codellama (Traducciones conscientes del código)

- Y muchos más modelos de la comunidad

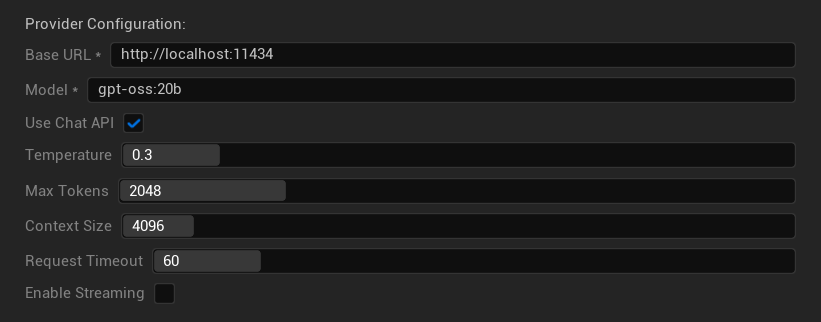

Opciones de Configuración

- URL Base: Servidor local de Ollama (por defecto:

http://localhost:11434) - Modelo: Nombre del modelo instalado localmente (requerido)

- Usar Chat API: Activar para un mejor manejo de conversaciones

- Temperatura: 0.0-2.0 (0.3 recomendado)

- Tokens Máximos: 1-8,192 tokens

- Tamaño de Contexto: 512-32,768 tokens

- Tiempo de Espera de Solicitud: 10-300 segundos (los modelos locales pueden ser más lentos)

- Habilitar Streaming: Para el procesamiento de respuestas en tiempo real

Puntos Fuertes

- ✅ Privacidad completa (ningún dato sale de tu máquina)

- ✅ Sin costes de API ni límites de uso

- ✅ Funciona sin conexión

- ✅ Control total sobre los parámetros del modelo

- ✅ Amplia variedad de modelos de la comunidad

- ✅ Sin dependencia de un proveedor

Consideraciones

- 💻 Requiere configuración local y hardware capaz

- ⚡ Generalmente más lento que los proveedores en la nube

- 🔧 Se requiere una configuración más técnica

- 📊 La calidad de la traducción varía significativamente según el modelo (algunos pueden superar a los proveedores en la nube)

- 💾 Grandes requisitos de almacenamiento para los modelos

Configuración de Ollama

- Instalar Ollama: Descarga desde ollama.ai e instala en tu sistema

- Descargar Modelos: Usa

ollama pull llama3.2para descargar el modelo elegido - Iniciar Servidor: Ollama se ejecuta automáticamente, o inicia con

ollama serve - Configurar Plugin: Establece la URL base y el nombre del modelo en la configuración del plugin

- Probar Conexión: El plugin verificará la conectividad cuando apliques la configuración

OpenAI

Ideal para: La más alta calidad general de traducción, amplia selección de modelos

OpenAI proporciona modelos de lenguaje líderes en la industria a través de su API, incluyendo los últimos modelos GPT y el nuevo formato Responses API.

Modelos Disponibles

- gpt-5 (Último modelo insignia)

- gpt-5-mini (Variante más pequeña y rápida)

- gpt-4.1 y gpt-4.1-mini

- gpt-4o y gpt-4o-mini (Modelos optimizados)

- o3 y o3-mini (Razonamiento avanzado)

- o1 y o1-mini (Generación anterior)

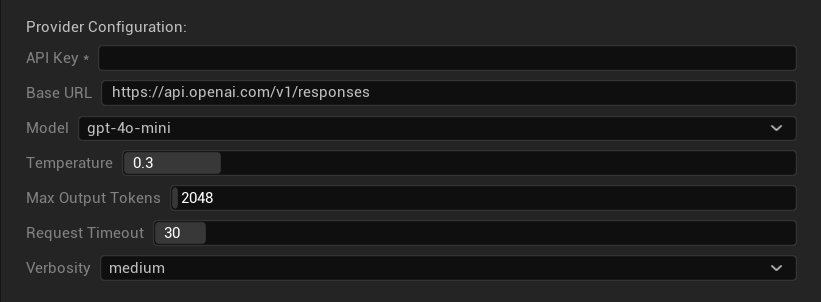

Opciones de Configuración

- Clave API: Tu clave API de OpenAI (requerida)

- URL Base: Punto final de la API (por defecto: servidores de OpenAI)

- Modelo: Elige entre los modelos GPT disponibles

- Temperatura: 0.0-2.0 (0.3 recomendado para consistencia en traducción)

- Tokens Máximos de Salida: 1-128,000 tokens

- Tiempo de Espera de Solicitud: 5-300 segundos

- Verbosidad: Controla el nivel de detalle de la respuesta

Fortalezas

- ✅ Traducciones de alta calidad consistentes

- ✅ Excelente comprensión del contexto

- ✅ Fuerte preservación del formato

- ✅ Amplio soporte de idiomas

- ✅ Tiempo de actividad de la API confiable

Consideraciones

- 💰 Costo más alto por solicitud

- 🌐 Requiere conexión a internet

- ⏱️ Límites de uso basados en el nivel

Anthropic Claude

Mejor para: Traducciones matizadas, contenido creativo, aplicaciones centradas en la seguridad

Los modelos de Claude sobresalen en la comprensión del contexto y los matices, lo que los hace ideales para juegos con mucha narrativa y escenarios de localización complejos.

Modelos Disponibles

- claude-opus-4-1-20250805 (Último modelo insignia)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Rápido y eficiente)

- claude-3-haiku-20240307

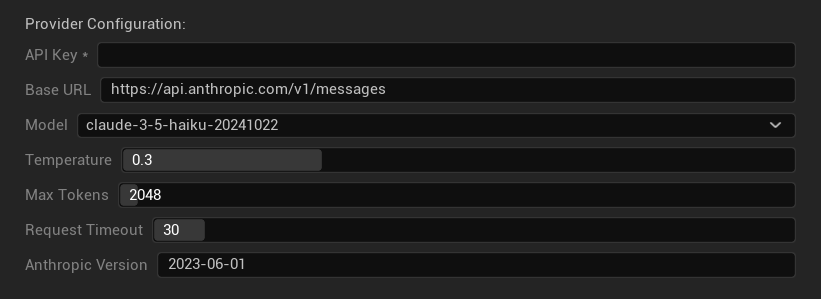

Opciones de Configuración

- Clave API: Tu clave API de Anthropic (requerida)

- URL Base: Punto final de la API de Claude

- Modelo: Selecciona de la familia de modelos Claude

- Temperatura: 0.0-1.0 (0.3 recomendado)

- Tokens Máximos: 1-64,000 tokens

- Tiempo de Espera de Solicitud: 5-300 segundos

- Versión de Anthropic: Encabezado de versión de la API

Fortalezas

- ✅ Conciencia contextual excepcional

- ✅ Excelente para contenido creativo/narrativo

- ✅ Fuertes características de seguridad

- ✅ Capacidades de razonamiento detalladas

- ✅ Seguimiento excelente de instrucciones

Consideraciones

- 💰 Modelo de precios premium

- 🌐 Se requiere conexión a internet

- 📏 Los límites de tokens varían según el modelo

DeepSeek

Mejor para: Traducción rentable, alto rendimiento, proyectos con presupuesto limitado

DeepSeek ofrece una calidad de traducción competitiva a una fracción del costo de otros proveedores, lo que lo hace ideal para proyectos de localización a gran escala.

Modelos Disponibles

- deepseek-chat (Propósito general, recomendado)

- deepseek-reasoner (Capacidades de razonamiento mejoradas)

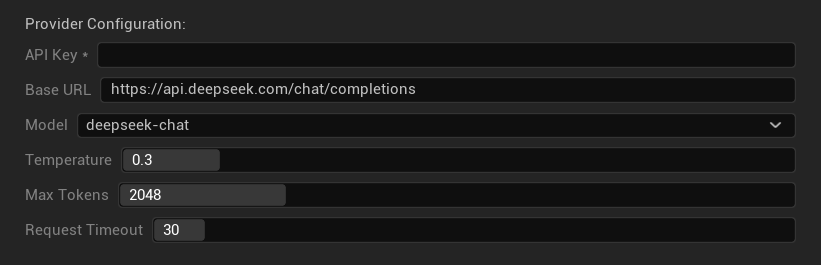

Opciones de Configuración

- Clave API: Tu clave API de DeepSeek (requerida)

- URL Base: Punto final de la API de DeepSeek

- Modelo: Elige entre los modelos chat y reasoner

- Temperatura: 0.0-2.0 (0.3 recomendado)

- Tokens Máximos: 1-8,192 tokens

- Tiempo de Espera de Solicitud: 5-300 segundos

Fortalezas

- ✅ Muy rentable

- ✅ Buena calidad de traducción

- ✅ Tiempos de respuesta rápidos

- ✅ Configuración simple

- ✅ Límites de tasa altos

Consideraciones

- 📏 Límites de tokens más bajos

- 🆕 Proveedor más nuevo (menos historial)

- 🌐 Requiere conexión a internet

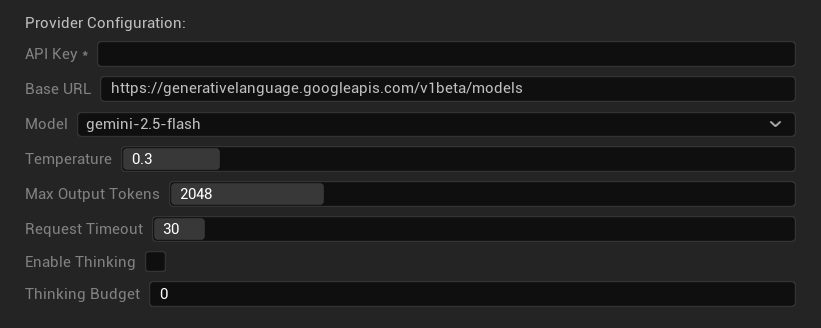

Google Gemini

Mejor para: Proyectos multilingües, traducción rentable, integración con el ecosistema de Google

Los modelos Gemini ofrecen sólidas capacidades multilingües con precios competitivos y características únicas como el modo de pensamiento para un razonamiento mejorado.

Modelos Disponibles

- gemini-2.5-pro (Último modelo insignia con pensamiento)

- gemini-2.5-flash (Rápido, con soporte de pensamiento)

- gemini-2.5-flash-lite (Variante ligera)

- gemini-2.0-flash y gemini-2.0-flash-lite

- gemini-1.5-pro y gemini-1.5-flash

Opciones de Configuración

- Clave API: Tu clave de API de Google AI (requerida)

- URL Base: Punto final de la API de Gemini

- Modelo: Selecciona de la familia de modelos Gemini

- Temperatura: 0.0-2.0 (0.3 recomendado)

- Tokens Máximos de Salida: 1-8,192 tokens

- Tiempo de Espera de Solicitud: 5-300 segundos

- Habilitar Pensamiento: Activa el razonamiento mejorado para modelos 2.5

- Presupuesto de Pensamiento: Controla la asignación de tokens de pensamiento

Fortalezas

- ✅ Fuerte soporte multilingüe

- ✅ Precios competitivos

- ✅ Razonamiento avanzado (modo de pensamiento)

- ✅ Integración con el ecosistema de Google

- ✅ Actualizaciones regulares de modelos

Consideraciones

- 🧠 El modo de pensamiento aumenta el uso de tokens

- 📏 Límites de tokens variables según el modelo

- 🌐 Se requiere conexión a internet

Elegir el Proveedor Correcto

| Proveedor | Mejor Para | Calidad | Costo | Configuración | Privacidad |

|---|---|---|---|---|---|

| Ollama | Privacidad/sin conexión | Variable* | Gratis | Avanzada | Local |

| OpenAI | Máxima calidad | ⭐⭐⭐⭐⭐ | 💰💰💰 | Fácil | Nube |

| Claude | Contenido creativo | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Fácil | Nube |

| DeepSeek | Proyectos con presupuesto | ⭐⭐⭐⭐ | 💰 | Fácil | Nube |

| Gemini | Multilingüe | ⭐⭐⭐⭐ | 💰 | Fácil | Nube |

*La calidad para Ollama varía significativamente según el modelo local utilizado; algunos modelos locales modernos pueden igualar o superar a los proveedores en la nube.

Consejos de Configuración del Proveedor

Para Todos los Proveedores en la Nube:

- Almacena las claves API de forma segura y no las incluyas en el control de versiones

- Comienza con ajustes de temperatura conservadores (0.3) para traducciones consistentes

- Monitorea tu uso de API y costos

- Prueba con lotes pequeños antes de ejecuciones de traducción grandes

Para Ollama:

- Asegura RAM adecuada (se recomiendan 8GB+ para modelos más grandes)

- Utiliza almacenamiento SSD para un mejor rendimiento de carga de modelos

- Considera la aceleración por GPU para una inferencia más rápida

- Prueba localmente antes de confiar en él para traducciones de producción