Guía de Configuración

Esta guía te lleva a través del proceso de configuración básica para Runtime MetaHuman Lip Sync con tus personajes MetaHuman.

Nota: Runtime MetaHuman Lip Sync funciona tanto con MetaHuman como con personajes personalizados. Para instrucciones detalladas sobre cómo configurar personajes personalizados, consulta la Guía de Configuración para Personajes Personalizados.

Prerrequisitos

Antes de comenzar, asegúrate de:

-

Requisitos del Plugin MetaHuman:

- UE 5.5 y anteriores: Habilita el plugin MetaHuman en tu proyecto

- UE 5.6 y posteriores: Habilita el plugin MetaHuman Core Tech en tu proyecto

Plugins Adicionales de MetaHumanDependiendo de cómo crees tus personajes MetaHuman, es posible que necesites plugins adicionales. Por ejemplo, si tienes la intención de crear un MetaHuman con el nuevo sistema MetaHuman Creator introducido en UE 5.6, también necesitarás habilitar el plugin MetaHuman Creator. Para obtener más información sobre este sistema, consulta la documentación de MetaHuman Creator.

-

Tienes al menos un personaje MetaHuman descargado y disponible en tu proyecto

-

El plugin Runtime MetaHuman Lip Sync está instalado

Plugin de Extensión del Modelo Estándar

Si planeas usar el Modelo Estándar, necesitarás instalar el plugin de extensión:

- Descarga el Standard Lip Sync Extension plugin desde Google Drive

- Extrae la carpeta del archivo descargado en la carpeta

Pluginsde tu proyecto (crea esta carpeta si no existe) - Asegúrate de que tu proyecto esté configurado como un proyecto C++ (incluso si no tienes ningún código C++)

- Reconstruye tu proyecto

- Esta extensión es solo necesaria si quieres usar el Modelo Estándar. Si solo necesitas los Modelos Realistas, puedes omitir este paso.

- Para obtener más información sobre cómo construir plugins manualmente, consulta el tutorial Building Plugins

Plugins Adicionales

- Si planeas usar captura de audio (por ejemplo, entrada de micrófono), instala el plugin Runtime Audio Importer.

- Si planeas usar la funcionalidad de texto a voz:

- Para TTS local (Modelo Estándar y Modelo Realista con Estados de Ánimo), instala el plugin Runtime Text To Speech.

- Para proveedores de TTS externos (ElevenLabs, OpenAI, Google Cloud, Azure), instala el plugin Runtime AI Chatbot Integrator.

Configuración del Animation Blueprint

Paso 1: Localizar y modificar el Blueprint de animación facial

- UE 5.5 y anteriores (o MetaHumans heredados en UE 5.6+)

- Personajes de MetaHuman Creator en UE 5.6+

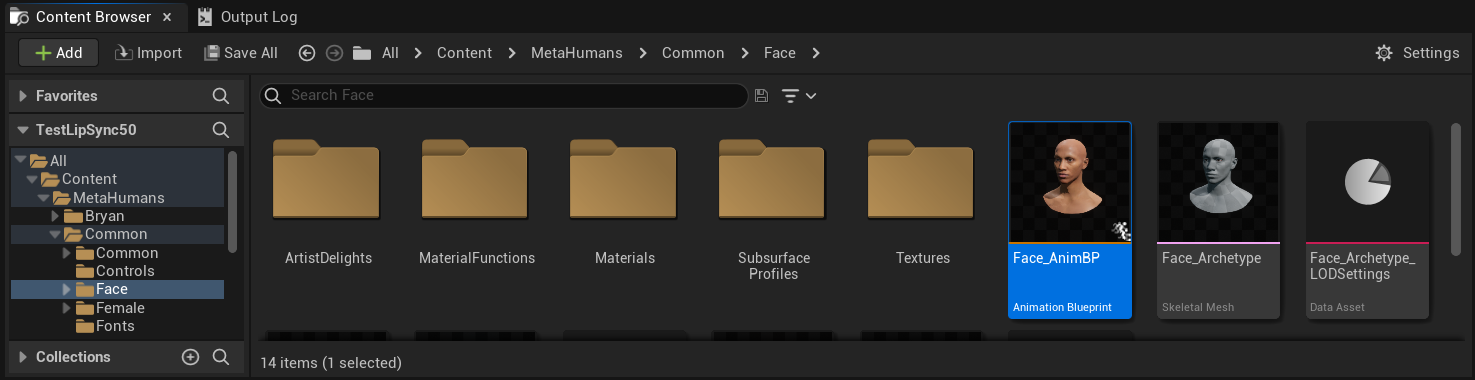

Necesitas modificar un Animation Blueprint que se utilizará para las animaciones faciales de tu personaje MetaHuman. El Animation Blueprint facial predeterminado de MetaHuman se encuentra en:

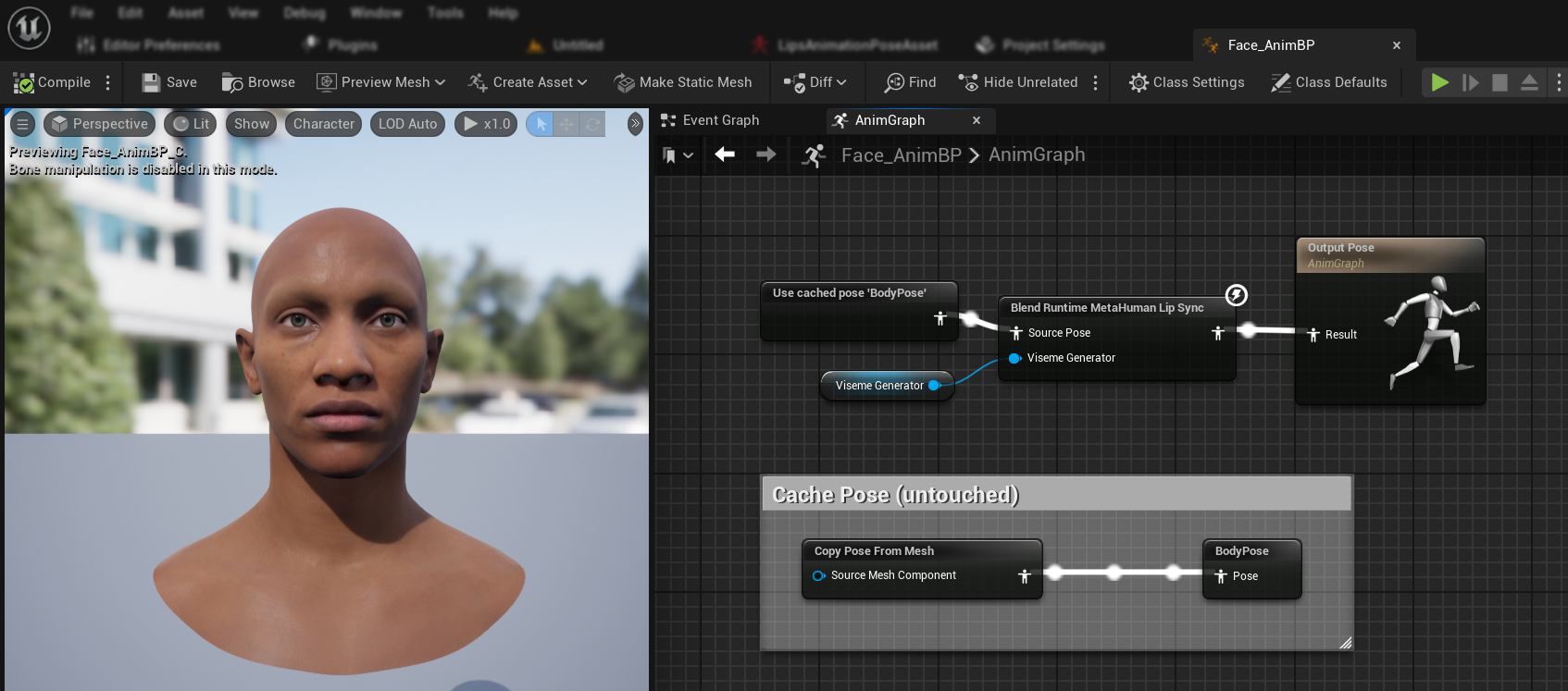

Content/MetaHumans/Common/Face/Face_AnimBP

Tienes varias opciones para implementar la funcionalidad de sincronización labial:

- Editar Activo Predeterminado (Opción Más Simple)

- Crear Duplicado

- Usar Animation Blueprint Personalizado

Abre directamente el Face_AnimBP predeterminado y realiza tus modificaciones. Cualquier cambio afectará a todos los personajes MetaHuman que utilicen este Animation Blueprint.

Nota: Este enfoque es conveniente pero afectará a todos los personajes que utilicen el Animation Blueprint predeterminado.

- Duplica

Face_AnimBPy asígnale un nombre descriptivo - Localiza la clase Blueprint de tu personaje (por ejemplo, para el personaje "Bryan", estaría en

Content/MetaHumans/Bryan/BP_Bryan) - Abre el Blueprint del personaje y encuentra el componente Face

- Cambia la propiedad Anim Class a tu Animation Blueprint recién duplicado

Nota: Este enfoque te permite personalizar la sincronización labial para personajes específicos mientras dejas a otros sin cambios.

Puedes implementar la mezcla de sincronización labial en cualquier Animation Blueprint que tenga acceso a los huesos faciales requeridos:

- Crea o utiliza un Animation Blueprint personalizado existente

- Asegúrate de que tu Animation Blueprint funcione con un esqueleto que contenga los mismos huesos faciales que el

Face_Archetype_Skeletonpredeterminado de MetaHuman

Nota: Este enfoque te brinda la máxima flexibilidad para la integración con sistemas de animación personalizados.

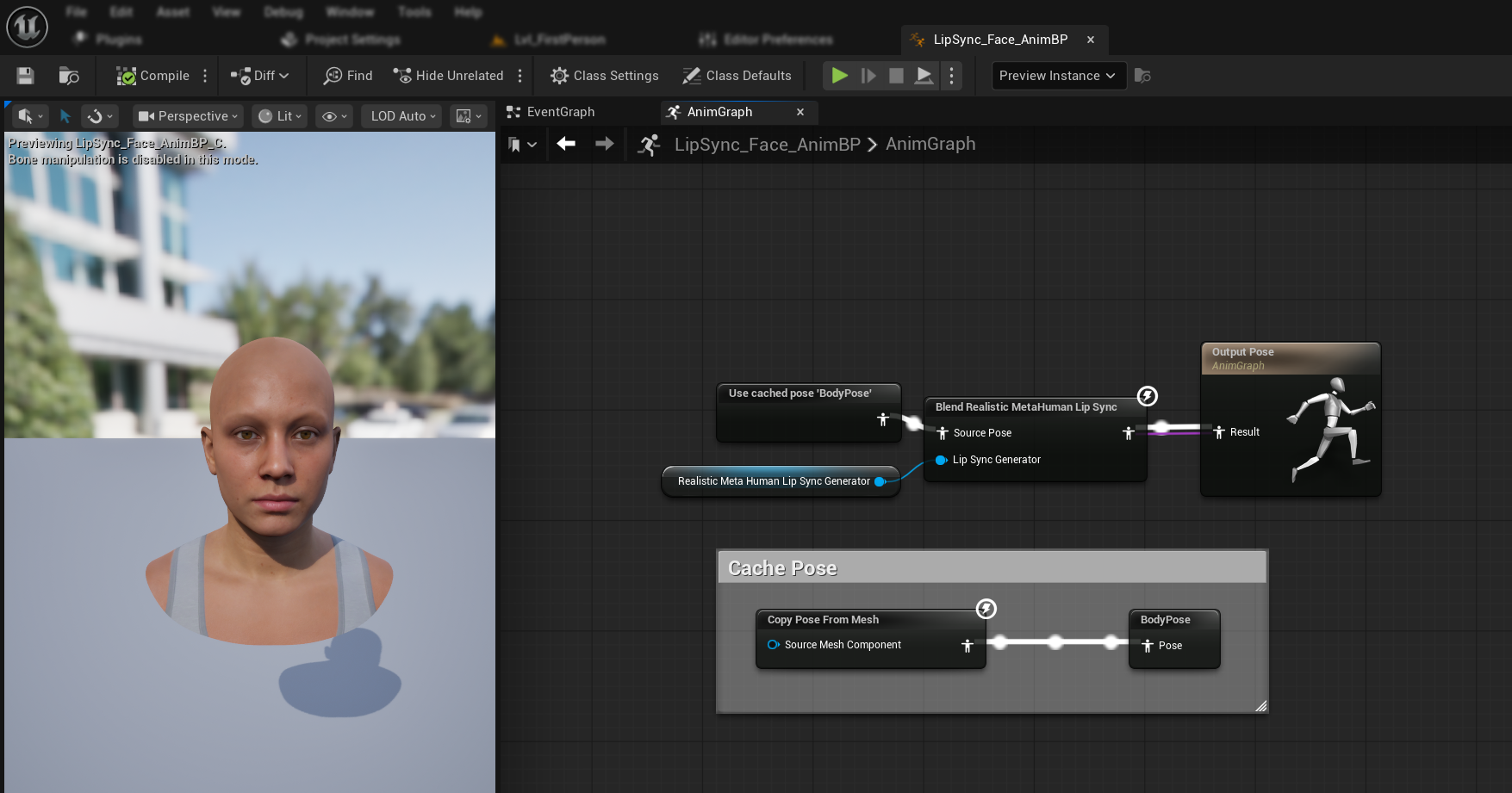

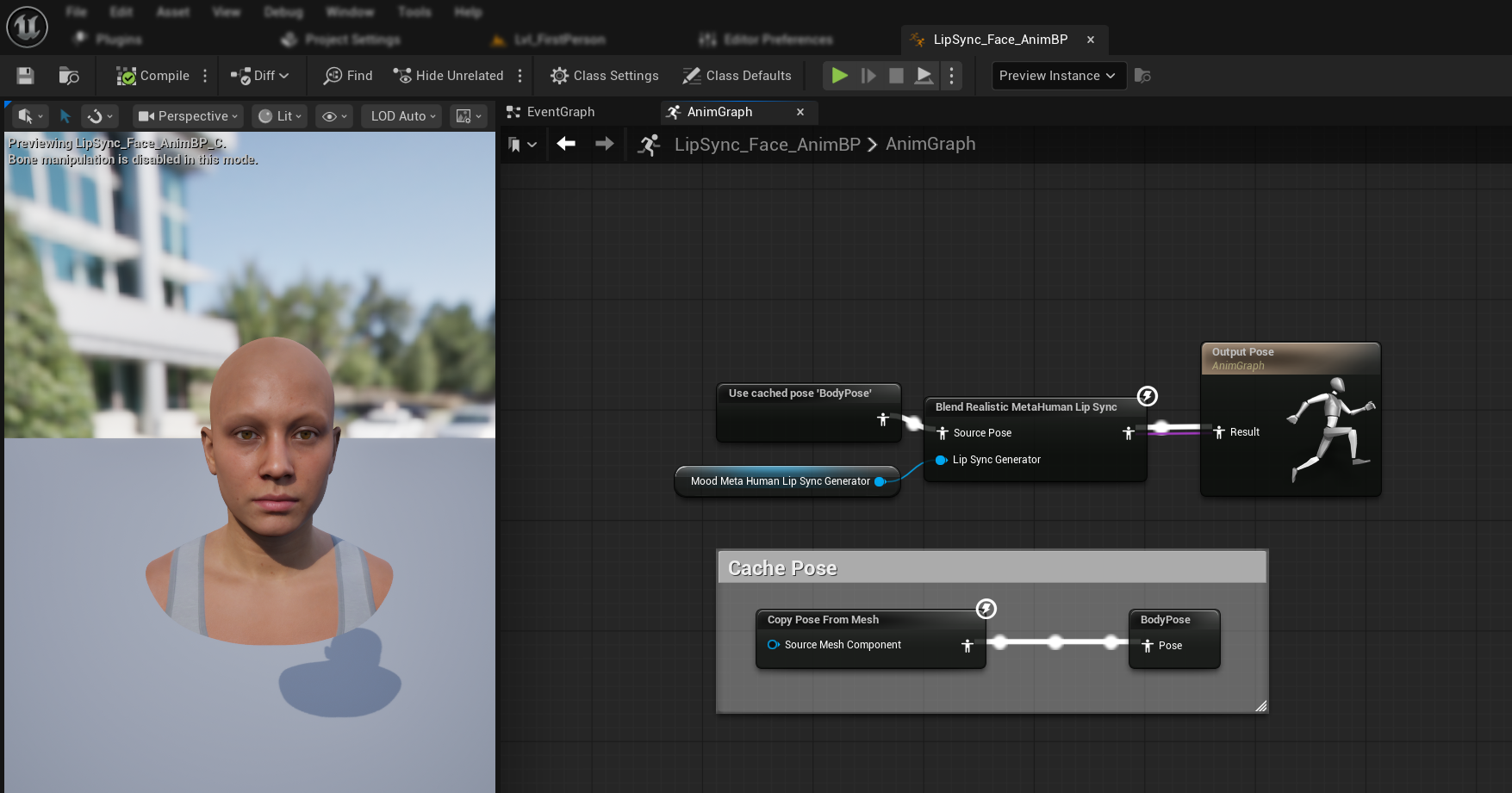

A partir de UE 5.6, se introdujo el nuevo sistema MetaHuman Creator. Para estos personajes, el plugin proporciona un Animation Blueprint facial ubicado en:

Content/LipSyncData/LipSync_Face_AnimBP

Este Animation Blueprint se encuentra en la carpeta de contenido del plugin y se sobrescribirá con cada actualización del plugin. Para evitar perder sus personalizaciones:

- Copie este activo a la carpeta Content de su proyecto (por ejemplo, a

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - Utilice su versión copiada en la configuración de su personaje

- Realice todas sus modificaciones en la versión copiada

Usando el Face Animation Blueprint del Plugin:

- Localice la clase Blueprint de su personaje de MetaHuman Creator

- Abra el Blueprint del personaje y encuentre el componente Face

- Cambie la propiedad Anim Class al

LipSync_Face_AnimBPdel plugin - Continúe con los siguientes pasos para configurar la funcionalidad Runtime MetaHuman Lip Sync

Paso 2: Configuración del Event Graph

Abra su Face Animation Blueprint y cambie al Event Graph. Necesitará crear un generador que procesará datos de audio y generará animación de sincronización labial.

- Modelo Estándar

- Modelo Realista

- Modelo Realista con Estado de Ánimo

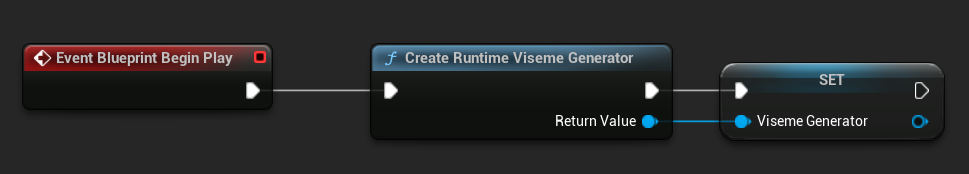

- Agregue el nodo

Event Blueprint Begin Playsi no existe ya - Agregue el nodo

Create Runtime Viseme Generatory conéctelo al evento Begin Play - Guarde la salida como una variable (por ejemplo, "VisemeGenerator") para usar en otras partes del gráfico

Para opciones de configuración detalladas, consulte la sección Configuración del Modelo Estándar.

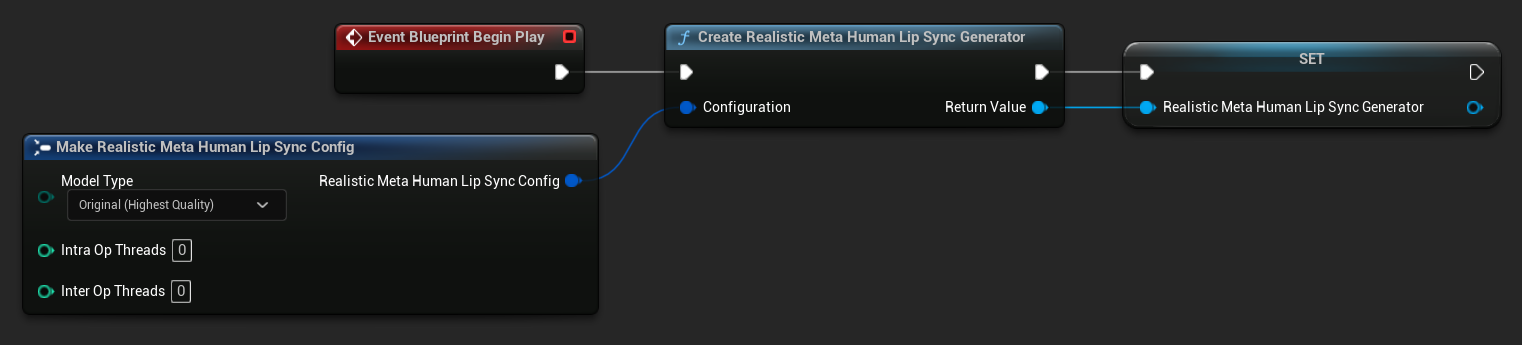

- Agregue el nodo

Event Blueprint Begin Playsi no existe ya - Agregue el nodo

Create Realistic MetaHuman Lip Sync Generatory conéctelo al evento Begin Play - Guarde la salida como una variable (por ejemplo, "RealisticMetaHumanLipSyncGenerator") para usar en otras partes del gráfico

- (Opcional) Configure los ajustes del generador usando el parámetro Configuration

Para opciones de configuración detalladas incluyendo tipos de modelo, ajustes de rendimiento y parámetros de procesamiento, consulte la sección Configuración del Modelo Realista.

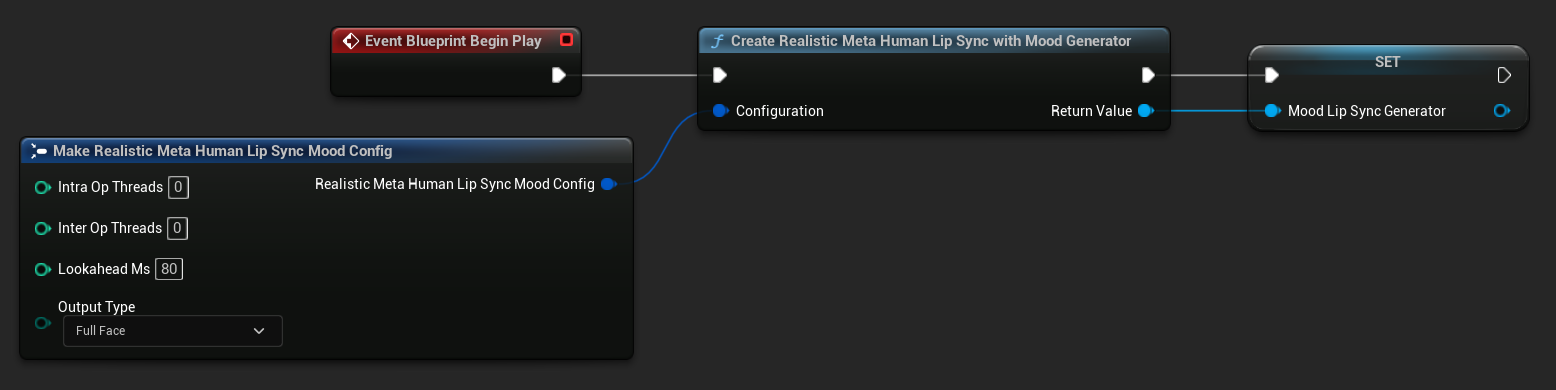

- Agregue el nodo

Event Blueprint Begin Playsi no existe ya - Agregue el nodo

Create Realistic MetaHuman Lip Sync With Mood Generatory conéctelo al evento Begin Play - Guarde la salida como una variable (por ejemplo, "MoodMetaHumanLipSyncGenerator") para usar en otras partes del gráfico

- (Opcional) Configure los ajustes del generador usando el parámetro Configuration

Para configuración detallada del estado de ánimo incluyendo tipos de estado de ánimo, configuraciones de intensidad, temporización de anticipación y selección de tipo de salida, consulta la sección Configuración del Modelo Habilitado para Estados de Ánimo.

Paso 3: Configuración del Gráfico de Animación

Después de configurar el Gráfico de Eventos, cambia al Anim Graph para conectar el generador a la animación del personaje:

- Modelo Estándar

- Modelo Realista

- Modelo Realista Habilitado para Estados de Ánimo

- Localiza la pose que contiene la cara del MetaHuman (normalmente desde

Use cached pose 'Body Pose') - Añade el nodo

Blend Runtime MetaHuman Lip Sync - Conecta la pose al

Source Posedel nodoBlend Runtime MetaHuman Lip Sync - Conecta tu variable

VisemeGeneratoral pinViseme Generator - Conecta la salida del nodo

Blend Runtime MetaHuman Lip Syncal pinResultde laOutput Pose

- Localiza la pose que contiene la cara del MetaHuman (normalmente desde

Use cached pose 'Body Pose') - Añade el nodo

Blend Realistic MetaHuman Lip Sync - Conecta la pose al

Source Posedel nodoBlend Realistic MetaHuman Lip Sync - Conecta tu variable

RealisticMetaHumanLipSyncGeneratoral pinLip Sync Generator - Conecta la salida del nodo

Blend Realistic MetaHuman Lip Syncal pinResultde laOutput Pose

- Localiza la pose que contiene la cara del MetaHuman (normalmente desde

Use cached pose 'Body Pose') - Añade el nodo

Blend Realistic MetaHuman Lip Sync(el mismo nodo que el modelo realista regular) - Conecta la pose al

Source Posedel nodoBlend Realistic MetaHuman Lip Sync - Conecta tu variable

MoodMetaHumanLipSyncGeneratoral pinLip Sync Generator - Conecta la salida del nodo

Blend Realistic MetaHuman Lip Syncal pinResultde laOutput Pose

Nota: El modelo habilitado para estados de ánimo utiliza el mismo nodo de Animation Blueprint que el modelo realista regular. La funcionalidad de estado de ánimo se maneja internamente por el generador.

Próximos Pasos

Ahora que tienes la configuración básica del Animation Blueprint completa, necesitarás configurar el procesamiento de entrada de audio para alimentar datos de audio a tu generador de sincronización de labios.

Continúa con la Guía de Procesamiento de Audio para aprender cómo configurar diferentes métodos de entrada de audio, incluyendo captura de micrófono, texto a voz y procesamiento de archivos de audio. Para opciones de configuración avanzadas y ajustes finos, consulta la Guía de Configuración.