Fournisseurs de Traduction

L'AI Localization Automator prend en charge cinq fournisseurs d'IA différents, chacun avec des forces et des options de configuration uniques. Choisissez le fournisseur qui correspond le mieux aux besoins, au budget et aux exigences de qualité de votre projet.

Ollama (IA Locale)

Idéal pour : Projets sensibles à la confidentialité, traduction hors ligne, utilisation illimitée

Ollama exécute des modèles d'IA localement sur votre machine, offrant une confidentialité et un contrôle complets sans coûts d'API ni exigences internet.

Modèles Populaires

- llama3.2 (Usage général recommandé)

- mistral (Alternative efficace)

- codellama (Traductions conscientes du code)

- Et bien d'autres modèles communautaires

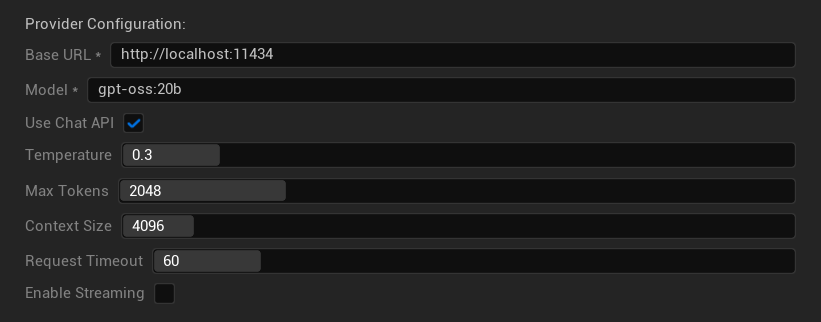

Options de Configuration

- URL de base : Serveur Ollama local (par défaut :

http://localhost:11434) - Modèle : Nom du modèle installé localement (requis)

- Utiliser l'API Chat : Activer pour une meilleure gestion des conversations

- Température : 0.0-2.0 (0.3 recommandé)

- Tokens Maximum : 1-8 192 tokens

- Taille du Contexte : 512-32 768 tokens

- Délai d'Expiration de la Requête : 10-300 secondes (les modèles locaux peuvent être plus lents)

- Activer le Streaming : Pour un traitement des réponses en temps réel

Forces

- ✅ Confidentialité totale (aucune donnée ne quitte votre machine)

- ✅ Aucun coût d'API ou limite d'utilisation

- ✅ Fonctionne hors ligne

- ✅ Contrôle total des paramètres du modèle

- ✅ Grande variété de modèles communautaires

- ✅ Aucun verrouillage fournisseur

Considérations

- 💻 Nécessite une configuration locale et un matériel capable

- ⚡ Généralement plus lent que les fournisseurs cloud

- 🔧 Configuration plus technique requise

- 📊 La qualité de traduction varie considérablement selon le modèle (certains peuvent dépasser les fournisseurs cloud)

- 💾 Besoins de stockage importants pour les modèles

Configuration d'Ollama

- Installer Ollama : Téléchargez depuis ollama.ai et installez sur votre système

- Télécharger les Modèles : Utilisez

ollama pull llama3.2pour télécharger le modèle de votre choix - Démarrer le Serveur : Ollama s'exécute automatiquement, ou démarrez avec

ollama serve - Configurer le Plugin : Définissez l'URL de base et le nom du modèle dans les paramètres du plugin

- Tester la Connexion : Le plugin vérifiera la connectivité lorsque vous appliquerez la configuration

OpenAI

Idéal pour : La plus haute qualité de traduction globale, vaste sélection de modèles

OpenAI fournit des modèles de langage de premier plan via leur API, y compris les derniers modèles GPT et le nouveau format d'API Responses.

Modèles Disponibles

- gpt-5 (Dernier modèle phare)

- gpt-5-mini (Variante plus petite et plus rapide)

- gpt-4.1 et gpt-4.1-mini

- gpt-4o et gpt-4o-mini (Modèles optimisés)

- o3 et o3-mini (Raisonnement avancé)

- o1 et o1-mini (Génération précédente)

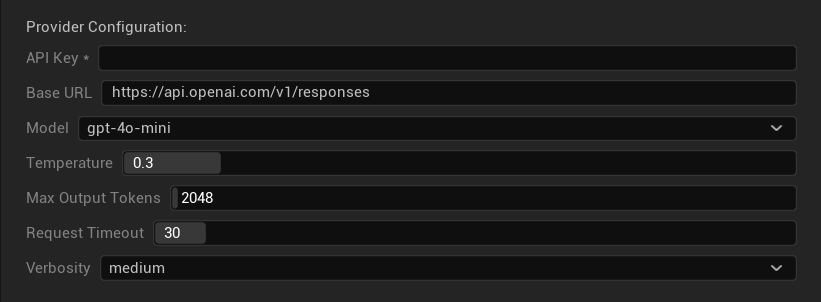

Options de Configuration

- Clé API : Votre clé API OpenAI (requise)

- URL de Base : Point de terminaison de l'API (par défaut : les serveurs d'OpenAI)

- Modèle : Choisissez parmi les modèles GPT disponibles

- Température : 0.0-2.0 (0.3 recommandé pour la cohérence de la traduction)

- Jetons de Sortie Max : 1-128 000 jetons

- Délai d'Expiration de la Requête : 5-300 secondes

- Verbosité : Contrôle le niveau de détail de la réponse

Points Forts

- ✅ Traductions de qualité constamment élevée

- ✅ Excellente compréhension du contexte

- ✅ Forte préservation du format

- ✅ Large support linguistique

- ✅ Disponibilité de l'API fiable

Considérations

- 💰 Coût plus élevé par requête

- 🌐 Nécessite une connexion internet

- ⏱️ Limites d'utilisation basées sur le forfait

Anthropic Claude

Idéal pour : Traductions nuancées, contenu créatif, applications axées sur la sécurité

Les modèles Claude excellent dans la compréhension du contexte et de la nuance, ce qui les rend idéaux pour les jeux riches en narration et les scénarios de localisation complexes.

Modèles Disponibles

- claude-opus-4-1-20250805 (Dernier modèle phare)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Rapide et efficace)

- claude-3-haiku-20240307

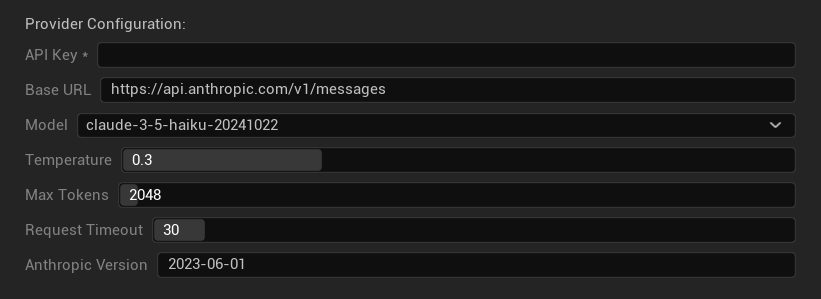

Options de Configuration

- Clé API : Votre clé API Anthropic (requise)

- URL de Base : Point de terminaison de l'API Claude

- Modèle : Sélectionnez dans la famille de modèles Claude

- Température : 0.0-1.0 (0.3 recommandé)

- Jetons Max : 1-64 000 jetons

- Délai d'Expiration de la Requête : 5-300 secondes

- Version Anthropic : En-tête de version de l'API

Points Forts

- ✅ Conscience contextuelle exceptionnelle

- ✅ Excellent pour le contenu créatif/narratif

- ✅ Fonctionnalités de sécurité solides

- ✅ Capacités de raisonnement détaillées

- ✅ Excellente capacité à suivre les instructions

Considérations

- 💰 Modèle de tarification premium

- 🌐 Connexion internet requise

- 📏 Les limites de jetons varient selon le modèle

DeepSeek

Idéal pour : Traduction rentable, débit élevé, projets soucieux du budget

DeepSeek offre une qualité de traduction compétitive à une fraction du coût des autres fournisseurs, ce qui le rend idéal pour les projets de localisation à grande échelle.

Modèles Disponibles

- deepseek-chat (Usage général, recommandé)

- deepseek-reasoner (Capacités de raisonnement améliorées)

Options de Configuration

- Clé API : Votre clé API DeepSeek (requise)

- URL de Base : Point de terminaison de l'API DeepSeek

- Modèle : Choisissez entre les modèles chat et reasoner

- Température : 0.0-2.0 (0.3 recommandé)

- Jetons Max : 1-8 192 jetons

- Délai d'Expiration de la Requête : 5-300 secondes

Points Forts

- ✅ Très rentable

- ✅ Bonne qualité de traduction

- ✅ Temps de réponse rapides

- ✅ Configuration simple

- ✅ Limites de débit élevées

Considérations

- 📏 Limites de tokens plus basses

- 🆕 Fournisseur plus récent (moins d'historique)

- 🌐 Nécessite une connexion internet

Google Gemini

Idéal pour : Projets multilingues, traduction rentable, intégration à l'écosystème Google

Les modèles Gemini offrent de solides capacités multilingues avec une tarification compétitive et des fonctionnalités uniques comme le mode de réflexion pour un raisonnement amélioré.

Modèles disponibles

- gemini-2.5-pro (Dernier modèle phare avec réflexion)

- gemini-2.5-flash (Rapide, avec support de la réflexion)

- gemini-2.5-flash-lite (Variante légère)

- gemini-2.0-flash et gemini-2.0-flash-lite

- gemini-1.5-pro et gemini-1.5-flash

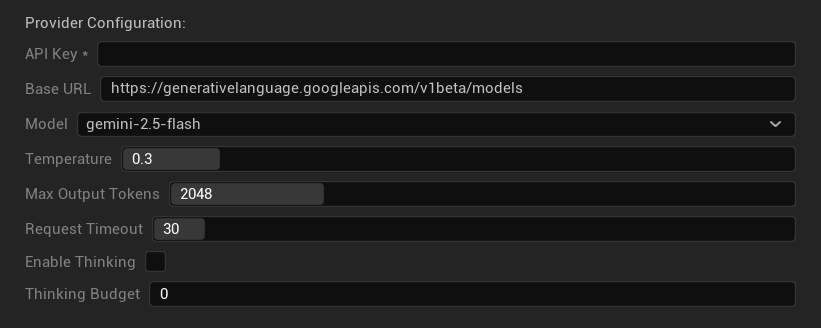

Options de configuration

- Clé API : Votre clé API Google AI (requise)

- URL de base : Point de terminaison de l'API Gemini

- Modèle : Sélectionnez dans la famille de modèles Gemini

- Température : 0.0-2.0 (0.3 recommandé)

- Tokens de sortie max : 1-8 192 tokens

- Délai d'expiration de la requête : 5-300 secondes

- Activer la réflexion : Active le raisonnement amélioré pour les modèles 2.5

- Budget de réflexion : Contrôle l'allocation des tokens de réflexion

Points forts

- ✅ Solide support multilingue

- ✅ Tarification compétitive

- ✅ Raisonnement avancé (mode réflexion)

- ✅ Intégration à l'écosystème Google

- ✅ Mises à jour régulières des modèles

Considérations

- 🧠 Le mode réflexion augmente l'utilisation des tokens

- 📏 Limites de tokens variables selon le modèle

- 🌐 Connexion internet requise

Choisir le bon fournisseur

| Fournisseur | Idéal pour | Qualité | Coût | Configuration | Confidentialité |

|---|---|---|---|---|---|

| Ollama | Confidentialité/hors ligne | Variable* | Gratuit | Avancée | Local |

| OpenAI | Qualité la plus élevée | ⭐⭐⭐⭐⭐ | 💰💰💰 | Facile | Cloud |

| Claude | Contenu créatif | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Facile | Cloud |

| DeepSeek | Projets à budget limité | ⭐⭐⭐⭐ | 💰 | Facile | Cloud |

| Gemini | Multilingue | ⭐⭐⭐⭐ | 💰 | Facile | Cloud |

*La qualité pour Ollama varie considérablement selon le modèle local utilisé - certains modèles locaux modernes peuvent égaler ou dépasser les fournisseurs cloud.

Conseils de configuration des fournisseurs

Pour tous les fournisseurs cloud :

- Stockez les clés API de manière sécurisée et ne les committez pas dans le contrôle de version

- Commencez avec des réglages de température conservateurs (0.3) pour des traductions cohérentes

- Surveillez votre utilisation de l'API et les coûts

- Testez avec de petits lots avant de grands lots de traduction

Pour Ollama :

- Assurez une RAM adéquate (8 Go+ recommandés pour les modèles plus grands)

- Utilisez un stockage SSD pour de meilleures performances de chargement des modèles

- Envisagez l'accélération GPU pour une inférence plus rapide

- Testez localement avant de s'y fier pour des traductions en production