Configuration du Plugin

Configuration du Modèle

Configuration Standard du Modèle

Le nœud Create Runtime Viseme Generator utilise des paramètres par défaut qui fonctionnent bien pour la plupart des scénarios. La configuration est gérée via les propriétés du nœud de mélange dans l'Animation Blueprint.

Pour les options de configuration de l'Animation Blueprint, consultez la section Configuration de la Synchronisation Labiale ci-dessous.

Configuration du Modèle Réaliste

Le nœud Create Realistic MetaHuman Lip Sync Generator accepte un paramètre Configuration facultatif qui vous permet de personnaliser le comportement du générateur :

Type de Modèle

Le paramètre Model Type détermine quelle version du modèle réaliste utiliser :

| Type de Modèle | Performance | Qualité Visuelle | Gestion du Bruit | Cas d'Utilisation Recommandés |

|---|---|---|---|---|

| Highly Optimized (Par défaut) | Performance la plus élevée, utilisation CPU la plus faible | Bonne qualité | Peut montrer des mouvements de bouche notables avec du bruit de fond ou des sons non vocaux | Environnements audio propres, scénarios critiques pour la performance |

| Semi-Optimized | Bonne performance, utilisation CPU modérée | Haute qualité | Meilleure stabilité avec l'audio bruité | Équilibre performance/qualité, conditions audio mixtes |

| Original | Adapté à une utilisation en temps réel sur les CPU modernes | Qualité la plus élevée | Plus stable avec le bruit de fond et les sons non vocaux | Productions de haute qualité, environnements audio bruyants, lorsque la précision maximale est nécessaire |

Paramètres de Performance

Intra Op Threads : Contrôle le nombre de threads utilisés pour les opérations de traitement interne du modèle.

- 0 (Par défaut/Automatique) : Utilise la détection automatique (typiquement 1/4 des cœurs CPU disponibles, maximum 4)

- 1-16 : Spécifiez manuellement le nombre de threads. Des valeurs plus élevées peuvent améliorer les performances sur les systèmes multi-cœurs mais utilisent plus de CPU

Inter Op Threads : Contrôle le nombre de threads utilisés pour l'exécution parallèle de différentes opérations du modèle.

- 0 (Par défaut/Automatique) : Utilise la détection automatique (typiquement 1/8 des cœurs CPU disponibles, maximum 2)

- 1-8 : Spécifiez manuellement le nombre de threads. Généralement gardé bas pour le traitement en temps réel

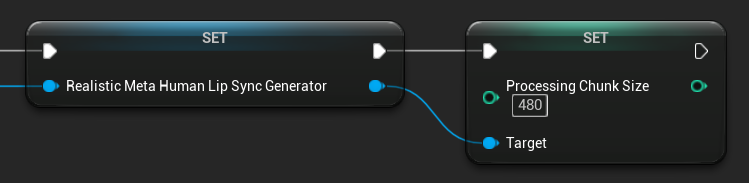

Taille des Blocs de Traitement

Le paramètre Processing Chunk Size détermine combien d'échantillons sont traités à chaque étape d'inférence. La valeur par défaut est 160 échantillons (10ms d'audio à 16kHz) :

- Des valeurs plus petites fournissent des mises à jour plus fréquentes mais augmentent l'utilisation du CPU

- Des valeurs plus grandes réduisent la charge CPU mais peuvent diminuer la réactivité de la synchronisation labiale

- Il est recommandé d'utiliser des multiples de 160 pour un alignement optimal

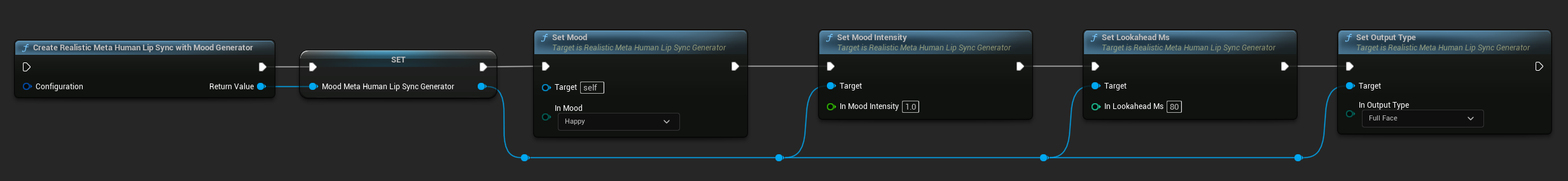

Configuration du Modèle avec Humeur

Le nœud Create Realistic MetaHuman Lip Sync With Mood Generator fournit des options de configuration supplémentaires au-delà du modèle réaliste de base :

Configuration de Base

Lookahead Ms : Délai de prévision en millisecondes pour une meilleure précision de la synchronisation labiale.

- Par défaut : 80ms

- Plage : 20ms à 200ms (doit être divisible par 20)

- Des valeurs plus élevées offrent une meilleure synchronisation mais augmentent la latence

Output Type : Contrôle quels contrôles faciaux sont générés.

- Full Face : Tous les 81 contrôles faciaux (sourcils, yeux, nez, bouche, mâchoire, langue)

- Mouth Only : Seulement les contrôles liés à la bouche, la mâchoire et la langue

Performance Settings : Utilise les mêmes paramètres Intra Op Threads et Inter Op Threads que le modèle réaliste standard.

Paramètres d'Humeur

Humeurs Disponibles :

- Neutral, Happy, Sad, Disgust, Anger, Surprise, Fear

- Confident, Excited, Bored, Playful, Confused

Mood Intensity : Contrôle la force avec laquelle l'humeur affecte l'animation (0.0 à 1.0)

Contrôle de l'Humeur en Temps Réel

Vous pouvez ajuster les paramètres d'humeur pendant l'exécution à l'aide des fonctions suivantes :

- Set Mood : Changer le type d'humeur actuel

- Set Mood Intensity : Ajuster la force avec laquelle l'humeur affecte l'animation (0.0 à 1.0)

- Set Lookahead Ms : Modifier le délai de prévision pour la synchronisation

- Set Output Type : Basculer entre les contrôles Full Face et Mouth Only

Guide de Sélection de l'Humeur

Choisissez des humeurs appropriées en fonction de votre contenu :

| Humeur | Idéal Pour | Plage d'Intensité Typique |

|---|---|---|

| Neutral | Conversation générale, narration, état par défaut | 0.5 - 1.0 |

| Happy | Contenu positif, dialogue joyeux, célébrations | 0.6 - 1.0 |

| Sad | Contenu mélancolique, scènes émotionnelles, moments sombres | 0.5 - 0.9 |

| Disgust | Réactions négatives, contenu dégoûtant, rejet | 0.4 - 0.8 |

| Anger | Dialogue agressif, scènes de confrontation, frustration | 0.6 - 1.0 |

| Surprise | Événements inattendus, révélations, réactions de choc | 0.7 - 1.0 |

| Fear | Situations menaçantes, anxiété, dialogue nerveux | 0.5 - 0.9 |

| Confident | Présentations professionnelles, dialogue de leadership, discours affirmé | 0.7 - 1.0 |

| Excited | Contenu énergique, annonces, dialogue enthousiaste | 0.8 - 1.0 |

| Bored | Contenu monotone, dialogue désintéressé, discours fatigué | 0.3 - 0.7 |

| Playful | Conversation décontractée, humour, interactions légères | 0.6 - 0.9 |

| Confused | Dialogue riche en questions, incertitude, perplexité | 0.4 - 0.8 |

Configuration de l'Animation Blueprint

Configuration de la Synchronisation Labiale

- Standard Model

- Modèles réalistes

Le nœud Blend Runtime MetaHuman Lip Sync a des options de configuration dans son panneau des propriétés :

| Propriété | Par défaut | Description |

|---|---|---|

| Interpolation Speed | 25 | Contrôle la rapidité avec laquelle les mouvements des lèvres passent d'un visème à l'autre. Des valeurs plus élevées entraînent des transitions plus rapides et plus abruptes. |

| Reset Time | 0.2 | La durée en secondes après laquelle la synchronisation labiale est réinitialisée. Ceci est utile pour empêcher la synchronisation labiale de continuer après l'arrêt de l'audio. |

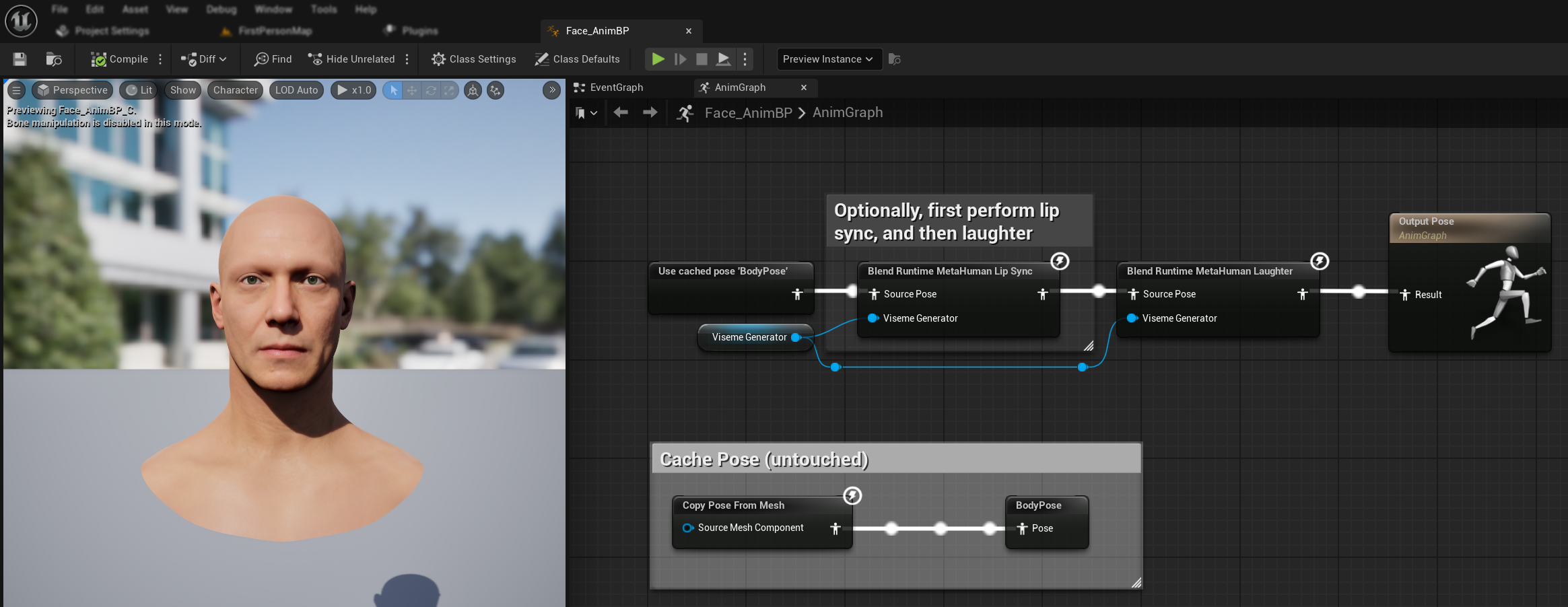

Animation du Rire

Vous pouvez également ajouter des animations de rire qui répondront dynamiquement au rire détecté dans l'audio :

- Ajoutez le nœud

Blend Runtime MetaHuman Laughter - Connectez votre variable

RuntimeVisemeGeneratorà la brocheViseme Generator - Si vous utilisez déjà la synchronisation labiale :

- Connectez la sortie du nœud

Blend Runtime MetaHuman Lip Syncà laSource Posedu nœudBlend Runtime MetaHuman Laughter - Connectez la sortie du nœud

Blend Runtime MetaHuman Laughterà la brocheResultde l'Output Pose

- Connectez la sortie du nœud

- Si vous utilisez uniquement le rire sans synchronisation labiale :

- Connectez votre pose source directement à la

Source Posedu nœudBlend Runtime MetaHuman Laughter - Connectez la sortie à la broche

Result

- Connectez votre pose source directement à la

Lorsqu'un rire est détecté dans l'audio, votre personnage s'animera dynamiquement en conséquence :

Configuration du rire

Le nœud Blend Runtime MetaHuman Laughter possède ses propres options de configuration :

| Propriété | Par défaut | Description |

|---|---|---|

| Vitesse d'interpolation | 25 | Contrôle la rapidité avec laquelle les mouvements des lèvres passent d'une animation de rire à l'autre. Des valeurs plus élevées entraînent des transitions plus rapides et plus abruptes. |

| Temps de réinitialisation | 0.2 | La durée en secondes après laquelle le rire est réinitialisé. Ceci est utile pour empêcher le rire de continuer après l'arrêt de l'audio. |

| Poids maximum du rire | 0.7 | Échelonne l'intensité maximale de l'animation du rire (0.0 - 1.0). |

Remarque : La détection du rire n'est actuellement disponible qu'avec le Modèle Standard.

Le nœud Blend Realistic MetaHuman Lip Sync possède des options de configuration dans son panneau des propriétés :

| Propriété | Par défaut | Description |

|---|---|---|

| Vitesse d'interpolation | 30 | Contrôle la rapidité avec laquelle les expressions faciales changent pendant la parole active. Des valeurs plus élevées entraînent des transitions plus rapides et plus abruptes. |

| Vitesse d'interpolation au repos | 15 | Contrôle la rapidité avec laquelle les expressions faciales reviennent à l'état de repos/neutre. Des valeurs plus faibles créent des retours plus doux et plus graduels vers la pose de repos. |

| Temps de réinitialisation | 0.2 | Durée en secondes après laquelle la synchronisation labiale se réinitialise à l'état de repos. Utile pour empêcher les expressions de continuer après l'arrêt de l'audio. |

| Préserver l'état de repos | false | Lorsqu'elle est activée, préserve le dernier état émotionnel pendant les périodes de silence au lieu de revenir à l'état neutre. |

| Préserver les expressions des yeux | true | Contrôle si les contrôles faciaux liés aux yeux sont préservés pendant l'état de repos. N'est effectif que lorsque Préserver l'état de repos est activé. |

| Préserver les expressions des sourcils | true | Contrôle si les contrôles faciaux liés aux sourcils sont préservés pendant l'état de repos. N'est effectif que lorsque Préserver l'état de repos est activé. |

| Préserver la forme de la bouche | false | Contrôle si les contrôles de forme de la bouche (à l'exclusion des mouvements spécifiques à la parole comme la langue et la mâchoire) sont préservés pendant l'état de repos. N'est effectif que lorsque Préserver l'état de repos est activé. |

Préservation de l'état de repos

La fonctionnalité Préserver l'état de repos traite de la façon dont le modèle réaliste gère les périodes de silence. Contrairement au modèle standard qui utilise des visèmes discrets et revient systématiquement à des valeurs nulles pendant le silence, le réseau neuronal du modèle réaliste peut maintenir un positionnement facial subtil qui diffère de la pose de repos par défaut du MetaHuman.

Quand l'activer :

- Maintenir des expressions émotionnelles entre les segments de parole

- Préserver les traits de personnalité du personnage

- Assurer la continuité visuelle dans les séquences cinématiques

Options de contrôle régional :

- Expressions des yeux : Préserve le plissement, l'élargissement des yeux et le positionnement des paupières

- Expressions des sourcils : Maintient le positionnement des sourcils et du front

- Forme de la bouche : Conserve la courbure générale de la bouche tout en permettant aux mouvements de parole (langue, mâchoire) de se réinitialiser

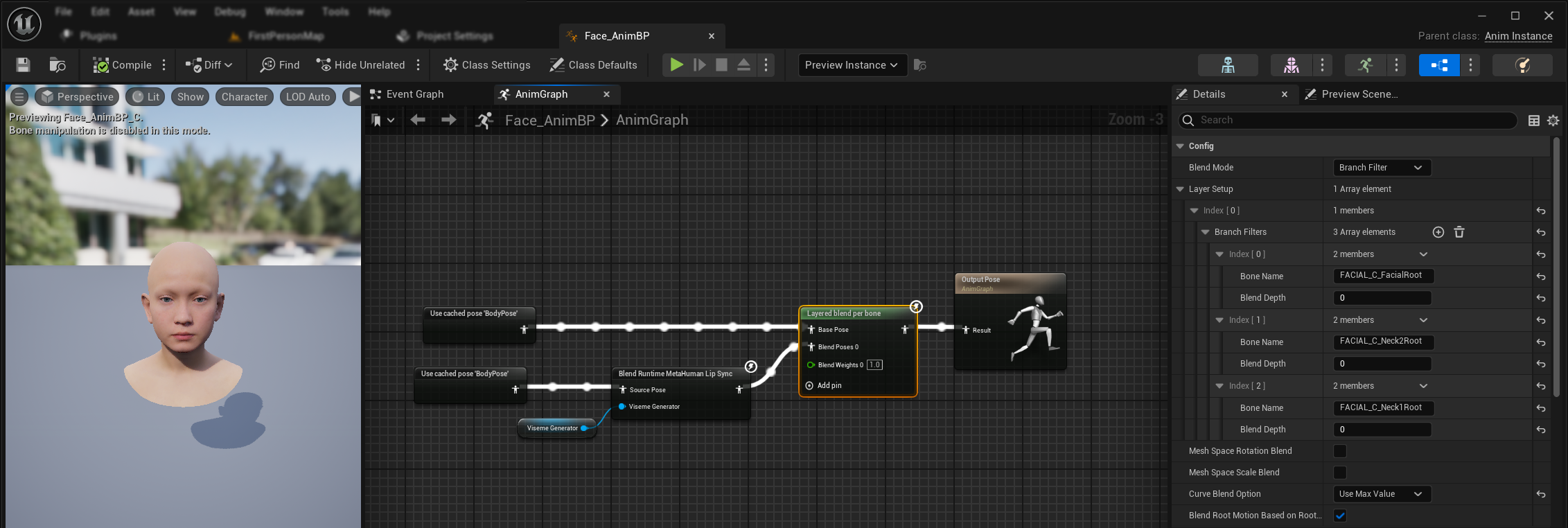

Combinaison avec des animations existantes

Pour appliquer la synchronisation labiale et le rire parallèlement à des animations corporelles existantes et à des animations faciales personnalisées sans les écraser :

- Ajoutez un nœud

Layered blend per boneentre vos animations corporelles et la sortie finale. Assurez-vous queUse Attached Parentest vrai. - Configurez la structure des calques :

- Ajoutez 1 élément au tableau

Layer Setup - Ajoutez 3 éléments aux

Branch Filterspour le calque, avec lesBone Namesuivants :FACIAL_C_FacialRootFACIAL_C_Neck2RootFACIAL_C_Neck1Root

- Ajoutez 1 élément au tableau

- Important pour les animations faciales personnalisées : Dans

Curve Blend Option, sélectionnez "Use Max Value". Cela permet aux animations faciales personnalisées (expressions, émotions, etc.) d'être correctement superposées à la synchronisation labiale. - Établissez les connexions :

- Animations existantes (comme

BodyPose) → entréeBase Pose - Sortie d'animation faciale (des nœuds de synchronisation labiale et/ou de rire) → entrée

Blend Poses 0 - Nœud de fusion en calques → pose

Resultfinale

- Animations existantes (comme

Sélection du jeu de morph targets

- Modèle standard

- Modèles réalistes

Le Modèle Standard utilise des assets de pose qui prennent en charge nativement toute convention de nommage de morph targets via la configuration d'asset de pose personnalisée. Aucune configuration supplémentaire n'est nécessaire.

Le nœud Blend Realistic MetaHuman Lip Sync inclut une propriété Morph Target Set qui détermine quelle convention de nommage de morph targets utiliser pour l'animation faciale :

| Jeu de Morph Targets | Description | Cas d'utilisation |

|---|---|---|

| MetaHuman (Par défaut) | Noms de morph targets MetaHuman standard (ex : CTRL_expressions_jawOpen) | Personnages MetaHuman |

| ARKit | Noms compatibles Apple ARKit (ex : JawOpen, MouthSmileLeft) | Personnages basés sur ARKit |

Ajustement fin du comportement de la synchronisation labiale

Contrôle de la protrusion de la langue

Dans le modèle de synchronisation labiale standard, vous pouvez remarquer un mouvement excessif de la langue vers l'avant pendant certains phonèmes. Pour contrôler la protrusion de la langue :

- Après votre nœud de fusion de synchronisation labiale, ajoutez un nœud

Modify Curve - Faites un clic droit sur le nœud

Modify Curveet sélectionnez Add Curve Pin - Ajoutez un curve pin avec le nom

CTRL_expressions_tongueOut - Définissez la propriété Apply Mode du nœud sur Scale

- Ajustez le paramètre Value pour contrôler l'extension de la langue (ex : 0.8 pour réduire la protrusion de 20 %)

Contrôle de l'ouverture de la mâchoire

La synchronisation labiale réaliste peut produire des mouvements de mâchoire excessivement réactifs selon votre contenu audio et vos exigences visuelles. Pour ajuster l'intensité de l'ouverture de la mâchoire :

- Après votre nœud de fusion de synchronisation labiale, ajoutez un nœud

Modify Curve - Faites un clic droit sur le nœud

Modify Curveet sélectionnez Add Curve Pin - Ajoutez un curve pin avec le nom

CTRL_expressions_jawOpen - Définissez la propriété Apply Mode du nœud sur Scale

- Ajustez le paramètre Value pour contrôler l'amplitude d'ouverture de la mâchoire (ex : 0.9 pour réduire le mouvement de la mâchoire de 10 %)

Ajustement fin spécifique à l'humeur

Pour les modèles avec humeur, vous pouvez ajuster finement des expressions émotionnelles spécifiques :

Contrôle des sourcils :

CTRL_expressions_browRaiseInL/CTRL_expressions_browRaiseInR- Sourcils intérieurs relevésCTRL_expressions_browRaiseOuterL/CTRL_expressions_browRaiseOuterR- Sourcils extérieurs relevésCTRL_expressions_browDownL/CTRL_expressions_browDownR- Sourcils abaissés

Contrôle des expressions des yeux :

CTRL_expressions_eyeSquintInnerL/CTRL_expressions_eyeSquintInnerR- Plissement des yeuxCTRL_expressions_eyeCheekRaiseL/CTRL_expressions_eyeCheekRaiseR- Rehaussement des joues

Comparaison et sélection des modèles

Choix entre les modèles

Lorsque vous décidez quel modèle de synchronisation labiale utiliser pour votre projet, prenez en compte ces facteurs :

| Considération | Modèle Standard | Modèle Réaliste | Modèle Réaliste avec Humeur |

|---|---|---|---|

| Compatibilité des personnages | MetaHumans et tous les types de personnages personnalisés | Personnages MetaHumans (et ARKit) | Personnages MetaHumans (et ARKit) |

| Qualité visuelle | Bonne synchronisation labiale avec des performances efficaces | Réalisme amélioré avec des mouvements de bouche plus naturels | Réalisme amélioré avec des expressions émotionnelles |

| Performances | Optimisé pour toutes les plateformes, y compris mobile/VR | Exigences en ressources plus élevées | Exigences en ressources plus élevées |

| Fonctionnalités | 14 visèmes, détection du rire | 81 contrôles faciaux, 3 niveaux d'optimisation | 81 contrôles faciaux, 12 humeurs, sortie configurable |

| Support des plateformes | Windows, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest |

| Cas d'utilisation | Applications générales, jeux, VR/AR, mobile | Expériences cinématiques, interactions en gros plan | Narration émotionnelle, interaction avancée avec les personnages |

Compatibilité des versions du moteur

Si vous utilisez Unreal Engine 5.2, les Modèles Réalistes peuvent ne pas fonctionner correctement en raison d'un bug dans la bibliothèque de rééchantillonnage d'UE. Pour les utilisateurs d'UE 5.2 qui ont besoin d'une fonctionnalité de synchronisation labiale fiable, veuillez utiliser le Modèle Standard à la place.

Ce problème est spécifique à UE 5.2 et n'affecte pas les autres versions du moteur.

Recommandations de performance

- Pour la plupart des projets, le Modèle Standard offre un excellent équilibre entre qualité et performance

- Utilisez le Modèle Réaliste lorsque vous avez besoin de la plus haute fidélité visuelle pour les personnages MetaHuman

- Utilisez le Modèle Réaliste avec Humeur lorsque le contrôle des expressions émotionnelles est important pour votre application

- Prenez en compte les capacités de performance de votre plateforme cible lors du choix entre les modèles

- Testez différents niveaux d'optimisation pour trouver le meilleur équilibre pour votre cas d'utilisation spécifique

Dépannage

Problèmes courants

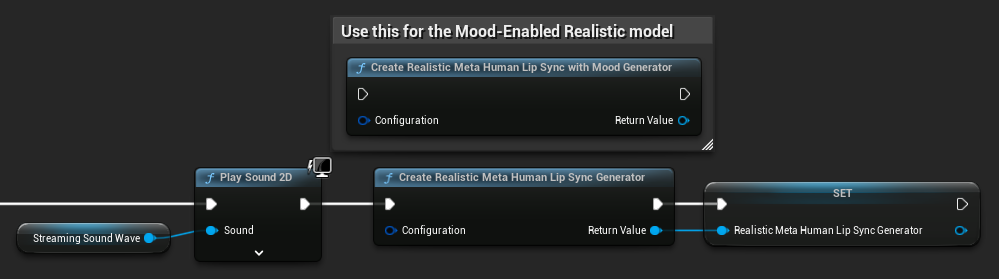

Recréation du générateur pour les modèles réalistes : Pour un fonctionnement fiable et cohérent avec les Modèles Réalistes, il est recommandé de recréer le générateur chaque fois que vous souhaitez fournir de nouvelles données audio après une période d'inactivité. Ceci est dû au comportement du runtime ONNX qui peut faire cesser le fonctionnement de la synchronisation labiale lors de la réutilisation de générateurs après des périodes de silence.

Par exemple, vous pourriez recréer le générateur de synchronisation labiale à chaque début de lecture, comme chaque fois que vous appelez Play Sound 2D ou utilisez toute autre méthode pour démarrer la lecture d'une onde sonore et la synchronisation labiale :

Emplacement du plugin pour l'intégration Runtime Text To Speech : Lorsque vous utilisez Runtime MetaHuman Lip Sync avec Runtime Text To Speech (les deux plugins utilisent ONNX Runtime), vous pouvez rencontrer des problèmes dans les builds empaquetées si les plugins sont installés dans le dossier Marketplace du moteur. Pour corriger cela :

- Localisez les deux plugins dans votre dossier d'installation UE sous

\Engine\Plugins\Marketplace(ex :C:\Program Files\Epic Games\UE_5.6\Engine\Plugins\Marketplace) - Déplacez les dossiers

RuntimeMetaHumanLipSyncetRuntimeTextToSpeechvers le dossierPluginsde votre projet - Si votre projet n'a pas de dossier

Plugins, créez-en un dans le même répertoire que votre fichier.uproject - Redémarrez l'Unreal Editor

Cela résout les problèmes de compatibilité qui peuvent survenir lorsque plusieurs plugins basés sur ONNX Runtime sont chargés depuis le répertoire Marketplace du moteur.

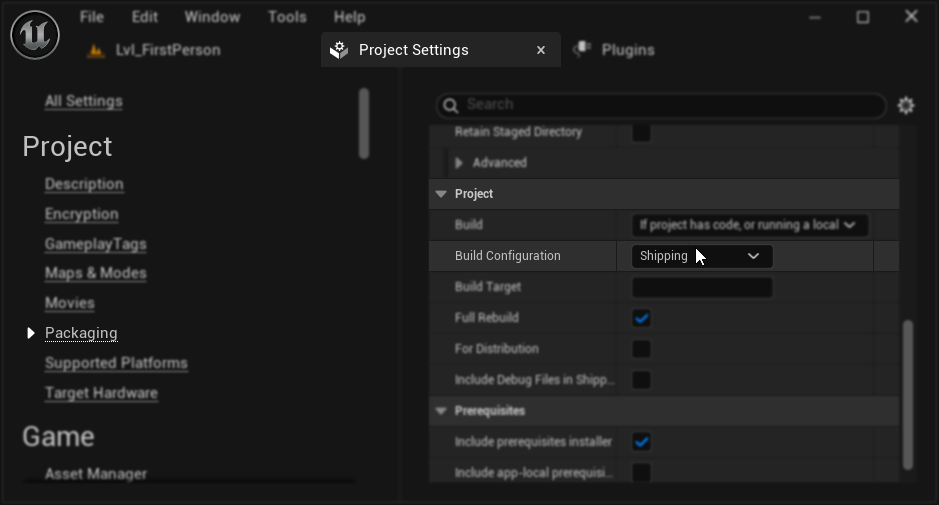

Configuration de l'empaquetage (Windows) : Si la synchronisation labiale ne fonctionne pas correctement dans votre projet empaqueté sur Windows, assurez-vous d'utiliser la configuration de build Shipping au lieu de Development. La configuration Development peut causer des problèmes avec le runtime ONNX des modèles réalistes dans les builds empaquetées.

Pour corriger cela :

- Dans vos Paramètres du projet → Packaging, définissez la Build Configuration sur Shipping

- Re-empaquetez votre projet

Dans certains projets Blueprint uniquement, Unreal Engine peut toujours construire en configuration Development même lorsque Shipping est sélectionné. Si cela se produit, convertissez votre projet en projet C++ en ajoutant au moins une classe C++ (elle peut être vide). Pour ce faire, allez dans Tools → New C++ Class dans le menu de l'éditeur UE et créez une classe vide. Cela forcera le projet à se construire correctement en configuration Shipping. Votre projet peut rester Blueprint uniquement en termes de fonctionnalité, la classe C++ est juste nécessaire pour une configuration de build correcte.

Dégradation de la réactivité de la synchronisation labiale : Si vous constatez que la synchronisation labiale devient moins réactive avec le temps lors de l'utilisation de Streaming Sound Wave ou Capturable Sound Wave, cela peut être causé par une accumulation de mémoire. Par défaut, la mémoire est réallouée chaque fois que de nouveaux audio sont ajoutés. Pour éviter ce problème, appelez la fonction ReleaseMemory périodiquement pour libérer la mémoire accumulée, par exemple toutes les 30 secondes environ.

Optimisation des performances :

- Ajustez la taille des blocs de traitement pour les modèles réalistes en fonction de vos exigences de performance

- Utilisez un nombre de threads approprié pour votre matériel cible

- Envisagez d'utiliser le type de sortie Mouth Only pour les modèles avec humeur lorsque l'animation faciale complète n'est pas nécessaire