Guide d'Installation

Ce guide vous accompagne dans le processus d'installation de base de Runtime MetaHuman Lip Sync avec vos personnages MetaHuman.

Note : Runtime MetaHuman Lip Sync fonctionne avec les MetaHuman et les personnages personnalisés. Pour des instructions détaillées sur la configuration des personnages personnalisés, consultez le Guide de Configuration des Personnages Personnalisés.

Prérequis

Avant de commencer, assurez-vous :

-

Prérequis du plugin MetaHuman :

- UE 5.5 et versions antérieures : Activez le plugin MetaHuman dans votre projet

- UE 5.6 et versions ultérieures : Activez le plugin MetaHuman Core Tech dans votre projet

Plugins MetaHuman SupplémentairesSelon la façon dont vous créez vos personnages MetaHuman, vous pourriez avoir besoin de plugins supplémentaires. Par exemple, si vous prévoyez de créer un MetaHuman avec le nouveau système MetaHuman Creator introduit dans UE 5.6, vous devrez également activer le plugin MetaHuman Creator. Pour plus d'informations sur ce système, consultez la documentation MetaHuman Creator.

-

Vous avez au moins un personnage MetaHuman téléchargé et disponible dans votre projet

-

Le plugin Runtime MetaHuman Lip Sync est installé

Plugin d'Extension du Modèle Standard

Si vous prévoyez d'utiliser le Modèle Standard, vous devrez installer le plugin d'extension :

- Téléchargez le plugin Standard Lip Sync Extension depuis Google Drive

- Extrayez le dossier de l'archive téléchargée dans le dossier

Pluginsde votre projet (créez ce dossier s'il n'existe pas) - Assurez-vous que votre projet est configuré comme un projet C++ (même si vous n'avez pas de code C++)

- Recompilez votre projet

- Cette extension est uniquement requise si vous souhaitez utiliser le Modèle Standard. Si vous n'avez besoin que des Modèles Réalistes, vous pouvez ignorer cette étape.

- Pour plus d'informations sur la façon de compiler manuellement des plugins, consultez le tutoriel Building Plugins

Plugins Supplémentaires

- Si vous prévoyez d'utiliser la capture audio (par exemple, entrée microphone), installez le plugin Runtime Audio Importer.

- Si vous prévoyez d'utiliser la fonctionnalité synthèse vocale :

- Pour la synthèse vocale locale (Modèle Standard et Modèle Réaliste avec Émotions), installez le plugin Runtime Text To Speech.

- Pour les fournisseurs de synthèse vocale externes (ElevenLabs, OpenAI, Google Cloud, Azure), installez le plugin Runtime AI Chatbot Integrator.

Configuration du Animation Blueprint

Étape 1 : Localiser et modifier le Blueprint d'animation faciale

- UE 5.5 et versions antérieures (ou MetaHumans Hérités dans UE 5.6+)

- Personnages MetaHuman Creator UE 5.6+

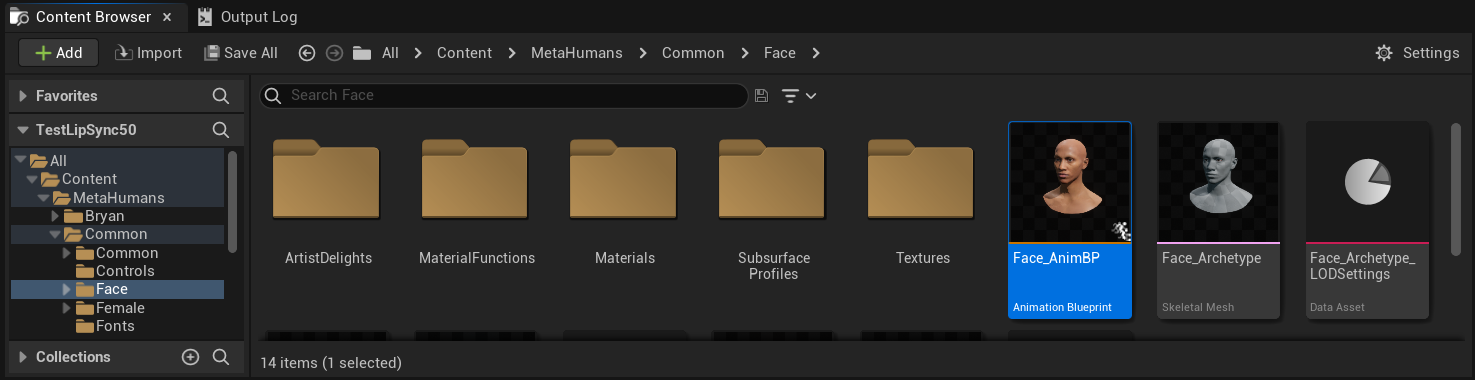

Vous devez modifier un Blueprint d'Animation qui sera utilisé pour les animations faciales de votre personnage MetaHuman. Le Blueprint d'Animation facial par défaut pour MetaHuman se trouve à l'emplacement :

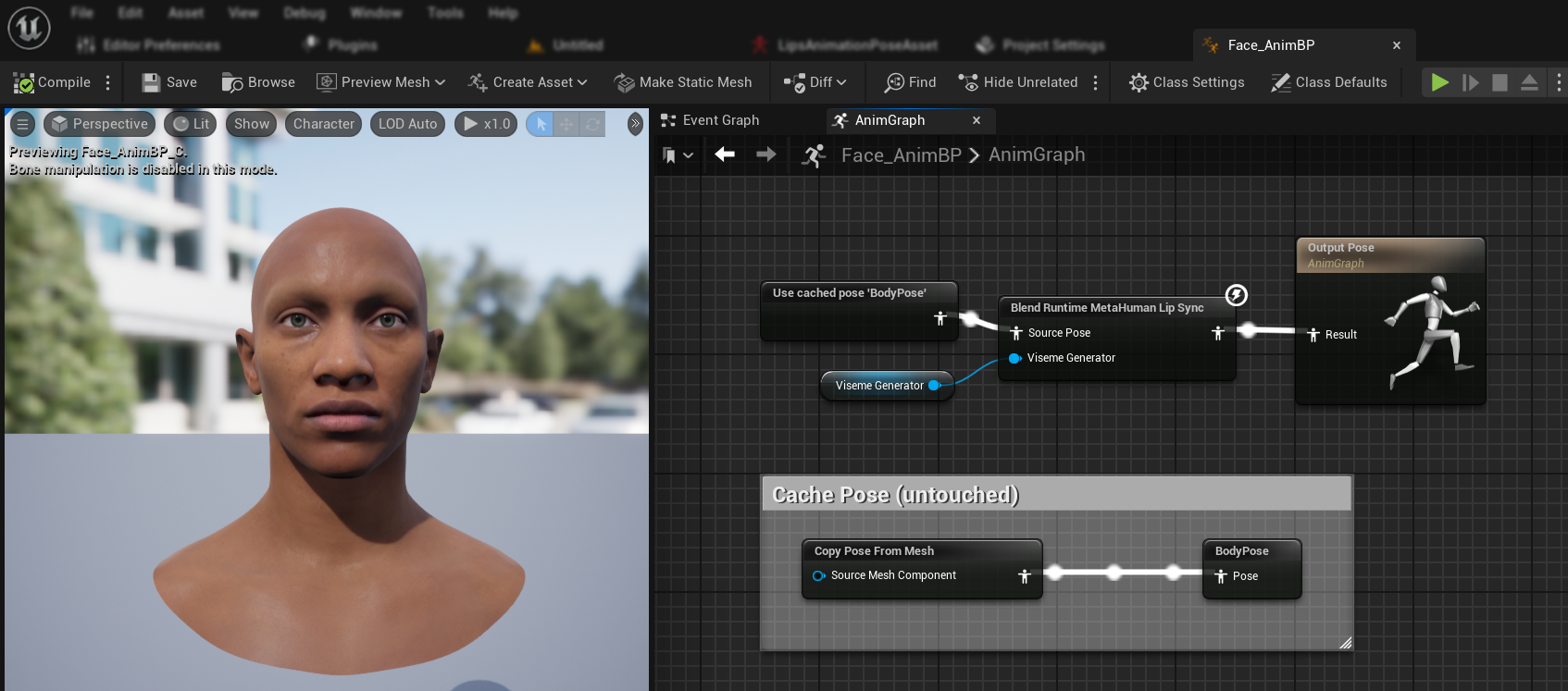

Content/MetaHumans/Common/Face/Face_AnimBP

Vous avez plusieurs options pour implémenter la fonctionnalité de synchronisation labiale :

- Modifier l'Asset par Défaut (Option la Plus Simple)

- Créer un Duplicata

- Utiliser un Animation Blueprint Personnalisé

Ouvrez directement le Face_AnimBP par défaut et effectuez vos modifications. Tous les changements affecteront tous les personnages MetaHuman utilisant ce Animation Blueprint.

Remarque : Cette approche est pratique mais impactera tous les personnages utilisant le Animation Blueprint par défaut.

- Dupliquez

Face_AnimBPet donnez-lui un nom descriptif - Localisez la classe Blueprint de votre personnage (par exemple, pour le personnage "Bryan", elle se trouverait à

Content/MetaHumans/Bryan/BP_Bryan) - Ouvrez le Blueprint du personnage et trouvez le composant Face

- Modifiez la propriété Anim Class pour votre nouveau Animation Blueprint dupliqué

Remarque : Cette approche vous permet de personnaliser la synchronisation labiale pour des personnages spécifiques tout en laissant les autres inchangés.

Vous pouvez implémenter le mélange de synchronisation labiale dans n'importe quel Animation Blueprint ayant accès aux os faciaux requis :

- Créez ou utilisez un Animation Blueprint personnalisé existant

- Assurez-vous que votre Animation Blueprint fonctionne avec un squelette contenant les mêmes os faciaux que le

Face_Archetype_Skeletonpar défaut de MetaHuman

Remarque : Cette approche vous offre une flexibilité maximale pour l'intégration avec des systèmes d'animation personnalisés.

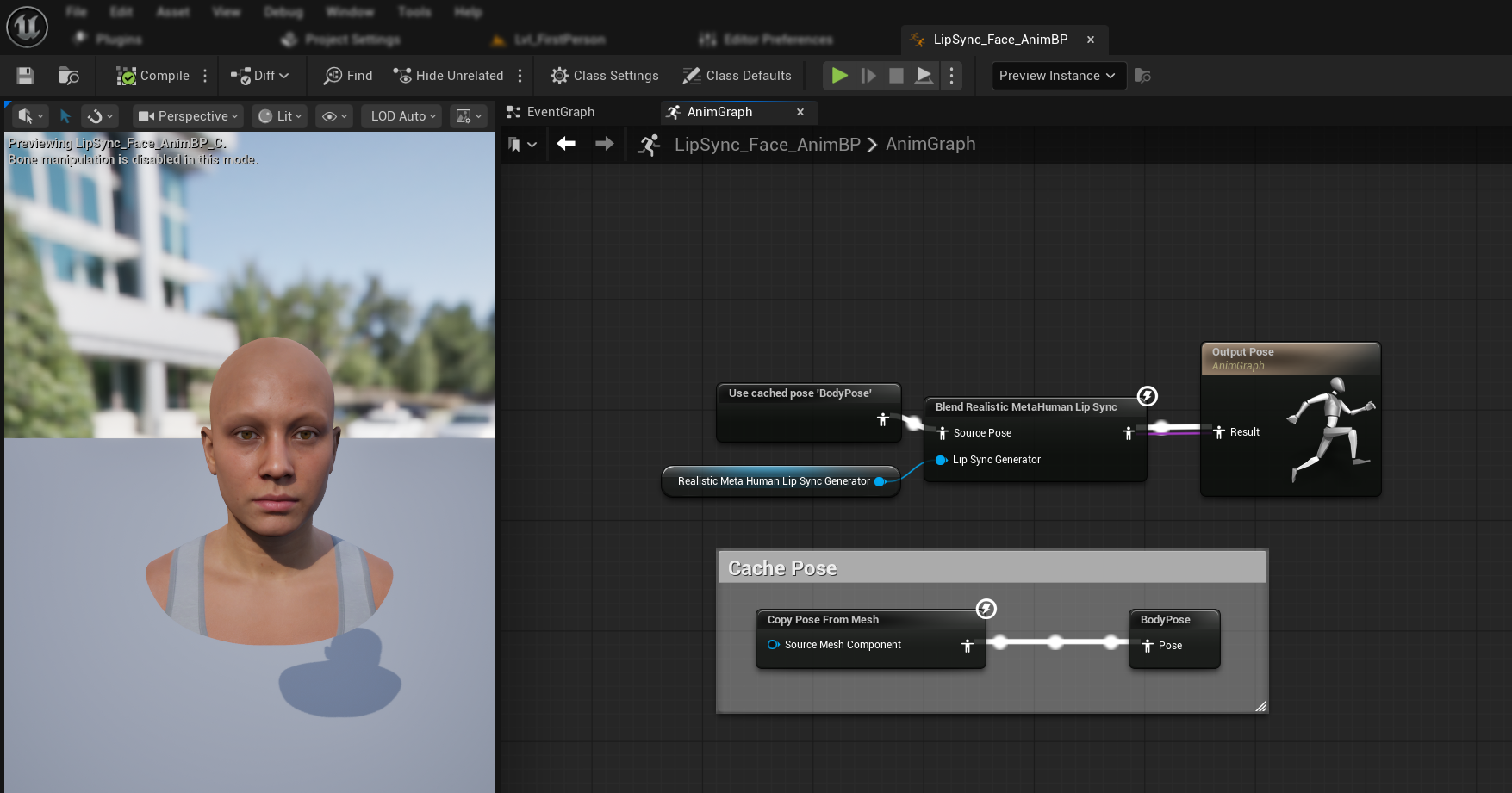

À partir d'UE 5.6, le nouveau système MetaHuman Creator a été introduit. Pour ces personnages, le plugin fournit un Animation Blueprint facial situé à :

Content/LipSyncData/LipSync_Face_AnimBP

Cette Animation Blueprint se trouve dans le dossier de contenu du plugin et sera écrasée à chaque mise à jour du plugin. Pour éviter de perdre vos personnalisations :

- Copiez cet asset dans le dossier Content de votre projet (par exemple, vers

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - Utilisez votre version copiée dans la configuration de votre personnage

- Effectuez toutes vos modifications sur la version copiée

Utilisation de l'Animation Blueprint du visage du plugin :

- Localisez la classe Blueprint de votre personnage MetaHuman Creator

- Ouvrez la Blueprint du personnage et trouvez le composant Face

- Modifiez la propriété Anim Class avec celle du plugin

LipSync_Face_AnimBP - Poursuivez avec les étapes suivantes pour configurer la fonctionnalité Runtime MetaHuman Lip Sync

Étape 2 : Configuration du graphe d'événements

Ouvrez votre Animation Blueprint du visage et basculez vers le Event Graph. Vous devrez créer un générateur qui traitera les données audio et générera l'animation de synchronisation labiale.

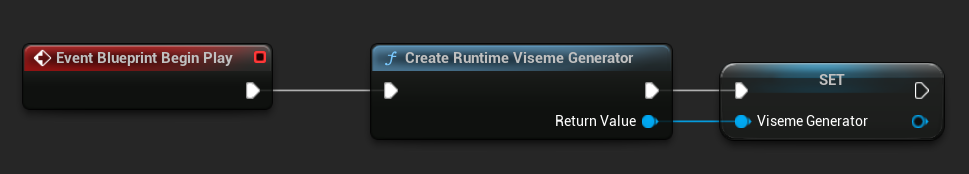

- Modèle Standard

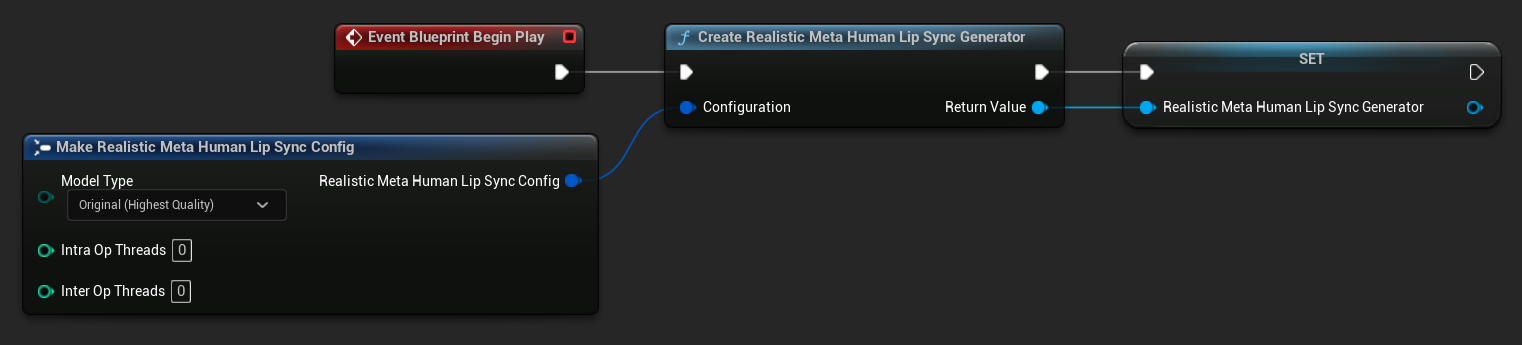

- Modèle Réaliste

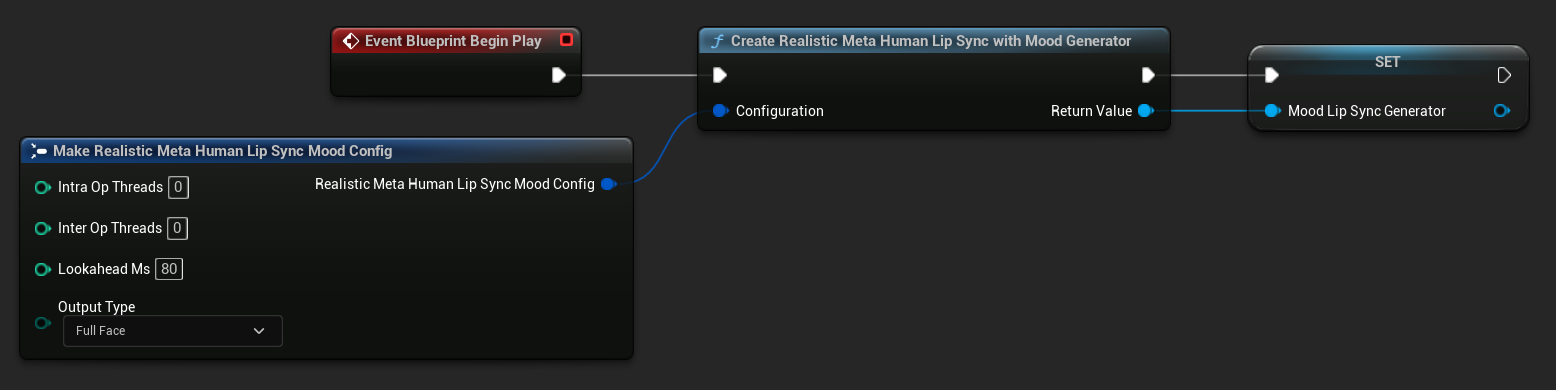

- Modèle Réaliste avec Humeur

- Ajoutez le nœud

Event Blueprint Begin Plays'il n'existe pas déjà - Ajoutez le nœud

Create Runtime Viseme Generatoret connectez-le à l'événement Begin Play - Sauvegardez la sortie en tant que variable (par exemple "VisemeGenerator") pour l'utiliser dans d'autres parties du graphe

Pour les options de configuration détaillées, consultez la section Configuration du modèle standard.

- Ajoutez le nœud

Event Blueprint Begin Plays'il n'existe pas déjà - Ajoutez le nœud

Create Realistic MetaHuman Lip Sync Generatoret connectez-le à l'événement Begin Play - Sauvegardez la sortie en tant que variable (par exemple "RealisticMetaHumanLipSyncGenerator") pour l'utiliser dans d'autres parties du graphe

- (Optionnel) Configurez les paramètres du générateur en utilisant le paramètre Configuration

Pour les options de configuration détaillées incluant les types de modèles, les paramètres de performance et les paramètres de traitement, consultez la section Configuration du modèle réaliste.

- Ajoutez le nœud

Event Blueprint Begin Plays'il n'existe pas déjà - Ajoutez le nœud

Create Realistic MetaHuman Lip Sync With Mood Generatoret connectez-le à l'événement Begin Play - Sauvegardez la sortie en tant que variable (par exemple "MoodMetaHumanLipSyncGenerator") pour l'utiliser dans d'autres parties du graphe

- (Optionnel) Configurez les paramètres du générateur en utilisant le paramètre Configuration

Pour la configuration détaillée de l'humeur incluant types d'humeur, paramètres d'intensité, minutage de prévision et sélection du type de sortie, consultez la section Configuration du modèle avec humeur.

Étape 3 : Configuration du graphe d'animation

Après avoir configuré le graphe d'événements, passez au Anim Graph pour connecter le générateur à l'animation du personnage :

- Modèle standard

- Modèle réaliste

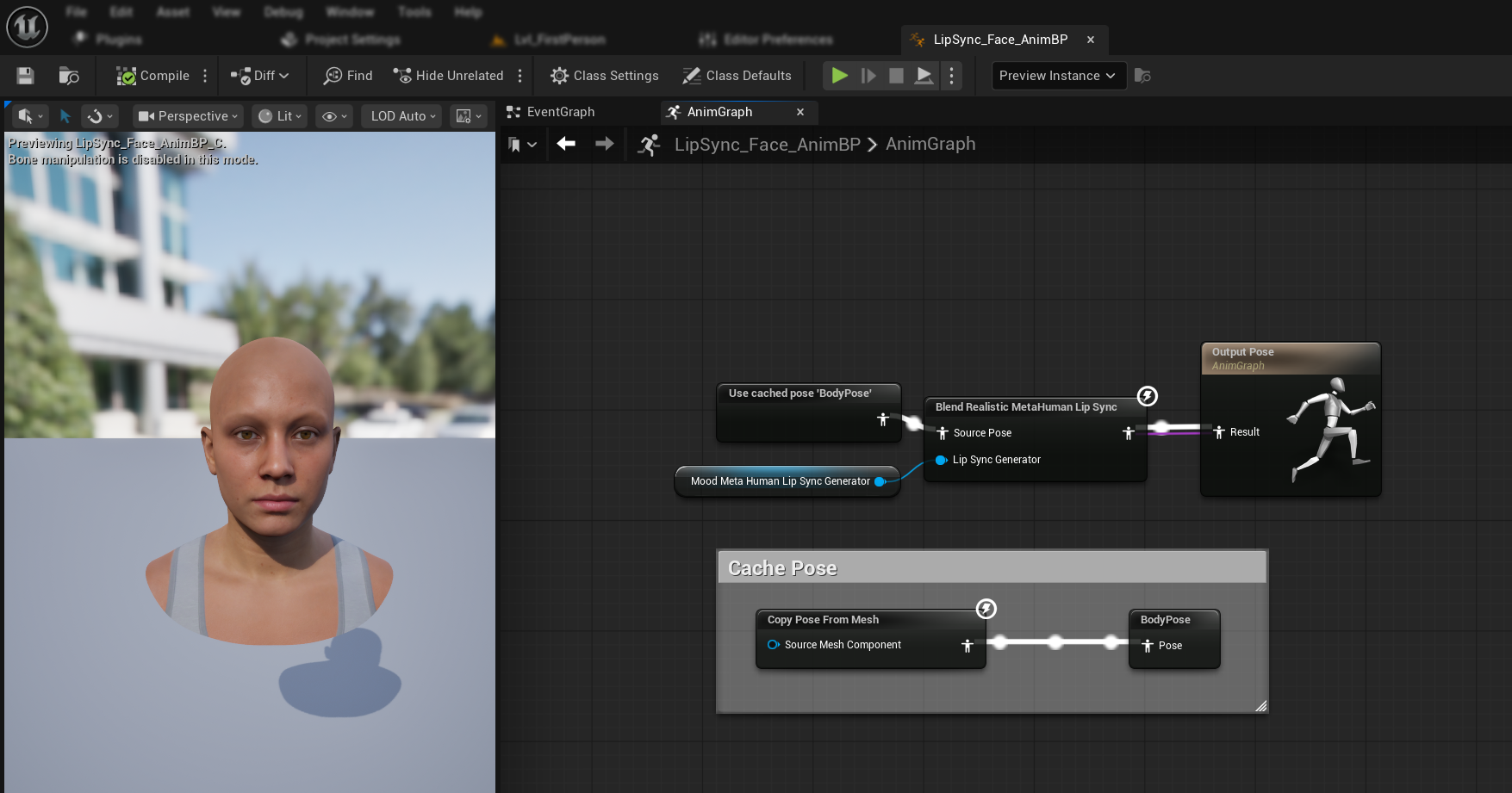

- Modèle réaliste avec humeur

- Localisez la pose qui contient le visage MetaHuman (généralement à partir de

Use cached pose 'Body Pose') - Ajoutez le nœud

Blend Runtime MetaHuman Lip Sync - Connectez la pose à la

Source Posedu nœudBlend Runtime MetaHuman Lip Sync - Connectez votre variable

VisemeGeneratorà la brocheViseme Generator - Connectez la sortie du nœud

Blend Runtime MetaHuman Lip Syncà la brocheResultde l'Output Pose

- Localisez la pose qui contient le visage MetaHuman (généralement à partir de

Use cached pose 'Body Pose') - Ajoutez le nœud

Blend Realistic MetaHuman Lip Sync - Connectez la pose à la

Source Posedu nœudBlend Realistic MetaHuman Lip Sync - Connectez votre variable

RealisticMetaHumanLipSyncGeneratorà la brocheLip Sync Generator - Connectez la sortie du nœud

Blend Realistic MetaHuman Lip Syncà la brocheResultde l'Output Pose

- Localisez la pose qui contient le visage MetaHuman (généralement à partir de

Use cached pose 'Body Pose') - Ajoutez le nœud

Blend Realistic MetaHuman Lip Sync(même nœud que le modèle réaliste standard) - Connectez la pose à la

Source Posedu nœudBlend Realistic MetaHuman Lip Sync - Connectez votre variable

MoodMetaHumanLipSyncGeneratorà la brocheLip Sync Generator - Connectez la sortie du nœud

Blend Realistic MetaHuman Lip Syncà la brocheResultde l'Output Pose

Remarque : Le modèle avec humeur utilise le même nœud d'Animation Blueprint que le modèle réaliste standard. La fonctionnalité d'humeur est gérée en interne par le générateur.

Prochaines étapes

Maintenant que la configuration de base de l'Animation Blueprint est terminée, vous devrez configurer le traitement de l'entrée audio pour alimenter votre générateur de synchronisation labiale en données audio.

Poursuivez avec le Guide de traitement audio pour apprendre à configurer différentes méthodes d'entrée audio, y compris la capture par microphone, la synthèse vocale et le traitement de fichiers audio. Pour les options de configuration avancées et le réglage fin, consultez le Guide de Configuration.