अनुवाद प्रदाता

AI Localization Automator पाँच अलग-अलग AI प्रदाताओं का समर्थन करता है, प्रत्येक के अपने अनूठे बल और कॉन्फ़िगरेशन विकल्प हैं। वह प्रदाता चुनें जो आपकी परियोजना की आवश्यकताओं, बजट और गुणवत्ता आवश्यकताओं के लिए सबसे उपयुक्त हो।

ओलामा (स्थानीय AI)

सर्वोत्तम: गोपनीयता-संवेदनशील परियोजनाओं, ऑफ़लाइन अनुवाद, असीमित उपयोग के लिए

ओलामा AI मॉडल आपकी मशीन पर स्थानीय रूप से चलाता है, जो API लागत या इंटरनेट आवश्यकताओं के बिना पूर्ण गोपनीयता और नियंत्रण प्रदान करता है।

लोकप्रिय मॉडल

- llama3.2 (अनुशंसित सामान्य उद्देश्य)

- mistral (कुशल विकल्प)

- codellama (कोड-जागरूक अनुवाद)

- और भी कई सामुदायिक मॉडल

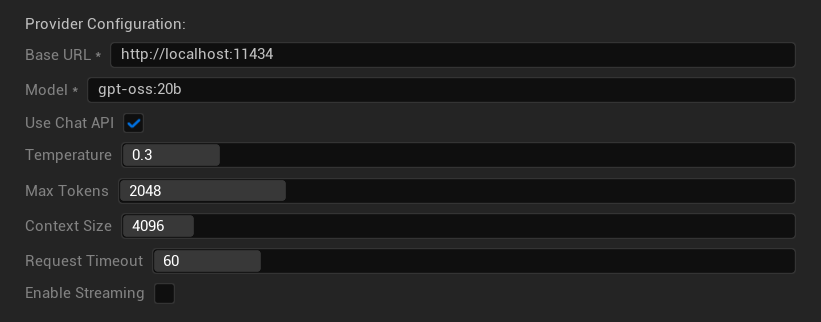

कॉन्फ़िगरेशन विकल्प

- आधार URL: स्थानीय ओलामा सर्वर (डिफ़ॉल्ट:

http://localhost:11434) - मॉडल: स्थानीय रूप से स्थापित मॉडल का नाम (आवश्यक)

- चैट API का उपयोग करें: बेहतर वार्तालाप प्रबंधन के लिए सक्षम करें

- तापमान: 0.0-2.0 (0.3 अनुशंसित)

- अधिकतम टोकन: 1-8,192 टोकन

- संदर्भ आकार: 512-32,768 टोकन

- अनुरोध समय समाप्ति: 10-300 सेकंड (स्थानीय मॉडल धीमे हो सकते हैं)

- स्ट्रीमिंग सक्षम करें: वास्तविक-समय प्रतिक्रिया प्रसंस्करण के लिए

बल

- ✅ पूर्ण गोपनीयता (कोई डेटा आपकी मशीन से नहीं जाता)

- ✅ कोई API लागत या उपयोग सीमा नहीं

- ✅ ऑफ़लाइन काम करता है

- ✅ मॉडल मापदंडों पर पूर्ण नियंत्रण

- ✅ सामुदायिक मॉडलों की विस्तृत विविधता

- ✅ कोई विक्रेता लॉक-इन नहीं

विचार

- 💻 स्थानीय सेटअप और सक्षम हार्डवेयर की आवश्यकता है

- ⚡ आम तौर पर क्लाउड प्रदाताओं से धीमा

- 🔧 अधिक तकनीकी सेटअप आवश्यक

- 📊 अनुवाद गुणवत्ता मॉडल के अनुसार काफी भिन्न होती है (कुछ क्लाउड प्रदाताओं से अधिक हो सकते हैं)

- 💾 मॉडलों के लिए बड़ी भंडारण आवश्यकताएँ

ओलामा सेटअप करना

- ओलामा इंस्टॉल करें: ollama.ai से डाउनलोड करें और अपने सिस्टम पर इंस्टॉल करें

- मॉडल डाउनलोड करें: अपना चुना हुआ मॉडल डाउनलोड करने के लिए

ollama pull llama3.2का उपयोग करें - सर्वर शुरू करें: ओलामा स्वचालित रूप से चलता है, या

ollama serveसे शुरू करें - प्लगइन कॉन्फ़िगर करें: प्लगइन सेटिंग्स में आधार URL और मॉडल नाम सेट करें

- कनेक्शन परीक्षण करें: जब आप कॉन्फ़िगरेशन लागू करेंगे तो प्लगइन कनेक्टिविटी सत्यापित करेगा

OpenAI

सर्वोत्तम: उच्चतम समग्र अनुवाद गुणवत्ता, व्यापक मॉडल चयन के लिए

OpenAI अपने API के माध्यम से उद्योग-अग्रणी भाषा मॉडल प्रदान करता है, जिसमें नवीनतम GPT मॉडल और नया Responses API प्रारूप शामिल है।

उपलब्ध मॉडल

- gpt-5 (नवीनतम प्रमुख मॉडल)

- gpt-5-mini (छोटा, तेज़ प्रकार)

- gpt-4.1 और gpt-4.1-mini

- gpt-4o और gpt-4o-mini (अनुकूलित मॉडल)

- o3 और o3-mini (उन्नत तर्क)

- o1 और o1-mini (पिछली पीढ़ी)

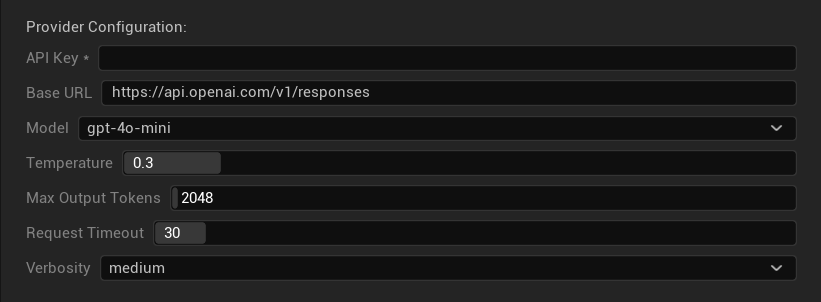

कॉन्फ़िगरेशन विकल्प

- API कुंजी: आपकी OpenAI API कुंजी (आवश्यक)

- बेस URL: API एंडपॉइंट (डिफ़ॉल्ट: OpenAI के सर्वर)

- मॉडल: उपलब्ध GPT मॉडल में से चुनें

- टेम्परेचर: 0.0-2.0 (अनुवाद स्थिरता के लिए 0.3 अनुशंसित)

- अधिकतम आउटपुट टोकन: 1-128,000 टोकन

- अनुरोध टाइमआउट: 5-300 सेकंड

- वर्बोसिटी: प्रतिक्रिया विस्तार स्तर नियंत्रित करें

ताकत

- ✅ लगातार उच्च-गुणवत्ता वाले अनुवाद

- ✅ उत्कृष्ट संदर्भ समझ

- ✅ मजबूत प्रारूप संरक्षण

- ✅ व्यापक भाषा समर्थन

- ✅ विश्वसनीय API अपटाइम

विचार

- 💰 प्रति अनुरोध उच्च लागत

- 🌐 इंटरनेट कनेक्शन आवश्यक

- ⏱️ टियर के आधार पर उपयोग सीमाएं

Anthropic Claude

सर्वोत्तम: सूक्ष्म अनुवाद, रचनात्मक सामग्री, सुरक्षा-केंद्रित अनुप्रयोग

Claude मॉडल संदर्भ और सूक्ष्मता को समझने में उत्कृष्ट हैं, जो उन्हें कथा-प्रधान गेम और जटिल स्थानीयकरण परिदृश्यों के लिए आदर्श बनाते हैं।

उपलब्ध मॉडल

- claude-opus-4-1-20250805 (नवीनतम फ्लैगशिप)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (तेज़ और कुशल)

- claude-3-haiku-20240307

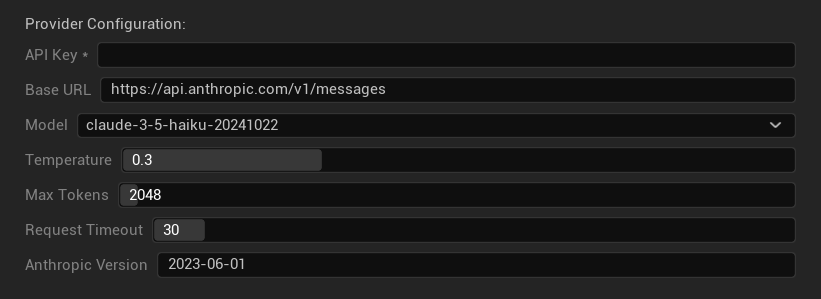

कॉन्फ़िगरेशन विकल्प

- API कुंजी: आपकी Anthropic API कुंजी (आवश्यक)

- बेस URL: Claude API एंडपॉइंट

- मॉडल: Claude मॉडल परिवार से चुनें

- टेम्परेचर: 0.0-1.0 (0.3 अनुशंसित)

- अधिकतम टोकन: 1-64,000 टोकन

- अनुरोध टाइमआउट: 5-300 सेकंड

- Anthropic वर्जन: API वर्जन हेडर

ताकत

- ✅ असाधारण संदर्भ जागरूकता

- ✅ रचनात्मक/कथा सामग्री के लिए बढ़िया

- ✅ मजबूत सुरक्षा सुविधाएँ

- ✅ विस्तृत तर्क क्षमताएँ

- ✅ उत्कृष्ट निर्देश अनुसरण

विचार

- 💰 प्रीमियम मूल्य निर्धारण मॉडल

- 🌐 इंटरनेट कनेक्शन आवश्यक

- 📏 मॉडल के अनुसार टोकन सीमाएँ भिन्न

DeepSeek

सर्वोत्तम: लागत-प्रभावी अनुवाद, उच्च थ्रूपुट, बजट-सचेत परियोजनाएँ

DeepSeek अन्य प्रदाताओं की तुलना में एक अंश लागत पर प्रतिस्पर्धी अनुवाद गुणवत्ता प्रदान करता है, जो इसे बड़े पैमाने की स्थानीयकरण परियोजनाओं के लिए आदर्श बनाता है।

उपलब्ध मॉडल

- deepseek-chat (सामान्य उद्देश्य, अनुशंसित)

- deepseek-reasoner (उन्नत तर्क क्षमताएँ)

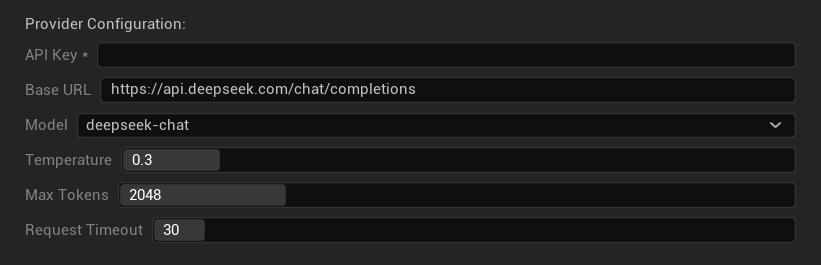

कॉन्फ़िगरेशन विकल्प

- API कुंजी: आपकी DeepSeek API कुंजी (आवश्यक)

- बेस URL: DeepSeek API एंडपॉइंट

- मॉडल: चैट और रीज़नर मॉडल के बीच चुनें

- टेम्परेचर: 0.0-2.0 (0.3 अनुशंसित)

- अधिकतम टोकन: 1-8,192 टोकन

- अनुरोध टाइमआउट: 5-300 सेकंड

ताकत

- ✅ बहुत लागत-प्रभावी

- ✅ अच्छी अनुवाद गुणवत्ता

- ✅ तेज़ प्रतिक्रिया समय

- ✅ सरल कॉन्फ़िगरेशन

- ✅ उच्च दर सीमाएँ

विचार

- 📏 कम टोकन सीमाएँ

- 🆕 नया प्रदाता (कम ट्रैक रिकॉर्ड)

- 🌐 इंटरनेट कनेक्शन आवश्यक

Google Gemini

सर्वोत्तम: बहुभाषी परियोजनाओं के लिए, लागत-प्रभावी अनुवाद, Google इकोसिस्टम एकीकरण

Gemini मॉडल बेहतर तर्क के लिए सोच मोड जैसी अनूठी सुविधाओं के साथ प्रतिस्पर्धी मूल्य निर्धारण और मजबूत बहुभाषी क्षमताएँ प्रदान करते हैं।

उपलब्ध मॉडल

- gemini-2.5-pro (सोच के साथ नवीनतम फ्लैगशिप)

- gemini-2.5-flash (तेज़, सोच समर्थन के साथ)

- gemini-2.5-flash-lite (हल्का वेरिएंट)

- gemini-2.0-flash और gemini-2.0-flash-lite

- gemini-1.5-pro और gemini-1.5-flash

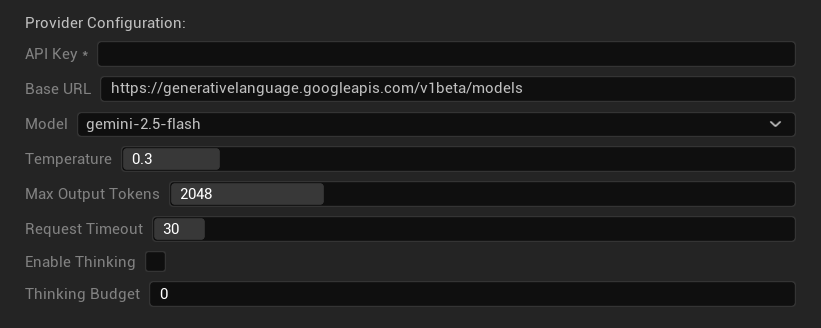

कॉन्फ़िगरेशन विकल्प

- API कुंजी: आपकी Google AI API कुंजी (आवश्यक)

- बेस URL: Gemini API एंडपॉइंट

- मॉडल: Gemini मॉडल परिवार से चयन करें

- तापमान: 0.0-2.0 (0.3 अनुशंसित)

- अधिकतम आउटपुट टोकन: 1-8,192 टोकन

- अनुरोध टाइमआउट: 5-300 सेकंड

- सोच सक्षम करें: 2.5 मॉडल के लिए उन्नत तर्क सक्रिय करें

- सोच बजट: सोच टोकन आवंटन को नियंत्रित करें

ताकत

- ✅ मजबूत बहुभाषी समर्थन

- ✅ प्रतिस्पर्धी मूल्य निर्धारण

- ✅ उन्नत तर्क (सोच मोड)

- ✅ Google इकोसिस्टम एकीकरण

- ✅ नियमित मॉडल अपडेट

विचार

- 🧠 सोच मोड टोकन उपयोग बढ़ाता है

- 📏 मॉडल द्वारा परिवर्तनशील टोकन सीमाएँ

- 🌐 इंटरनेट कनेक्शन आवश्यक

सही प्रदाता चुनना

| प्रदाता | सर्वोत्तम | गुणवत्ता | लागत | सेटअप | गोपनीयता |

|---|---|---|---|---|---|

| Ollama | गोपनीयता/ऑफ़लाइन | परिवर्तनशील* | मुफ़्त | उन्नत | स्थानीय |

| OpenAI | उच्चतम गुणवत्ता | ⭐⭐⭐⭐⭐ | 💰💰💰 | आसान | क्लाउड |

| Claude | रचनात्मक सामग्री | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | आसान | क्लाउड |

| DeepSeek | बजट परियोजनाएँ | ⭐⭐⭐⭐ | 💰 | आसान | क्लाउड |

| Gemini | बहुभाषी | ⭐⭐⭐⭐ | 💰 | आसान | क्लाउड |

*Ollama के लिए गुणवत्ता उपयोग किए गए स्थानीय मॉडल के आधार पर काफी भिन्न होती है - कुछ आधुनिक स्थानीय मॉडल क्लाउड प्रदाताओं से मेल खा सकते हैं या उनसे आगे निकल सकते हैं।

प्रदाता कॉन्फ़िगरेशन युक्तियाँ

सभी क्लाउड प्रदाताओं के लिए:

- API कुंजियों को सुरक्षित रूप से संग्रहीत करें और उन्हें वर्जन कंट्रोल में कमिट न करें

- सुसंगत अनुवादों के लिए रूढ़िवादी तापमान सेटिंग्स (0.3) से शुरुआत करें

- अपने API उपयोग और लागतों पर नज़र रखें

- बड़े अनुवाद रन से पहले छोटे बैचों के साथ परीक्षण करें

Ollama के लिए:

- पर्याप्त RAM सुनिश्चित करें (बड़े मॉडलों के लिए 8GB+ अनुशंसित)

- बेहतर मॉडल लोडिंग प्रदर्शन के लिए SSD स्टोरेज का उपयोग करें

- तेज़ अनुमान के लिए GPU त्वरण पर विचार करें

- उत्पादन अनुवादों के लिए इस पर भरोसा करने से पहले स्थानीय रूप से परीक्षण करें