ऑडियो प्रोसेसिंग गाइड

यह गाइड आपके लिप सिंक जनरेटरों को ऑडियो डेटा फीड करने के लिए विभिन्न ऑडियो इनपुट विधियों को सेट अप करने का तरीका कवर करती है। आगे बढ़ने से पहले सुनिश्चित करें कि आपने सेटअप गाइड पूरा कर लिया है।

ऑडियो इनपुट प्रोसेसिंग

आपको ऑडियो इनपुट को प्रोसेस करने की एक विधि सेट अप करने की आवश्यकता है। यह आपके ऑडियो स्रोत के आधार पर कई तरीकों से किया जा सकता है।

- माइक्रोफोन (रियल-टाइम)

- माइक्रोफोन (प्लेबैक)

- टेक्स्ट-टू-स्पीच (लोकल)

- Text-to-Speech (External APIs)

- ऑडियो फ़ाइल/बफ़र से

- स्ट्रीमिंग ऑडियो बफ़र

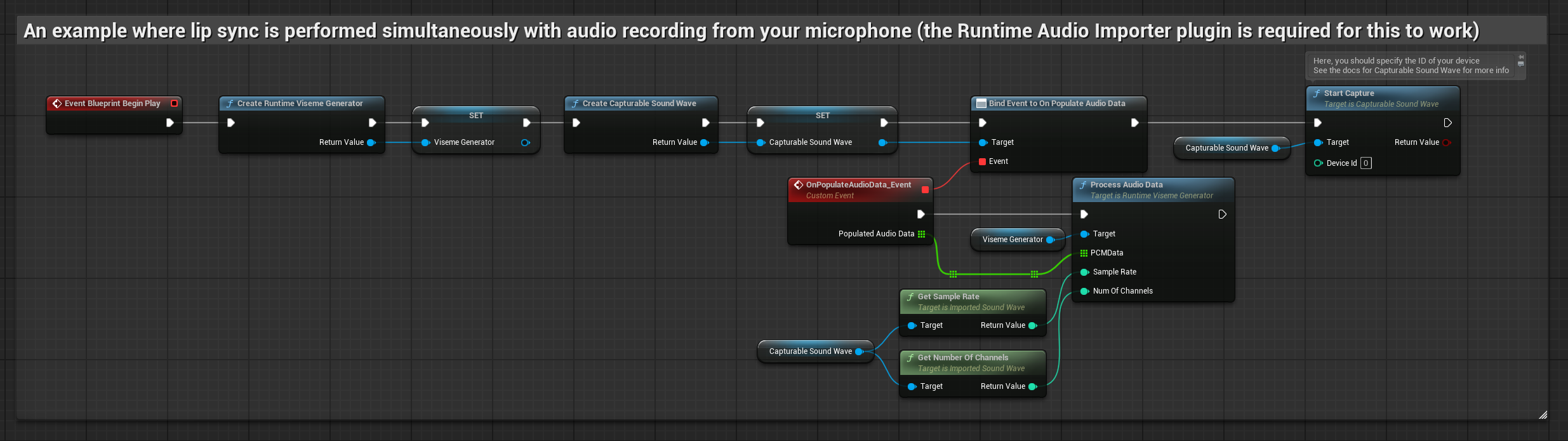

यह दृष्टिकोण माइक्रोफोन में बोलते समय रियल-टाइम में लिप सिंक करता है:

- स्टैंडर्ड मॉडल

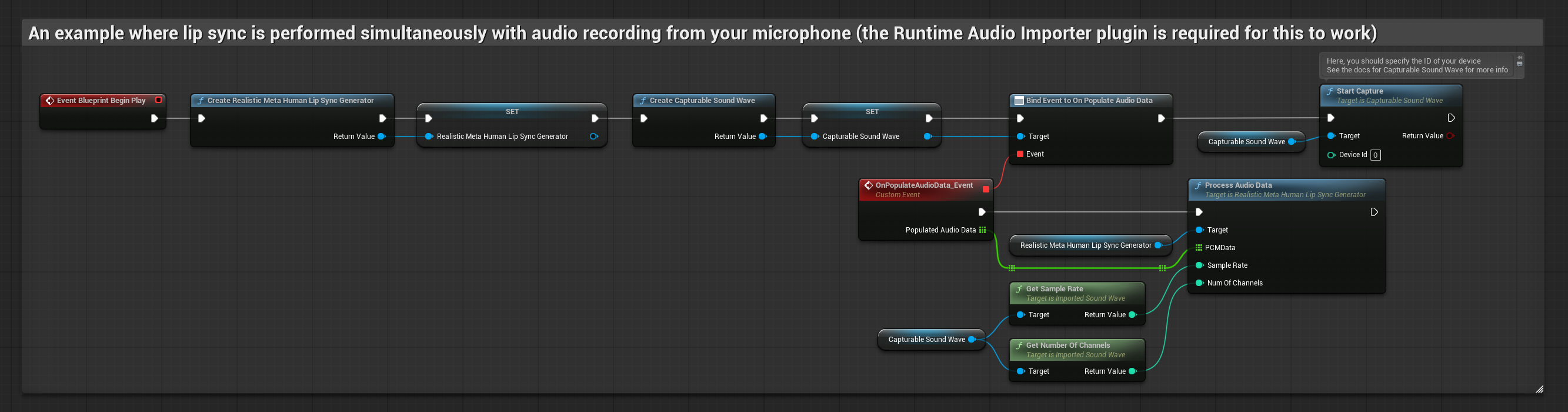

- यथार्थवादी मॉडल

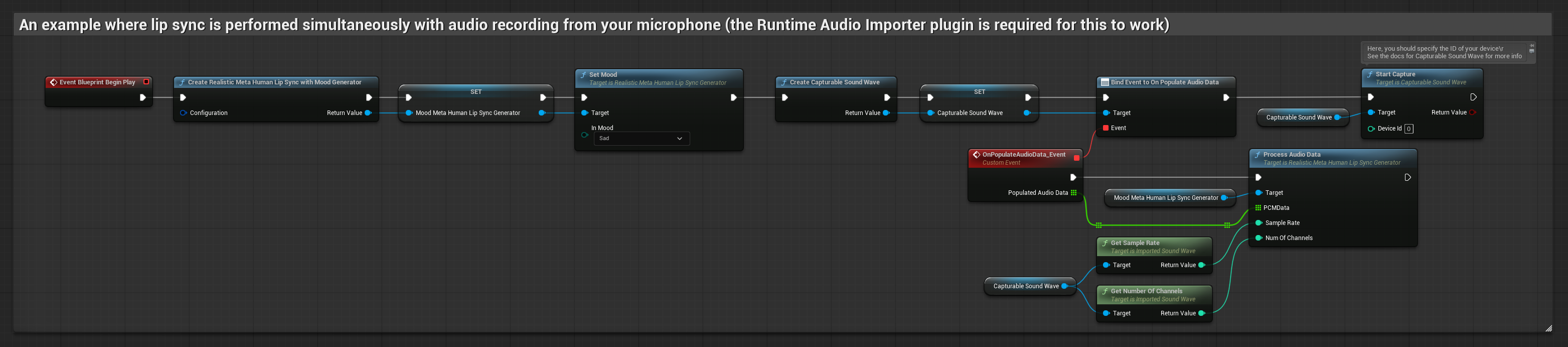

- मूड-सक्षम यथार्थवादी मॉडल

- Runtime Audio Importer का उपयोग करके एक Capturable Sound Wave बनाएं

- Pixel Streaming के साथ Linux के लिए, इसके बजाय Pixel Streaming Capturable Sound Wave का उपयोग करें

- ऑडियो कैप्चर करना शुरू करने से पहले,

OnPopulateAudioDataडेलीगेट से बाइंड करें - बाउंड फ़ंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें - माइक्रोफोन से ऑडियो कैप्चर करना शुरू करें

यथार्थवादी मॉडल स्टैंडर्ड मॉडल के समान ही ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator वेरिएबल के साथ।

मूड-सक्षम मॉडल समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator वेरिएबल और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

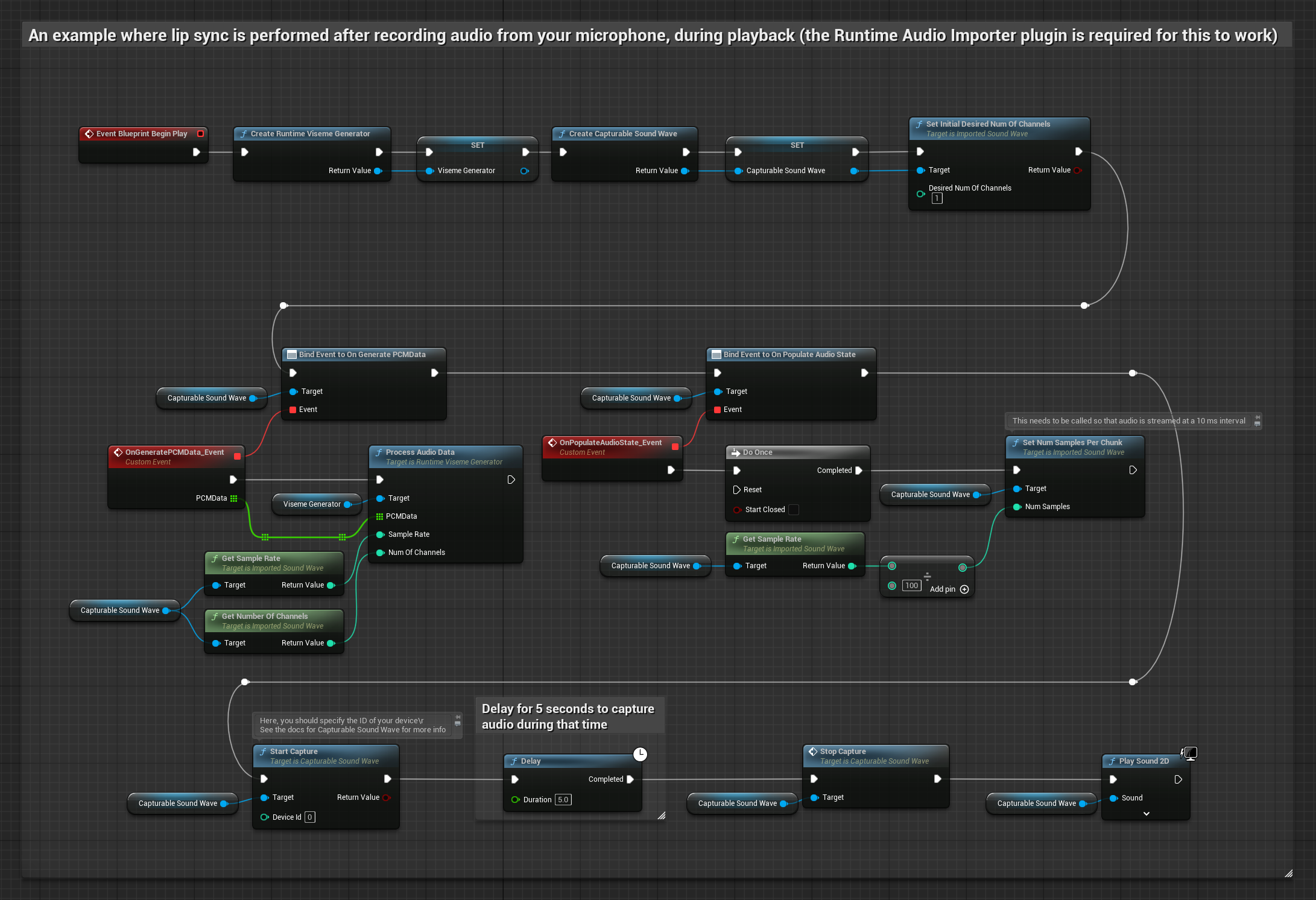

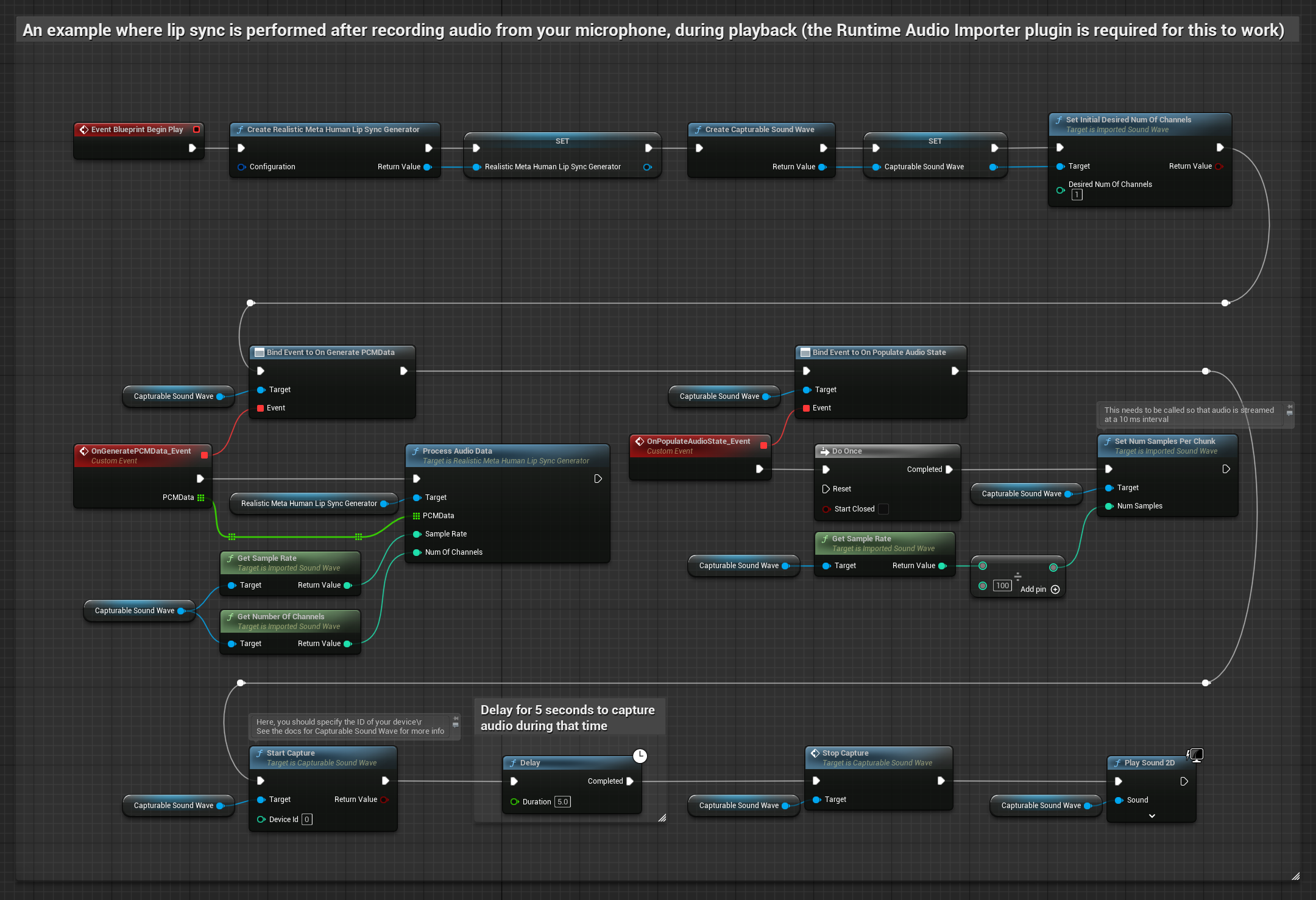

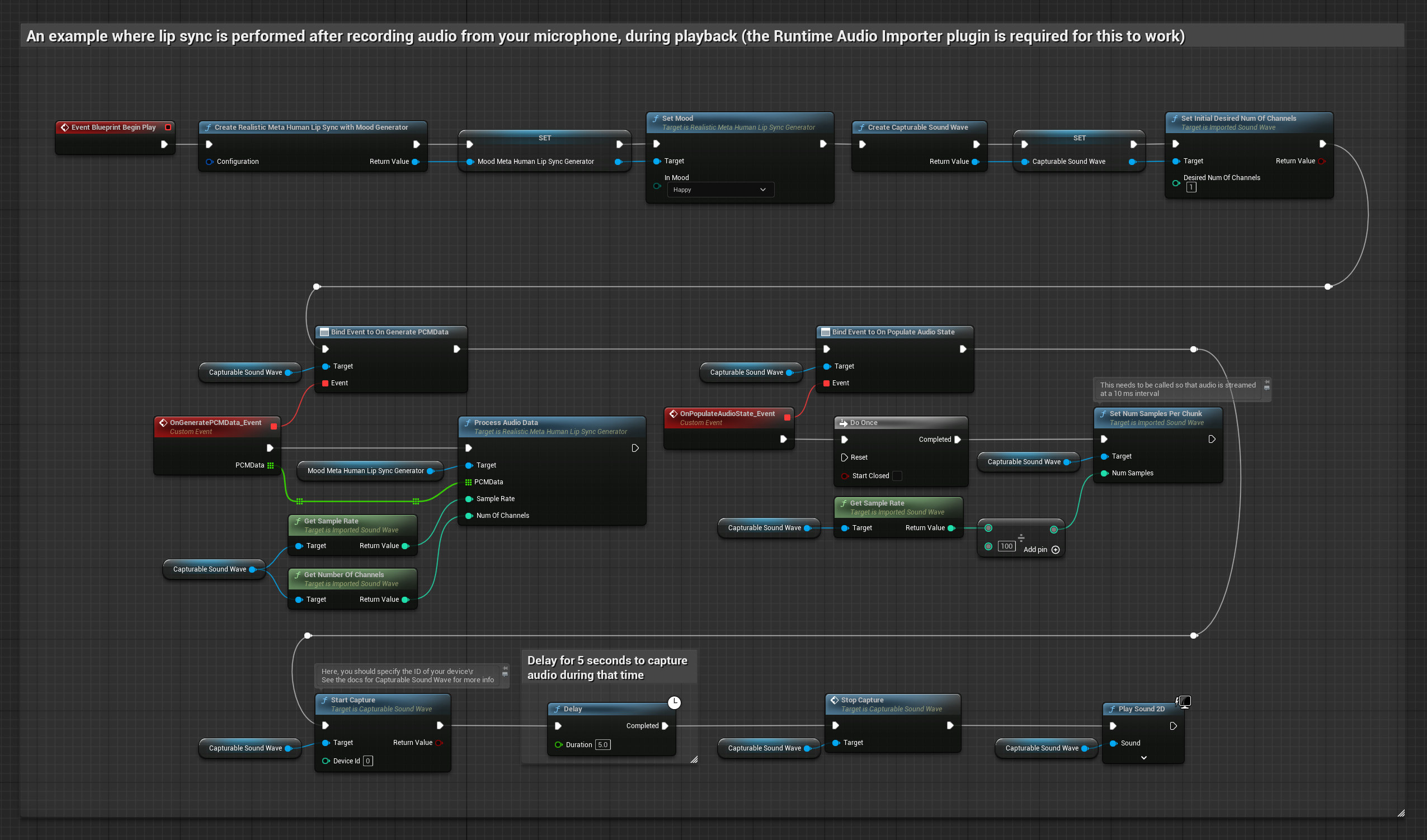

यह दृष्टिकोण माइक्रोफोन से ऑडियो कैप्चर करता है, फिर उसे लिप सिंक के साथ प्लेबैक करता है:

- स्टैंडर्ड मॉडल

- यथार्थवादी मॉडल

- मूड-सक्षम यथार्थवादी मॉडल

- Runtime Audio Importer का उपयोग करके एक Capturable Sound Wave बनाएं

- Pixel Streaming के साथ Linux के लिए, इसके बजाय Pixel Streaming Capturable Sound Wave का उपयोग करें

- माइक्रोफोन से ऑडियो कैप्चर शुरू करें

- कैप्चर करने योग्य साउंड वेव को प्लेबैक करने से पहले, इसके

OnGeneratePCMDataडेलीगेट से बाइंड करें - बाउंड फ़ंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें

यथार्थवादी मॉडल स्टैंडर्ड मॉडल के समान ही ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator वेरिएबल के साथ।

मूड-सक्षम मॉडल समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator वेरिएबल और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

- नियमित

- Streaming

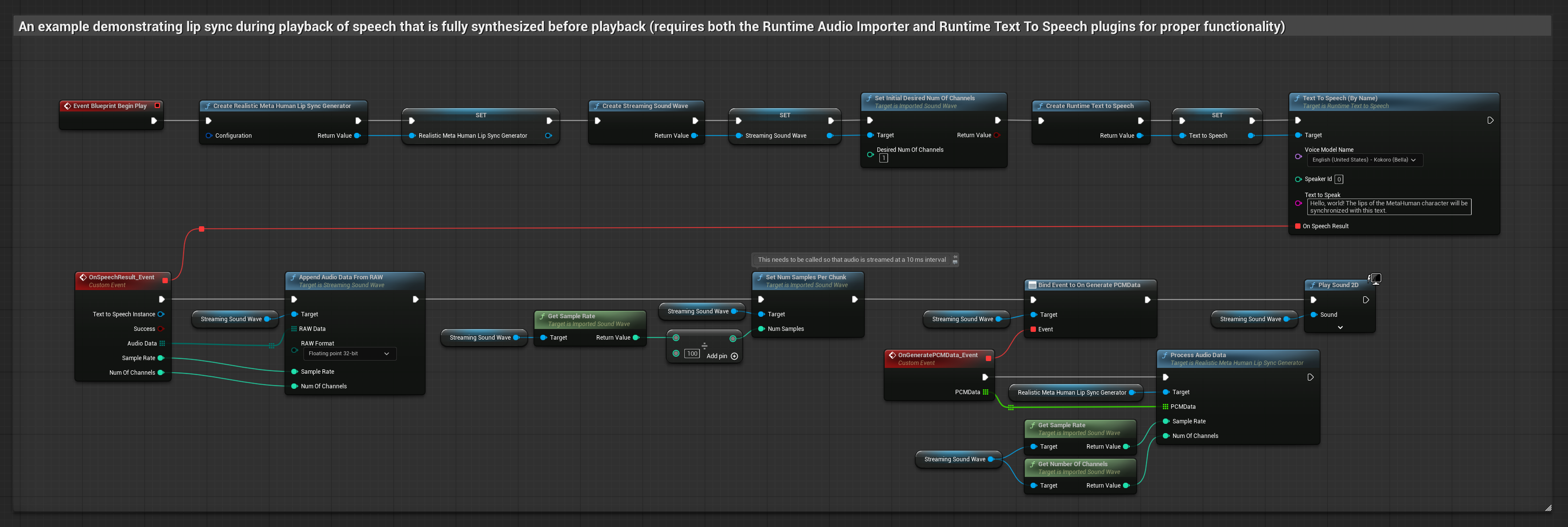

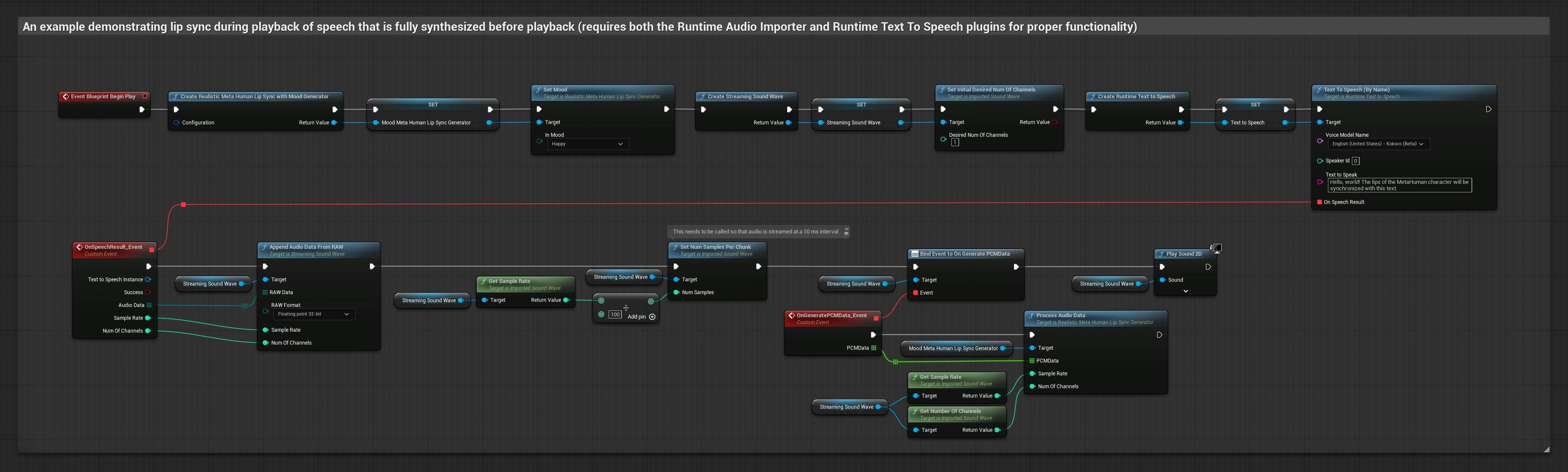

यह दृष्टिकोण लोकल TTS का उपयोग करके टेक्स्ट से स्पीच सिंथेसाइज़ करता है और लिप सिंक करता है:

- स्टैंडर्ड मॉडल

- Realistic Model

- Mood-Enabled Realistic Model

- टेक्स्ट से स्पीच जनरेट करने के लिए Runtime Text To Speech का उपयोग करें

- सिंथेसाइज़ किए गए ऑडियो को इम्पोर्ट करने के लिए Runtime Audio Importer का उपयोग करें

- इम्पोर्ट की गई साउंड वेव को प्लेबैक करने से पहले, इसके

OnGeneratePCMDataडेलीगेट से बाइंड करें - बाउंड फ़ंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें

Realistic Model, Standard Model के समान ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator चर के साथ।

Mood-Enabled Model समान ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator चर और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

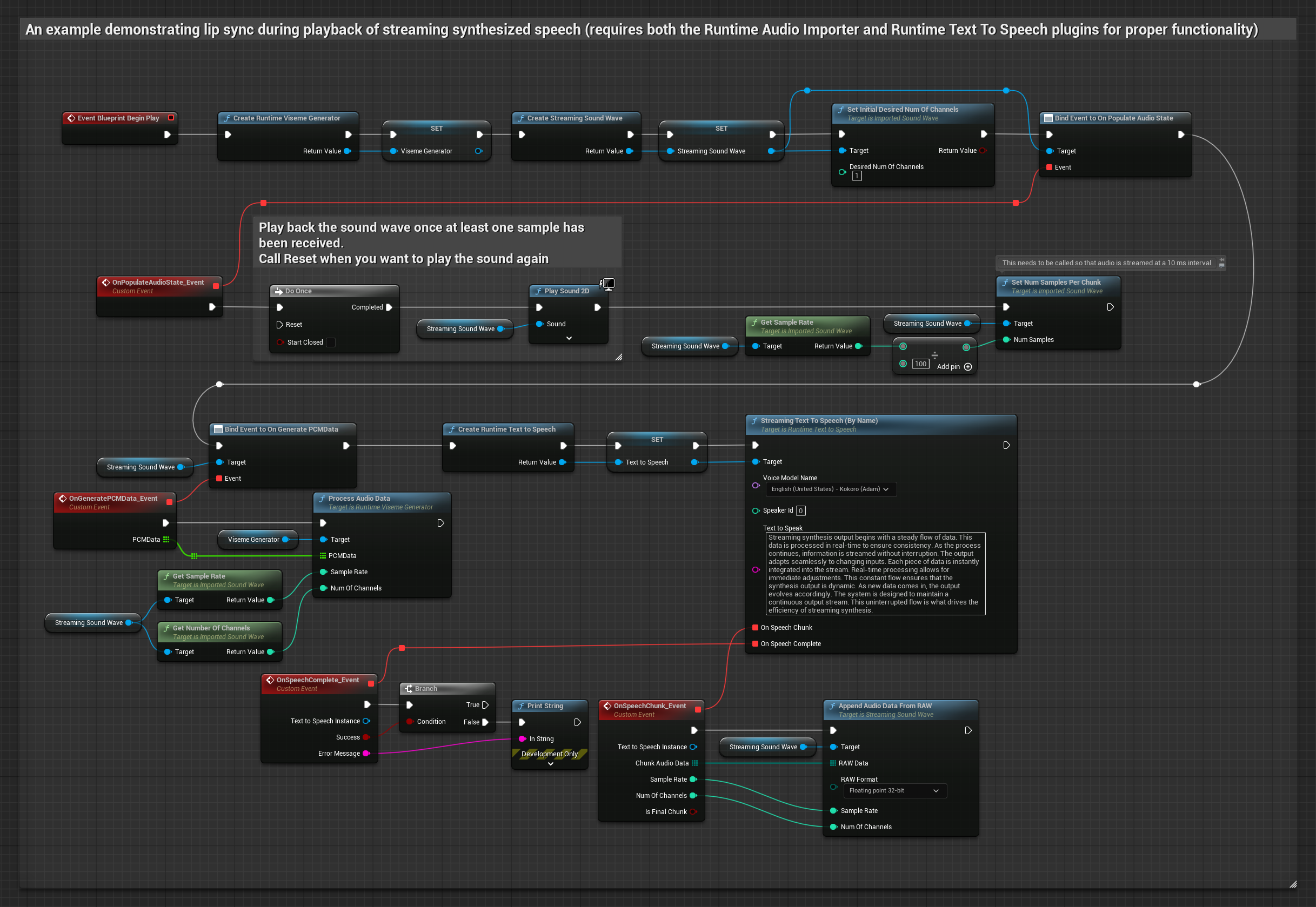

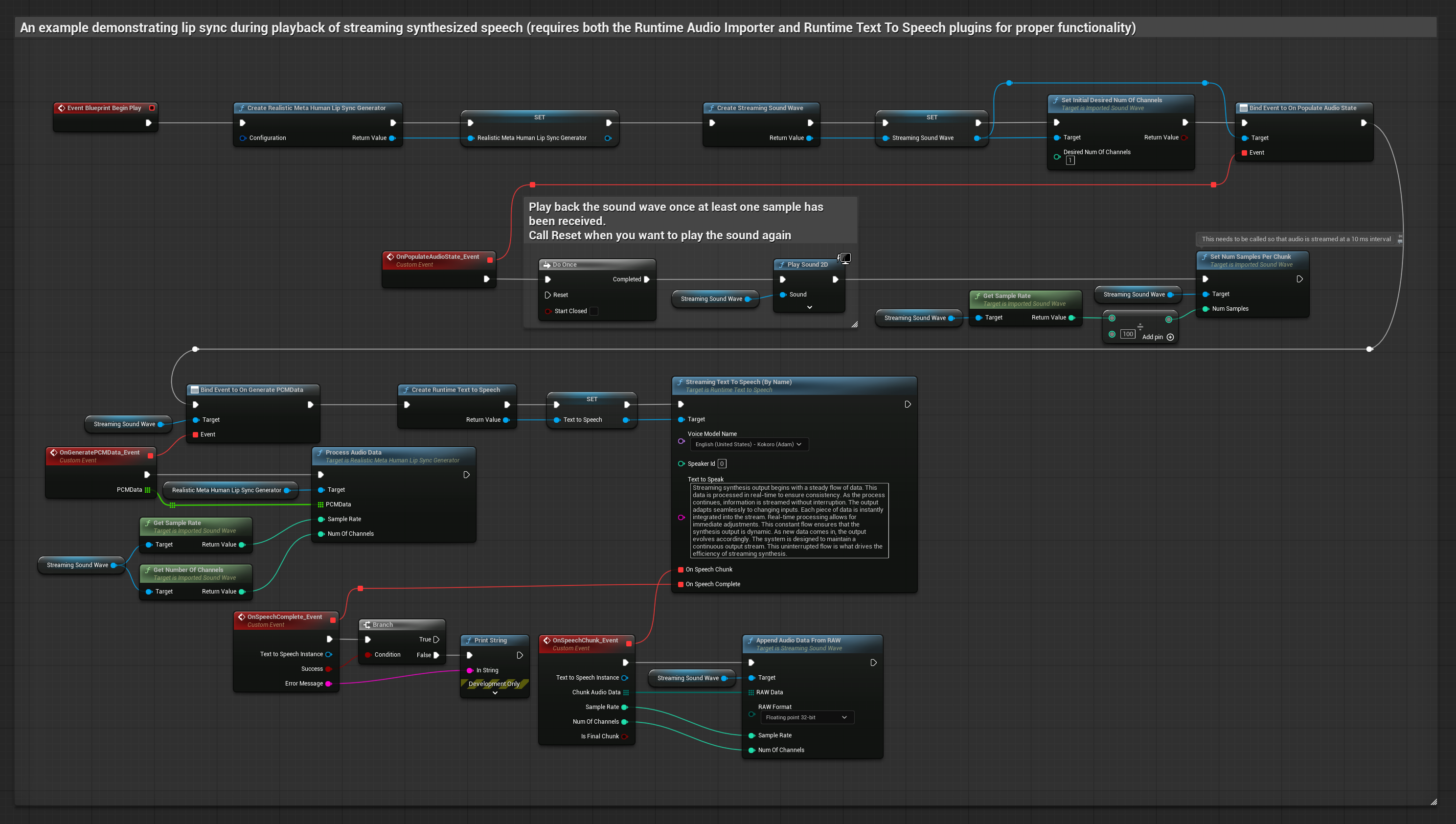

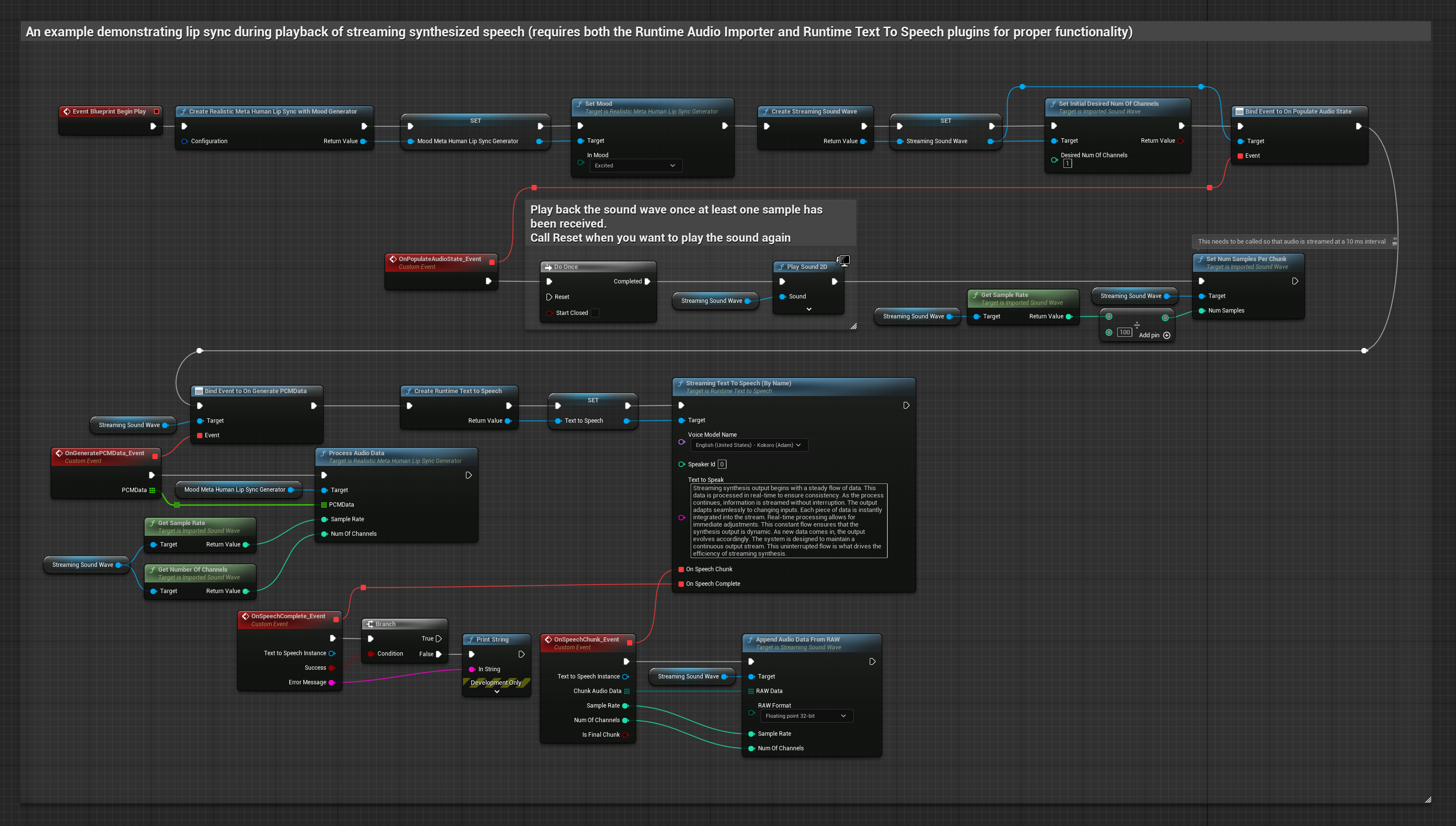

यह दृष्टिकोण रीयल-टाइम लिप सिंक के साथ स्ट्रीमिंग टेक्स्ट-टू-स्पीच सिंथेसिस का उपयोग करता है:

- Standard Model

- Realistic Model

- Mood-Enabled Realistic Model

- टेक्स्ट से स्ट्रीमिंग स्पीच जनरेट करने के लिए Runtime Text To Speech का उपयोग करें

- सिंथेसाइज़्ड ऑडियो को इम्पोर्ट करने के लिए Runtime Audio Importer का उपयोग करें

- स्ट्रीमिंग साउंड वेव को प्लेबैक करने से पहले, इसके

OnGeneratePCMDataडेलिगेट से बाइंड करें - बाउंड फ़ंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें

Realistic Model, Standard Model के समान ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator चर के साथ।

Mood-Enabled Model समान ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator चर और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

- Regular

- स्ट्रीमिंग

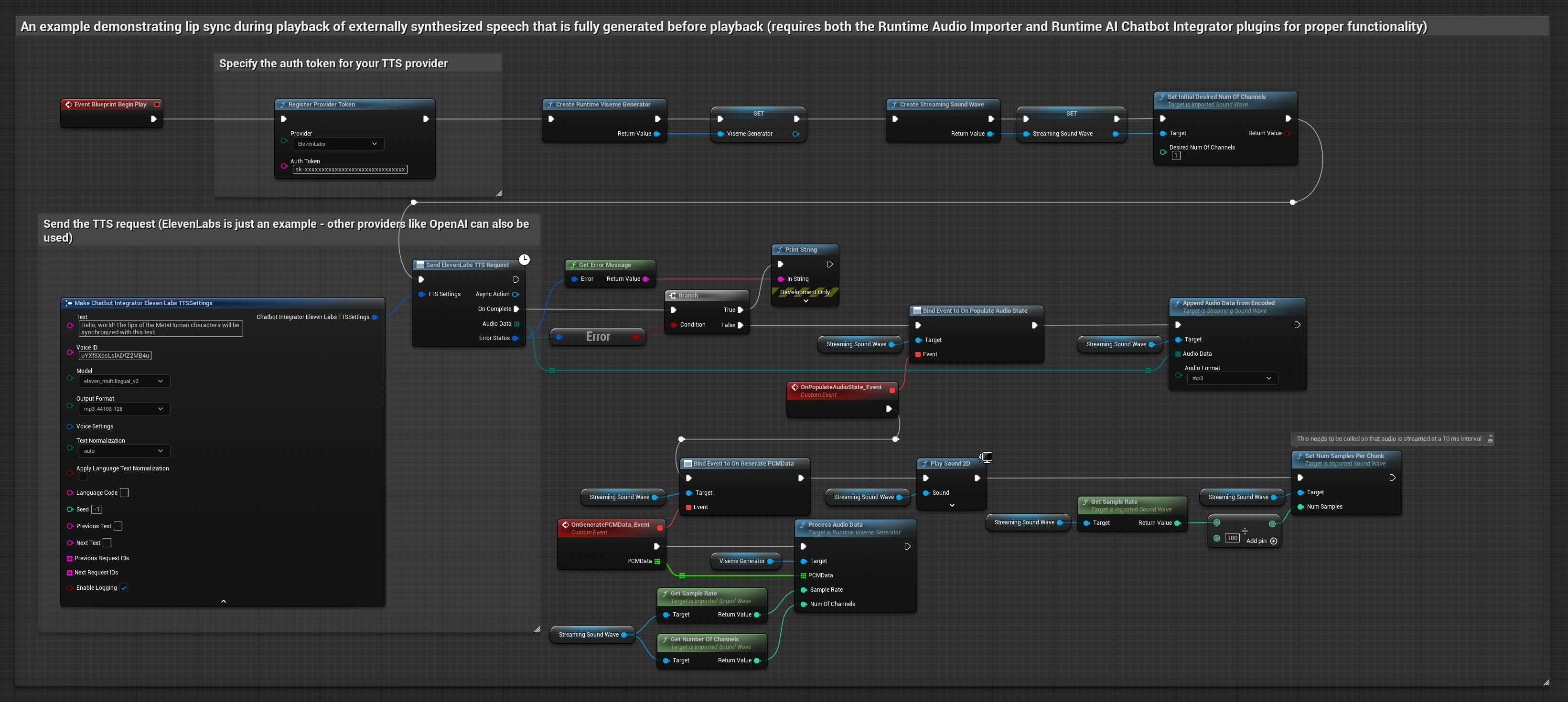

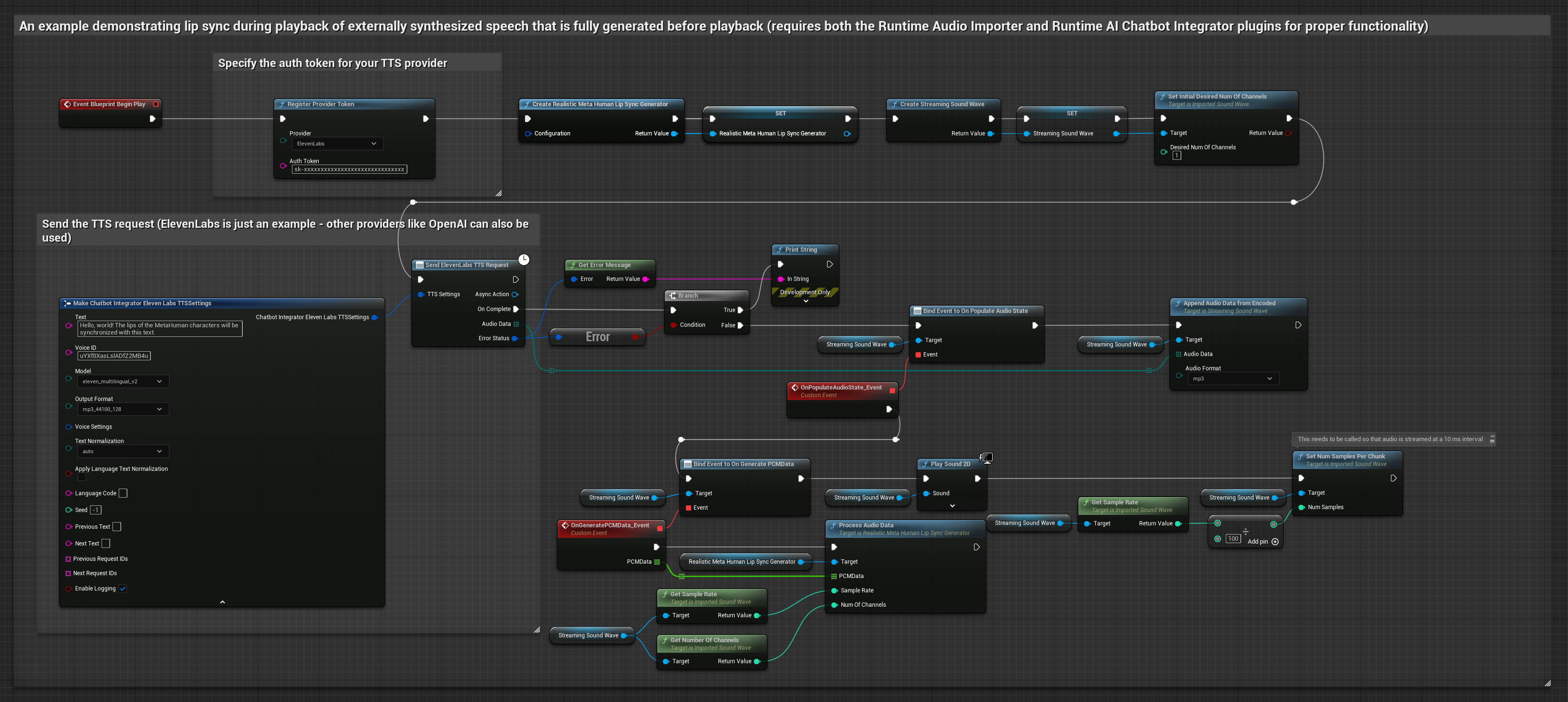

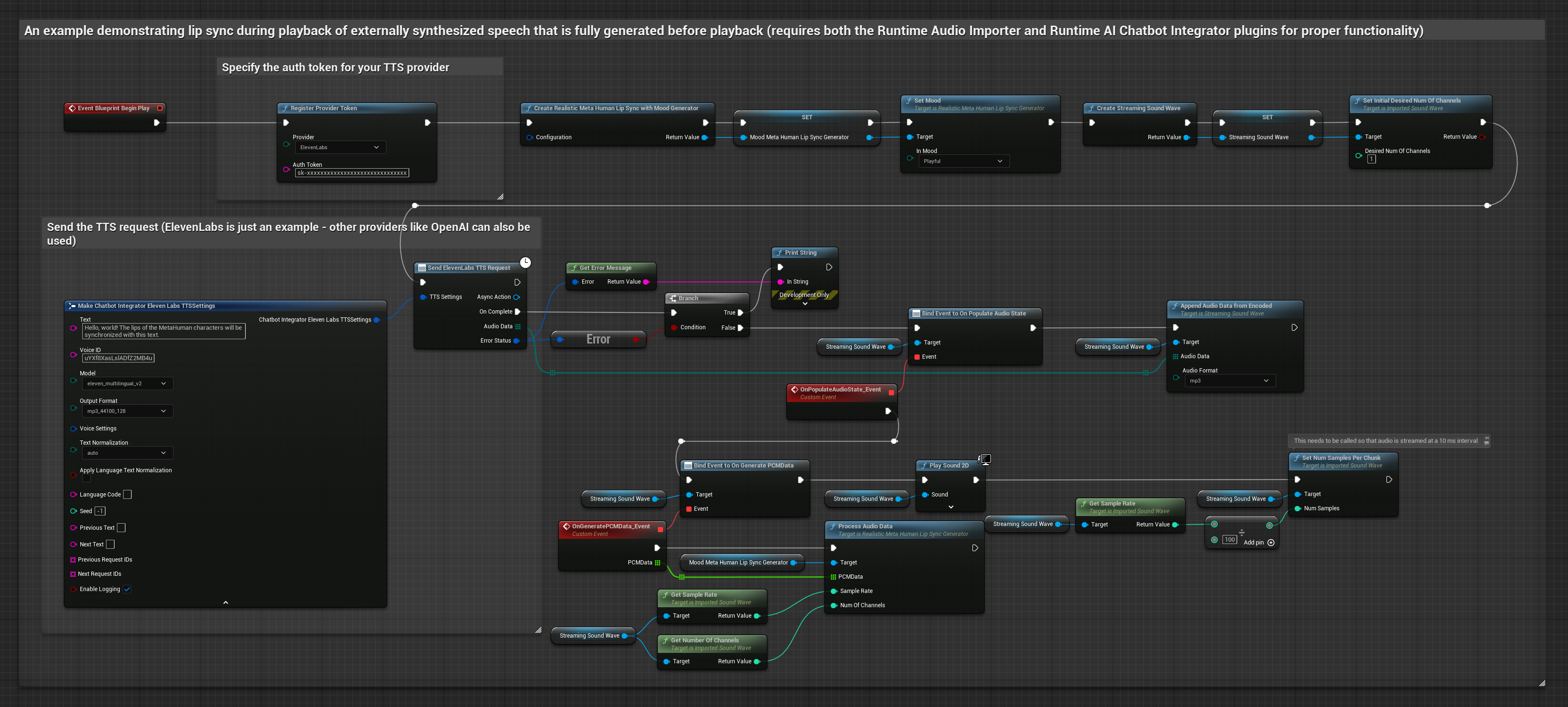

यह दृष्टिकोण AI सेवाओं (OpenAI या ElevenLabs) से सिंथेसाइज़्ड स्पीच जनरेट करने और लिप सिंक करने के लिए Runtime AI Chatbot Integrator प्लगइन का उपयोग करता है:

- Standard Model

- Realistic Model

- Mood-Enabled Realistic Model

- बाहरी APIs (OpenAI, ElevenLabs, आदि) का उपयोग करके टेक्स्ट से स्पीच जनरेट करने के लिए Runtime AI Chatbot Integrator का उपयोग करें

- सिंथेसाइज़्ड ऑडियो डेटा को इम्पोर्ट करने के लिए Runtime Audio Importer का उपयोग करें

- इम्पोर्ट की गई साउंड वेव को प्लेबैक करने से पहले, इसके

OnGeneratePCMDataडेलिगेट से बाइंड करें - बाउंड फ़ंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें

Realistic Model, Standard Model के समान ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator चर के साथ।

Mood-Enabled Model समान ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator चर और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

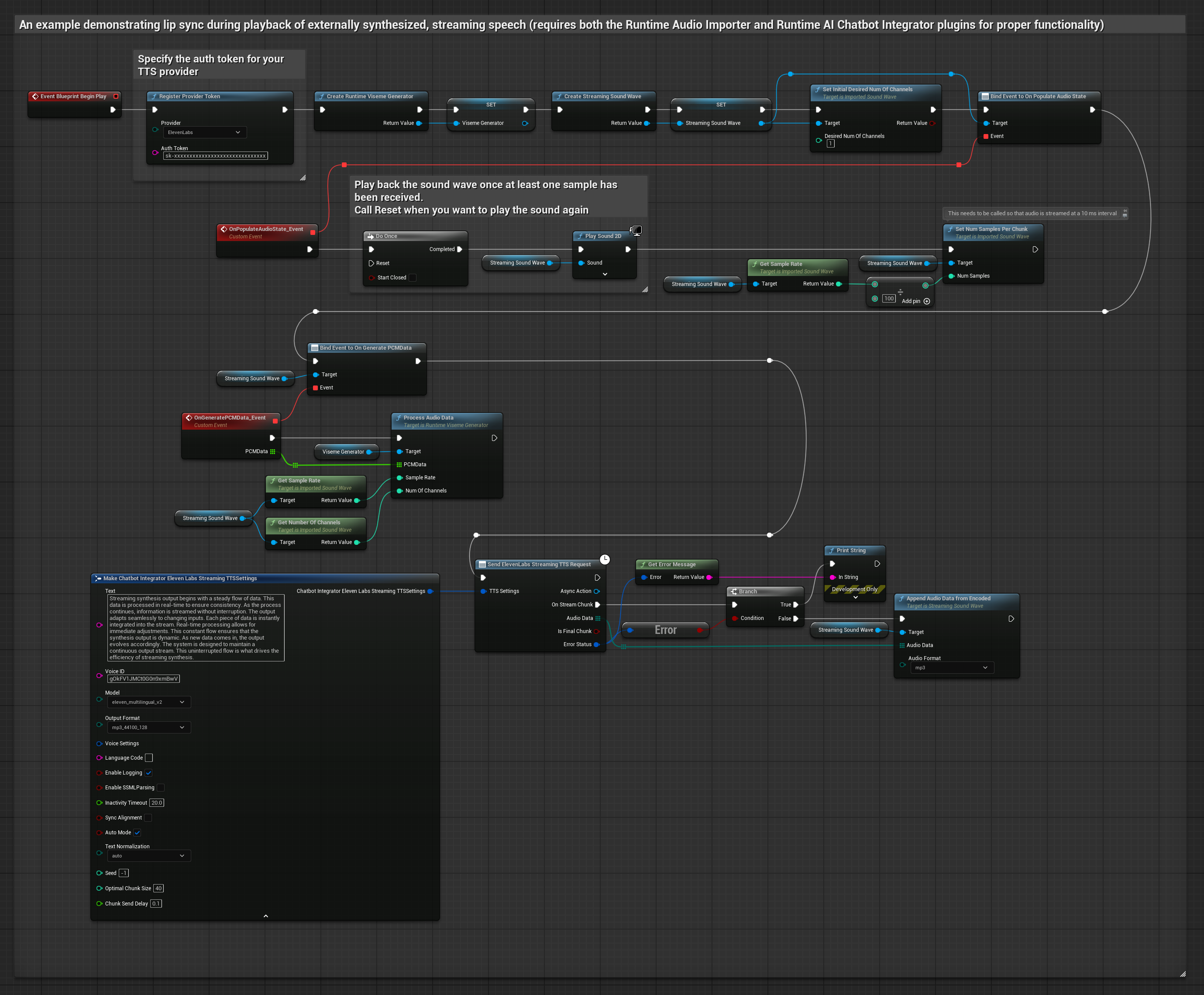

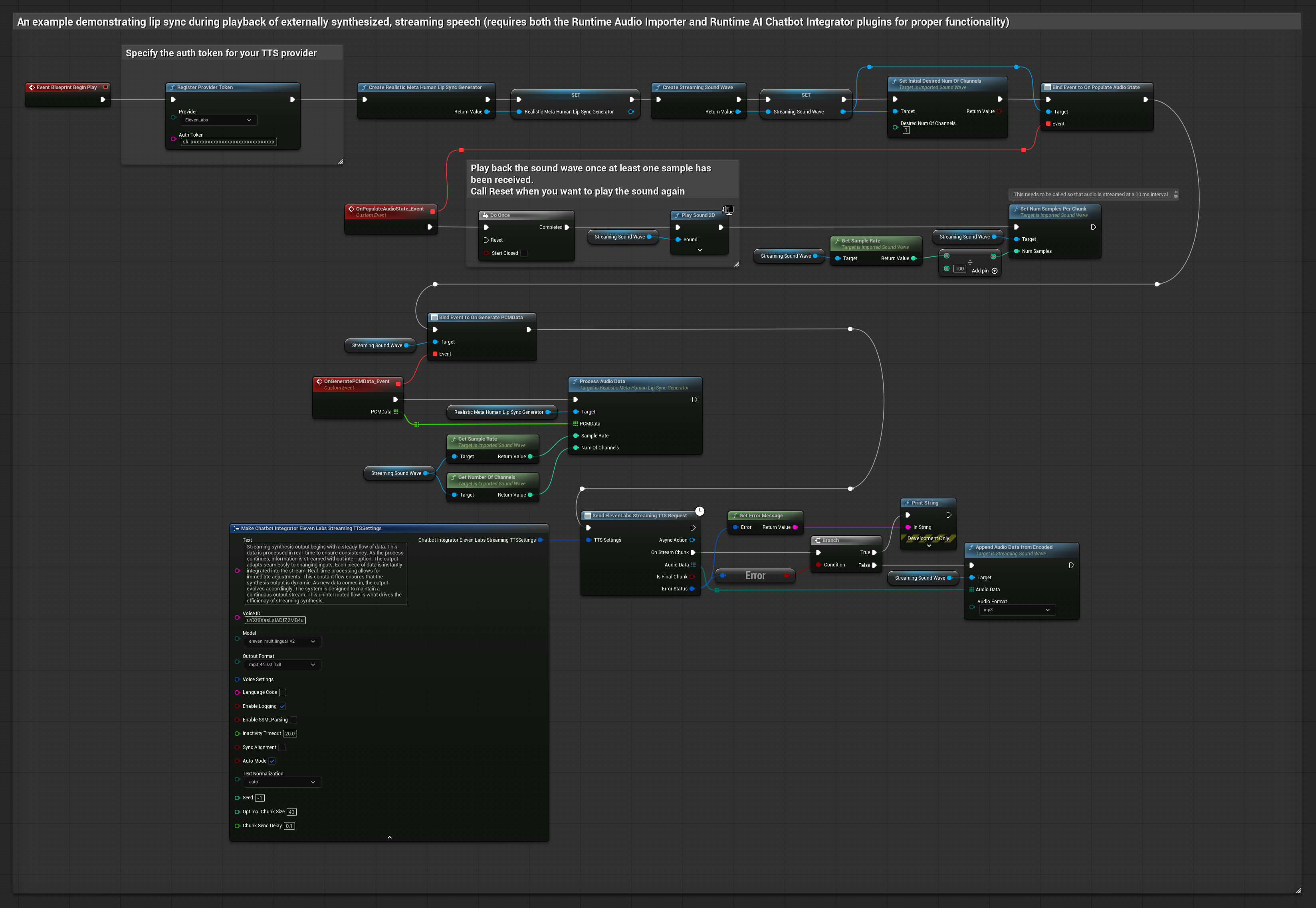

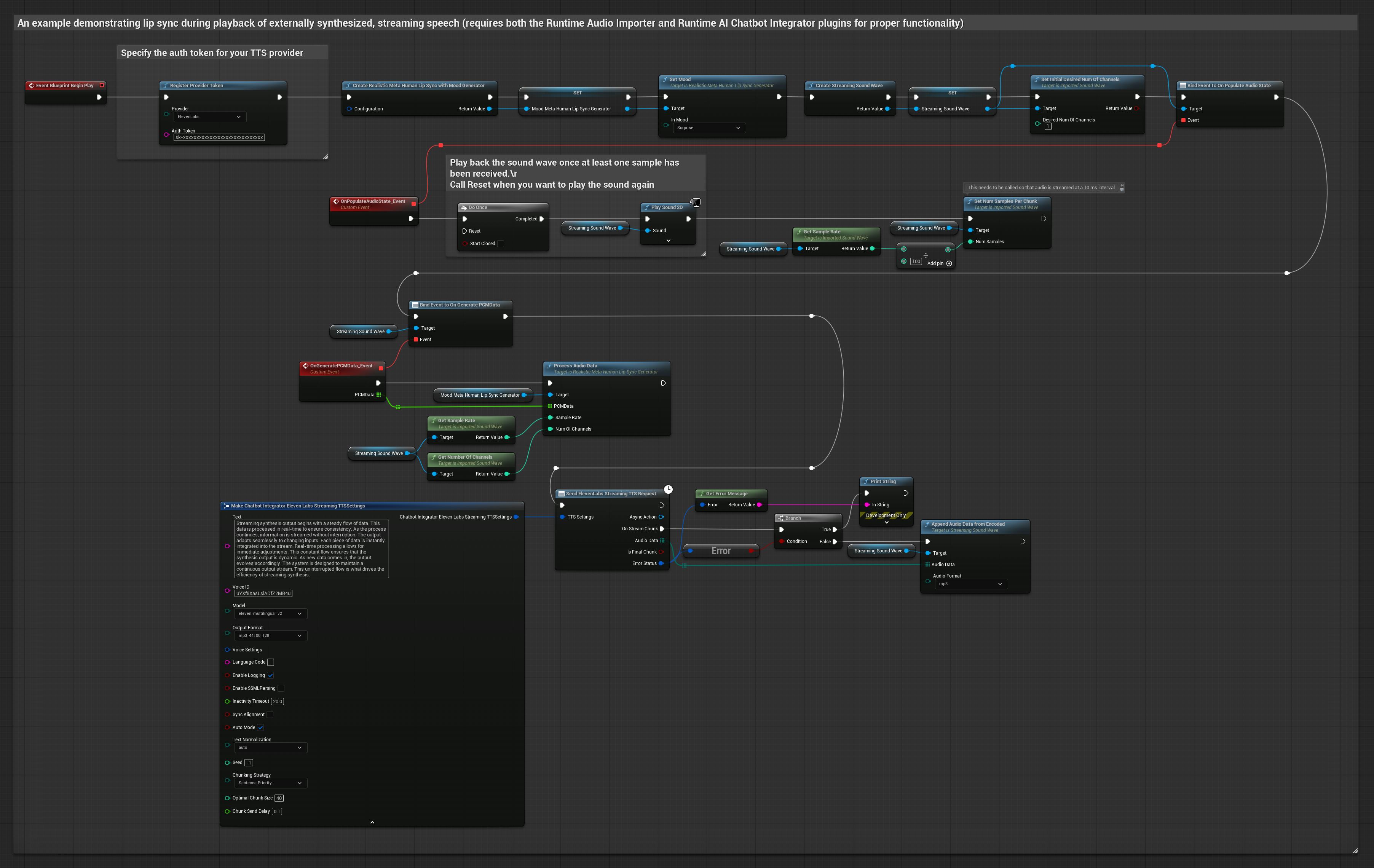

यह दृष्टिकोण सिंथेसाइज्ड स्ट्रीमिंग स्पीच को AI सेवाओं (OpenAI या ElevenLabs) से जनरेट करने और लिप सिंक करने के लिए Runtime AI Chatbot Integrator प्लगइन का उपयोग करता है:

- स्टैंडर्ड मॉडल

- रियलिस्टिक मॉडल

- मूड-एनेबल्ड रियलिस्टिक मॉडल

- स्ट्रीमिंग TTS APIs (जैसे ElevenLabs Streaming API) से कनेक्ट करने के लिए Runtime AI Chatbot Integrator का उपयोग करें

- सिंथेसाइज्ड ऑडियो डेटा को इम्पोर्ट करने के लिए Runtime Audio Importer का उपयोग करें

- स्ट्रीमिंग साउंड वेव को प्लेबैक करने से पहले, इसके

OnGeneratePCMDataडेलिगेट से बाइंड करें - बाउंड फंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें

रियलिस्टिक मॉडल स्टैंडर्ड मॉडल के समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator वेरिएबल के साथ।

मूड-एनेबल्ड मॉडल समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator वेरिएबल और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

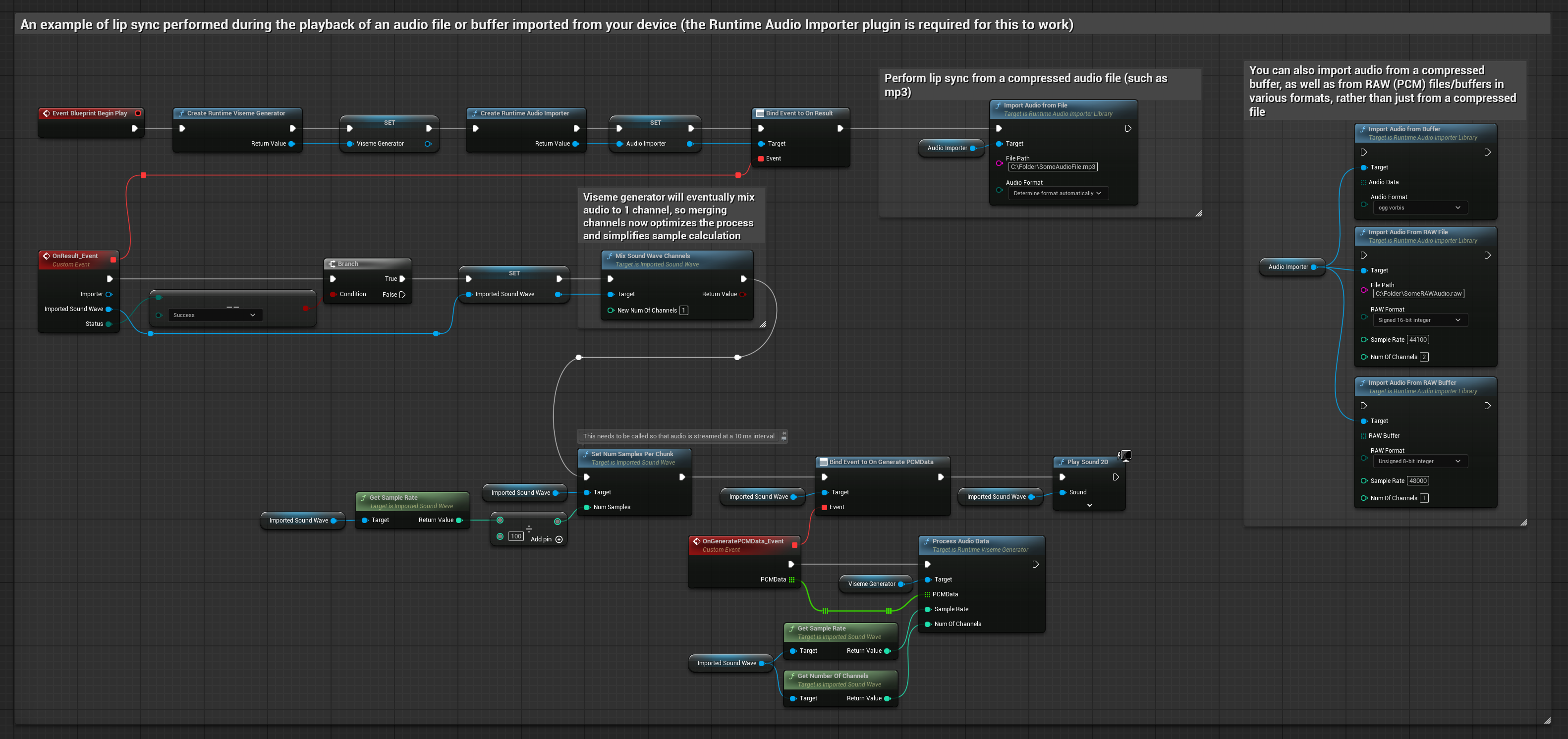

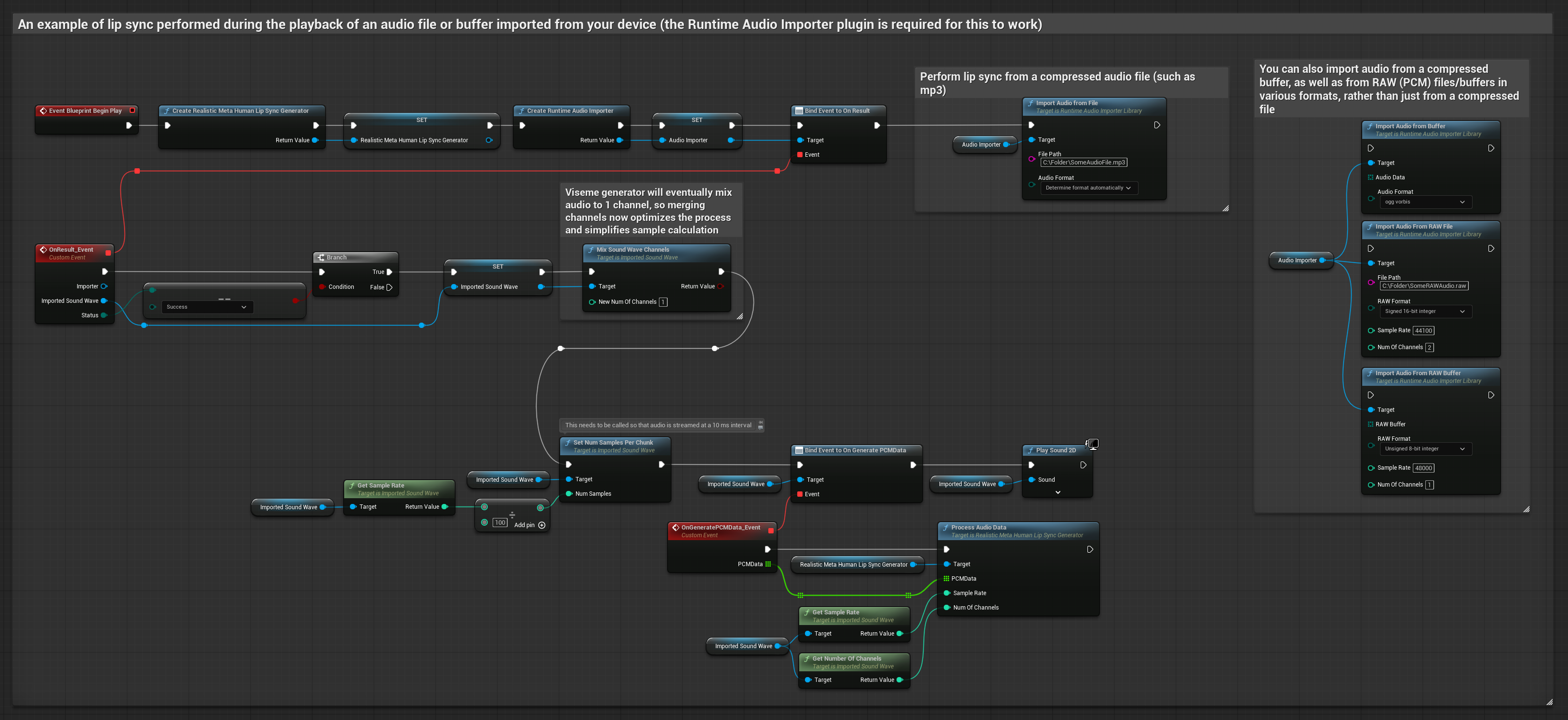

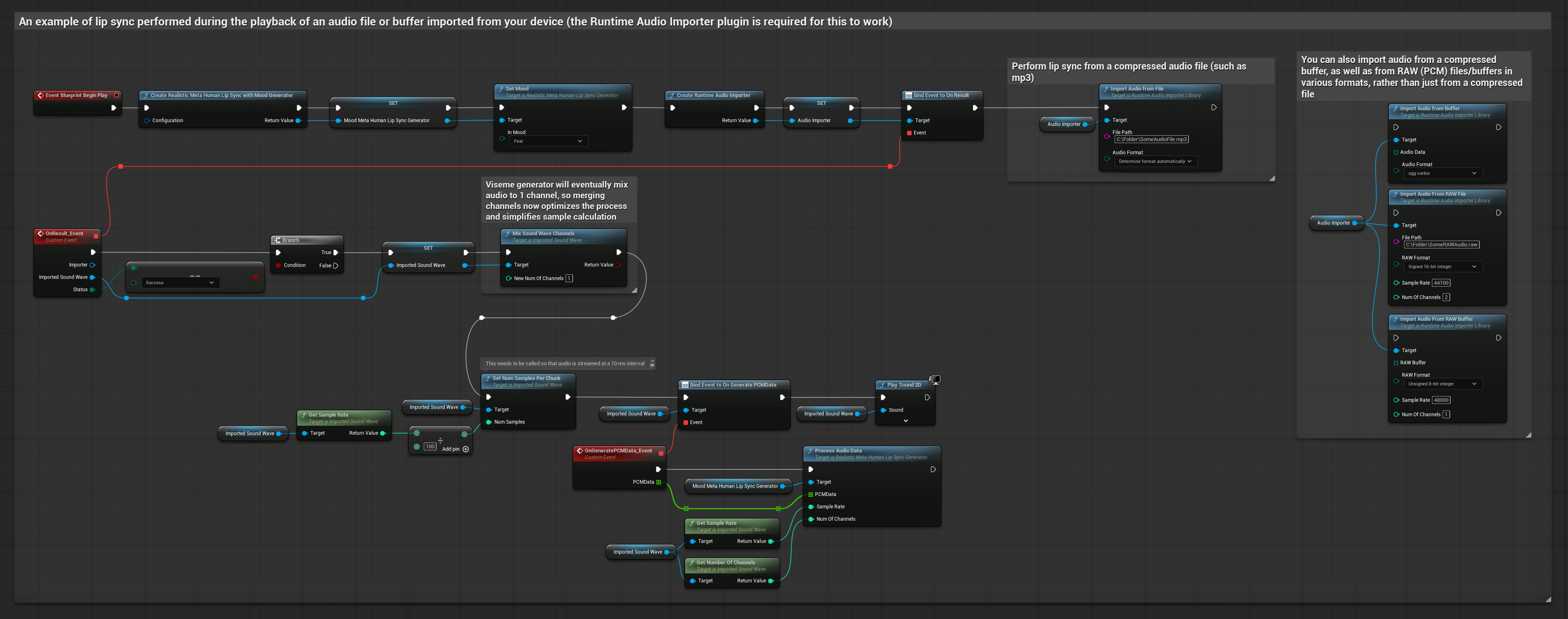

यह दृष्टिकोण लिप सिंक के लिए प्री-रिकॉर्डेड ऑडियो फ़ाइलों या ऑडियो बफ़र्स का उपयोग करता है:

- स्टैंडर्ड मॉडल

- रियलिस्टिक मॉडल

- मूड-एनेबल्ड रियलिस्टिक मॉडल

- डिस्क या मेमोरी से एक ऑडियो फ़ाइल इम्पोर्ट करने के लिए Runtime Audio Importer का उपयोग करें

- इम्पोर्ट की गई साउंड वेव को प्लेबैक करने से पहले, इसके

OnGeneratePCMDataडेलिगेट से बाइंड करें - बाउंड फंक्शन में, अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें - इम्पोर्ट की गई साउंड वेव को प्ले करें और लिप सिंक एनीमेशन देखें

रियलिस्टिक मॉडल स्टैंडर्ड मॉडल के समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator वेरिएबल के साथ।

मूड-एनेबल्ड मॉडल समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator वेरिएबल और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

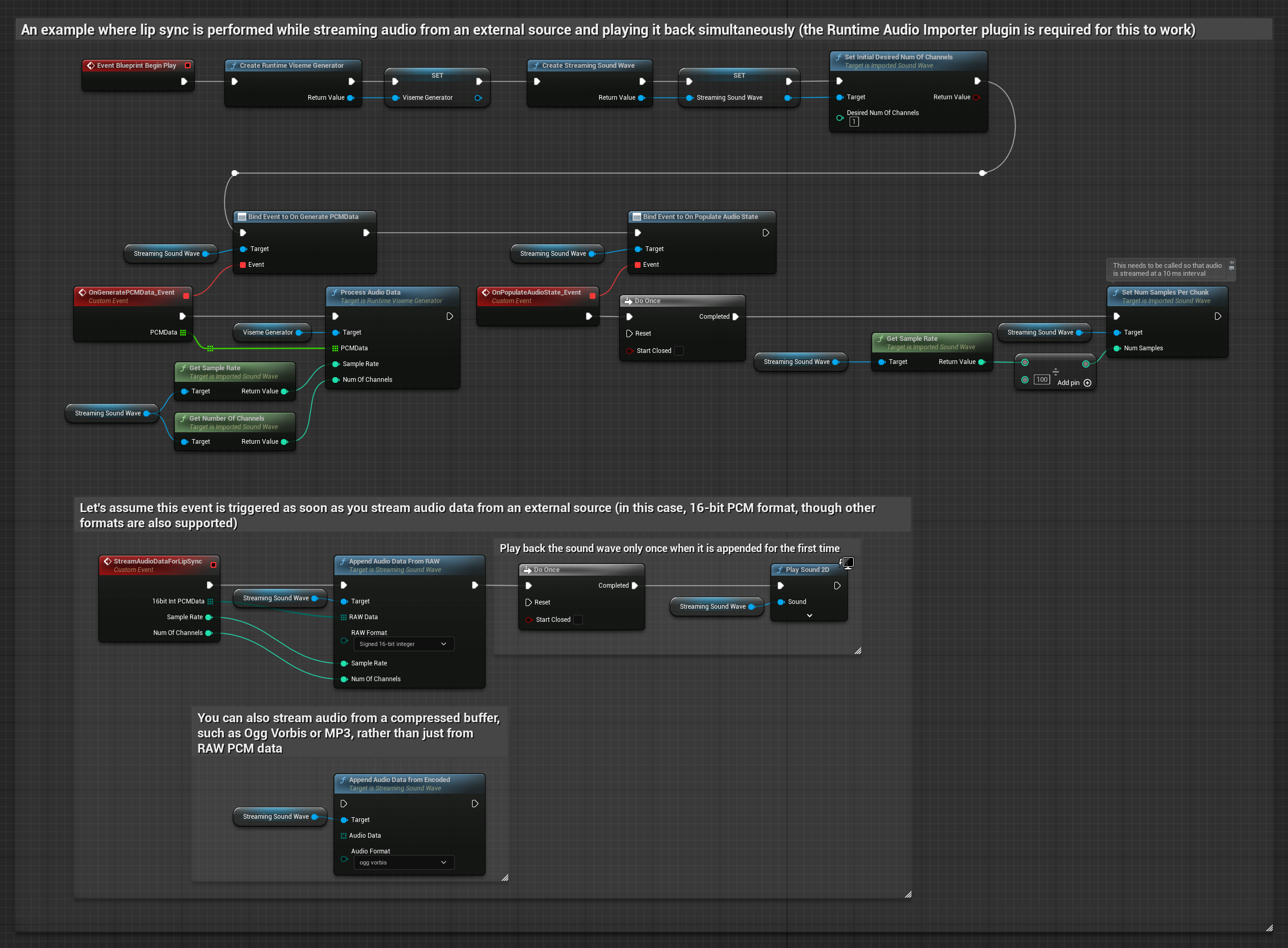

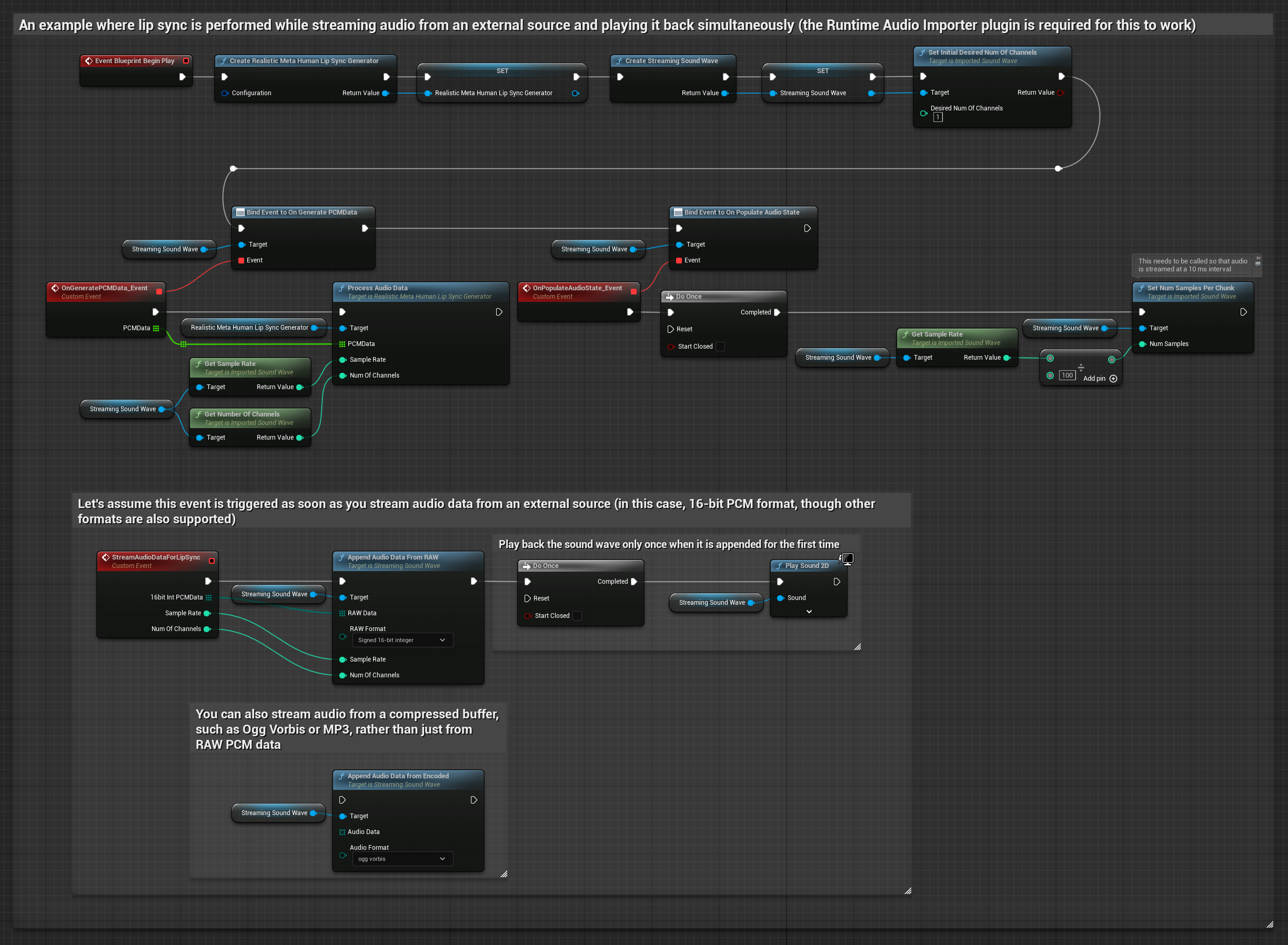

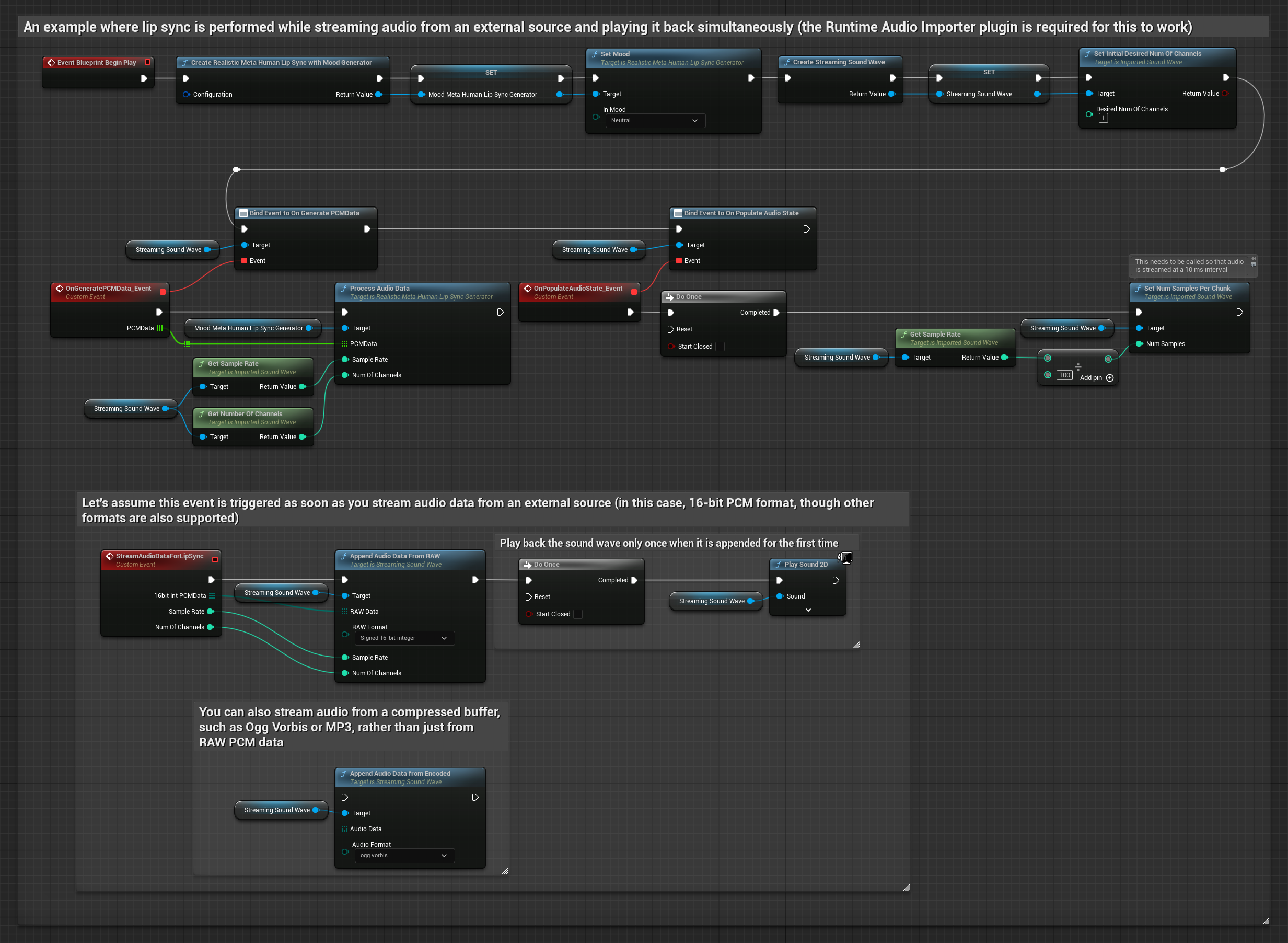

स्ट्रीमिंग ऑडियो डेटा के लिए, आपको चाहिए:

- स्टैंडर्ड मॉडल

- रियलिस्टिक मॉडल

- Mood-Enabled Realistic Model

- फ्लोट PCM फॉर्मेट में ऑडियो डेटा (फ्लोटिंग-पॉइंट सैंपल्स की एक ऐरे) आपके स्ट्रीमिंग स्रोत से उपलब्ध (या अधिक फॉर्मेट्स को सपोर्ट करने के लिए Runtime Audio Importer का उपयोग करें)

- सैंपल रेट और चैनलों की संख्या

- जैसे ही ऑडियो चंक्स उपलब्ध होते हैं, इन पैरामीटर्स के साथ अपने Runtime Viseme Generator से

ProcessAudioDataको कॉल करें

रियलिस्टिक मॉडल स्टैंडर्ड मॉडल के समान ऑडियो प्रोसेसिंग वर्कफ़्लो का उपयोग करता है, लेकिन VisemeGenerator के बजाय RealisticLipSyncGenerator वेरिएबल के साथ।

मूड-सक्षम मॉडल एक ही ऑडियो प्रसंस्करण वर्कफ़्लो का उपयोग करता है, लेकिन MoodMetaHumanLipSyncGenerator वेरिएबल और अतिरिक्त मूड कॉन्फ़िगरेशन क्षमताओं के साथ।

नोट: स्ट्रीमिंग ऑडियो स्रोतों का उपयोग करते समय, विकृत प्लेबैक से बचने के लिए ऑडियो प्लेबैक टाइमिंग का उचित प्रबंधन सुनिश्चित करें। अधिक जानकारी के लिए स्ट्रीमिंग साउंड वेव दस्तावेज़ीकरण देखें।

प्रसंस्करण प्रदर्शन युक्तियाँ

-

चंक आकार: यदि आप अधिक उत्तरदायी लिप सिंक के लिए छोटे चंक में ऑडियो डेटा प्रोसेस करना चाहते हैं, तो

SetNumSamplesPerChunkफ़ंक्शन में गणना समायोजित करें। उदाहरण के लिए, सैंपल रेट को 100 (हर 10 ms पर स्ट्रीमिंग) के बजाय 150 से विभाजित करने पर (हर ~6.67 ms पर स्ट्रीमिंग) अधिक बार लिप सिंक अपडेट प्रदान करेगा। -

बफ़र प्रबंधन: मूड-सक्षम मॉडल ऑडियो को 320-सैंपल फ़्रेम (16kHz पर 20ms) में प्रोसेस करता है। इष्टतम प्रदर्शन के लिए सुनिश्चित करें कि आपका ऑडियो इनपुट टाइमिंग इसके साथ संरेखित हो।

-

जनरेटर पुनर्निर्माण: रियलिस्टिक मॉडल के साथ विश्वसनीय संचालन के लिए, निष्क्रियता की अवधि के बाद नए ऑडियो डेटा को फ़ीड करना चाहते हैं तो हर बार जनरेटर को फिर से बनाएँ।

अगले कदम

एक बार जब आपके पास ऑडियो प्रसंस्करण सेटअप हो जाए, तो आप चाह सकते हैं:

- अपने लिप सिंक व्यवहार को ठीक-ट्यून करने के लिए कॉन्फ़िगरेशन विकल्पों के बारे में जानें

- बढ़ी हुई अभिव्यक्ति के लिए हँसी एनीमेशन जोड़ें

- कॉन्फ़िगरेशन गाइड में वर्णित लेयरिंग तकनीकों का उपयोग करके मौजूदा चेहरे के एनीमेशन के साथ लिप सिंक को संयोजित करें