Fornitori di Traduzione

L'AI Localization Automator supporta cinque diversi fornitori di intelligenza artificiale, ognuno con punti di forza e opzioni di configurazione unici. Scegli il fornitore che meglio si adatta alle esigenze, al budget e ai requisiti di qualità del tuo progetto.

Ollama (AI Locale)

Ideale per: Progetti sensibili alla privacy, traduzione offline, utilizzo illimitato

Ollama esegue modelli di intelligenza artificiale localmente sulla tua macchina, fornendo privacy e controllo completi senza costi API o requisiti di internet.

Modelli Popolari

- llama3.2 (Consigliato per uso generale)

- mistral (Alternativa efficiente)

- codellama (Traduzioni consapevoli del codice)

- E molti altri modelli della community

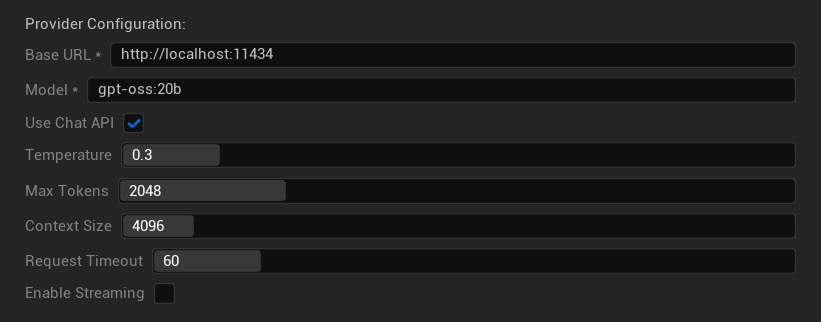

Opzioni di Configurazione

- URL Base: Server Ollama locale (predefinito:

http://localhost:11434) - Modello: Nome del modello installato localmente (richiesto)

- Usa Chat API: Abilita per una migliore gestione delle conversazioni

- Temperatura: 0.0-2.0 (0.3 consigliato)

- Token Massimi: 1-8.192 token

- Dimensione Contesto: 512-32.768 token

- Timeout Richiesta: 10-300 secondi (i modelli locali possono essere più lenti)

- Abilita Streaming: Per l'elaborazione delle risposte in tempo reale

Punti di Forza

- ✅ Privacy completa (nessun dato lascia la tua macchina)

- ✅ Nessun costo API o limite di utilizzo

- ✅ Funziona offline

- ✅ Controllo completo sui parametri del modello

- ✅ Ampia varietà di modelli della community

- ✅ Nessun vincolo di fornitore

Considerazioni

- 💻 Richiede configurazione locale e hardware capace

- ⚡ Generalmente più lento dei fornitori cloud

- 🔧 Configurazione più tecnica richiesta

- 📊 La qualità della traduzione varia significativamente in base al modello (alcuni possono superare i fornitori cloud)

- 💾 Grandi requisiti di archiviazione per i modelli

Configurare Ollama

- Installa Ollama: Scarica da ollama.ai e installa sul tuo sistema

- Scarica Modelli: Usa

ollama pull llama3.2per scaricare il modello scelto - Avvia Server: Ollama si avvia automaticamente, oppure avvia con

ollama serve - Configura Plugin: Imposta l'URL base e il nome del modello nelle impostazioni del plugin

- Test Connessione: Il plugin verificherà la connettività quando applichi la configurazione

OpenAI

Ideale per: Qualità complessiva di traduzione più alta, ampia selezione di modelli

OpenAI fornisce modelli linguistici all'avanguardia attraverso la loro API, inclusi gli ultimi modelli GPT e il nuovo formato Responses API.

Modelli Disponibili

- gpt-5 (Ultimo modello di punta)

- gpt-5-mini (Variante più piccola e veloce)

- gpt-4.1 e gpt-4.1-mini

- gpt-4o e gpt-4o-mini (Modelli ottimizzati)

- o3 e o3-mini (Ragionamento avanzato)

- o1 e o1-mini (Generazione precedente)

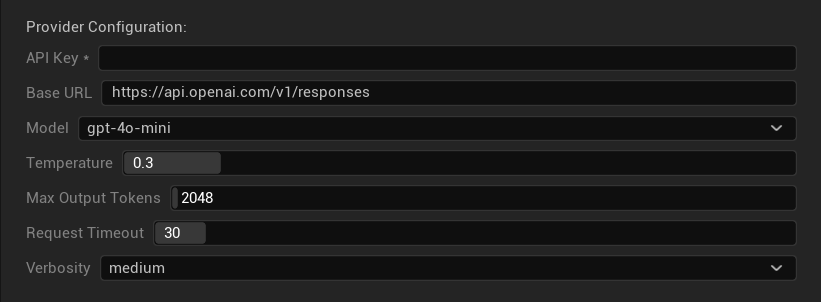

Opzioni di Configurazione

- Chiave API: La tua chiave API di OpenAI (richiesta)

- URL Base: Endpoint API (predefinito: server di OpenAI)

- Modello: Scegli tra i modelli GPT disponibili

- Temperatura: 0.0-2.0 (0.3 consigliato per coerenza nella traduzione)

- Token Massimi in Output: 1-128.000 token

- Timeout Richiesta: 5-300 secondi

- Verbosity: Controlla il livello di dettaglio della risposta

Punti di Forza

- ✅ Traduzioni di qualità costantemente alta

- ✅ Eccellente comprensione del contesto

- ✅ Forte preservazione del formato

- ✅ Ampio supporto linguistico

- ✅ Affidabile uptime dell'API

Considerazioni

- 💰 Costo più elevato per richiesta

- 🌐 Richiede connessione internet

- ⏱️ Limiti di utilizzo basati sul piano

Anthropic Claude

Migliore per: Traduzioni sfumate, contenuti creativi, applicazioni focalizzate sulla sicurezza

I modelli Claude eccellono nella comprensione del contesto e delle sfumature, rendendoli ideali per giochi ricchi di narrazione e scenari di localizzazione complessi.

Modelli Disponibili

- claude-opus-4-1-20250805 (Ultimo modello di punta)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Veloce ed efficiente)

- claude-3-haiku-20240307

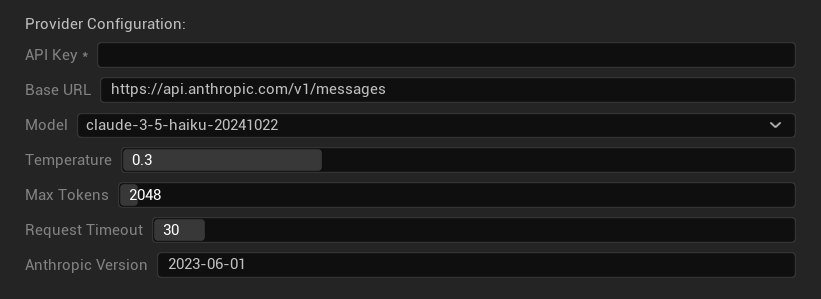

Opzioni di Configurazione

- Chiave API: La tua chiave API di Anthropic (richiesta)

- URL Base: Endpoint API di Claude

- Modello: Seleziona dalla famiglia di modelli Claude

- Temperatura: 0.0-1.0 (0.3 consigliato)

- Token Massimi: 1-64.000 token

- Timeout Richiesta: 5-300 secondi

- Versione Anthropic: Intestazione della versione API

Punti di Forza

- ✅ Consapevolezza eccezionale del contesto

- ✅ Ottimo per contenuti creativi/narrativi

- ✅ Forti funzionalità di sicurezza

- ✅ Capacità di ragionamento dettagliate

- ✅ Eccellente aderenza alle istruzioni

Considerazioni

- 💰 Modello di prezzi premium

- 🌐 Richiesta connessione internet

- 📏 Limiti di token variabili per modello

DeepSeek

Migliore per: Traduzione conveniente, alto volume, progetti attenti al budget

DeepSeek offre una qualità di traduzione competitiva a una frazione del costo di altri provider, rendendolo ideale per progetti di localizzazione su larga scala.

Modelli Disponibili

- deepseek-chat (Scopo generale, consigliato)

- deepseek-reasoner (Capacità di ragionamento potenziate)

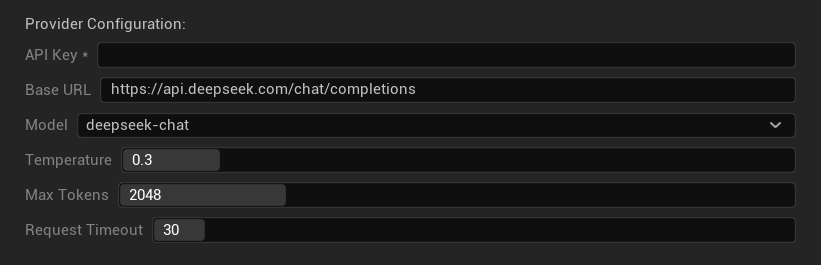

Opzioni di Configurazione

- Chiave API: La tua chiave API di DeepSeek (richiesta)

- URL Base: Endpoint API di DeepSeek

- Modello: Scegli tra i modelli chat e reasoner

- Temperatura: 0.0-2.0 (0.3 consigliato)

- Token Massimi: 1-8.192 token

- Timeout Richiesta: 5-300 secondi

Punti di Forza

- ✅ Molto conveniente

- ✅ Buona qualità di traduzione

- ✅ Tempi di risposta veloci

- ✅ Configurazione semplice

- ✅ Limiti di frequenza elevati

Considerazioni

- 📏 Limiti di token più bassi

- 🆕 Provider più recente (minore esperienza consolidata)

- 🌐 Richiede una connessione internet

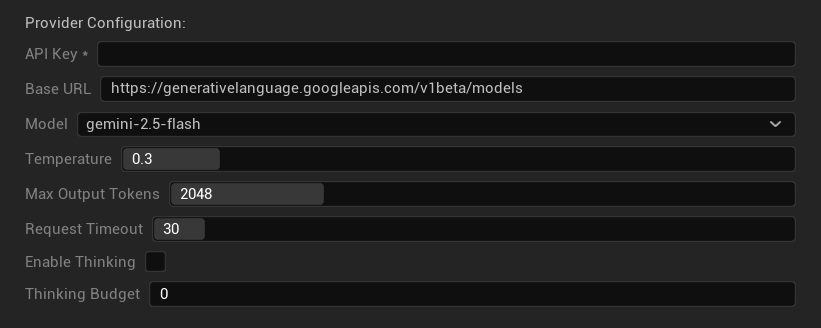

Google Gemini

Migliore per: Progetti multilingue, traduzione conveniente, integrazione con l'ecosistema Google

I modelli Gemini offrono solide capacità multilingue con prezzi competitivi e funzionalità uniche come la modalità thinking per un ragionamento potenziato.

Modelli Disponibili

- gemini-2.5-pro (Ultimo modello di punta con thinking)

- gemini-2.5-flash (Veloce, con supporto thinking)

- gemini-2.5-flash-lite (Variante leggera)

- gemini-2.0-flash e gemini-2.0-flash-lite

- gemini-1.5-pro e gemini-1.5-flash

Opzioni di Configurazione

- Chiave API: La tua chiave API di Google AI (richiesta)

- URL Base: Endpoint API Gemini

- Modello: Seleziona dalla famiglia di modelli Gemini

- Temperatura: 0.0-2.0 (0.3 consigliato)

- Token di Output Massimi: 1-8.192 token

- Timeout Richiesta: 5-300 secondi

- Abilita Thinking: Attiva il ragionamento potenziato per i modelli 2.5

- Budget Thinking: Controlla l'allocazione dei token per il thinking

Punti di Forza

- ✅ Solido supporto multilingue

- ✅ Prezzi competitivi

- ✅ Ragionamento avanzato (modalità thinking)

- ✅ Integrazione con l'ecosistema Google

- ✅ Aggiornamenti regolari dei modelli

Considerazioni

- 🧠 La modalità thinking aumenta l'uso dei token

- 📏 Limiti di token variabili per modello

- 🌐 Richiede una connessione internet

Scegliere il Provider Giusto

| Provider | Migliore Per | Qualità | Costo | Configurazione | Privacy |

|---|---|---|---|---|---|

| Ollama | Privacy/offline | Variabile* | Gratuito | Avanzata | Locale |

| OpenAI | Qualità più alta | ⭐⭐⭐⭐⭐ | 💰💰💰 | Semplice | Cloud |

| Claude | Contenuti creativi | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Semplice | Cloud |

| DeepSeek | Progetti con budget | ⭐⭐⭐⭐ | 💰 | Semplice | Cloud |

| Gemini | Multilingue | ⭐⭐⭐⭐ | 💰 | Semplice | Cloud |

*La qualità per Ollama varia significativamente in base al modello locale utilizzato - alcuni modelli locali moderni possono eguagliare o superare i provider cloud.

Suggerimenti per la Configurazione del Provider

Per Tutti i Provider Cloud:

- Archivia le chiavi API in modo sicuro e non inserirle nel controllo versione

- Inizia con impostazioni di temperatura conservative (0.3) per traduzioni consistenti

- Monitora l'utilizzo e i costi dell'API

- Testa con piccoli lotti prima di eseguire grandi sessioni di traduzione

Per Ollama:

- Assicurati di avere RAM sufficiente (8GB+ consigliato per modelli più grandi)

- Utilizza archiviazione SSD per prestazioni migliori nel caricamento dei modelli

- Considera l'accelerazione GPU per un'inferenza più veloce

- Testa localmente prima di affidarti ad esso per traduzioni in produzione