Guida all'Installazione

Questa guida ti accompagna attraverso il processo di installazione di base per Runtime MetaHuman Lip Sync con i tuoi personaggi MetaHuman.

Nota: Runtime MetaHuman Lip Sync funziona sia con i MetaHuman che con i personaggi personalizzati. Per istruzioni dettagliate sulla configurazione dei personaggi personalizzati, consulta la Guida all'Installazione per Personaggi Personalizzati.

Prerequisiti

Prima di iniziare, assicurati:

-

Requisiti del Plugin MetaHuman:

- UE 5.5 e precedenti: Abilita il plugin MetaHuman nel tuo progetto

- UE 5.6 e successivi: Abilita il plugin MetaHuman Core Tech nel tuo progetto

Plugin MetaHuman AggiuntiviA seconda di come crei i tuoi personaggi MetaHuman, potresti aver bisogno di plugin aggiuntivi. Ad esempio, se intendi creare un MetaHuman con il nuovo sistema MetaHuman Creator introdotto in UE 5.6, dovrai anche abilitare il plugin MetaHuman Creator. Per maggiori informazioni su questo sistema, consulta la documentazione di MetaHuman Creator.

-

Hai almeno un personaggio MetaHuman scaricato e disponibile nel tuo progetto

-

Il plugin Runtime MetaHuman Lip Sync è installato

Plugin di Estensione Modello Standard

Se prevedi di utilizzare il Modello Standard, dovrai installare il plugin di estensione:

- Scarica il plugin Standard Lip Sync Extension da Google Drive

- Estrai la cartella dall'archivio scaricato nella cartella

Pluginsdel tuo progetto (crea questa cartella se non esiste) - Assicurati che il tuo progetto sia configurato come progetto C++ (anche se non hai alcun codice C++)

- Ricompila il tuo progetto

- Questa estensione è richiesta solo se vuoi utilizzare il Modello Standard. Se hai bisogno solo dei Modelli Realistici, puoi saltare questo passaggio.

- Per maggiori informazioni su come compilare i plugin manualmente, consulta il tutorial sulla Compilazione dei Plugin

Plugin Aggiuntivi

- Se prevedi di utilizzare la cattura audio (ad esempio, input del microfono), installa il plugin Runtime Audio Importer.

- Se prevedi di utilizzare la funzionalità text-to-speech:

- Per il TTS locale (Modello Standard e Modello Realistico con Umore), installa il plugin Runtime Text To Speech.

- Per i provider TTS esterni (ElevenLabs, OpenAI, Google Cloud, Azure), installa il plugin Runtime AI Chatbot Integrator.

Configurazione dell'Animation Blueprint

Passo 1: Localizar e modificar o Blueprint de animação facial

- UE 5.5 e Anteriores (ou MetaHumans Legado no UE 5.6+)

- Personaggi UE 5.6+ MetaHuman Creator

Você precisa modificar um Blueprint de Animação que será usado para as animações faciais do seu personagem MetaHuman. O Blueprint de Animação facial padrão do MetaHuman está localizado em:

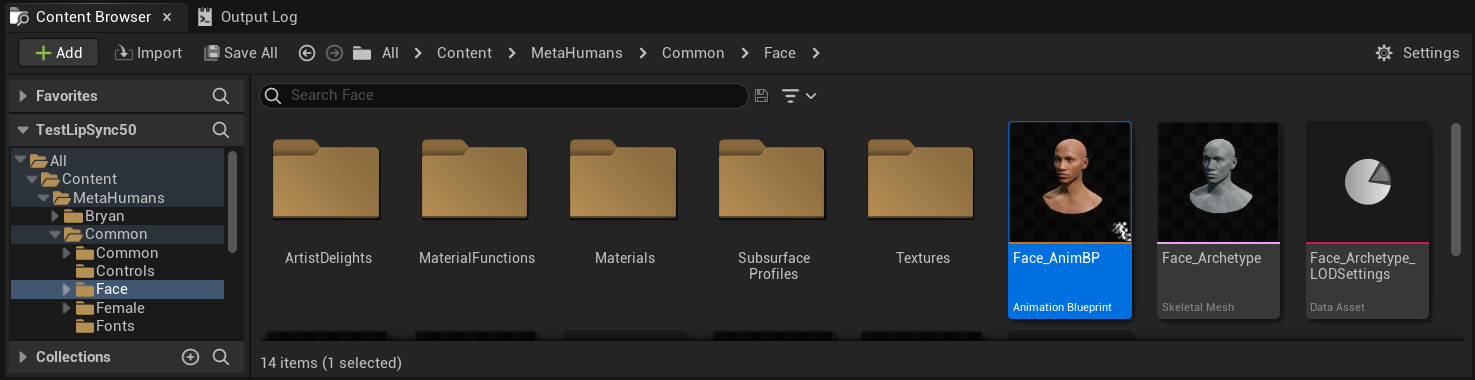

Content/MetaHumans/Common/Face/Face_AnimBP

Hai diverse opzioni per implementare la funzionalità di lip sync:

- Modifica Asset Predefinito (Opzione Più Semplice)

- Crea Duplicato

- Usa Animation Blueprint Personalizzato

Apri direttamente il Face_AnimBP predefinito e apporta le tue modifiche. Qualsiasi modifica influenzerà tutti i personaggi MetaHuman che utilizzano questo Animation Blueprint.

Nota: Questo approccio è conveniente ma avrà un impatto su tutti i personaggi che utilizzano l'Animation Blueprint predefinito.

- Duplica

Face_AnimBPe dagli un nome descrittivo - Individua la classe Blueprint del tuo personaggio (ad esempio, per il personaggio "Bryan", si troverebbe in

Content/MetaHumans/Bryan/BP_Bryan) - Apri il Blueprint del personaggio e trova il componente Face

- Cambia la proprietà Anim Class con il tuo Animation Blueprint appena duplicato

Nota: Questo approccio ti consente di personalizzare il lip sync per personaggi specifici lasciando gli altri invariati.

Puoi implementare la fusione del lip sync in qualsiasi Animation Blueprint che abbia accesso alle ossa facciali richieste:

- Crea o utilizza un Animation Blueprint personalizzato esistente

- Assicurati che il tuo Animation Blueprint funzioni con uno scheletro che contenga le stesse ossa facciali dello

Face_Archetype_Skeletonpredefinito di MetaHuman

Nota: Questo approccio ti offre la massima flessibilità per l'integrazione con sistemi di animazione personalizzati.

A partire da UE 5.6, è stato introdotto il nuovo sistema MetaHuman Creator. Per questi personaggi, il plugin fornisce un Animation Blueprint per il viso situato in:

Content/LipSyncData/LipSync_Face_AnimBP

Questa Animation Blueprint si trova nella cartella dei contenuti del plugin e verrà sovrascritta ad ogni aggiornamento del plugin. Per evitare di perdere le tue personalizzazioni:

- Copia questa risorsa nella cartella Content del tuo progetto (ad esempio in

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - Usa la tua versione copiata nella configurazione del personaggio

- Apporta tutte le tue modifiche alla versione copiata

Utilizzo della Face Animation Blueprint del Plugin:

- Individua la classe Blueprint del tuo personaggio di MetaHuman Creator

- Apri la Blueprint del personaggio e trova il componente Face

- Cambia la proprietà Anim Class con la

LipSync_Face_AnimBPdel plugin - Prosegui con i passaggi successivi per configurare la funzionalità Runtime MetaHuman Lip Sync

Passaggio 2: Configurazione del Grafico degli Eventi

Apri la tua Face Animation Blueprint e passa al Event Graph. Dovrai creare un generatore che elaborerà i dati audio e genererà l'animazione di lip sync.

- Modello Standard

- Modello Realistico

- Modello Realistico con Umore

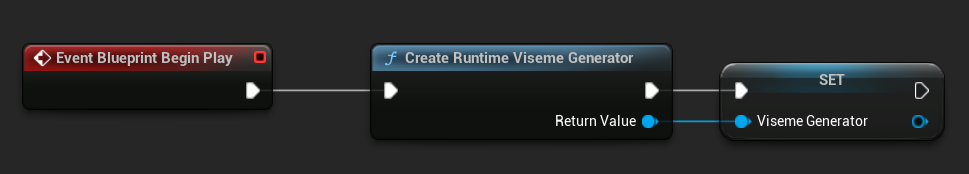

- Aggiungi il nodo

Event Blueprint Begin Playse non esiste già - Aggiungi il nodo

Create Runtime Viseme Generatore collegalo all'evento Begin Play - Salva l'output come una variabile (ad es. "VisemeGenerator") per l'uso in altre parti del grafico

Per le opzioni di configurazione dettagliate, consulta la sezione Configurazione del Modello Standard.

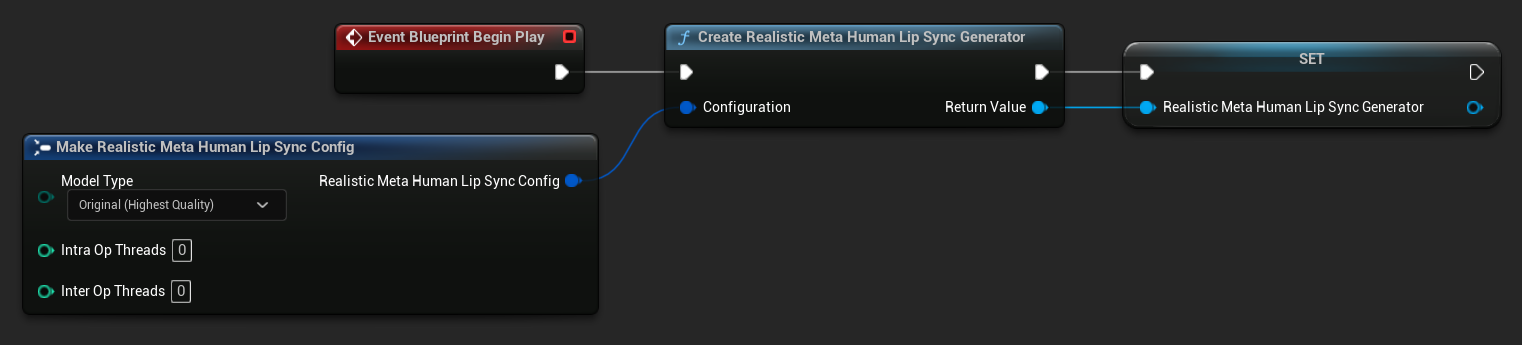

- Aggiungi il nodo

Event Blueprint Begin Playse non esiste già - Aggiungi il nodo

Create Realistic MetaHuman Lip Sync Generatore collegalo all'evento Begin Play - Salva l'output come una variabile (ad es. "RealisticMetaHumanLipSyncGenerator") per l'uso in altre parti del grafico

- (Opzionale) Configura le impostazioni del generatore utilizzando il parametro Configuration

Per le opzioni di configurazione dettagliate inclusi i tipi di modello, le impostazioni delle prestazioni e i parametri di elaborazione, consulta la sezione Configurazione del Modello Realistico.

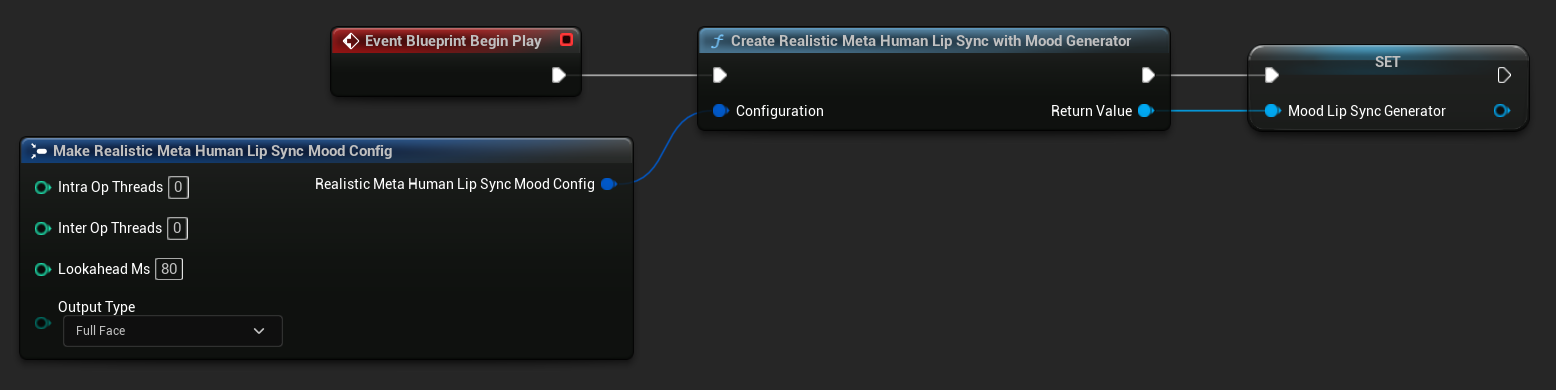

- Aggiungi il nodo

Event Blueprint Begin Playse non esiste già - Aggiungi il nodo

Create Realistic MetaHuman Lip Sync With Mood Generatore collegalo all'evento Begin Play - Salva l'output come una variabile (ad es. "MoodMetaHumanLipSyncGenerator") per l'uso in altre parti del grafico

- (Opzionale) Configura le impostazioni del generatore utilizzando il parametro Configuration

Per la configurazione dettagliata dell'umore inclusa tipi di umore, impostazioni di intensità, tempistica di anticipo e selezione del tipo di output, consulta la sezione Configurazione del modello abilitato all'umore.

Passo 3: Configurazione del Grafico delle Animazioni

Dopo aver configurato il Grafico degli Eventi, passa al Anim Graph per collegare il generatore all'animazione del personaggio:

- Modello Standard

- Modello Realistico

- Modello Realistico Abilitato all'Umore

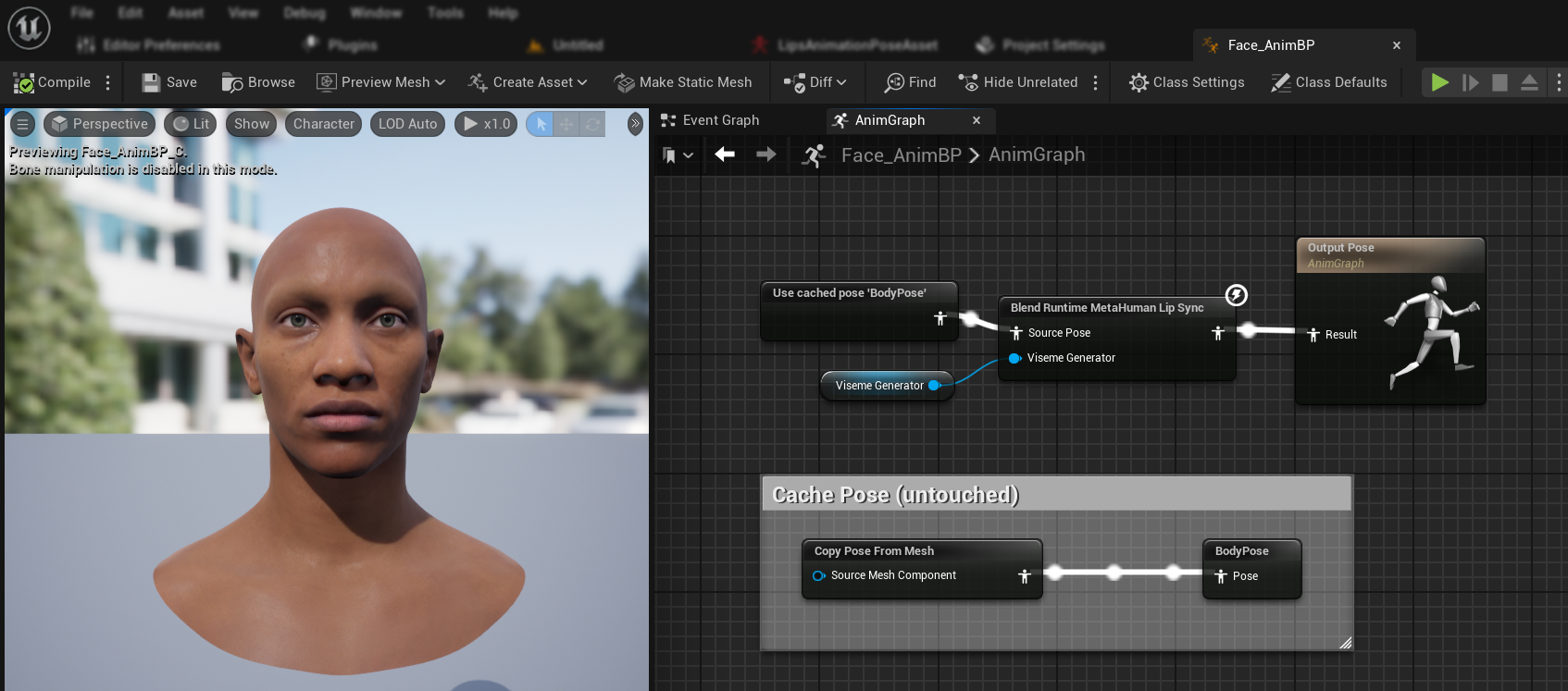

- Individua la posa che contiene il volto del MetaHuman (tipicamente da

Use cached pose 'Body Pose') - Aggiungi il nodo

Blend Runtime MetaHuman Lip Sync - Collega la posa al

Source Posedel nodoBlend Runtime MetaHuman Lip Sync - Collega la tua variabile

VisemeGeneratoral pinViseme Generator - Collega l'output del nodo

Blend Runtime MetaHuman Lip Syncal pinResultdell'Output Pose

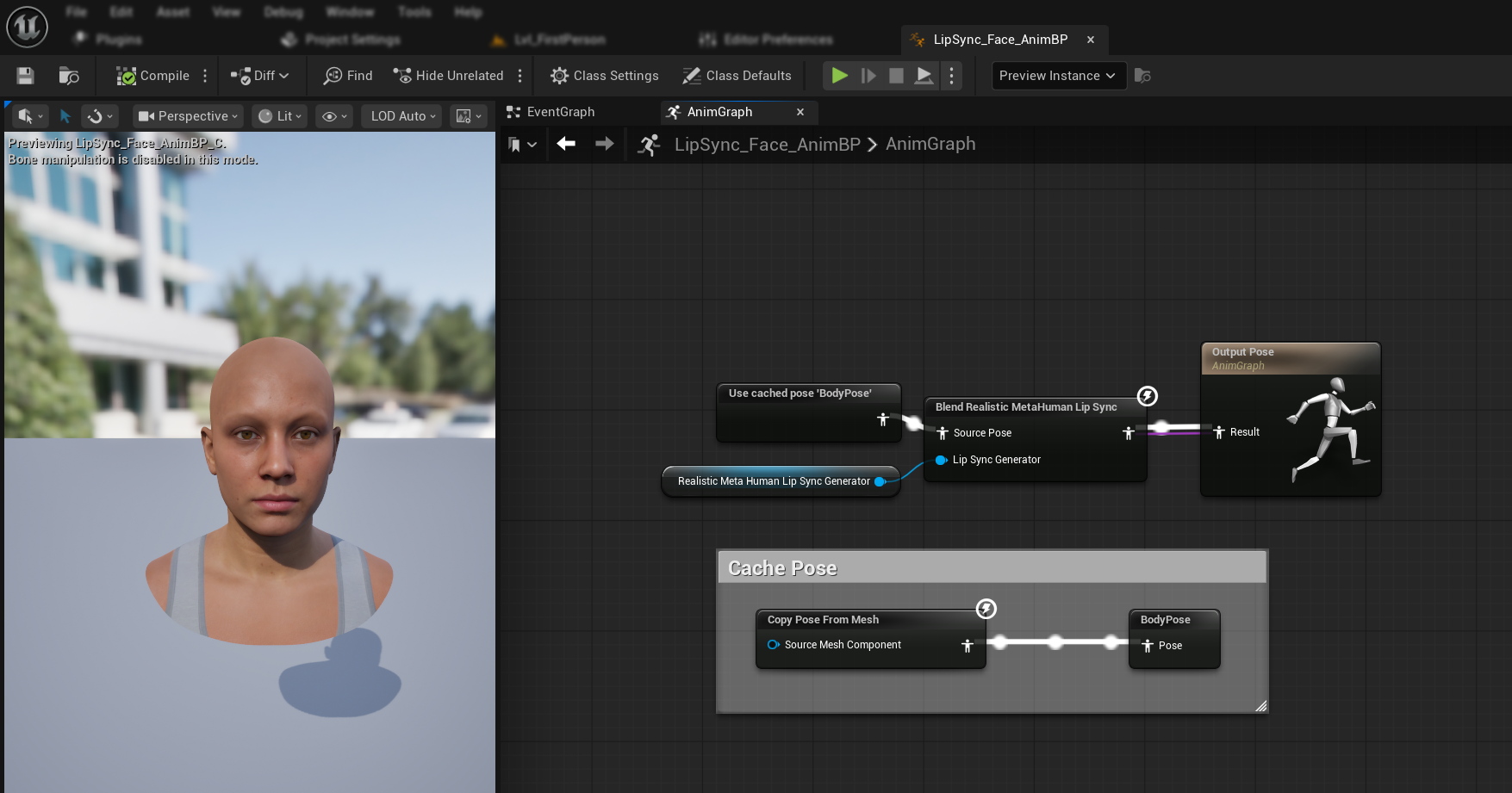

- Individua la posa che contiene il volto del MetaHuman (tipicamente da

Use cached pose 'Body Pose') - Aggiungi il nodo

Blend Realistic MetaHuman Lip Sync - Collega la posa al

Source Posedel nodoBlend Realistic MetaHuman Lip Sync - Collega la tua variabile

RealisticMetaHumanLipSyncGeneratoral pinLip Sync Generator - Collega l'output del nodo

Blend Realistic MetaHuman Lip Syncal pinResultdell'Output Pose

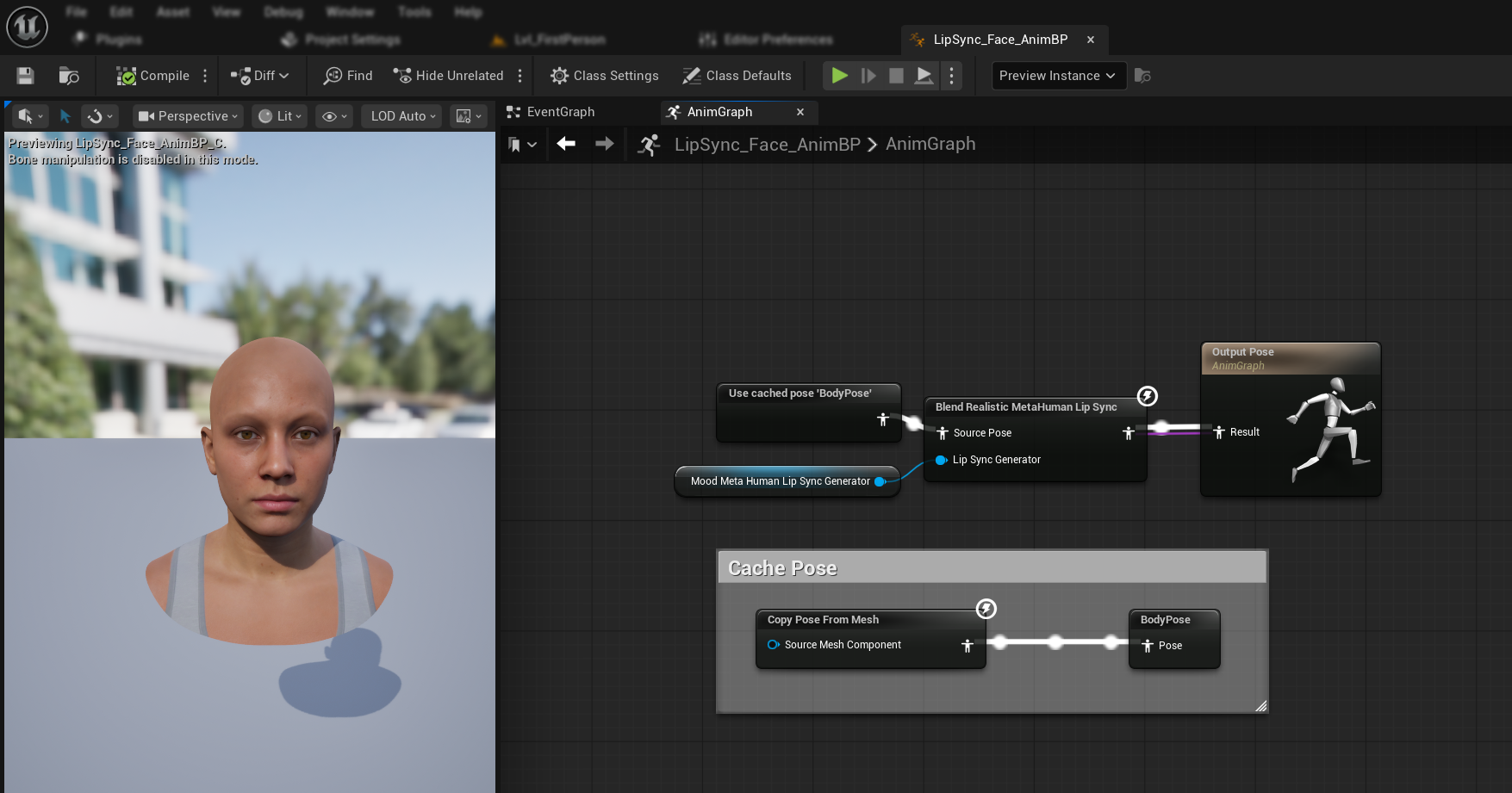

- Individua la posa che contiene il volto del MetaHuman (tipicamente da

Use cached pose 'Body Pose') - Aggiungi il nodo

Blend Realistic MetaHuman Lip Sync(lo stesso nodo del modello realistico regolare) - Collega la posa al

Source Posedel nodoBlend Realistic MetaHuman Lip Sync - Collega la tua variabile

MoodMetaHumanLipSyncGeneratoral pinLip Sync Generator - Collega l'output del nodo

Blend Realistic MetaHuman Lip Syncal pinResultdell'Output Pose

Nota: Il modello abilitato all'umore utilizza lo stesso nodo Animation Blueprint del modello realistico regolare. La funzionalità dell'umore è gestita internamente dal generatore.

Prossimi Passi

Ora che hai completato la configurazione di base dell'Animation Blueprint, dovrai configurare l'elaborazione dell'input audio per fornire dati audio al tuo generatore di lip sync.

Prosegui con la Guida all'Elaborazione Audio per imparare come impostare diversi metodi di input audio, inclusa la cattura del microfono, il text-to-speech e l'elaborazione di file audio. Per le opzioni di configurazione avanzate e la messa a punto, consulta la Guida alla Configurazione.