翻訳プロバイダー

AI Localization Automator は、それぞれに独自の強みと設定オプションを持つ5つの異なるAIプロバイダーをサポートしています。プロジェクトのニーズ、予算、品質要件に最適なプロバイダーを選択してください。

Ollama (ローカルAI)

最適な用途: プライバシーに敏感なプロジェクト、オフライン翻訳、無制限の使用

OllamaはAIモデルをマシン上でローカルに実行し、APIコストやインターネット接続を必要とせず、完全なプライバシーと制御を提供します。

人気モデル

- llama3.2 (推奨される汎用モデル)

- mistral (効率的な代替モデル)

- codellama (コードを意識した翻訳)

- その他多くのコミュニティモデル

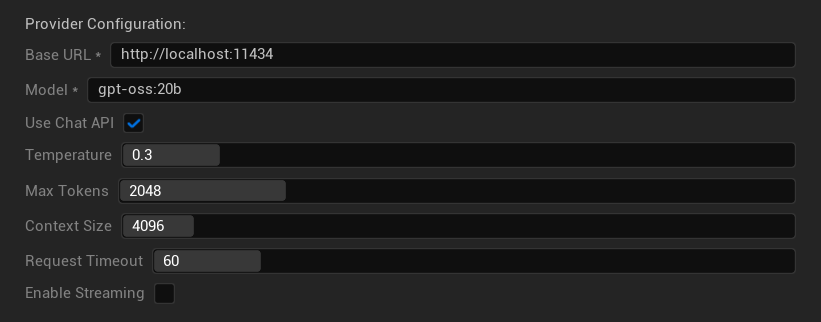

設定オプション

- ベースURL: ローカルのOllamaサーバー (デフォルト:

http://localhost:11434) - モデル: ローカルにインストールされたモデルの名前 (必須)

- チャットAPIを使用: より良い会話処理のために有効化

- 温度 (Temperature): 0.0-2.0 (0.3推奨)

- 最大トークン数 (Max Tokens): 1-8,192トークン

- コンテキストサイズ (Context Size): 512-32,768トークン

- リクエストタイムアウト (Request Timeout): 10-300秒 (ローカルモデルは遅くなる可能性あり)

- ストリーミングを有効化 (Enable Streaming): リアルタイムのレスポンス処理用

強み

- ✅ 完全なプライバシー (データがマシンから流出しない)

- ✅ APIコストや使用制限なし

- ✅ オフラインで動作

- ✅ モデルパラメータの完全な制御

- ✅ 多種多様なコミュニティモデル

- ✅ ベンダーロックインなし

考慮事項

- 💻 ローカルセットアップと十分なハードウェアが必要

- ⚡ 一般的にクラウドプロバイダーより低速

- 🔧 より技術的なセットアップが必要

- 📊 翻訳品質はモデルによって大きく異なる (クラウドプロバイダーを超えるものもある)

- 💾 モデル用の大容量ストレージが必要

Ollamaのセットアップ

- Ollamaのインストール: ollama.ai からダウンロードし、システムにインストール

- モデルのダウンロード:

ollama pull llama3.2を使用して選択したモデルをダウンロード - サーバーの起動: Ollamaは自動的に実行されるか、

ollama serveで起動 - プラグインの設定: プラグイン設定でベースURLとモデル名を設定

- 接続テスト: 設定を適用すると、プラグインが接続を検証します

OpenAI

最適な用途: 全体的に最高の翻訳品質、豊富なモデル選択肢

OpenAIは、最新のGPTモデルや新しいResponses APIフォーマットを含む、業界をリードする言語モデルをAPIを通じて提供します。

利用可能なモデル

- gpt-5 (最新のフラグシップモデル)

- gpt-5-mini (より小型で高速なバリアント)

- gpt-4.1 および gpt-4.1-mini

- gpt-4o および gpt-4o-mini (最適化されたモデル)

- o3 および o3-mini (高度な推論)

- o1 および o1-mini (前世代)

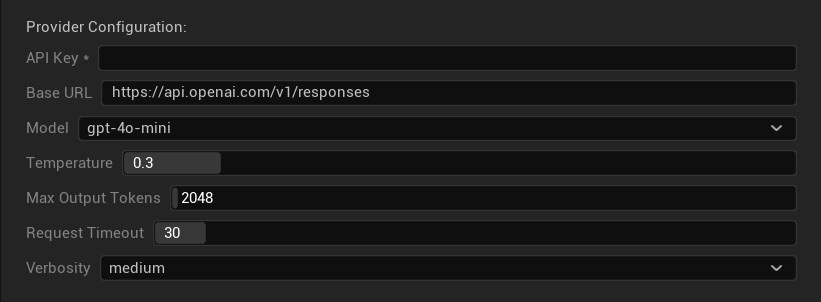

設定オプション

- APIキー: あなたのOpenAI APIキー (必須)

- ベースURL: APIエンドポイント (デフォルト: OpenAIのサーバー)

- モデル: 利用可能なGPTモデルから選択

- Temperature (温度): 0.0-2.0 (翻訳の一貫性には0.3を推奨)

- 最大出力トークン数: 1-128,000トークン

- リクエストタイムアウト: 5-300秒

- 詳細度: 応答の詳細レベルを制御

強み

- ✅ 一貫して高品質な翻訳

- ✅ 優れた文脈理解

- ✅ 強力なフォーマット維持

- ✅ 幅広い言語サポート

- ✅ 信頼性の高いAPI稼働時間

考慮事項

- 💰 リクエストあたりのコストが高い

- 🌐 インターネット接続が必要

- ⏱️ 利用枠に基づく使用制限

Anthropic Claude

最適な用途: ニュアンスのある翻訳、創造的なコンテンツ、安全性を重視したアプリケーション

Claudeモデルは文脈とニュアンスの理解に優れており、物語性の強いゲームや複雑なローカライゼーションシナリオに最適です。

利用可能なモデル

- claude-opus-4-1-20250805 (最新のフラグシップモデル)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (高速かつ効率的)

- claude-3-haiku-20240307

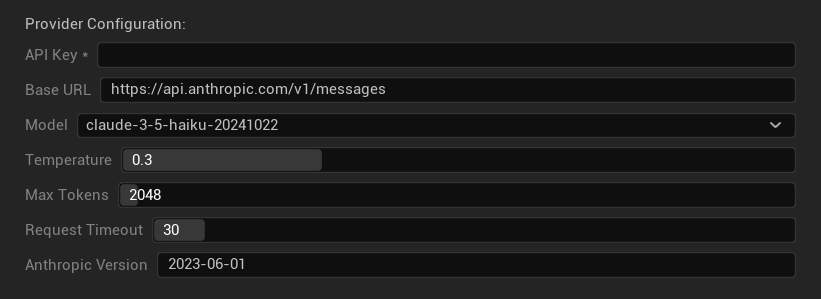

設定オプション

- APIキー: あなたのAnthropic APIキー (必須)

- ベースURL: Claude APIエンドポイント

- モデル: Claudeモデルファミリーから選択

- Temperature (温度): 0.0-1.0 (0.3を推奨)

- 最大トークン数: 1-64,000トークン

- リクエストタイムアウト: 5-300秒

- Anthropicバージョン: APIバージョンヘッダー

強み

- ✅ 卓越した文脈認識

- ✅ 創造的/物語的コンテンツに最適

- ✅ 強力な安全機能

- ✅ 詳細な推論能力

- ✅ 優れた指示追従性

考慮事項

- 💰 プレミアム価格設定

- 🌐 インターネット接続が必要

- 📏 モデルごとにトークン制限が異なる

DeepSeek

最適な用途: コスト効率の良い翻訳、高スループット、予算を意識したプロジェクト

DeepSeekは他のプロバイダーの数分の一のコストで競争力のある翻訳品質を提供し、大規模なローカライゼーションプロジェクトに最適です。

利用可能なモデル

- deepseek-chat (汎用、推奨)

- deepseek-reasoner (強化された推論能力)

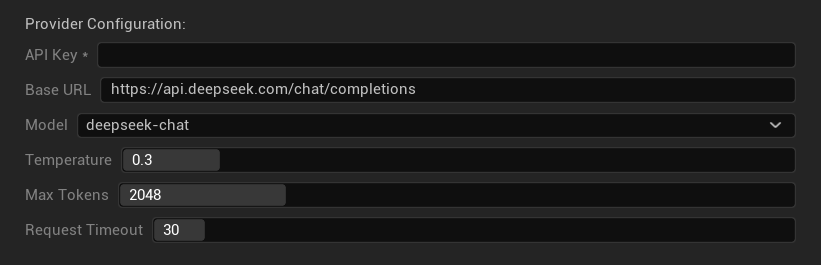

設定オプション

- APIキー: あなたのDeepSeek APIキー (必須)

- ベースURL: DeepSeek APIエンドポイント

- モデル: チャットモデルと推論モデルから選択

- Temperature (温度): 0.0-2.0 (0.3を推奨)

- 最大トークン数: 1-8,192トークン

- リクエストタイムアウト: 5-300秒

強み

- ✅ 非常にコスト効率が良い

- ✅ 良好な翻訳品質

- ✅ 高速な応答時間

- ✅ シンプルな設定

- ✅ 高いレート制限

考慮事項

- 📏 低いトークン制限

- 🆕 新しいプロバイダー(実績が少ない)

- 🌐 インターネット接続が必要

Google Gemini

最適な用途: 多言語プロジェクト、コスト効率の良い翻訳、Google エコシステムとの統合

Gemini モデルは、強力な多言語対応能力、競争力のある価格設定、強化された推論のための思考モードなどのユニークな機能を提供します。

利用可能なモデル

- gemini-2.5-pro (思考機能を備えた最新のフラグシップモデル)

- gemini-2.5-flash (高速、思考機能サポート)

- gemini-2.5-flash-lite (軽量版)

- gemini-2.0-flash および gemini-2.0-flash-lite

- gemini-1.5-pro および gemini-1.5-flash

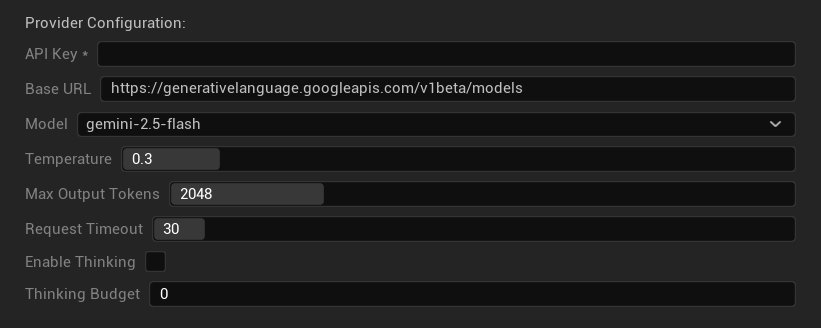

設定オプション

- API キー: Google AI API キー (必須)

- ベース URL: Gemini API エンドポイント

- モデル: Gemini モデルファミリーから選択

- Temperature (温度): 0.0-2.0 (0.3 推奨)

- 最大出力トークン数: 1-8,192 トークン

- リクエストタイムアウト: 5-300 秒

- 思考モードを有効化: 2.5 モデルで強化された推論をアクティブ化

- 思考予算: 思考トークンの割り当てを制御

強み

- ✅ 強力な多言語サポート

- ✅ 競争力のある価格設定

- ✅ 高度な推論 (思考モード)

- ✅ Google エコシステムとの統合

- ✅ 定期的なモデル更新

考慮事項

- 🧠 思考モードはトークン使用量を増加させる

- 📏 モデルごとに異なるトークン制限

- 🌐 インターネット接続が必要

適切なプロバイダーの選択

| プロバイダー | 最適な用途 | 品質 | コスト | セットアップ | プライバシー |

|---|---|---|---|---|---|

| Ollama | プライバシー/オフライン | 変動* | 無料 | 上級者向け | ローカル |

| OpenAI | 最高品質 | ⭐⭐⭐⭐⭐ | 💰💰💰 | 簡単 | クラウド |

| Claude | 創造的なコンテンツ | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | 簡単 | クラウド |

| DeepSeek | 予算重視のプロジェクト | ⭐⭐⭐⭐ | 💰 | 簡単 | クラウド |

| Gemini | 多言語 | ⭐⭐⭐⭐ | 💰 | 簡単 | クラウド |

*Ollama の品質は、使用するローカルモデルによって大きく異なります。最新のローカルモデルの中には、クラウドプロバイダーと同等かそれ以上の性能を発揮するものもあります。

プロバイダー設定のヒント

すべてのクラウドプロバイダー向け:

- API キーは安全に保管し、バージョン管理システムにコミットしないでください

- 一貫性のある翻訳を得るために、控えめな温度設定 (0.3) から始めてください

- API の使用量とコストを監視してください

- 大規模な翻訳実行の前に、小さなバッチでテストしてください

Ollama 向け:

- 十分な RAM を確保してください (大規模モデルには 8GB 以上を推奨)

- モデルの読み込みパフォーマンス向上のために SSD ストレージを使用してください

- 高速な推論のために GPU アクセラレーションを検討してください

- 本番環境の翻訳に依存する前に、ローカルでテストしてください