セットアップガイド

このガイドでは、Runtime MetaHuman Lip Sync を MetaHuman キャラクターと共に使用するための基本的なセットアップ手順を説明します。

注意: Runtime MetaHuman Lip Sync は MetaHuman と カスタムキャラクター の両方で動作します。カスタムキャラクターの設定に関する詳細な手順については、カスタムキャラクター設定ガイド を参照してください。

前提条件

開始する前に、以下を確認してください:

-

MetaHuman プラグインの要件:

- UE 5.5 以前: プロジェクトで MetaHuman プラグインを有効にする

- UE 5.6 以降: プロジェクトで MetaHuman Core Tech プラグインを有効にする

追加の MetaHuman プラグインMetaHuman キャラクターの作成方法によっては、追加のプラグインが必要になる場合があります。例えば、UE 5.6 で導入された新しい MetaHuman Creator システムで MetaHuman を作成する場合は、MetaHuman Creator プラグインも有効にする必要があります。このシステムに関する詳細は、MetaHuman Creator ドキュメント を参照してください。

-

少なくとも 1 つの MetaHuman キャラクターがダウンロードされ、プロジェクト内で利用可能であること

-

Runtime MetaHuman Lip Sync プラグインがインストールされていること

標準モデル拡張プラグイン

標準モデル を使用する予定がある場合は、拡張プラグインをインストールする必要があります:

- 標準リップシンク拡張プラグイン を Google Drive からダウンロードする

- ダウンロードしたアーカイブからフォルダを抽出し、プロジェクトの

Pluginsフォルダに配置する (このフォルダが存在しない場合は作成する) - プロジェクトが C++ プロジェクト として設定されていることを確認する (C++ コードがなくても)

- プロジェクトをリビルドする

- この拡張は 標準モデル を使用したい場合にのみ必要です。リアリスティックモデル のみが必要な場合は、この手順をスキップできます。

- プラグインを手動でビルドする方法の詳細については、プラグインビルドチュートリアル を参照してください

追加プラグイン

- オーディオキャプチャ (例: マイク入力) を使用する予定がある場合は、Runtime Audio Importer プラグインをインストールしてください。

- テキスト読み上げ 機能を使用する予定がある場合:

- ローカル TTS (標準モデルおよびムード対応リアリスティックモデル) の場合は、Runtime Text To Speech プラグインをインストールしてください。

- 外部 TTS プロバイダー (ElevenLabs, OpenAI, Google Cloud, Azure) の場合は、Runtime AI Chatbot Integrator プラグインをインストールしてください。

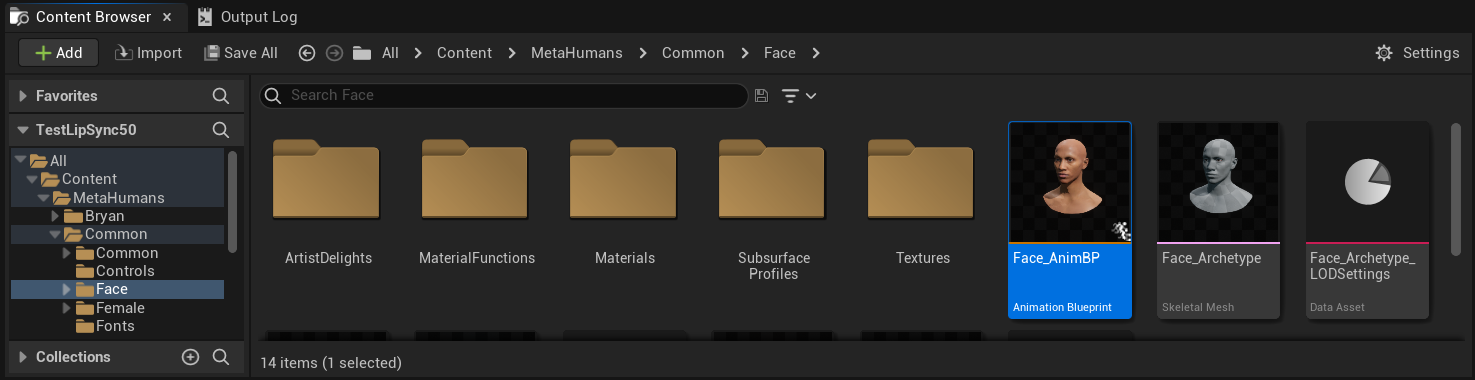

アニメーションブループリントの設定

ステップ 1: フェイスアニメーション Blueprint を探して修正する

- UE 5.5 およびそれ以前 (または UE 5.6+ のレガシー MetaHumans)

- UE 5.6+ MetaHuman Creator キャラクター

MetaHuman キャラクターのフェイシャルアニメーションに使用される Animation Blueprint を修正する必要があります。デフォルトの MetaHuman フェイス Animation Blueprint は次の場所にあります:

Content/MetaHumans/Common/Face/Face_AnimBP

リップシンク機能を実装するにはいくつかのオプションがあります:

- デフォルトアセットを編集(最も簡単なオプション)

- 複製を作成

- カスタムアニメーションブループリントを使用

デフォルトの Face_AnimBP を直接開き、変更を加えます。変更はこのアニメーションブループリントを使用するすべてのMetaHumanキャラクターに影響します。

注意: このアプローチは便利ですが、デフォルトのアニメーションブループリントを使用するすべてのキャラクターに影響を与えます。

Face_AnimBPを複製し、説明的な名前を付けます- キャラクターのBlueprintクラスを探します(例:キャラクター「Bryan」の場合、

Content/MetaHumans/Bryan/BP_Bryanにあります) - キャラクターBlueprintを開き、Faceコンポーネントを見つけます

- Anim Classプロパティを新しく複製したアニメーションブループリントに変更します

注意: このアプローチでは、特定のキャラクターのリップシンクをカスタマイズしながら、他のキャラクターは変更しないままにすることができます。

必要な顔のボーンにアクセスできる任意のアニメーションブループリントでリップシンクのブレンディングを実装できます:

- カスタムアニメーションブループリントを作成するか、既存のものを使用します

- あなたのアニメーションブループリントが、デフォルトのMetaHumanの

Face_Archetype_Skeletonと同じ顔のボーンを含むスケルトンで動作することを確認します

注意: このアプローチは、カスタムアニメーションシステムとの統合において最大限の柔軟性を提供します。

UE 5.6以降、新しい MetaHuman Creator システムが導入されました。これらのキャラクターの場合、プラグインは以下の場所にフェースアニメーションブループリントを提供します:

Content/LipSyncData/LipSync_Face_AnimBP

この Animation Blueprint はプラグインのコンテンツフォルダに配置されており、プラグインの更新ごとに上書きされます。カスタマイズ内容を失わないようにするには:

- このアセットをプロジェクトの Content フォルダにコピーしてください(例:

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - キャラクター設定でコピーしたバージョンを使用してください

- コピーしたバージョンに対してすべての変更を加えてください

プラグインの Face Animation Blueprint を使用する:

- MetaHuman Creator キャラクターの Blueprint クラスを特定します

- キャラクター Blueprint を開き、Face コンポーネントを見つけます

- Anim Class プロパティをプラグインの

LipSync_Face_AnimBPに変更します - Runtime MetaHuman Lip Sync 機能を設定する次のステップに進みます

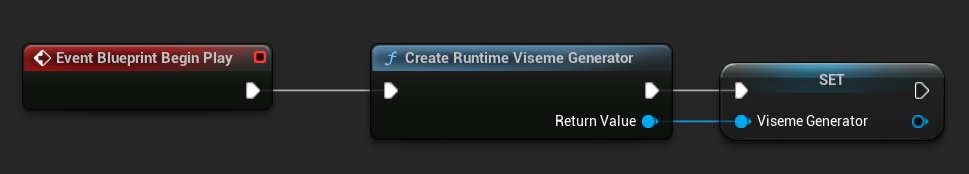

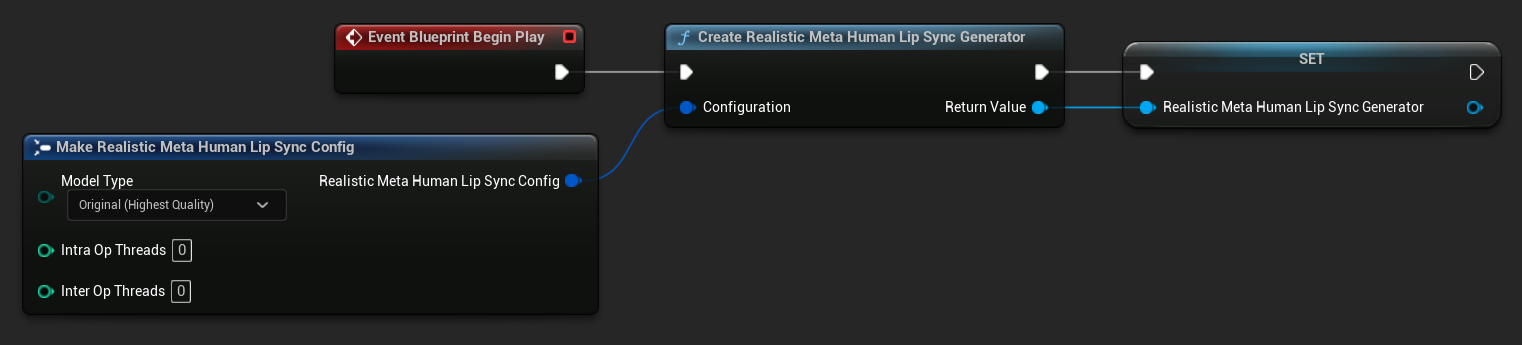

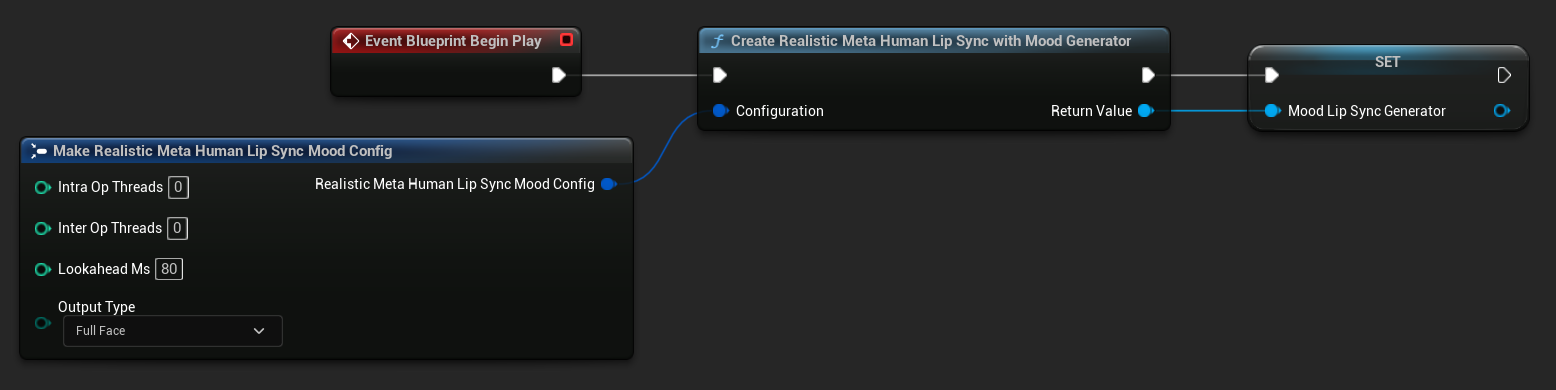

ステップ 2: イベントグラフの設定

Face Animation Blueprint を開き、Event Graph に切り替えます。オーディオデータを処理してリップシンクアニメーションを生成するジェネレーターを作成する必要があります。

- 標準モデル

- リアリスティックモデル

- ムード対応リアリスティックモデル

- まだ存在しない場合は

Event Blueprint Begin Playノードを追加します Create Runtime Viseme Generatorノードを追加し、Begin Play イベントに接続します- 出力を変数(例: "VisemeGenerator")として保存し、グラフの他の部分で使用します

詳細な設定オプションについては、標準モデル設定セクションを参照してください。

- まだ存在しない場合は

Event Blueprint Begin Playノードを追加します Create Realistic MetaHuman Lip Sync Generatorノードを追加し、Begin Play イベントに接続します- 出力を変数(例: "RealisticMetaHumanLipSyncGenerator")として保存し、グラフの他の部分で使用します

- (オプション)Configuration パラメータを使用してジェネレーター設定を構成します

モデルタイプ、パフォーマンス設定、処理パラメータを含む詳細な設定オプションについては、リアリスティックモデル設定セクションを参照してください。

- まだ存在しない場合は

Event Blueprint Begin Playノードを追加します Create Realistic MetaHuman Lip Sync With Mood Generatorノードを追加し、Begin Play イベントに接続します- 出力を変数(例: "MoodMetaHumanLipSyncGenerator")として保存し、グラフの他の部分で使用します

- (オプション)Configuration パラメータを使用してジェネレーター設定を構成します

ムード設定の詳細については、 ムードタイプ、強度設定、先読みタイミング、出力タイプの選択については、ムード対応モデル設定セクションを参照してください。

ステップ 3: アニメグラフの設定

イベントグラフの設定後、Anim Graph に切り替えて、ジェネレーターをキャラクターのアニメーションに接続します:

- 標準モデル

- リアリスティックモデル

- ムード対応リアリスティックモデル

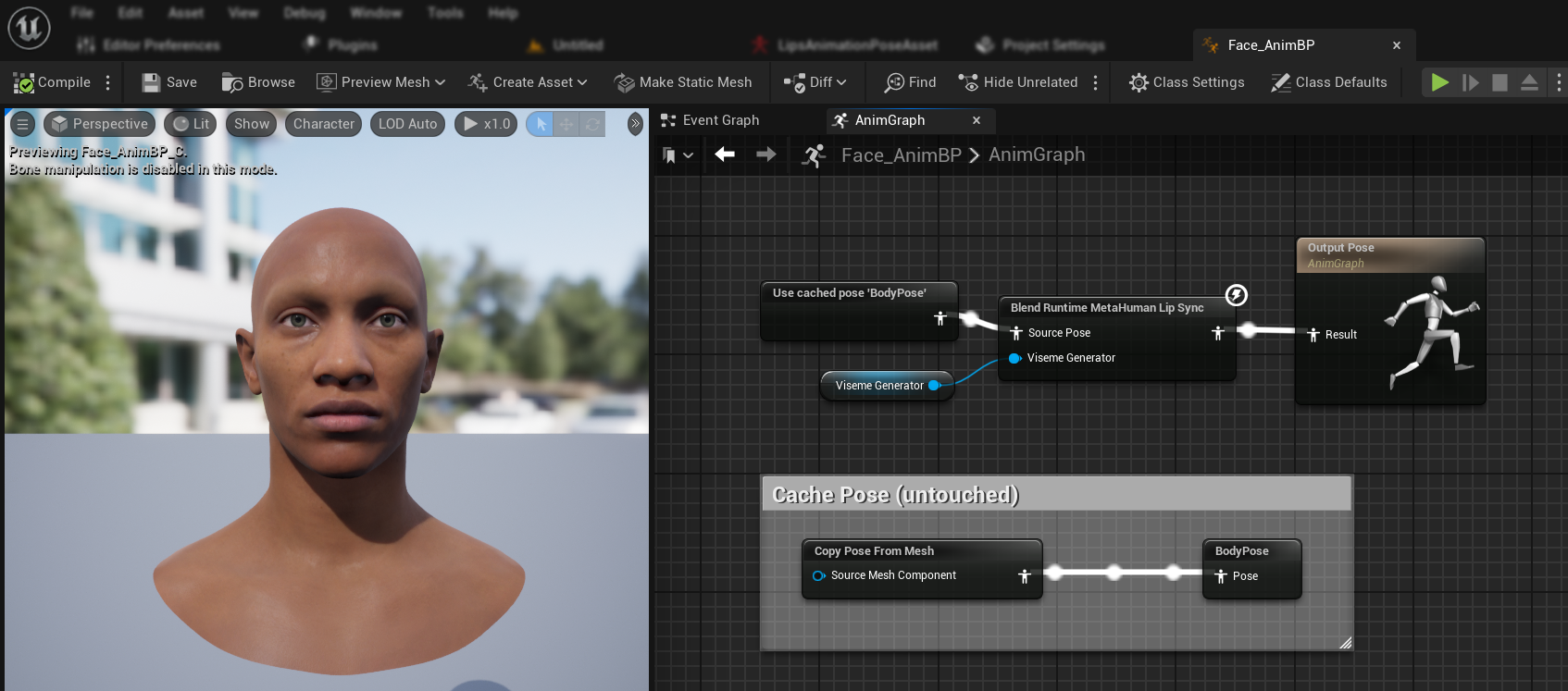

- MetaHuman の顔を含むポーズを見つけます(通常は

Use cached pose 'Body Pose'から) Blend Runtime MetaHuman Lip Syncノードを追加します- ポーズを

Blend Runtime MetaHuman Lip SyncノードのSource Poseに接続します - あなたの

VisemeGenerator変数をViseme Generatorピンに接続します Blend Runtime MetaHuman Lip Syncノードの出力をOutput PoseのResultピンに接続します

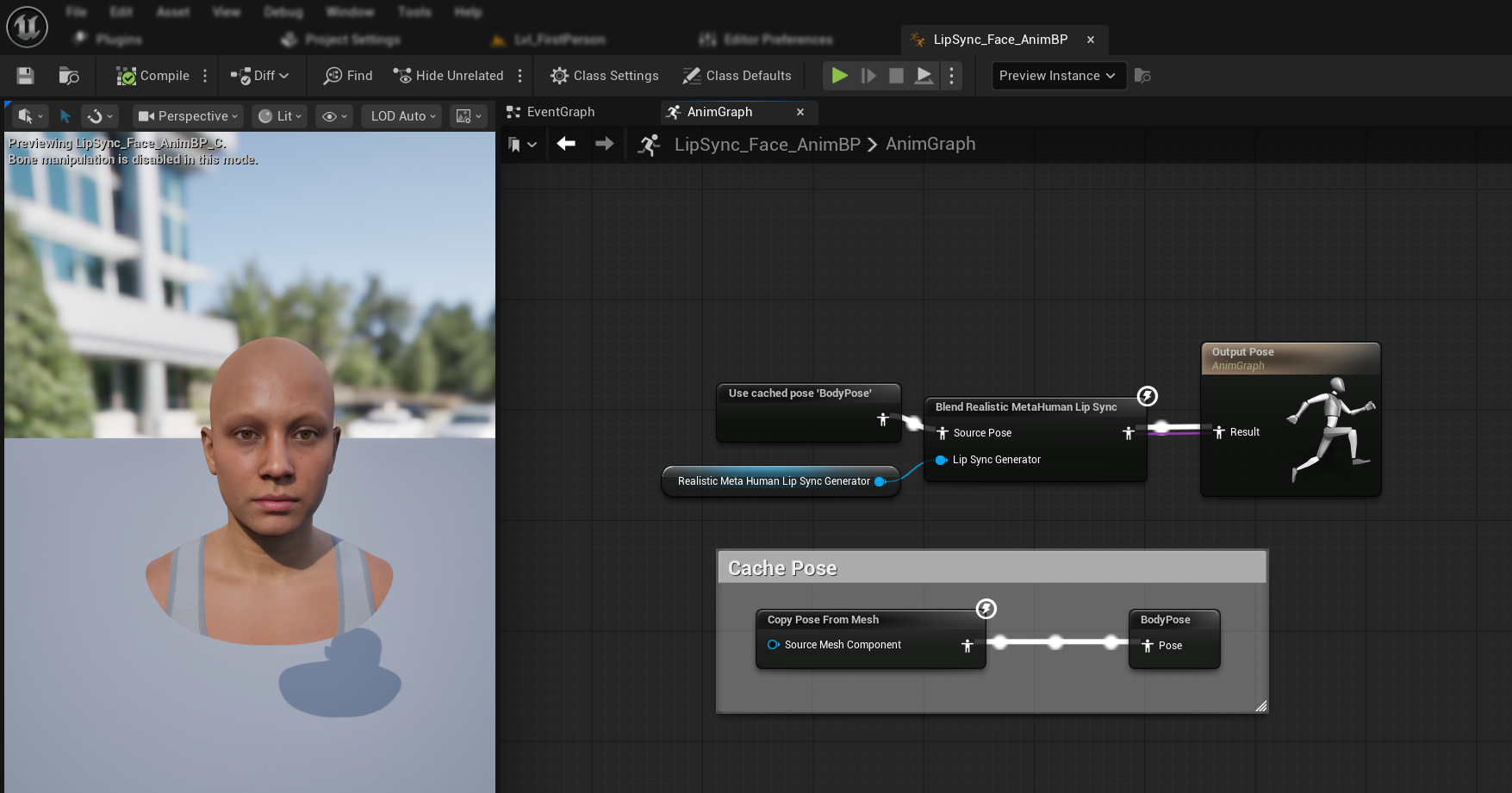

- MetaHuman の顔を含むポーズを見つけます(通常は

Use cached pose 'Body Pose'から) Blend Realistic MetaHuman Lip Syncノードを追加します- ポーズを

Blend Realistic MetaHuman Lip SyncノードのSource Poseに接続します - あなたの

RealisticMetaHumanLipSyncGenerator変数をLip Sync Generatorピンに接続します Blend Realistic MetaHuman Lip Syncノードの出力をOutput PoseのResultピンに接続します

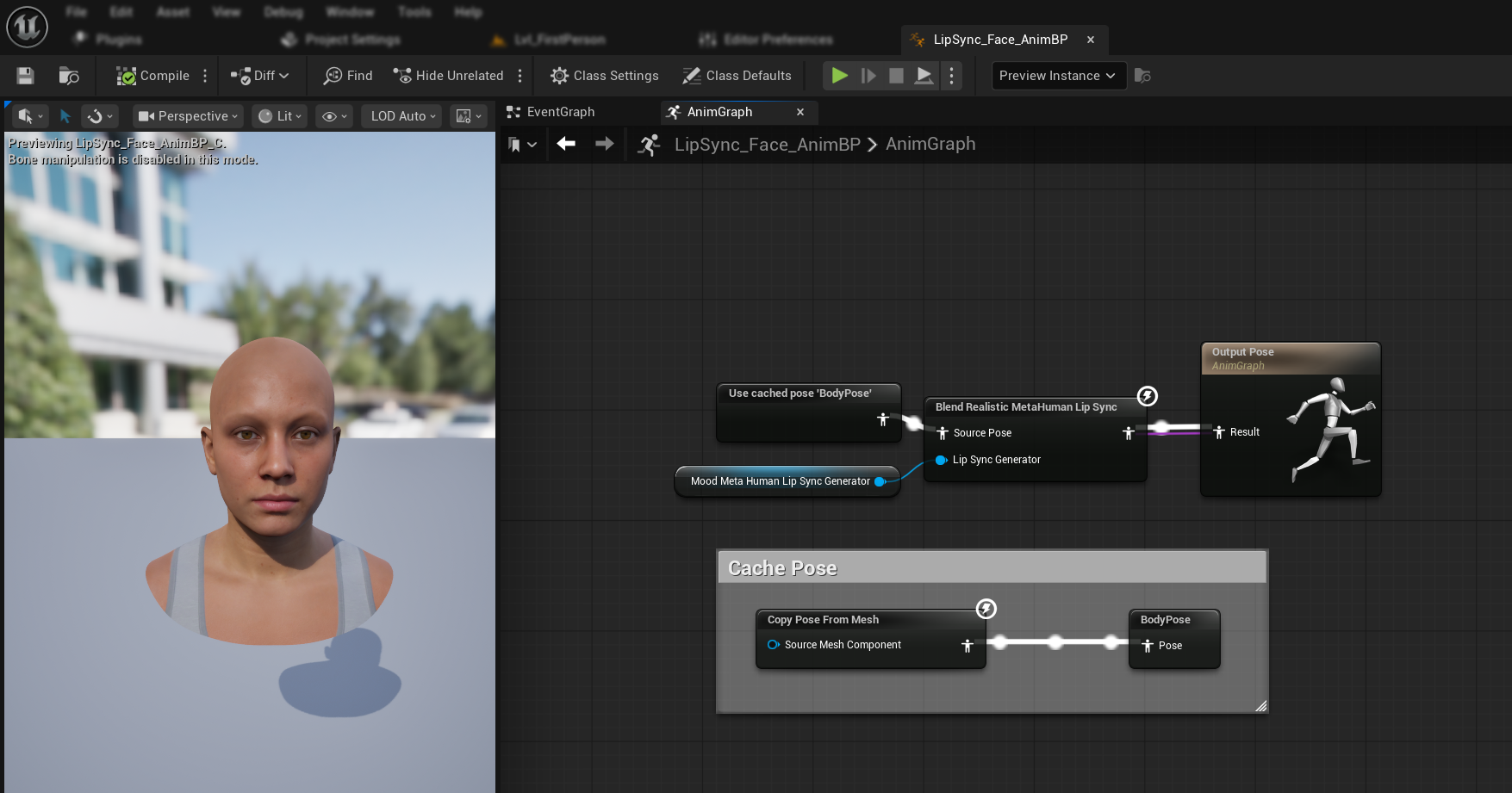

- MetaHuman の顔を含むポーズを見つけます(通常は

Use cached pose 'Body Pose'から) Blend Realistic MetaHuman Lip Syncノードを追加します(通常のリアリスティックモデルと同じノード)- ポーズを

Blend Realistic MetaHuman Lip SyncノードのSource Poseに接続します - あなたの

MoodMetaHumanLipSyncGenerator変数をLip Sync Generatorピンに接続します Blend Realistic MetaHuman Lip Syncノードの出力をOutput PoseのResultピンに接続します

注記: ムード対応モデルは、通常のリアリスティックモデルと同じ Animation Blueprint ノードを使用します。ムード機能はジェネレーター内部で処理されます。

次のステップ

基本的な Animation Blueprint の設定が完了したので、リップシンクジェネレーターにオーディオデータを供給するためのオーディオ入力処理を設定する必要があります。

マイクキャプチャ、テキスト読み上げ、オーディオファイル処理など、さまざまなオーディオ入力方法を設定する方法については、オーディオ処理ガイドに進んでください。 高度な設定オプションと微調整については、設定ガイドを参照してください。