플러그인 설정

모델 설정

표준 모델 설정

Create Runtime Viseme Generator 노드는 대부분의 시나리오에 잘 작동하는 기본 설정을 사용합니다. 설정은 애니메이션 블루프린트 블렌딩 노드 속성을 통해 처리됩니다.

애니메이션 블루프린트 설정 옵션은 아래 Lip Sync Configuration 섹션을 참조하세요.

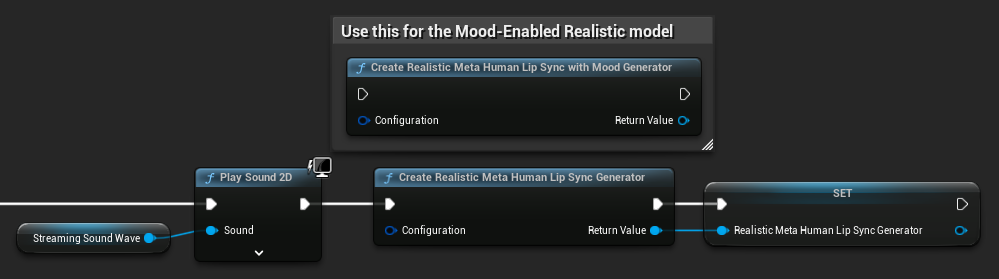

사실적 모델 설정

Create Realistic MetaHuman Lip Sync Generator 노드는 생성기의 동작을 사용자 정의할 수 있는 선택적 Configuration 매개변수를 허용합니다:

모델 유형

Model Type 설정은 사용할 사실적 모델의 버전을 결정합니다:

| 모델 유형 | 성능 | 시각적 품질 | 노이즈 처리 | 권장 사용 사례 |

|---|---|---|---|---|

| Highly Optimized (기본값) | 최고 성능, 최저 CPU 사용량 | 좋은 품질 | 배경 노이즈 또는 비음성 소리에서 눈에 띄는 입 움직임이 나타날 수 있음 | 깨끗한 오디오 환경, 성능이 중요한 시나리오 |

| Semi-Optimized | 좋은 성능, 중간 수준 CPU 사용량 | 높은 품질 | 노이즈가 있는 오디오에서 더 나은 안정성 | 균형 잡힌 성능과 품질, 혼합된 오디오 조건 |

| Original | 최신 CPU에서 실시간 사용에 적합 | 최고 품질 | 배경 노이즈 및 비음성 소리에서 가장 안정적 | 고품질 제작, 노이즈가 많은 오디오 환경, 최대 정확도가 필요할 때 |

성능 설정

Intra Op Threads: 내부 모델 처리 작업에 사용되는 스레드 수를 제어합니다.

- 0 (기본값/자동): 자동 감지 사용 (일반적으로 사용 가능한 CPU 코어의 1/4, 최대 4개)

- 1-16: 스레드 수를 수동으로 지정. 값이 높을수록 멀티코어 시스템에서 성능이 향상될 수 있지만 더 많은 CPU를 사용함

Inter Op Threads: 서로 다른 모델 작업의 병렬 실행에 사용되는 스레드 수를 제어합니다.

- 0 (기본값/자동): 자동 감지 사용 (일반적으로 사용 가능한 CPU 코어의 1/8, 최대 2개)

- 1-8: 스레드 수를 수동으로 지정. 실시간 처리에는 일반적으로 낮게 유지됨

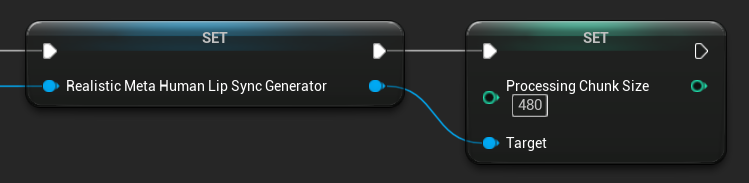

처리 청크 크기

Processing Chunk Size는 각 추론 단계에서 처리할 샘플 수를 결정합니다. 기본값은 160 샘플 (16kHz에서 10ms 오디오)입니다:

- 값이 작을수록 업데이트가 더 자주 발생하지만 CPU 사용량이 증가합니다

- 값이 클수록 CPU 부하가 감소하지만 립싱크 반응성이 떨어질 수 있습니다

- 최적의 정렬을 위해 160의 배수를 사용하는 것이 권장됩니다

무드 지원 모델 설정

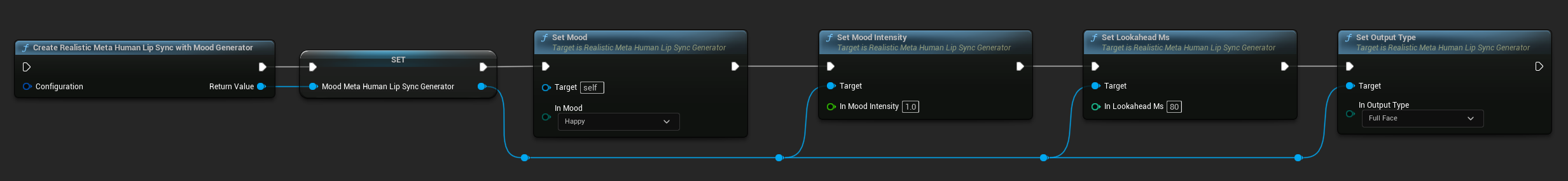

Create Realistic MetaHuman Lip Sync With Mood Generator 노드는 기본 사실적 모델을 넘어서는 추가 설정 옵션을 제공합니다:

기본 설정

Lookahead Ms: 립싱크 정확도를 향상시키기 위한 선행 타이밍(밀리초).

- 기본값: 80ms

- 범위: 20ms ~ 200ms (20으로 나누어 떨어져야 함)

- 값이 높을수록 동기화가 더 좋아지지만 지연 시간이 증가함

Output Type: 생성되는 얼굴 컨트롤을 제어합니다.

- Full Face: 모든 81개의 얼굴 컨트롤 (눈썹, 눈, 코, 입, 턱, 혀)

- Mouth Only: 입, 턱 및 혀 관련 컨트롤만

Performance Settings: 일반 사실적 모델과 동일한 Intra Op Threads 및 Inter Op Threads 설정을 사용합니다.

무드 설정

사용 가능한 무드:

- Neutral, Happy, Sad, Disgust, Anger, Surprise, Fear

- Confident, Excited, Bored, Playful, Confused

Mood Intensity: 무드가 애니메이션에 영향을 미치는 강도를 제어합니다 (0.0 ~ 1.0)

런타임 무드 제어

다음 함수를 사용하여 런타임 중에 무드 설정을 조정할 수 있습니다:

- Set Mood: 현재 무드 유형 변경

- Set Mood Intensity: 무드가 애니메이션에 영향을 미치는 강도 조정 (0.0 ~ 1.0)

- Set Lookahead Ms: 동기화를 위한 선행 타이밍 수정

- Set Output Type: Full Face와 Mouth Only 컨트롤 간 전환

무드 선택 가이드

콘텐츠에 따라 적절한 무드를 선택하세요:

| 무드 | 최적 용도 | 일반적인 강도 범위 |

|---|---|---|

| Neutral | 일반 대화, 내레이션, 기본 상태 | 0.5 - 1.0 |

| Happy | 긍정적인 콘텐츠, 유쾌한 대화, 축하 장면 | 0.6 - 1.0 |

| Sad | 우울한 콘텐츠, 감정적인 장면, 슬픈 순간 | 0.5 - 0.9 |

| Disgust | 부정적인 반응, 혐오스러운 콘텐츠, 거부 | 0.4 - 0.8 |

| Anger | 공격적인 대화, 대립 장면, 좌절감 | 0.6 - 1.0 |

| Surprise | 예상치 못한 사건, 폭로, 충격 반응 | 0.7 - 1.0 |

| Fear | 위협적인 상황, 불안, 긴장된 대화 | 0.5 - 0.9 |

| Confident | 전문적인 프레젠테이션, 리더십 대화, 단호한 발언 | 0.7 - 1.0 |

| Excited | 활기찬 콘텐츠, 발표, 열정적인 대화 | 0.8 - 1.0 |

| Bored | 단조로운 콘텐츠, 무관심한 대화, 지친 발언 | 0.3 - 0.7 |

| Playful | 캐주얼 대화, 유머, 가벼운 상호작용 | 0.6 - 0.9 |

| Confused | 질문이 많은 대화, 불확실성, 당혹감 | 0.4 - 0.8 |

애니메이션 블루프린트 설정

립싱크 설정

- Standard Model

- Realistic Models

Blend Runtime MetaHuman Lip Sync 노드는 속성 패널에 설정 옵션이 있습니다:

| 속성 | 기본값 | 설명 |

|---|---|---|

| Interpolation Speed | 25 | 입 움직임이 비시임 사이를 전환하는 속도를 제어합니다. 값이 높을수록 더 빠르고 급격한 전환이 발생합니다. |

| Reset Time | 0.2 | 립싱크가 재설정되는 시간(초)입니다. 이는 오디오가 중지된 후에도 립싱크가 계속되는 것을 방지하는 데 유용합니다. |

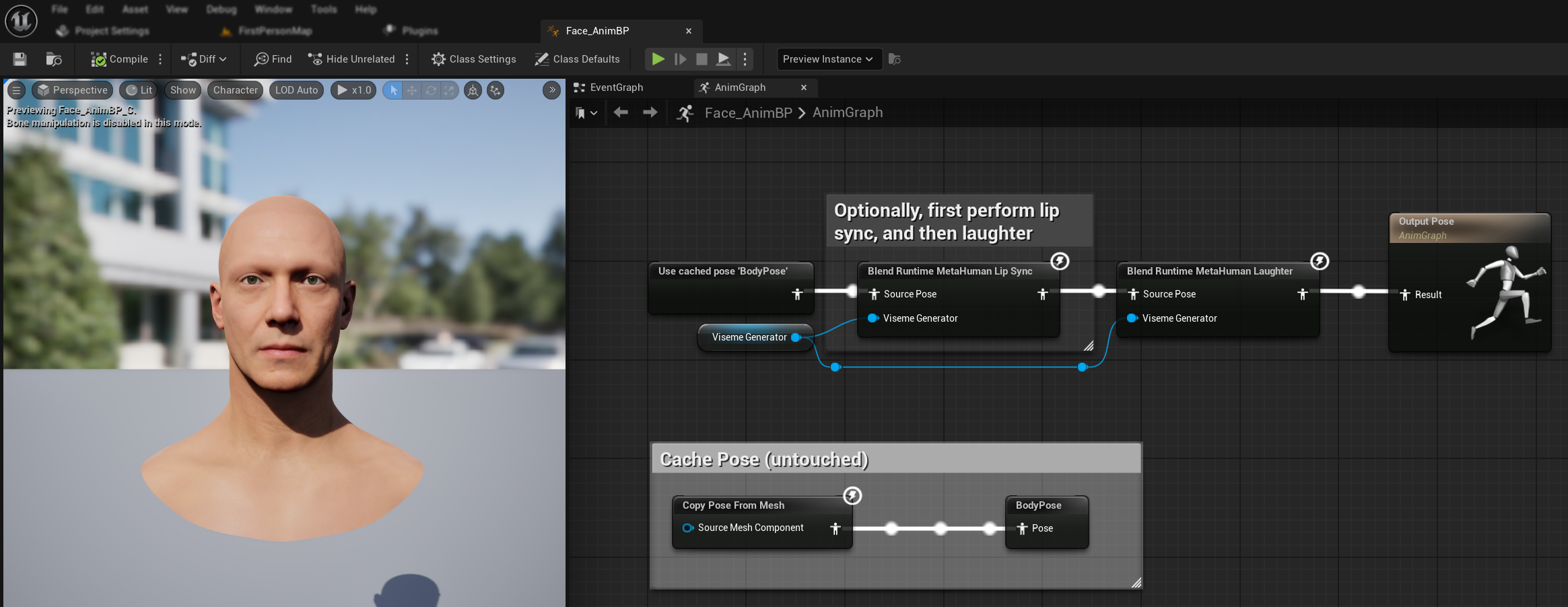

웃음 애니메이션

오디오에서 감지된 웃음에 동적으로 반응하는 웃음 애니메이션을 추가할 수도 있습니다:

Blend Runtime MetaHuman Laughter노드 추가RuntimeVisemeGenerator변수를Viseme Generator핀에 연결- 이미 립싱크를 사용 중인 경우:

Blend Runtime MetaHuman Lip Sync노드의 출력을Blend Runtime MetaHuman Laughter노드의Source Pose에 연결Blend Runtime MetaHuman Laughter노드의 출력을Output Pose의Result핀에 연결

- 립싱크 없이 웃음만 사용하는 경우:

- 소스 포즈를 직접

Blend Runtime MetaHuman Laughter노드의Source Pose에 연결 - 출력을

Result핀에 연결

- 소스 포즈를 직접

오디오에서 웃음이 감지되면 캐릭터가 그에 따라 동적으로 애니메이션됩니다:

웃음 구성

Blend Runtime MetaHuman Laughter 노드에는 자체 구성 옵션이 있습니다:

| 속성 | 기본값 | 설명 |

|---|---|---|

| 보간 속도 | 25 | 웃음 애니메이션 사이에서 입술 움직임이 전환되는 속도를 제어합니다. 값이 높을수록 더 빠르고 갑작스러운 전환이 일어납니다. |

| 재설정 시간 | 0.2 | 웃음이 재설정되기까지의 지속 시간(초)입니다. 오디오가 멈춘 후에도 웃음이 계속되는 것을 방지하는 데 유용합니다. |

| 최대 웃음 가중치 | 0.7 | 웃음 애니메이션의 최대 강도를 조절합니다 (0.0 - 1.0). |

참고: 웃음 감지는 현재 Standard Model에서만 사용할 수 있습니다.

Blend Realistic MetaHuman Lip Sync 노드는 속성 패널에 구성 옵션이 있습니다:

| 속성 | 기본값 | 설명 |

|---|---|---|

| 보간 속도 | 30 | 활성 발화 중 얼굴 표정이 전환되는 속도를 제어합니다. 값이 높을수록 더 빠르고 갑작스러운 전환이 일어납니다. |

| 유휴 상태 보간 속도 | 15 | 얼굴 표정이 유휴/중립 상태로 돌아가는 속도를 제어합니다. 값이 낮을수록 더 부드럽고 점진적으로 휴식 자세로 돌아갑니다. |

| 재설정 시간 | 0.2 | 립싱크가 유휴 상태로 재설정되기까지의 지속 시간(초)입니다. 오디오가 멈춘 후에도 표정이 계속되는 것을 방지하는 데 유용합니다. |

| 유휴 상태 유지 | false | 활성화되면, 중립 상태로 재설정하는 대신 유휴 기간 동안 마지막 감정 상태를 유지합니다. |

| 눈 표정 유지 | true | 유휴 상태 동안 눈과 관련된 얼굴 컨트롤을 유지할지 여부를 제어합니다. '유휴 상태 유지'가 활성화된 경우에만 효과가 있습니다. |

| 눈썹 표정 유지 | true | 유휴 상태 동안 눈썹과 관련된 얼굴 컨트롤을 유지할지 여부를 제어합니다. '유휴 상태 유지'가 활성화된 경우에만 효과가 있습니다. |

| 입 모양 유지 | false | 유휴 상태 동안 입 모양 컨트롤(혀와 턱과 같은 발화 특정 움직임 제외)을 유지할지 여부를 제어합니다. '유휴 상태 유지'가 활성화된 경우에만 효과가 있습니다. |

유휴 상태 유지

유휴 상태 유지 기능은 Realistic 모델이 침묵 기간을 처리하는 방식을 다룹니다. 침묵 중 일관되게 0 값으로 돌아가는 이산적인 비젬을 사용하는 Standard 모델과 달리, Realistic 모델의 신경망은 MetaHuman의 기본 휴식 자세와 다른 미세한 얼굴 위치를 유지할 수 있습니다.

활성화 시기:

- 발화 세그먼트 사이에서 감정 표현 유지

- 캐릭터 성격 특성 보존

- 시네마틱 시퀀스에서 시각적 연속성 보장

지역별 제어 옵션:

- 눈 표정: 눈 찡그림, 확대 및 눈꺼풀 위치 유지

- 눈썹 표정: 눈썹과 이마 위치 유지

- 입 모양: 발화 움직임(혀, 턱)이 재설정되는 동안 일반적인 입 곡선 유지

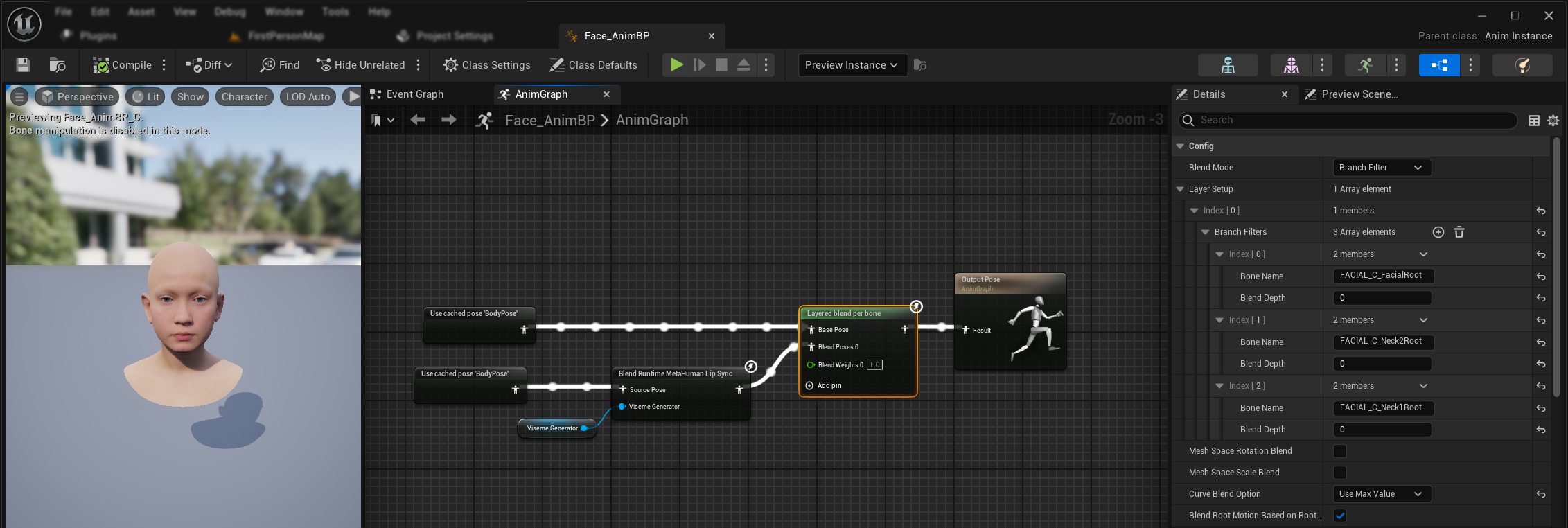

기존 애니메이션과 결합

기존 바디 애니메이션과 커스텀 얼굴 애니메이션을 덮어쓰지 않고 립싱크 및 웃음을 적용하려면:

- 바디 애니메이션과 최종 출력 사이에

Layered blend per bone노드를 추가합니다.Use Attached Parent가 true인지 확인하세요. - 레이어 설정 구성:

Layer Setup배열에 1개의 항목 추가- 레이어의

Branch Filters에 3개의 항목을 추가하고, 다음Bone Name을 지정합니다:FACIAL_C_FacialRootFACIAL_C_Neck2RootFACIAL_C_Neck1Root

- 커스텀 얼굴 애니메이션에 중요:

Curve Blend Option에서 "Use Max Value" 를 선택합니다. 이를 통해 커스텀 얼굴 애니메이션(표정, 감정 등)이 립싱크 위에 제대로 레이어될 수 있습니다. - 연결하기:

- 기존 애니메이션(예:

BodyPose) →Base Pose입력 - 얼굴 애니메이션 출력(립싱크 및/또는 웃음 노드에서) →

Blend Poses 0입력 - Layered blend 노드 → 최종

Result포즈

- 기존 애니메이션(예:

Morph Target 세트 선택

- Standard Model

- Realistic Models

Standard Model은 커스텀 포즈 애셋 설정을 통해 모든 morph target 명명 규칙을 본질적으로 지원하는 포즈 애셋을 사용합니다. 추가 구성이 필요하지 않습니다.

Blend Realistic MetaHuman Lip Sync 노드는 얼굴 애니메이션에 사용할 morph target 명명 규칙을 결정하는 Morph Target Set 속성을 포함합니다:

| Morph Target 세트 | 설명 | 사용 사례 |

|---|---|---|

| MetaHuman (기본값) | 표준 MetaHuman morph target 이름 (예: CTRL_expressions_jawOpen) | MetaHuman 캐릭터 |

| ARKit | Apple ARKit 호환 이름 (예: JawOpen, MouthSmileLeft) | ARKit 기반 캐릭터 |

립싱크 동작 미세 조정

혀 돌출 제어

표준 립싱크 모델에서는 특정 음소에서 과도한 앞쪽 혀 움직임을 볼 수 있습니다. 혀 돌출을 제어하려면:

- 립싱크 블렌드 노드 뒤에

Modify Curve노드를 추가합니다 Modify Curve노드를 우클릭하고 Add Curve Pin 선택- 이름이

CTRL_expressions_tongueOut인 커브 핀 추가 - 노드의 Apply Mode 속성을 Scale로 설정

- Value 매개변수를 조정하여 혀 확장을 제어합니다 (예: 0.8은 돌출을 20% 감소시킴)

턱 열림 제어

Realistic 립싱크는 오디오 콘텐츠와 시각적 요구 사항에 따라 지나치게 반응적인 턱 움직임을 생성할 수 있습니다. 턱 열림 강도를 조정하려면:

- 립싱크 블렌드 노드 뒤에

Modify Curve노드를 추가합니다 Modify Curve노드를 우클릭하고 Add Curve Pin 선택- 이름이

CTRL_expressions_jawOpen인 커브 핀 추가 - 노드의 Apply Mode 속성을 Scale로 설정

- Value 매개변수를 조정하여 턱 열림 범위를 제어합니다 (예: 0.9는 턱 움직임을 10% 감소시킴)

기분별 미세 조정

기분 활성화 모델의 경우 특정 감정 표현을 미세 조정할 수 있습니다:

눈썹 제어:

CTRL_expressions_browRaiseInL/CTRL_expressions_browRaiseInR- 안쪽 눈썹 올리기CTRL_expressions_browRaiseOuterL/CTRL_expressions_browRaiseOuterR- 바깥쪽 눈썹 올리기CTRL_expressions_browDownL/CTRL_expressions_browDownR- 눈썹 내리기

눈 표정 제어:

CTRL_expressions_eyeSquintInnerL/CTRL_expressions_eyeSquintInnerR- 눈 찡그림CTRL_expressions_eyeCheekRaiseL/CTRL_expressions_eyeCheekRaiseR- 볼 올리기

모델 비교 및 선택

모델 선택

프로젝트에 사용할 립싱크 모델을 결정할 때 다음 요소를 고려하세요:

| 고려 사항 | Standard Model | Realistic Model | Mood-Enabled Realistic Model |

|---|---|---|---|

| 캐릭터 호환성 | MetaHumans 및 모든 커스텀 캐릭터 유형 | MetaHumans (및 ARKit) 캐릭터 | MetaHumans (및 ARKit) 캐릭터 |

| 시각적 품질 | 효율적인 성능으로 좋은 립싱크 | 더 자연스러운 입 움직임으로 향상된 사실감 | 감정 표현이 있는 향상된 사실감 |

| 성능 | 모바일/VR을 포함한 모든 플랫폼에 최적화 | 더 높은 리소스 요구 사항 | 더 높은 리소스 요구 사항 |

| 기능 | 14개의 비젬, 웃음 감지 | 81개의 얼굴 컨트롤, 3가지 최적화 수준 | 81개의 얼굴 컨트롤, 12가지 기분, 구성 가능한 출력 |

| 플랫폼 지원 | Windows, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest | Windows, Mac, iOS, Linux, Android, Quest |

| 사용 사례 | 일반 애플리케이션, 게임, VR/AR, 모바일 | 시네마틱 경험, 클로즈업 상호작용 | 감정적 스토리텔링, 고급 캐릭터 상호작용 |

엔진 버전 호환성

Unreal Engine 5.2를 사용하는 경우, UE의 리샘플링 라이브러리 버그로 인해 Realistic Models가 올바르게 작동하지 않을 수 있습니다. UE 5.2 사용자 중 안정적인 립싱크 기능이 필요한 경우, 대신 Standard Model을 사용하십시오.

이 문제는 UE 5.2에만 해당되며 다른 엔진 버전에는 영향을 미치지 않습니다.

성능 권장 사항

- 대부분의 프로젝트에서 Standard Model은 품질과 성능의 훌륭한 균형을 제공합니다

- MetaHuman 캐릭터에 최고의 시각적 충실도가 필요할 때 Realistic Model을 사용하세요

- 애플리케이션에 감정 표현 제어가 중요할 때 Mood-Enabled Realistic Model을 사용하세요

- 모델 선택 시 대상 플랫폼의 성능 능력을 고려하세요

- 특정 사용 사례에 가장 적합한 균형을 찾기 위해 다양한 최적화 수준을 테스트하세요

문제 해결

일반적인 문제

Realistic Models용 생성기 재생성: Realistic Models의 안정적이고 일관된 작동을 위해, 비활성 기간 후 새로운 오디오 데이터를 공급하려고 할 때마다 생성기를 재생성하는 것이 권장됩니다. 이는 침묵 기간 후 생성기를 재사용할 때 립싱크 작동이 멈출 수 있는 ONNX 런타임 동작 때문입니다.

예를 들어, Play Sound 2D를 호출하거나 사운드 웨이브 재생 및 립싱크를 시작하는 다른 방법을 사용할 때마다와 같이 모든 재생 시작 시 립싱크 생성기를 재생성할 수 있습니다:

Runtime Text To Speech 통합을 위한 플러그인 위치: Runtime MetaHuman Lip Sync를 Runtime Text To Speech와 함께 사용할 때(두 플러그인 모두 ONNX Runtime 사용), 플러그인이 엔진의 Marketplace 폴더에 설치된 경우 패키징된 빌드에서 문제가 발생할 수 있습니다. 이를 해결하려면:

- UE 설치 폴더의

\Engine\Plugins\Marketplace아래에서 두 플러그인을 찾습니다 (예:C:\Program Files\Epic Games\UE_5.6\Engine\Plugins\Marketplace) RuntimeMetaHumanLipSync및RuntimeTextToSpeech폴더를 모두 프로젝트의Plugins폴더로 이동합니다- 프로젝트에

Plugins폴더가 없는 경우,.uproject파일과 같은 디렉토리에 하나를 생성합니다 - Unreal Editor를 재시작합니다

이는 엔진의 Marketplace 디렉토리에서 여러 ONNX Runtime 기반 플러그인이 로드될 때 발생할 수 있는 호환성 문제를 해결합니다.

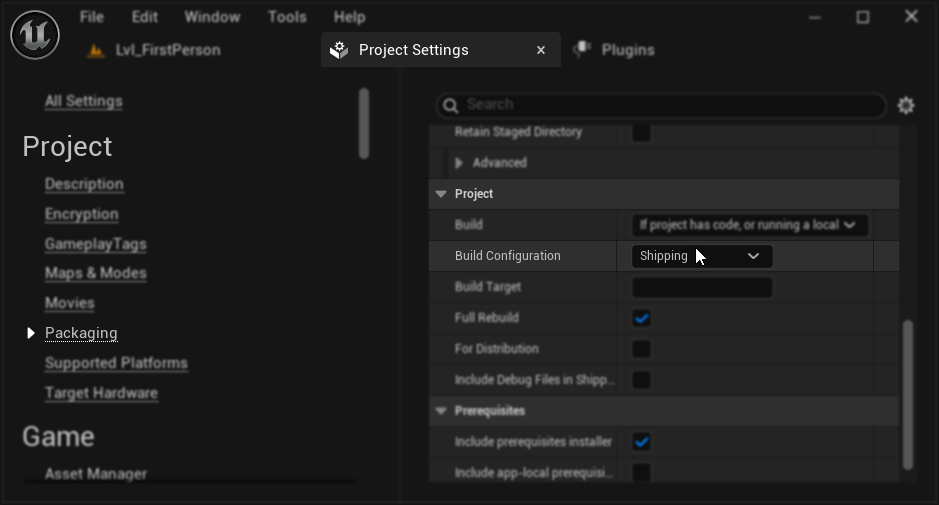

패키징 구성 (Windows): Windows에서 패키징된 프로젝트에서 립싱크가 올바르게 작동하지 않는 경우, Development 대신 Shipping 빌드 구성을 사용하고 있는지 확인하세요. Development 구성은 패키징된 빌드에서 Realistic models ONNX 런타임에 문제를 일으킬 수 있습니다.

이를 해결하려면:

- 프로젝트 설정 → Packaging에서 Build Configuration을 Shipping으로 설정합니다

- 프로젝트를 다시 패키징합니다

일부 Blueprint-only 프로젝트에서는 Shipping이 선택된 경우에도 Unreal Engine이 여전히 Development 구성으로 빌드할 수 있습니다. 이 경우, 프로젝트를 C++ 프로젝트로 변환하여 최소한 하나의 C++ 클래스를 추가하세요(비어 있어도 됩니다). 이를 위해 UE 에디터 메뉴에서 Tools → New C++ Class로 이동하여 빈 클래스를 생성합니다. 이렇게 하면 프로젝트가 Shipping 구성으로 올바르게 빌드됩니다. 프로젝트는 기능적으로 Blueprint-only로 유지될 수 있으며, C++ 클래스는 적절한 빌드 구성을 위해서만 필요합니다.

립싱크 반응성 저하: Streaming Sound Wave 또는 Capturable Sound Wave를 사용할 때 시간이 지남에 따라 립싱크 반응성이 떨어지는 경우, 이는 메모리 누적 때문일 수 있습니다. 기본적으로 메모리는 새로운 오디오가 추가될 때마다 재할당됩니다. 이 문제를 방지하려면, 예를 들어 30초마다 주기적으로 ReleaseMemory 함수를 호출하여 누적된 메모리를 해제하세요.

성능 최적화:

- 성능 요구 사항에 따라 Realistic 모델의 Processing Chunk Size를 조정하세요

- 대상 하드웨어에 적합한 스레드 수를 사용하세요

- 전체 얼굴 애니메이션이 필요하지 않을 때 Mood-Enabled 모델에 Mouth Only 출력 유형 사용을 고려하세요