설정 가이드

이 가이드는 MetaHuman 캐릭터와 함께 Runtime MetaHuman Lip Sync를 위한 기본 설정 과정을 안내합니다.

참고: Runtime MetaHuman Lip Sync는 MetaHuman과 커스텀 캐릭터 모두와 함께 작동합니다. 커스텀 캐릭터 설정에 대한 자세한 지침은 커스텀 캐릭터 설정 가이드를 참조하세요.

필수 조건

시작하기 전에 다음을 확인하세요:

-

MetaHuman 플러그인 요구사항:

- UE 5.5 및 이전 버전: 프로젝트에서 MetaHuman 플러그인을 활성화하세요

- UE 5.6 및 이후 버전: 프로젝트에서 MetaHuman Core Tech 플러그인을 활성화하세요

추가 MetaHuman 플러그인MetaHuman 캐릭터를 생성하는 방법에 따라 추가 플러그인이 필요할 수 있습니다. 예를 들어, UE 5.6에서 도입된 새로운 MetaHuman Creator 시스템으로 MetaHuman을 생성하려는 경우 MetaHuman Creator 플러그인도 활성화해야 합니다. 이 시스템에 대한 자세한 내용은 MetaHuman Creator 문서를 참조하세요.

-

프로젝트에 최소 하나 이상의 MetaHuman 캐릭터가 다운로드되어 사용 가능한 상태입니다

-

Runtime MetaHuman Lip Sync 플러그인이 설치되어 있습니다

표준 모델 확장 플러그인

표준 모델을 사용할 계획이라면 확장 플러그인을 설치해야 합니다:

- Google Drive에서 Standard Lip Sync Extension plugin을 다운로드하세요

- 다운로드한 아카이브에서 폴더를 추출하여 프로젝트의

Plugins폴더에 넣으세요 (해당 폴더가 없으면 생성하세요) - 프로젝트가 C++ 프로젝트로 설정되어 있는지 확인하세요 (C++ 코드가 없더라도)

- 프로젝트를 재빌드하세요

- 이 확장은 표준 모델을 사용하려는 경우에만 필요합니다. 리얼리스틱 모델만 필요하다면 이 단계를 건너뛸 수 있습니다.

- 플러그인을 수동으로 빌드하는 방법에 대한 자세한 내용은 플러그인 빌드 튜토리얼을 참조하세요

추가 플러그인

- 오디오 캡처 (예: 마이크 입력)를 사용할 계획이라면 Runtime Audio Importer 플러그인을 설치하세요.

- 텍스트 음성 변환 기능을 사용할 계획이라면:

- 로컬 TTS (표준 모델 및 무드 지원 리얼리스틱 모델)의 경우 Runtime Text To Speech 플러그인을 설치하세요.

- 외부 TTS 제공업체 (ElevenLabs, OpenAI, Google Cloud, Azure)의 경우 Runtime AI Chatbot Integrator 플러그인을 설치하세요.

애니메이션 블루프린트 설정

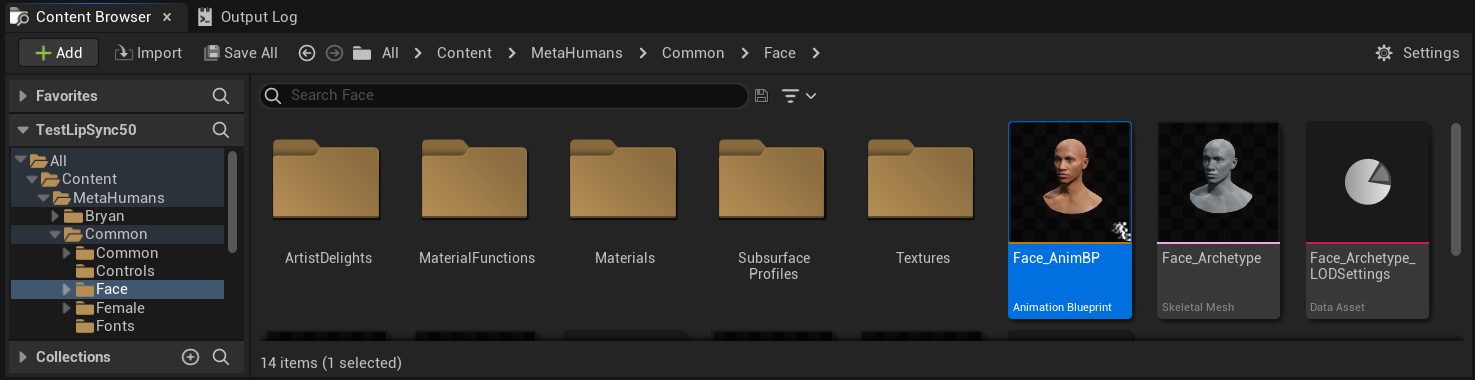

1단계: 얼굴 애니메이션 Blueprint 찾기 및 수정

- UE 5.5 및 이전 버전 (또는 UE 5.6+의 레거시 MetaHumans)

- UE 5.6+ MetaHuman Creator 캐릭터

MetaHuman 캐릭터의 얼굴 애니메이션에 사용될 Animation Blueprint를 수정해야 합니다. 기본 MetaHuman 얼굴 Animation Blueprint는 다음 위치에 있습니다:

Content/MetaHumans/Common/Face/Face_AnimBP

립 싱크 기능을 구현하는 데에는 여러 옵션이 있습니다:

- 기본 애셋 편집 (가장 간단한 옵션)

- 복제본 생성

- 사용자 정의 Animation Blueprint 사용

기본 Face_AnimBP를 직접 열고 수정합니다. 모든 변경 사항은 이 Animation Blueprint를 사용하는 모든 MetaHuman 캐릭터에 영향을 미칩니다.

참고: 이 접근 방식은 편리하지만 기본 Animation Blueprint를 사용하는 모든 캐릭터에 영향을 미칩니다.

Face_AnimBP를 복제하고 설명이 포함된 이름을 지정합니다- 캐릭터의 Blueprint 클래스를 찾습니다 (예: "Bryan" 캐릭터의 경우

Content/MetaHumans/Bryan/BP_Bryan에 위치) - 캐릭터 Blueprint를 열고 Face 컴포넌트를 찾습니다

- Anim Class 속성을 새로 복제한 Animation Blueprint로 변경합니다

참고: 이 접근 방식을 사용하면 다른 캐릭터는 변경하지 않고 특정 캐릭터에 대한 립 싱크를 사용자 정의할 수 있습니다.

필요한 얼굴 뼈에 접근할 수 있는 모든 Animation Blueprint에서 립 싱크 블렌딩을 구현할 수 있습니다:

- 사용자 정의 Animation Blueprint를 생성하거나 기존 것을 사용합니다

- Animation Blueprint가 기본 MetaHuman의

Face_Archetype_Skeleton과 동일한 얼굴 뼈를 포함하는 스켈레톤과 작동하는지 확인합니다

참고: 이 접근 방식은 사용자 정의 애니메이션 시스템과의 통합을 위한 최대의 유연성을 제공합니다.

UE 5.6부터 새로운 MetaHuman Creator 시스템이 도입되었습니다. 이러한 캐릭터의 경우 플러그인은 다음 위치에 페이스 Animation Blueprint를 제공합니다:

Content/LipSyncData/LipSync_Face_AnimBP

이 Animation Blueprint는 플러그인의 콘텐츠 폴더에 위치하며 각 플러그인 업데이트 시 덮어쓰여집니다. 사용자 정의 내용을 잃지 않으려면:

- 이 애셋을 프로젝트의 Content 폴더로 복사하세요 (예:

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - 캐릭터 설정에서 복사한 버전을 사용하세요

- 복사한 버전에 모든 수정 사항을 적용하세요

플러그인의 얼굴 Animation Blueprint 사용하기:

- MetaHuman Creator 캐릭터의 Blueprint 클래스를 찾으세요

- 캐릭터 Blueprint를 열고 Face 컴포넌트를 찾으세요

- Anim Class 속성을 플러그인의

LipSync_Face_AnimBP로 변경하세요 - Runtime MetaHuman Lip Sync 기능을 구성하기 위한 다음 단계를 계속하세요

2단계: 이벤트 그래프 설정

얼굴 Animation Blueprint를 열고 Event Graph로 전환하세요. 오디오 데이터를 처리하고 립싱크 애니메이션을 생성할 생성기를 만들어야 합니다.

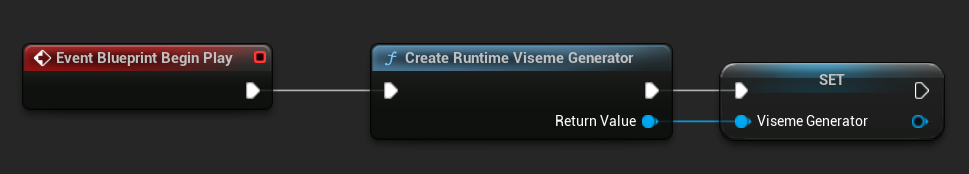

- 표준 모델

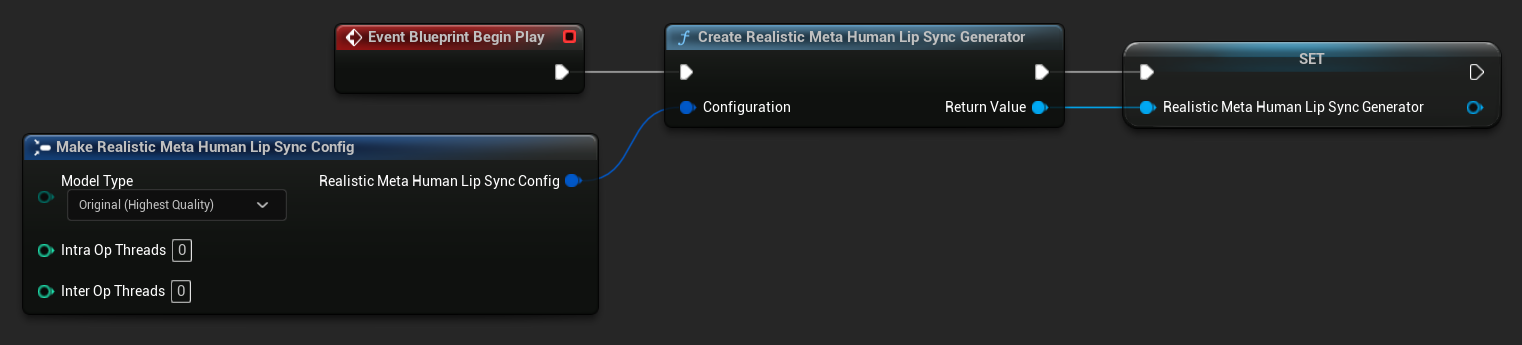

- 리얼리스틱 모델

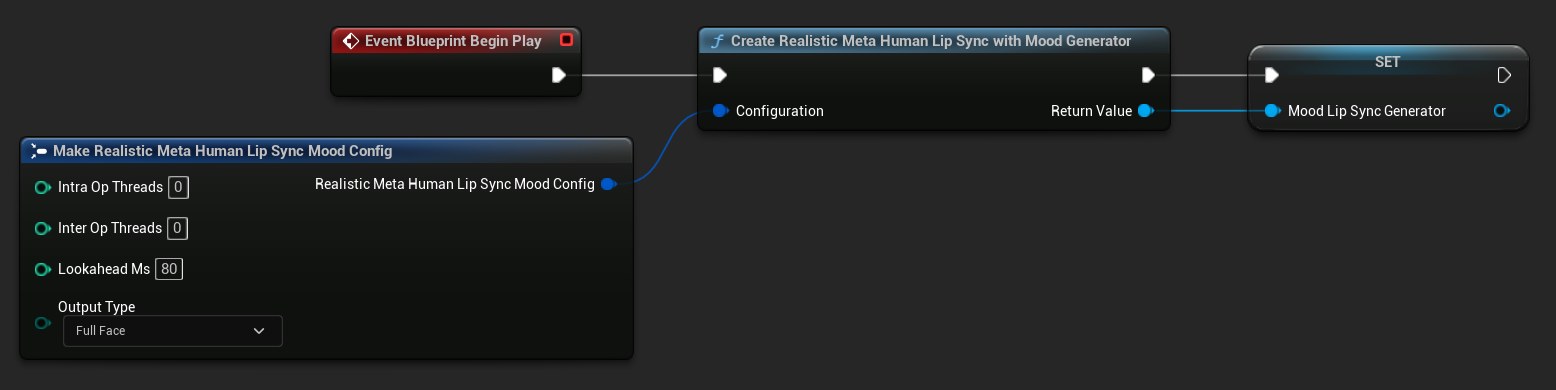

- 무드 지원 리얼리스틱 모델

- 아직 존재하지 않는다면

Event Blueprint Begin Play노드를 추가하세요 Create Runtime Viseme Generator노드를 추가하고 Begin Play 이벤트에 연결하세요- 출력을 변수로 저장하세요 (예: "VisemeGenerator") 그래프의 다른 부분에서 사용하기 위해

자세한 구성 옵션은 표준 모델 구성 섹션을 참조하세요.

- 아직 존재하지 않는다면

Event Blueprint Begin Play노드를 추가하세요 Create Realistic MetaHuman Lip Sync Generator노드를 추가하고 Begin Play 이벤트에 연결하세요- 출력을 변수로 저장하세요 (예: "RealisticMetaHumanLipSyncGenerator") 그래프의 다른 부분에서 사용하기 위해

- (선택사항) Configuration 매개변수를 사용하여 생성기 설정을 구성하세요

모델 유형, 성능 설정 및 처리 매개변수를 포함한 자세한 구성 옵션은 리얼리스틱 모델 구성 섹션을 참조하세요.

- 아직 존재하지 않는다면

Event Blueprint Begin Play노드를 추가하세요 Create Realistic MetaHuman Lip Sync With Mood Generator노드를 추가하고 Begin Play 이벤트에 연결하세요- 출력을 변수로 저장하세요 (예: "MoodMetaHumanLipSyncGenerator") 그래프의 다른 부분에서 사용하기 위해

- (선택사항) Configuration 매개변수를 사용하여 생성기 설정을 구성하세요

무드 구성을 포함한 자세한 내용은 mood 유형, 강도 설정, 미리보기 타이밍 및 출력 유형 선택에 대해서는 Mood-Enabled Model Configuration 섹션을 참조하십시오.

3단계: Anim Graph 설정

Event Graph 설정 후, Anim Graph로 전환하여 생성기를 캐릭터 애니메이션에 연결하십시오:

- Standard Model

- Realistic Model

- Mood-Enabled Realistic Model

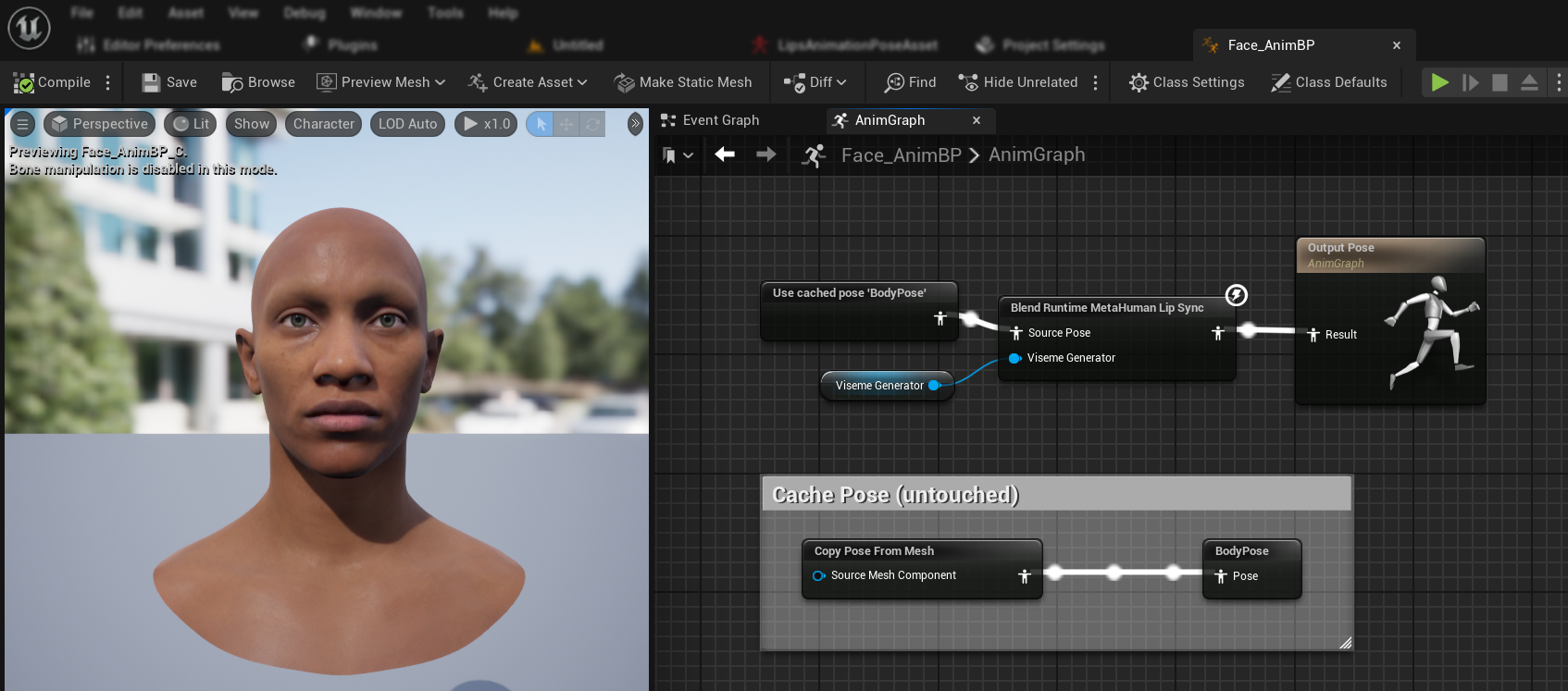

- MetaHuman 얼굴을 포함하는 포즈를 찾습니다 (일반적으로

Use cached pose 'Body Pose'에서 가져옴) Blend Runtime MetaHuman Lip Sync노드를 추가합니다- 포즈를

Blend Runtime MetaHuman Lip Sync노드의Source Pose에 연결합니다 VisemeGenerator변수를Viseme Generator핀에 연결합니다Blend Runtime MetaHuman Lip Sync노드의 출력을Output Pose의Result핀에 연결합니다

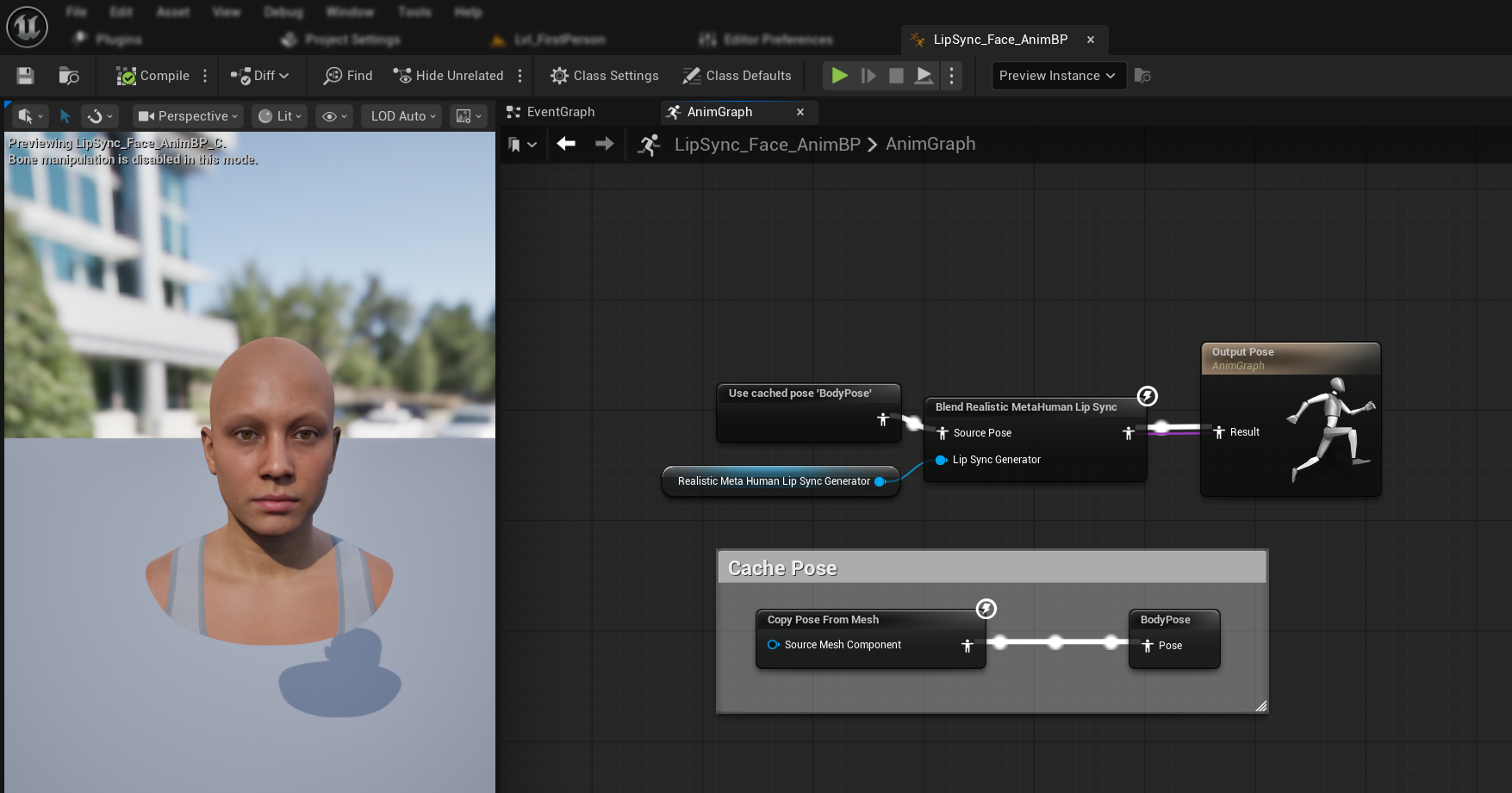

- MetaHuman 얼굴을 포함하는 포즈를 찾습니다 (일반적으로

Use cached pose 'Body Pose'에서 가져옴) Blend Realistic MetaHuman Lip Sync노드를 추가합니다- 포즈를

Blend Realistic MetaHuman Lip Sync노드의Source Pose에 연결합니다 RealisticMetaHumanLipSyncGenerator변수를Lip Sync Generator핀에 연결합니다Blend Realistic MetaHuman Lip Sync노드의 출력을Output Pose의Result핀에 연결합니다

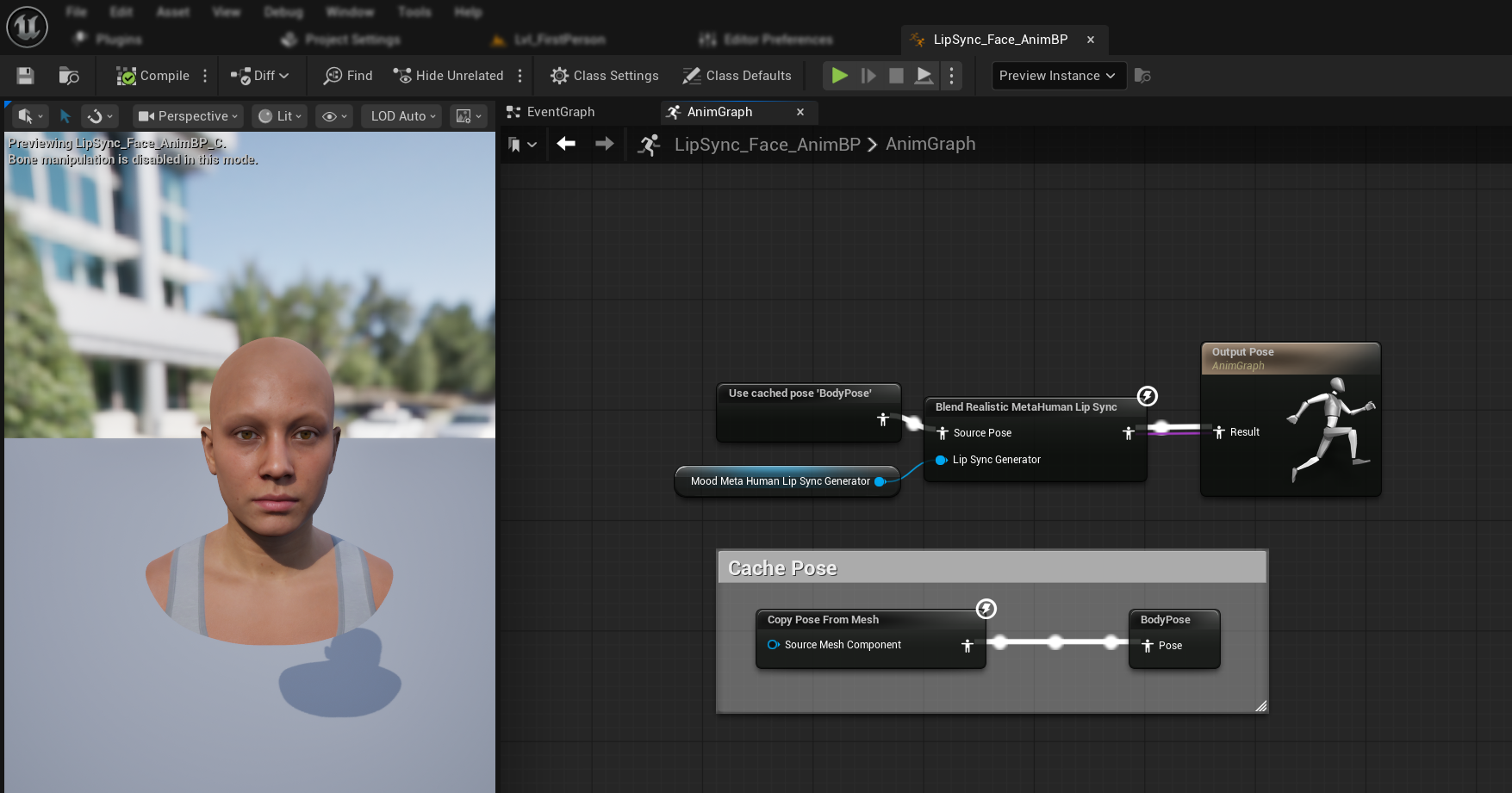

- MetaHuman 얼굴을 포함하는 포즈를 찾습니다 (일반적으로

Use cached pose 'Body Pose'에서 가져옴) Blend Realistic MetaHuman Lip Sync노드를 추가합니다 (일반 리얼리스틱 모델과 동일한 노드)- 포즈를

Blend Realistic MetaHuman Lip Sync노드의Source Pose에 연결합니다 MoodMetaHumanLipSyncGenerator변수를Lip Sync Generator핀에 연결합니다Blend Realistic MetaHuman Lip Sync노드의 출력을Output Pose의Result핀에 연결합니다

참고: mood-enabled 모델은 일반 리얼리스틱 모델과 동일한 Animation Blueprint 노드를 사용합니다. mood 기능은 생성기 내부에서 처리됩니다.

다음 단계

이제 기본 Animation Blueprint 설정이 완료되었으므로, 음성 동기화 생성기에 오디오 데이터를 공급하기 위해 오디오 입력 처리를 구성해야 합니다.

마이크 캡처, 텍스트-음성 변환 및 오디오 파일 처리를 포함한 다양한 오디오 입력 방법을 설정하는 방법을 알아보려면 Audio Processing Guide로 계속 진행하십시오. 고급 구성 옵션 및 미세 조정을 위해서는 구성 가이드를 참조하세요.