Dostawcy tłumaczeń

AI Localization Automator obsługuje pięciu różnych dostawców AI, każdy z unikalnymi zaletami i opcjami konfiguracji. Wybierz dostawcę, który najlepiej odpowiada potrzebom, budżetowi i wymaganiom jakościowym Twojego projektu.

Ollama (Lokalne AI)

Najlepsze dla: Projektów wrażliwych na prywatność, tłumaczeń offline, nieograniczonego użycia

Ollama uruchamia modele AI lokalnie na Twojej maszynie, zapewniając pełną prywatność i kontrolę bez kosztów API i wymagań dotyczących internetu.

Popularne modele

- llama3.2 (Zalecany ogólnego przeznaczenia)

- mistral (Wydajna alternatywa)

- codellama (Tłumaczenia świadome kodu)

- I wiele innych modeli społecznościowych

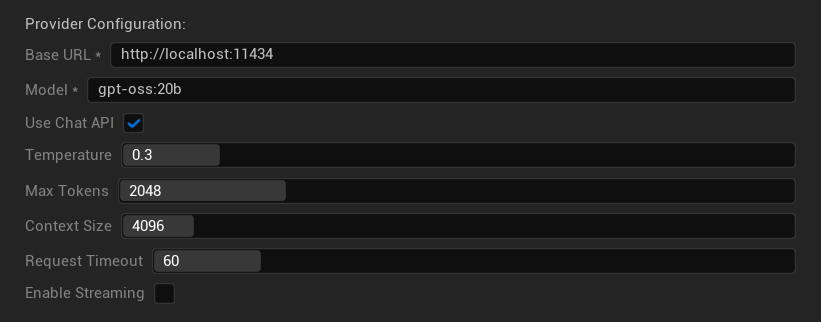

Opcje konfiguracji

- Bazowy URL: Lokalny serwer Ollama (domyślnie:

http://localhost:11434) - Model: Nazwa lokalnie zainstalowanego modelu (wymagane)

- Użyj Chat API: Włącz dla lepszej obsługi konwersacji

- Temperatura: 0.0-2.0 (zalecane 0.3)

- Maks. tokenów: 1-8,192 tokenów

- Rozmiar kontekstu: 512-32,768 tokenów

- Limit czasu żądania: 10-300 sekund (lokalne modele mogą być wolniejsze)

- Włącz streaming: Do przetwarzania odpowiedzi w czasie rzeczywistym

Zalety

- ✅ Pełna prywatność (żadne dane nie opuszczają Twojej maszyny)

- ✅ Brak kosztów API lub limitów użycia

- ✅ Działa offline

- ✅ Pełna kontrola nad parametrami modelu

- ✅ Szeroka gama modeli społecznościowych

- ✅ Brak uzależnienia od dostawcy

Zastrzeżenia

- 💻 Wymaga lokalnej konfiguracji i wydajnego sprzętu

- ⚡ Zazwyczaj wolniejsze niż dostawcy chmurowi

- 🔧 Wymaga bardziej technicznej konfiguracji

- 📊 Jakość tłumaczenia znacząco różni się w zależności od modelu (niektóre mogą przewyższać dostawców chmurowych)

- 💾 Duże wymagania dotyczące przechowywania modeli

Konfigurowanie Ollama

- Zainstaluj Ollama: Pobierz z ollama.ai i zainstaluj w swoim systemie

- Pobierz modele: Użyj

ollama pull llama3.2, aby pobrać wybrany model - Uruchom serwer: Ollama uruchamia się automatycznie lub uruchom go za pomocą

ollama serve - Skonfiguruj wtyczkę: Ustaw bazowy URL i nazwę modelu w ustawieniach wtyczki

- Przetestuj połączenie: Wtyczka zweryfikuje łączność po zastosowaniu konfiguracji

OpenAI

Najlepsze dla: Najwyższej ogólnej jakości tłumaczeń, szerokiego wyboru modeli

OpenAI zapewnia wiodące w branży modele językowe poprzez swoje API, w tym najnowsze modele GPT i nowy format API Responses.

Dostępne modele

- gpt-5 (Najnowszy flagowy model)

- gpt-5-mini (Mniejsza, szybsza wersja)

- gpt-4.1 i gpt-4.1-mini

- gpt-4o i gpt-4o-mini (Zoptymalizowane modele)

- o3 i o3-mini (Zaawansowane rozumowanie)

- o1 i o1-mini (Poprzednia generacja)

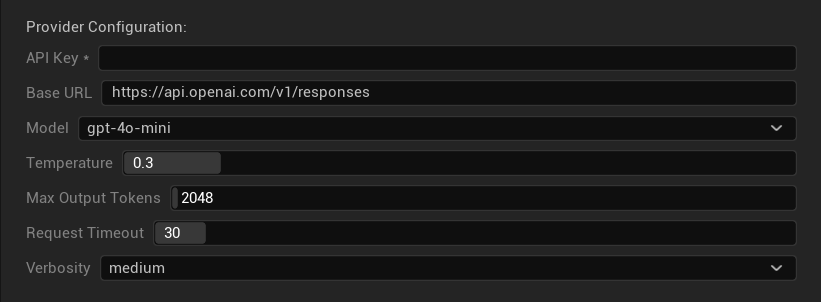

Opcje konfiguracji

- Klucz API: Twój klucz API OpenAI (wymagany)

- Bazowy URL: Punkt końcowy API (domyślnie: serwery OpenAI)

- Model: Wybierz z dostępnych modeli GPT

- Temperatura: 0.0-2.0 (0.3 zalecane dla spójności tłumaczenia)

- Maksymalna liczba tokenów wyjściowych: 1-128,000 tokenów

- Limit czasu żądania: 5-300 sekund

- Poziom szczegółowości: Kontroluj poziom szczegółowości odpowiedzi

Zalety

- ✅ Stale wysokiej jakości tłumaczenia

- ✅ Doskonałe rozumienie kontekstu

- ✅ Silne zachowywanie formatowania

- ✅ Szerokie wsparcie języków

- ✅ Niezawodny czas działania API

Uwagi

- 💰 Wyższy koszt na żądanie

- 🌐 Wymaga połączenia internetowego

- ⏱️ Limity użycia w zależności od poziomu

Anthropic Claude

Najlepszy do: Tłumaczeń nacechowanych niuansami, treści kreatywnych, aplikacji zorientowanych na bezpieczeństwo

Modele Claude doskonale radzą sobie ze zrozumieniem kontekstu i niuansów, co czyni je idealnymi do gier bogatych w narrację i złożonych scenariuszy lokalizacji.

Dostępne modele

- claude-opus-4-1-20250805 (Najnowszy flagowy)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Szybki i wydajny)

- claude-3-haiku-20240307

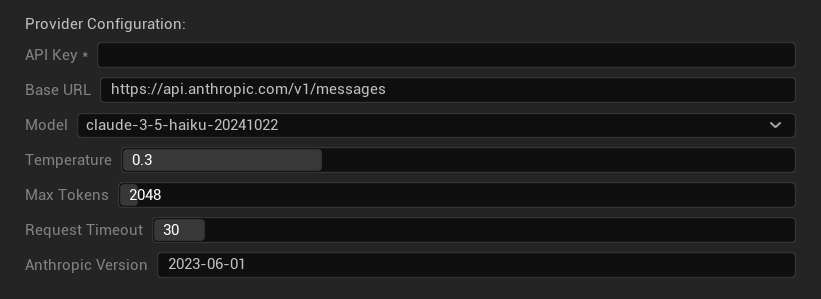

Opcje konfiguracji

- Klucz API: Twój klucz API Anthropic (wymagany)

- Bazowy URL: Punkt końcowy API Claude

- Model: Wybierz z rodziny modeli Claude

- Temperatura: 0.0-1.0 (0.3 zalecane)

- Maksymalna liczba tokenów: 1-64,000 tokenów

- Limit czasu żądania: 5-300 sekund

- Wersja Anthropic: Nagłówek wersji API

Zalety

- ✅ Wyjątkowa świadomość kontekstu

- ✅ Świetny do treści kreatywnych/narracyjnych

- ✅ Silne funkcje bezpieczeństwa

- ✅ Możliwości szczegółowego rozumowania

- ✅ Doskonałe przestrzeganie instrukcji

Uwagi

- 💰 Model cenowy premium

- 🌐 Wymagane połączenie internetowe

- 📏 Limity tokenów różnią się w zależności od modelu

DeepSeek

Najlepszy do: Ekonomicznego tłumaczenia, wysokiej przepustowości, projektów z ograniczonym budżetem

DeepSeek oferuje konkurencyjną jakość tłumaczenia za ułamek kosztów innych dostawców, co czyni go idealnym dla projektów lokalizacji na dużą skalę.

Dostępne modele

- deepseek-chat (Ogólnego przeznaczenia, zalecany)

- deepseek-reasoner (Ulepszone możliwości rozumowania)

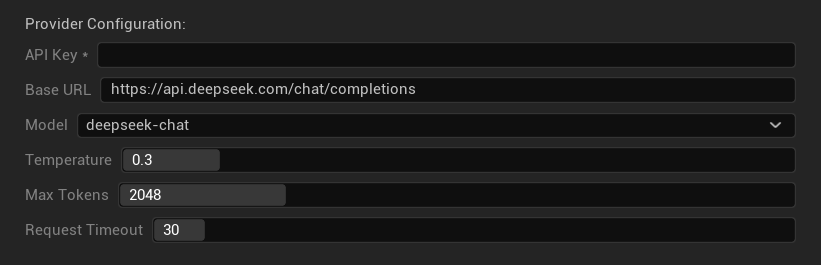

Opcje konfiguracji

- Klucz API: Twój klucz API DeepSeek (wymagany)

- Bazowy URL: Punkt końcowy API DeepSeek

- Model: Wybierz między modelami chat i reasoner

- Temperatura: 0.0-2.0 (0.3 zalecane)

- Maksymalna liczba tokenów: 1-8,192 tokenów

- Limit czasu żądania: 5-300 sekund

Zalety

- ✅ Bardzo ekonomiczny

- ✅ Dobra jakość tłumaczenia

- ✅ Szybkie czasy odpowiedzi

- ✅ Prosta konfiguracja

- ✅ Wysokie limity częstotliwości

Uwagi

- 📏 Niższe limity tokenów

- 🆕 Nowy dostawca (krótsza historia)

- 🌐 Wymaga połączenia z internetem

Google Gemini

Najlepszy do: Projektów wielojęzycznych, opłacalnego tłumaczenia, integracji z ekosystemem Google

Modele Gemini oferują silne możliwości wielojęzyczne z konkurencyjnymi cenami i unikalnymi funkcjami, takimi jak tryb myślenia (thinking mode) dla ulepszonego wnioskowania.

Dostępne modele

- gemini-2.5-pro (Najnowszy flagowiec z trybem myślenia)

- gemini-2.5-flash (Szybki, z obsługą trybu myślenia)

- gemini-2.5-flash-lite (Odmiana lekka)

- gemini-2.0-flash i gemini-2.0-flash-lite

- gemini-1.5-pro i gemini-1.5-flash

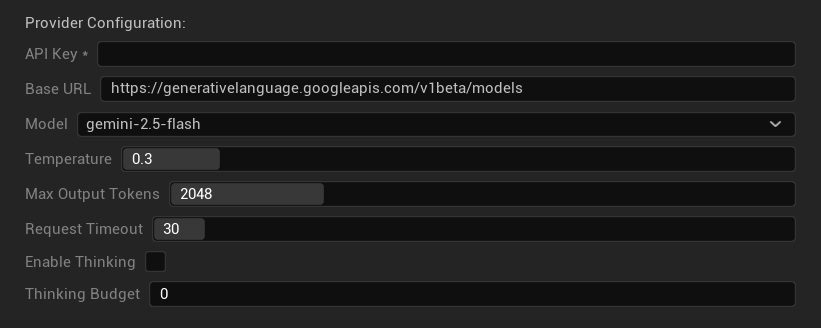

Opcje konfiguracji

- Klucz API: Twój klucz API Google AI (wymagany)

- Podstawowy URL: Punkt końcowy API Gemini

- Model: Wybierz z rodziny modeli Gemini

- Temperatura: 0.0-2.0 (zalecane 0.3)

- Maks. liczba tokenów wyjściowych: 1-8,192 tokeny

- Limit czasu żądania: 5-300 sekund

- Włącz tryb myślenia: Aktywuj ulepszone wnioskowanie dla modeli 2.5

- Budżet myślenia: Kontroluj alokację tokenów dla trybu myślenia

Zalety

- ✅ Silne wsparcie wielojęzyczne

- ✅ Konkurencyjne ceny

- ✅ Zaawansowane wnioskowanie (tryb myślenia)

- ✅ Integracja z ekosystemem Google

- ✅ Regularne aktualizacje modeli

Uwagi

- 🧠 Tryb myślenia zwiększa użycie tokenów

- 📏 Zmienne limity tokenów w zależności od modelu

- 🌐 Wymagane połączenie z internetem

Wybór odpowiedniego dostawcy

| Dostawca | Najlepszy do | Jakość | Koszt | Konfiguracja | Prywatność |

|---|---|---|---|---|---|

| Ollama | Prywatność/offline | Zmienna* | Darmowy | Zaawansowana | Lokalna |

| OpenAI | Najwyższa jakość | ⭐⭐⭐⭐⭐ | 💰💰💰 | Łatwa | Chmura |

| Claude | Treści kreatywne | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Łatwa | Chmura |

| DeepSeek | Projekty budżetowe | ⭐⭐⭐⭐ | 💰 | Łatwa | Chmura |

| Gemini | Wielojęzyczność | ⭐⭐⭐⭐ | 💰 | Łatwa | Chmura |

*Jakość dla Ollama znacząco się różni w zależności od użytego lokalnego modelu - niektóre nowoczesne modele lokalne mogą dorównywać lub przewyższać dostawców chmurowych.

Wskazówki dotyczące konfiguracji dostawcy

Dla wszystkich dostawców chmurowych:

- Przechowuj klucze API bezpiecznie i nie dodawaj ich do systemu kontroli wersji

- Zacznij od konserwatywnych ustawień temperatury (0.3) dla spójnych tłumaczeń

- Monitoruj swoje użycie API i koszty

- Testuj na małych partiach przed dużymi zadaniami tłumaczeniowymi

Dla Ollama:

- Zapewnij odpowiednią ilość RAM (zalecane 8GB+ dla większych modeli)

- Użyj pamięci SSD dla lepszej wydajności ładowania modeli

- Rozważ przyspieszenie GPU dla szybszej inferencji

- Testuj lokalnie przed poleganiem na tym w tłumaczeniach produkcyjnych