Przewodnik konfiguracji

Ten przewodnik przeprowadzi Cię przez podstawowy proces konfiguracji Runtime MetaHuman Lip Sync z twoimi postaciami MetaHuman.

Uwaga: Runtime MetaHuman Lip Sync działa zarówno z MetaHuman, jak i niestandardowymi postaciami. Aby uzyskać szczegółowe instrukcje dotyczące konfiguracji niestandardowych postaci, zobacz Przewodnik konfiguracji niestandardowych postaci.

Wymagania wstępne

Przed rozpoczęciem upewnij się, że:

-

Wymagania wtyczki MetaHuman:

- UE 5.5 i wcześniejsze: Włącz wtyczkę MetaHuman w swoim projekcie

- UE 5.6 i późniejsze: Włącz wtyczkę MetaHuman Core Tech w swoim projekcie

Dodatkowe wtyczki MetaHumanW zależności od tego, jak tworzysz swoje postacie MetaHuman, możesz potrzebować dodatkowych wtyczek. Na przykład, jeśli zamierzasz stworzyć MetaHuman za pomocą nowego systemu MetaHuman Creator wprowadzonego w UE 5.6, będziesz także musiał włączyć wtyczkę MetaHuman Creator. Aby uzyskać więcej informacji o tym systemie, zobacz dokumentację MetaHuman Creator.

-

Masz co najmniej jedną postać MetaHuman pobraną i dostępną w swoim projekcie

-

Wtyczka Runtime MetaHuman Lip Sync jest zainstalowana

Wtyczka rozszerzenia modelu standardowego

Jeśli planujesz używać modelu standardowego, będziesz potrzebować zainstalować wtyczkę rozszerzenia:

- Pobierz wtyczkę Standard Lip Sync Extension z Google Drive

- Wypakuj folder z pobranego archiwum do folderu

Pluginstwojego projektu (utwórz ten folder, jeśli nie istnieje) - Upewnij się, że twój projekt jest skonfigurowany jako projekt C++ (nawet jeśli nie masz żadnego kodu C++)

- Przebuduj swój projekt

- To rozszerzenie jest wymagane tylko jeśli chcesz używać modelu standardowego. Jeśli potrzebujesz tylko modeli realistycznych, możesz pominąć ten krok.

- Aby uzyskać więcej informacji na temat ręcznego budowania wtyczek, zobacz samouczek Budowanie wtyczek

Dodatkowe wtyczki

- Jeśli planujesz używać przechwytywania dźwięku (np. wejścia z mikrofonu), zainstaluj wtyczkę Runtime Audio Importer.

- Jeśli planujesz używać funkcjonalności zamiany tekstu na mowę:

- Dla lokalnej TTS (Model Standardowy i Model Realistyczny z Obsługą Nastroju), zainstaluj wtyczkę Runtime Text To Speech.

- Dla zewnętrznych dostawców TTS (ElevenLabs, OpenAI, Google Cloud, Azure), zainstaluj wtyczkę Runtime AI Chatbot Integrator.

Konfiguracja Animation Blueprint

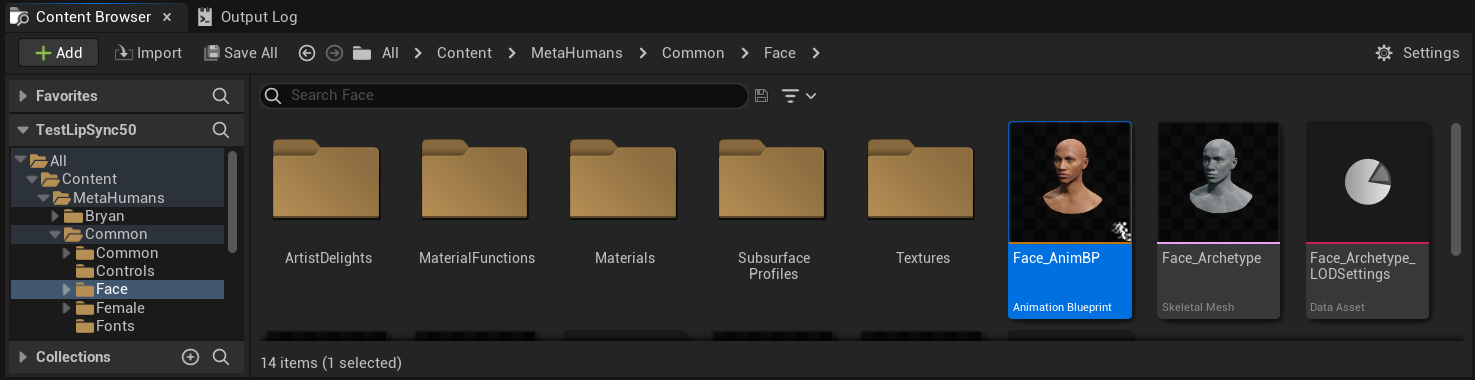

Krok 1: Znajdź i zmodyfikuj Blueprint animacji twarzy

- UE 5.5 i wcześniejsze (lub Legacy MetaHumans w UE 5.6+)

- Postacie z MetaHuman Creator UE 5.6+

Musisz zmodyfikować Animation Blueprint, który będzie używany do animacji twarzy twojej postaci MetaHuman. Domyślny Animation Blueprint twarzy MetaHuman znajduje się w lokalizacji:

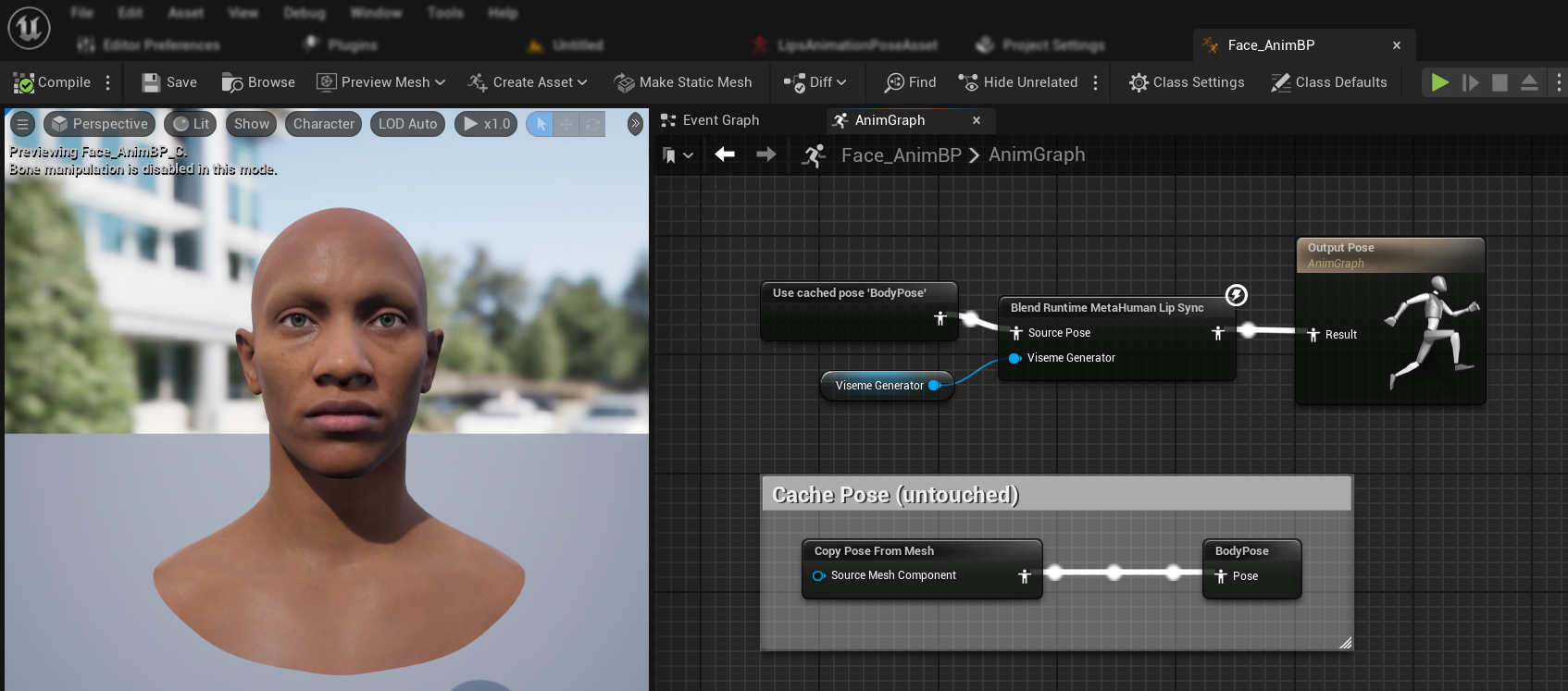

Content/MetaHumans/Common/Face/Face_AnimBP

Masz kilka opcji implementacji funkcji synchronizacji ust:

- Edytuj domyślny zasób (najprostsza opcja)

- Utwórz duplikat

- Użyj niestandardowego Blueprint animacji

Otwórz bezpośrednio domyślny Face_AnimBP i wprowadź swoje modyfikacje. Wszelkie zmiany wpłyną na wszystkie postacie MetaHuman korzystające z tego Blueprint animacji.

Uwaga: To podejście jest wygodne, ale wpłynie na wszystkie postacie używające domyślnego Blueprint animacji.

- Zduplikuj

Face_AnimBPi nadaj mu opisową nazwę - Znajdź klasę Blueprint swojej postaci (np. dla postaci "Bryan" będzie to

Content/MetaHumans/Bryan/BP_Bryan) - Otwórz Blueprint postaci i znajdź komponent Face

- Zmień właściwość Anim Class na nowo zduplikowany Blueprint animacji

Uwaga: To podejście pozwala dostosować synchronizację ust dla konkretnych postaci, pozostawiając inne niezmienione.

Możesz zaimplementować mieszanie synchronizacji ust w dowolnym Blueprint animacji, który ma dostęp do wymaganych kości twarzy:

- Utwórz lub użyj istniejącego niestandardowego Blueprint animacji

- Upewnij się, że Twój Blueprint animacji współpracuje ze szkieletem zawierającym te same kości twarzy co domyślny

Face_Archetype_SkeletonMetaHuman

Uwaga: To podejście daje maksymalną elastyczność integracji z niestandardowymi systemami animacji.

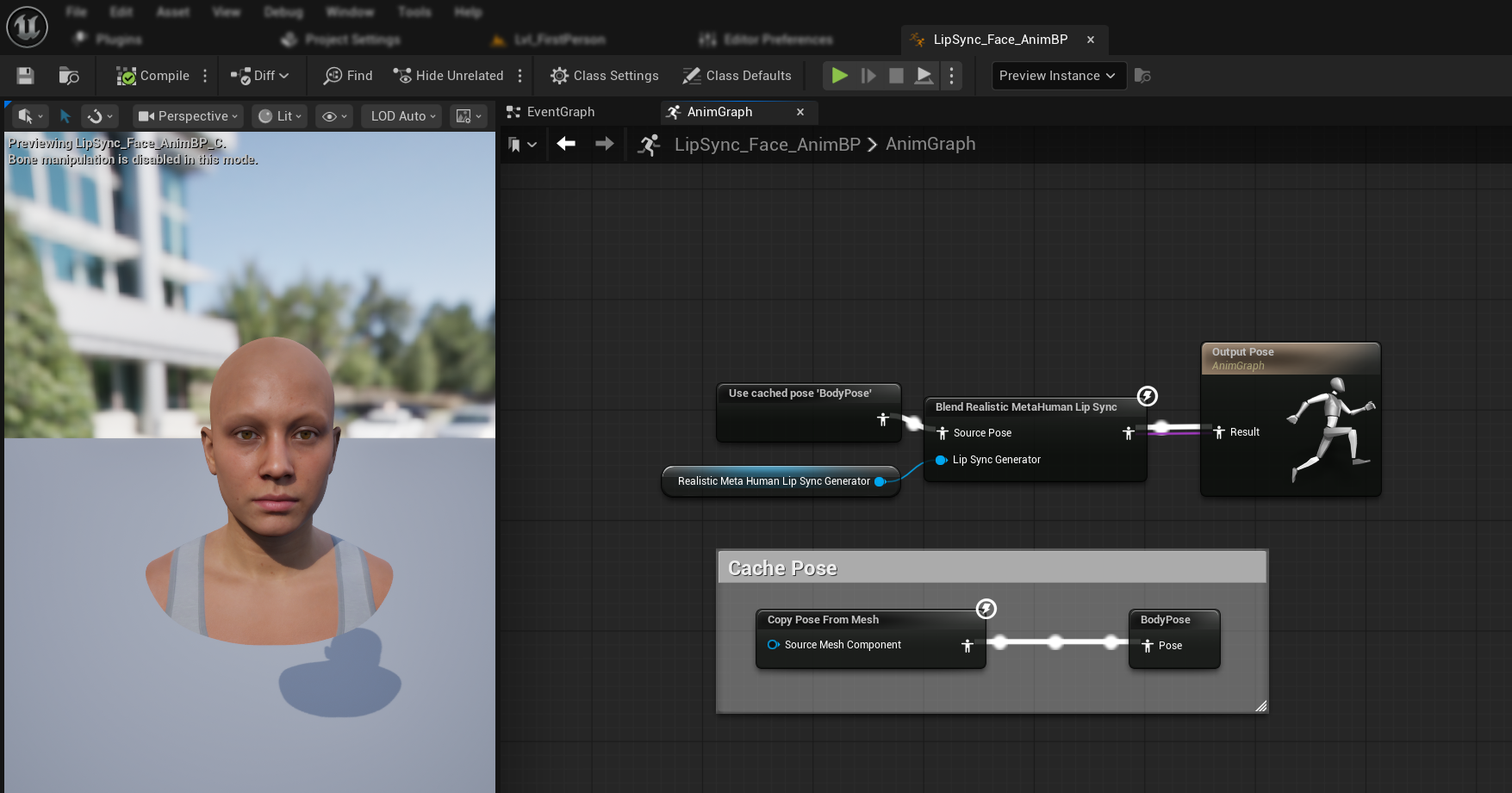

Począwszy od UE 5.6, wprowadzono nowy system MetaHuman Creator. Dla tych postaci plugin zapewnia Blueprint animacji twarzy znajdujący się w:

Content/LipSyncData/LipSync_Face_AnimBP

Ten Animation Blueprint znajduje się w folderze zawartości wtyczki i będzie nadpisywany przy każdej aktualizacji wtyczki. Aby zapobiec utracie swoich dostosowań:

- Skopiuj ten zasób do folderu Content swojego projektu (na przykład do

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - Używaj swojej skopiowanej wersji w konfiguracji swojej postaci

- Wprowadzaj wszystkie swoje modyfikacje do skopiowanej wersji

Używanie Face Animation Blueprint wtyczki:

- Zlokalizuj klasę Blueprint swojej postaci z MetaHuman Creator

- Otwórz Blueprint postaci i znajdź komponent Face

- Zmień właściwość Anim Class na

LipSync_Face_AnimBPwtyczki - Kontynuuj kolejne kroki, aby skonfigurować funkcjonalność Runtime MetaHuman Lip Sync

Krok 2: Konfiguracja Event Graph

Otwórz swój Face Animation Blueprint i przejdź do Event Graph. Będziesz musiał utworzyć generator, który przetworzy dane audio i wygeneruje animację synchronizacji ust.

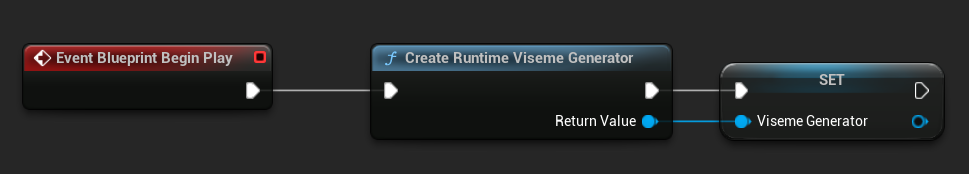

- Model Standardowy

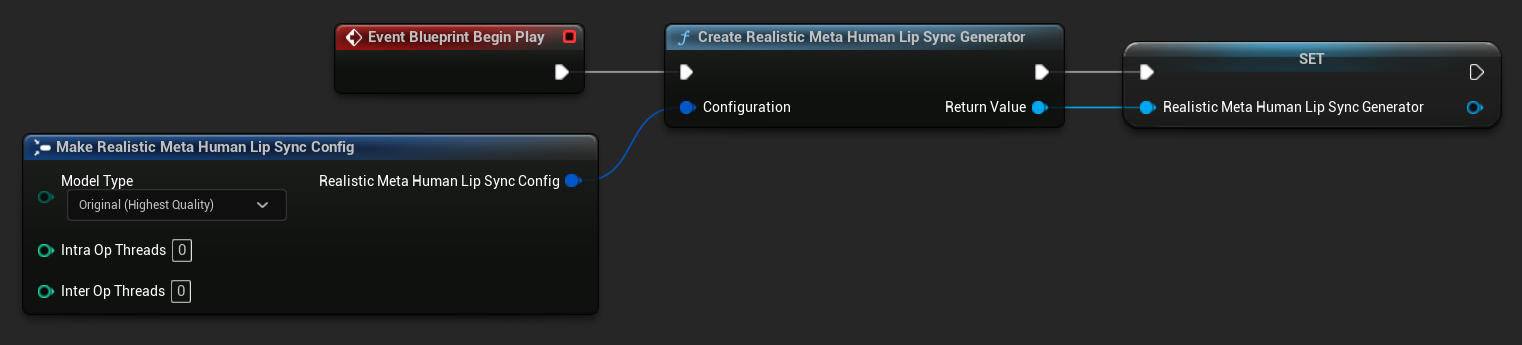

- Model Realistyczny

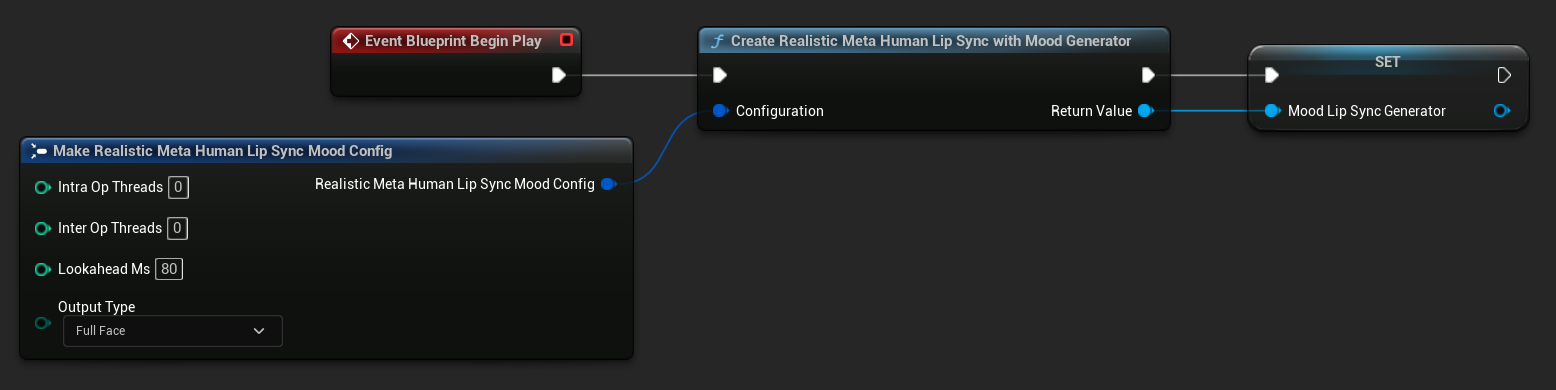

- Model Realistyczny z Obsługą Nastroju

- Dodaj węzeł

Event Blueprint Begin Play, jeśli jeszcze nie istnieje - Dodaj węzeł

Create Runtime Viseme Generatori połącz go ze zdarzeniem Begin Play - Zapisz wynik jako zmienną (np. "VisemeGenerator") do użycia w innych częściach grafu

Aby uzyskać szczegółowe opcje konfiguracji, zobacz sekcję Konfiguracja Modelu Standardowego.

- Dodaj węzeł

Event Blueprint Begin Play, jeśli jeszcze nie istnieje - Dodaj węzeł

Create Realistic MetaHuman Lip Sync Generatori połącz go ze zdarzeniem Begin Play - Zapisz wynik jako zmienną (np. "RealisticMetaHumanLipSyncGenerator") do użycia w innych częściach grafu

- (Opcjonalnie) Skonfiguruj ustawienia generatora za pomocą parametru Configuration

Aby uzyskać szczegółowe opcje konfiguracji, w tym typy modeli, ustawienia wydajności i parametry przetwarzania, zobacz sekcję Konfiguracja Modelu Realistycznego.

- Dodaj węzeł

Event Blueprint Begin Play, jeśli jeszcze nie istnieje - Dodaj węzeł

Create Realistic MetaHuman Lip Sync With Mood Generatori połącz go ze zdarzeniem Begin Play - Zapisz wynik jako zmienną (np. "MoodMetaHumanLipSyncGenerator") do użycia w innych częściach grafu

- (Opcjonalnie) Skonfiguruj ustawienia generatora za pomocą parametru Configuration

Aby uzyskać szczegółową konfigurację nastroju, w tym typy nastroju, ustawienia intensywności, czas wyprzedzenia i wybór typu wyjścia, zobacz sekcję Konfiguracja modelu z obsługą nastrojów.

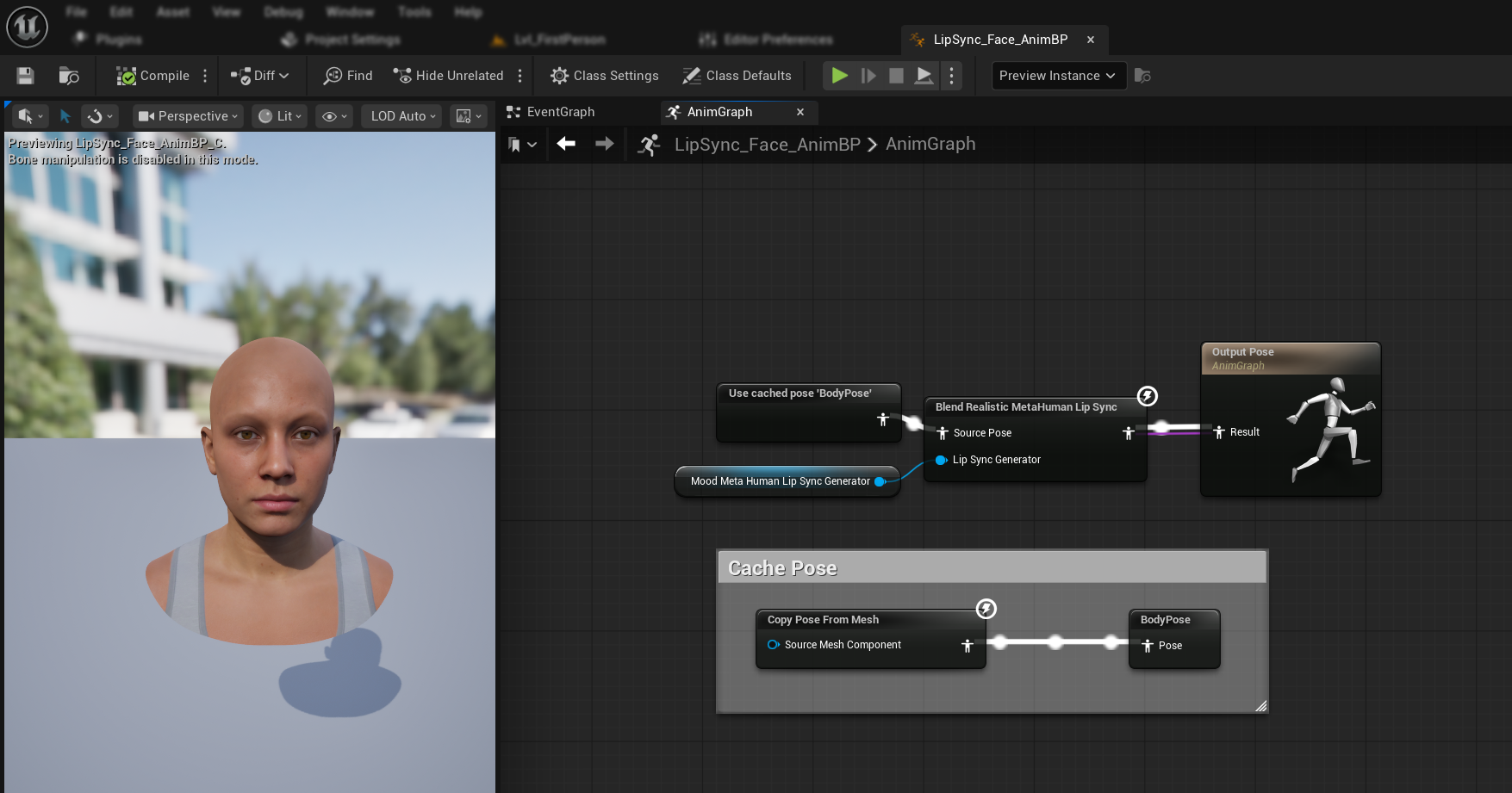

Krok 3: Konfiguracja Anim Graph

Po skonfigurowaniu Event Graph, przełącz się na Anim Graph, aby podłączyć generator do animacji postaci:

- Standard Model

- Realistic Model

- Mood-Enabled Realistic Model

- Znajdź pozę zawierającą twarz MetaHuman (zwykle z

Use cached pose 'Body Pose') - Dodaj węzeł

Blend Runtime MetaHuman Lip Sync - Podłącz pozę do

Source PosewęzłaBlend Runtime MetaHuman Lip Sync - Podłącz swoją zmienną

VisemeGeneratordo pinuViseme Generator - Podłącz wyjście węzła

Blend Runtime MetaHuman Lip Syncdo pinuResultwOutput Pose

- Znajdź pozę zawierającą twarz MetaHuman (zwykle z

Use cached pose 'Body Pose') - Dodaj węzeł

Blend Realistic MetaHuman Lip Sync - Podłącz pozę do

Source PosewęzłaBlend Realistic MetaHuman Lip Sync - Podłącz swoją zmienną

RealisticMetaHumanLipSyncGeneratordo pinuLip Sync Generator - Podłącz wyjście węzła

Blend Realistic MetaHuman Lip Syncdo pinuResultwOutput Pose

- Znajdź pozę zawierającą twarz MetaHuman (zwykle z

Use cached pose 'Body Pose') - Dodaj węzeł

Blend Realistic MetaHuman Lip Sync(ten sam węzeł co w zwykłym modelu realistycznym) - Podłącz pozę do

Source PosewęzłaBlend Realistic MetaHuman Lip Sync - Podłącz swoją zmienną

MoodMetaHumanLipSyncGeneratordo pinuLip Sync Generator - Podłącz wyjście węzła

Blend Realistic MetaHuman Lip Syncdo pinuResultwOutput Pose

Uwaga: Model z obsługą nastrojów używa tego samego węzła Animation Blueprint co zwykły model realistyczny. Funkcjonalność nastrojów jest obsługiwana wewnętrznie przez generator.

Następne kroki

Teraz, gdy podstawowa konfiguracja Animation Blueprint jest ukończona, musisz skonfigurować przetwarzanie wejścia audio, aby dostarczać dane audio do twojego generatora synchronizacji ust.

Kontynuuj do Przewodnika przetwarzania audio, aby dowiedzieć się, jak skonfigurować różne metody wprowadzania audio, w tym przechwytywanie z mikrofonu, zamianę tekstu na mowę i przetwarzanie plików audio. Aby uzyskać zaawansowane opcje konfiguracji i dostrajanie, zobacz Przewodnik konfiguracji.