Provedores de Tradução

O AI Localization Automator suporta cinco provedores de IA diferentes, cada um com pontos fortes e opções de configuração únicos. Escolha o provedor que melhor se adequa às necessidades, orçamento e requisitos de qualidade do seu projeto.

Ollama (IA Local)

Melhor para: Projetos sensíveis à privacidade, tradução offline, uso ilimitado

O Ollama executa modelos de IA localmente na sua máquina, fornecendo privacidade e controle completos sem custos de API ou requisitos de internet.

Modelos Populares

- llama3.2 (Uso geral recomendado)

- mistral (Alternativa eficiente)

- codellama (Traduções com consciência de código)

- E muitos outros modelos da comunidade

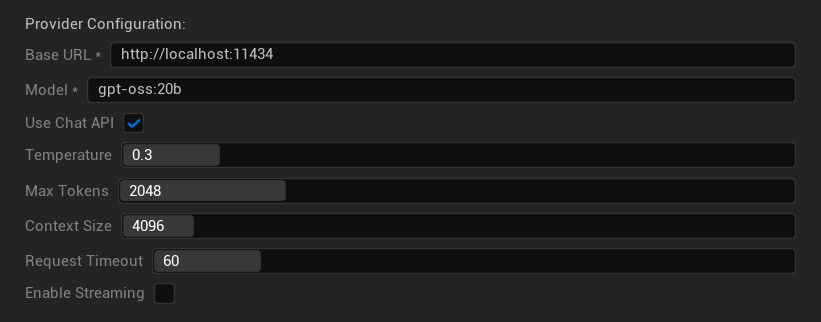

Opções de Configuração

- URL Base: Servidor Ollama local (padrão:

http://localhost:11434) - Modelo: Nome do modelo instalado localmente (obrigatório)

- Usar API de Chat: Ativar para melhor manipulação de conversas

- Temperatura: 0.0-2.0 (0.3 recomendado)

- Tokens Máximos: 1-8.192 tokens

- Tamanho do Contexto: 512-32.768 tokens

- Tempo Limite da Requisição: 10-300 segundos (modelos locais podem ser mais lentos)

- Ativar Streaming: Para processamento de resposta em tempo real

Pontos Fortes

- ✅ Privacidade completa (nenhum dado deixa sua máquina)

- ✅ Sem custos de API ou limites de uso

- ✅ Funciona offline

- ✅ Controle total sobre os parâmetros do modelo

- ✅ Grande variedade de modelos da comunidade

- ✅ Sem vendor lock-in

Considerações

- 💻 Requer configuração local e hardware capaz

- ⚡ Geralmente mais lento que provedores em nuvem

- 🔧 Configuração mais técnica necessária

- 📊 A qualidade da tradução varia significativamente conforme o modelo (alguns podem superar provedores em nuvem)

- 💾 Grandes requisitos de armazenamento para modelos

Configurando o Ollama

- Instale o Ollama: Faça o download em ollama.ai e instale no seu sistema

- Baixe Modelos: Use

ollama pull llama3.2para baixar o modelo escolhido - Inicie o Servidor: O Ollama é executado automaticamente, ou inicie com

ollama serve - Configure o Plugin: Defina a URL base e o nome do modelo nas configurações do plugin

- Teste a Conexão: O plugin verificará a conectividade quando você aplicar a configuração

OpenAI

Melhor para: Maior qualidade geral de tradução, extensa seleção de modelos

A OpenAI fornece modelos de linguagem líderes do setor por meio de sua API, incluindo os mais recentes modelos GPT e o novo formato Responses API.

Modelos Disponíveis

- gpt-5 (Modelo principal mais recente)

- gpt-5-mini (Variante menor e mais rápida)

- gpt-4.1 e gpt-4.1-mini

- gpt-4o e gpt-4o-mini (Modelos otimizados)

- o3 e o3-mini (Raciocínio avançado)

- o1 e o1-mini (Geração anterior)

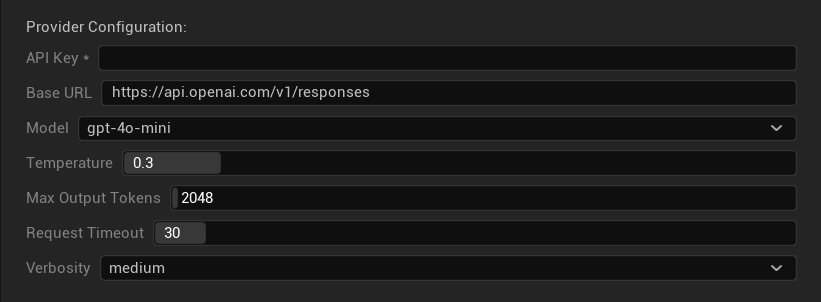

Opções de Configuração

- Chave da API: Sua chave de API da OpenAI (obrigatória)

- URL Base: Endpoint da API (padrão: servidores da OpenAI)

- Modelo: Escolha entre os modelos GPT disponíveis

- Temperatura: 0.0-2.0 (0.3 recomendado para consistência na tradução)

- Tokens Máximos de Saída: 1-128.000 tokens

- Tempo Limite da Requisição: 5-300 segundos

- Verbosity: Controla o nível de detalhe da resposta

Pontos Fortes

- ✅ Traduções de alta qualidade consistentes

- ✅ Excelente compreensão de contexto

- ✅ Forte preservação de formatação

- ✅ Amplo suporte a idiomas

- ✅ Tempo de atividade da API confiável

Considerações

- 💰 Custo mais alto por requisição

- 🌐 Requer conexão com a internet

- ⏱️ Limites de uso baseados no plano

Anthropic Claude

Melhor para: Traduções nuanceadas, conteúdo criativo, aplicações com foco em segurança

Os modelos Claude se destacam em entender contexto e nuance, tornando-os ideais para jogos ricos em narrativa e cenários de localização complexos.

Modelos Disponíveis

- claude-opus-4-1-20250805 (Mais recente, carro-chefe)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Rápido e eficiente)

- claude-3-haiku-20240307

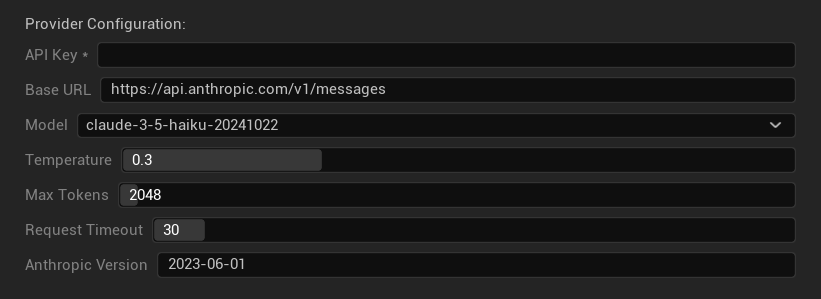

Opções de Configuração

- Chave da API: Sua chave de API da Anthropic (obrigatória)

- URL Base: Endpoint da API do Claude

- Modelo: Selecione da família de modelos Claude

- Temperatura: 0.0-1.0 (0.3 recomendado)

- Tokens Máximos: 1-64.000 tokens

- Tempo Limite da Requisição: 5-300 segundos

- Versão Anthropic: Cabeçalho da versão da API

Pontos Fortes

- ✅ Consciência contextual excepcional

- ✅ Ótimo para conteúdo criativo/narrativo

- ✅ Fortes recursos de segurança

- ✅ Capacidades de raciocínio detalhadas

- ✅ Excelente em seguir instruções

Considerações

- 💰 Modelo de preços premium

- 🌐 Conexão com a internet necessária

- 📏 Limites de tokens variam por modelo

DeepSeek

Melhor para: Tradução econômica, alta taxa de transferência, projetos com orçamento limitado

O DeepSeek oferece qualidade de tradução competitiva a uma fração do custo de outros provedores, tornando-o ideal para projetos de localização em larga escala.

Modelos Disponíveis

- deepseek-chat (Propósito geral, recomendado)

- deepseek-reasoner (Capacidades de raciocínio aprimoradas)

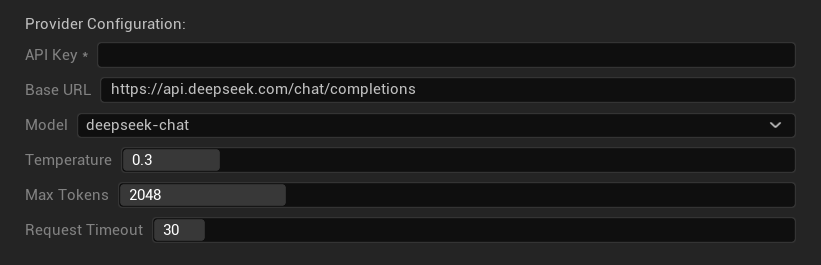

Opções de Configuração

- Chave da API: Sua chave de API do DeepSeek (obrigatória)

- URL Base: Endpoint da API do DeepSeek

- Modelo: Escolha entre os modelos chat e reasoner

- Temperatura: 0.0-2.0 (0.3 recomendado)

- Tokens Máximos: 1-8.192 tokens

- Tempo Limite da Requisição: 5-300 segundos

Pontos Fortes

- ✅ Muito econômico

- ✅ Boa qualidade de tradução

- ✅ Tempos de resposta rápidos

- ✅ Configuração simples

- ✅ Altos limites de taxa

Considerações

- 📏 Limites de tokens mais baixos

- 🆕 Provedor mais novo (menor histórico)

- 🌐 Requer conexão com a internet

Google Gemini

Melhor para: Projetos multilíngues, tradução econômica, integração com ecossistema Google

Os modelos Gemini oferecem fortes capacidades multilíngues com preços competitivos e recursos exclusivos, como modo de pensamento para raciocínio aprimorado.

Modelos Disponíveis

- gemini-2.5-pro (Mais recente carro-chefe com pensamento)

- gemini-2.5-flash (Rápido, com suporte a pensamento)

- gemini-2.5-flash-lite (Variante leve)

- gemini-2.0-flash e gemini-2.0-flash-lite

- gemini-1.5-pro e gemini-1.5-flash

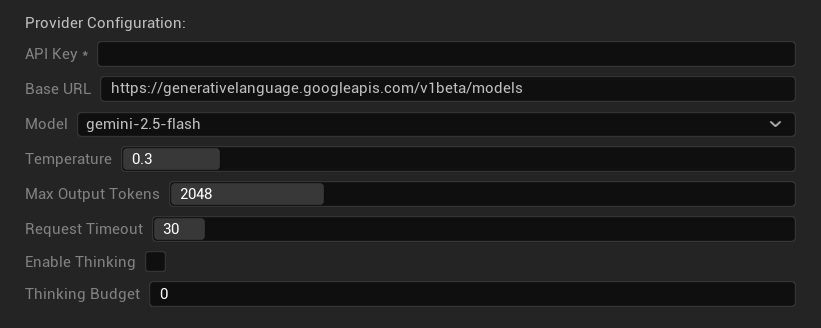

Opções de Configuração

- Chave de API: Sua chave de API do Google AI (obrigatória)

- URL Base: Endpoint da API Gemini

- Modelo: Selecione da família de modelos Gemini

- Temperatura: 0.0-2.0 (0.3 recomendado)

- Tokens Máximos de Saída: 1-8.192 tokens

- Tempo Limite da Requisição: 5-300 segundos

- Habilitar Pensamento: Ativar raciocínio aprimorado para modelos 2.5

- Orçamento de Pensamento: Controlar alocação de tokens de pensamento

Pontos Fortes

- ✅ Forte suporte multilíngue

- ✅ Preços competitivos

- ✅ Raciocínio avançado (modo de pensamento)

- ✅ Integração com ecossistema Google

- ✅ Atualizações regulares de modelo

Considerações

- 🧠 O modo de pensamento aumenta o uso de tokens

- 📏 Limites de tokens variáveis por modelo

- 🌐 Conexão com a internet necessária

Escolhendo o Provedor Correto

| Provedor | Melhor Para | Qualidade | Custo | Configuração | Privacidade |

|---|---|---|---|---|---|

| Ollama | Privacidade/offline | Variável* | Grátis | Avançada | Local |

| OpenAI | Maior qualidade | ⭐⭐⭐⭐⭐ | 💰💰💰 | Fácil | Nuvem |

| Claude | Conteúdo criativo | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Fácil | Nuvem |

| DeepSeek | Projetos econômicos | ⭐⭐⭐⭐ | 💰 | Fácil | Nuvem |

| Gemini | Multilíngue | ⭐⭐⭐⭐ | 💰 | Fácil | Nuvem |

*A qualidade para Ollama varia significativamente com base no modelo local usado - alguns modelos locais modernos podem igualar ou superar provedores de nuvem.

Dicas de Configuração do Provedor

Para Todos os Provedores de Nuvem:

- Armazene chaves de API com segurança e não as comite no controle de versão

- Comece com configurações conservadoras de temperatura (0.3) para traduções consistentes

- Monitore seu uso de API e custos

- Teste com lotes pequenos antes de execuções grandes de tradução

Para Ollama:

- Garanta RAM adequada (8GB+ recomendado para modelos maiores)

- Use armazenamento SSD para melhor desempenho de carregamento de modelo

- Considere aceleração por GPU para inferência mais rápida

- Teste localmente antes de confiar nele para traduções de produção