Guia de Configuração

Este guia orienta você através do processo básico de configuração do Runtime MetaHuman Lip Sync com seus personagens MetaHuman.

Nota: O Runtime MetaHuman Lip Sync funciona tanto com MetaHuman quanto com personagens personalizados. Para instruções detalhadas sobre como configurar personagens personalizados, consulte o Guia de Configuração de Personagem Personalizado.

Pré-requisitos

Antes de começar, certifique-se de:

-

Requisitos do Plugin MetaHuman:

- UE 5.5 e anteriores: Habilite o plugin MetaHuman em seu projeto

- UE 5.6 e posteriores: Habilite o plugin MetaHuman Core Tech em seu projeto

Plugins MetaHuman AdicionaisDependendo de como você cria seus personagens MetaHuman, você pode precisar de plugins adicionais. Por exemplo, se você pretende criar um MetaHuman com o novo sistema MetaHuman Creator introduzido no UE 5.6, você também precisará habilitar o plugin MetaHuman Creator. Para mais informações sobre este sistema, consulte a documentação do MetaHuman Creator.

-

Você tem pelo menos um personagem MetaHuman baixado e disponível em seu projeto

-

O plugin Runtime MetaHuman Lip Sync está instalado

Plugin de Extensão do Modelo Padrão

Se você planeja usar o Modelo Padrão, você precisará instalar o plugin de extensão:

- Baixe o Standard Lip Sync Extension plugin do Google Drive

- Extraia a pasta do arquivo baixado para a pasta

Pluginsdo seu projeto (crie esta pasta se ela não existir) - Certifique-se de que seu projeto está configurado como um projeto C++ (mesmo que você não tenha nenhum código C++)

- Recompile seu projeto

- Esta extensão é necessária apenas se você quiser usar o Modelo Padrão. Se você só precisa dos Modelos Realistas, você pode pular esta etapa.

- Para mais informações sobre como compilar plugins manualmente, consulte o tutorial Construindo Plugins

Plugins Adicionais

- Se você planeja usar captura de áudio (ex.: entrada de microfone), instale o plugin Runtime Audio Importer.

- Se você planeja usar a funcionalidade de texto para fala:

- Para TTS local (Modelo Padrão e Modelo Realista com Humor), instale o plugin Runtime Text To Speech.

- Para provedores de TTS externos (ElevenLabs, OpenAI, Google Cloud, Azure), instale o plugin Runtime AI Chatbot Integrator.

Configuração do Animation Blueprint

Passo 1: Localize e modifique o Blueprint de animação facial

- UE 5.5 e Anteriores (ou MetaHumans Legado no UE 5.6+)

- Personagens MetaHuman Creator UE 5.6+

Você precisa modificar um Animation Blueprint que será usado para as animações faciais do seu personagem MetaHuman. O Animation Blueprint facial padrão do MetaHuman está localizado em:

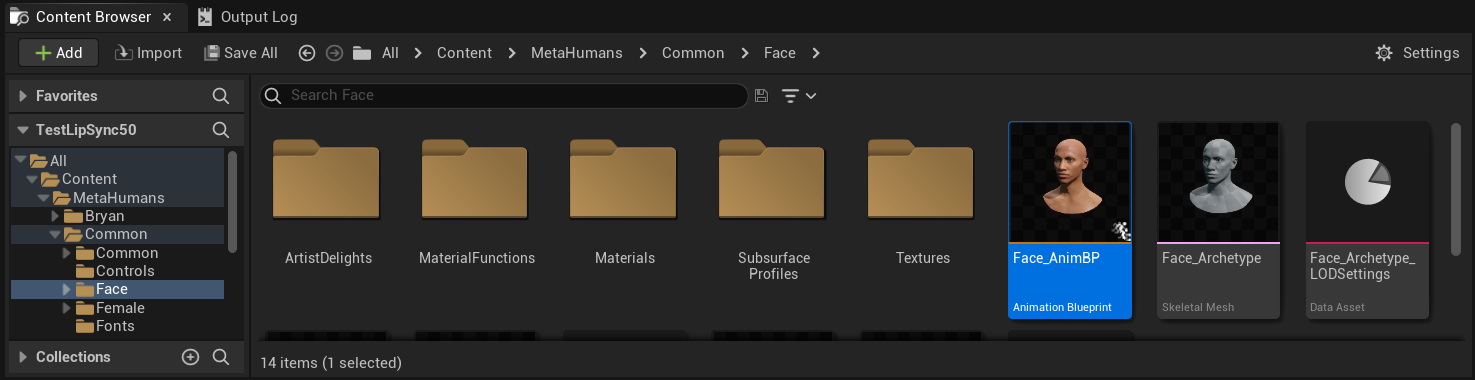

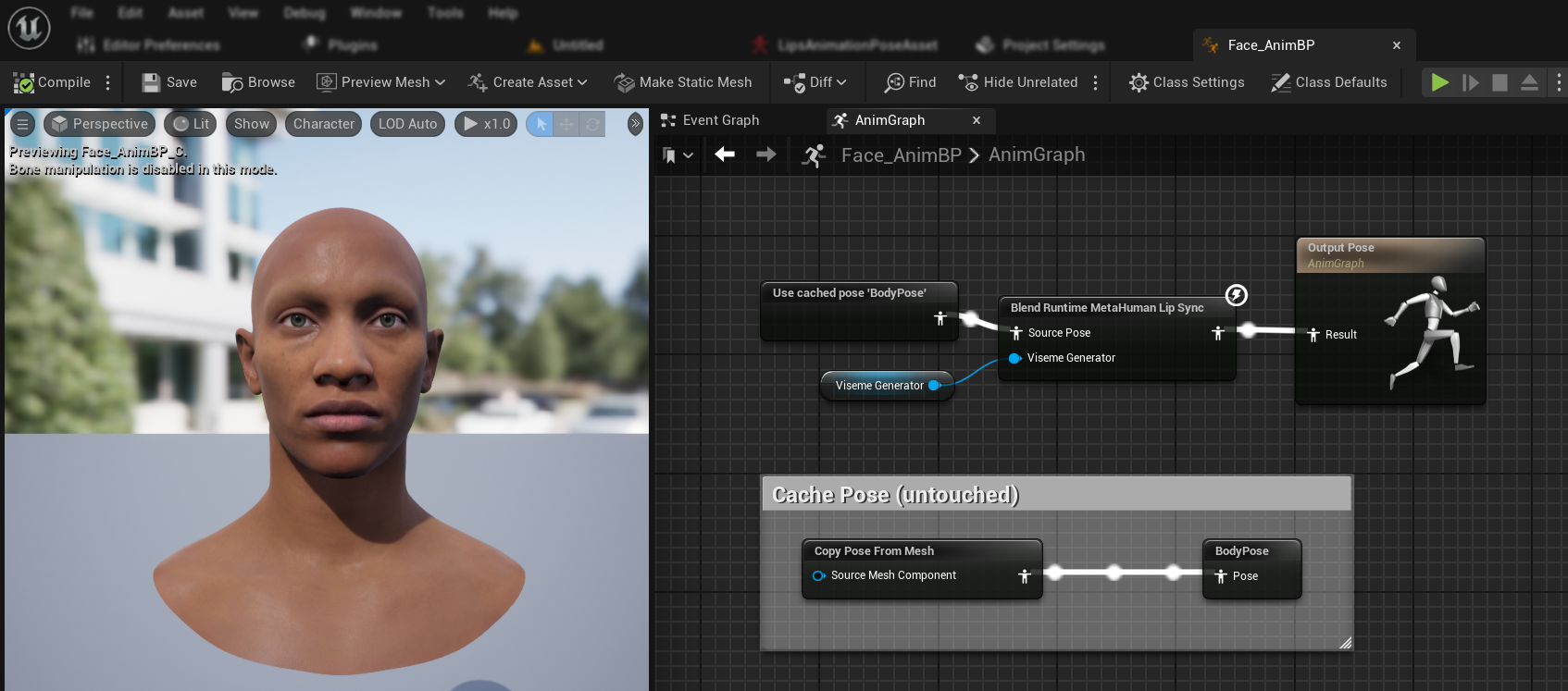

Content/MetaHumans/Common/Face/Face_AnimBP

Você tem várias opções para implementar a funcionalidade de sincronização labial:

- Editar Ativo Padrão (Opção Mais Simples)

- Criar Duplicata

- Usar Animation Blueprint Personalizado

Abra o Face_AnimBP padrão diretamente e faça suas modificações. Quaisquer alterações afetarão todos os personagens MetaHuman usando este Animation Blueprint.

Observação: Esta abordagem é conveniente, mas impactará todos os personagens usando o Animation Blueprint padrão.

- Duplique o

Face_AnimBPe dê um nome descritivo - Localize a classe Blueprint do seu personagem (por exemplo, para o personagem "Bryan", estaria em

Content/MetaHumans/Bryan/BP_Bryan) - Abra o Blueprint do personagem e encontre o componente Face

- Altere a propriedade Anim Class para seu Animation Blueprint recém-duplicado

Observação: Esta abordagem permite personalizar a sincronização labial para personagens específicos enquanto deixa outros inalterados.

Você pode implementar a mesclagem de sincronização labial em qualquer Animation Blueprint que tenha acesso aos ossos faciais necessários:

- Crie ou use um Animation Blueprint personalizado existente

- Certifique-se de que seu Animation Blueprint funciona com um esqueleto que contém os mesmos ossos faciais do

Face_Archetype_Skeletonpadrão do MetaHuman

Observação: Esta abordagem oferece máxima flexibilidade para integração com sistemas de animação personalizados.

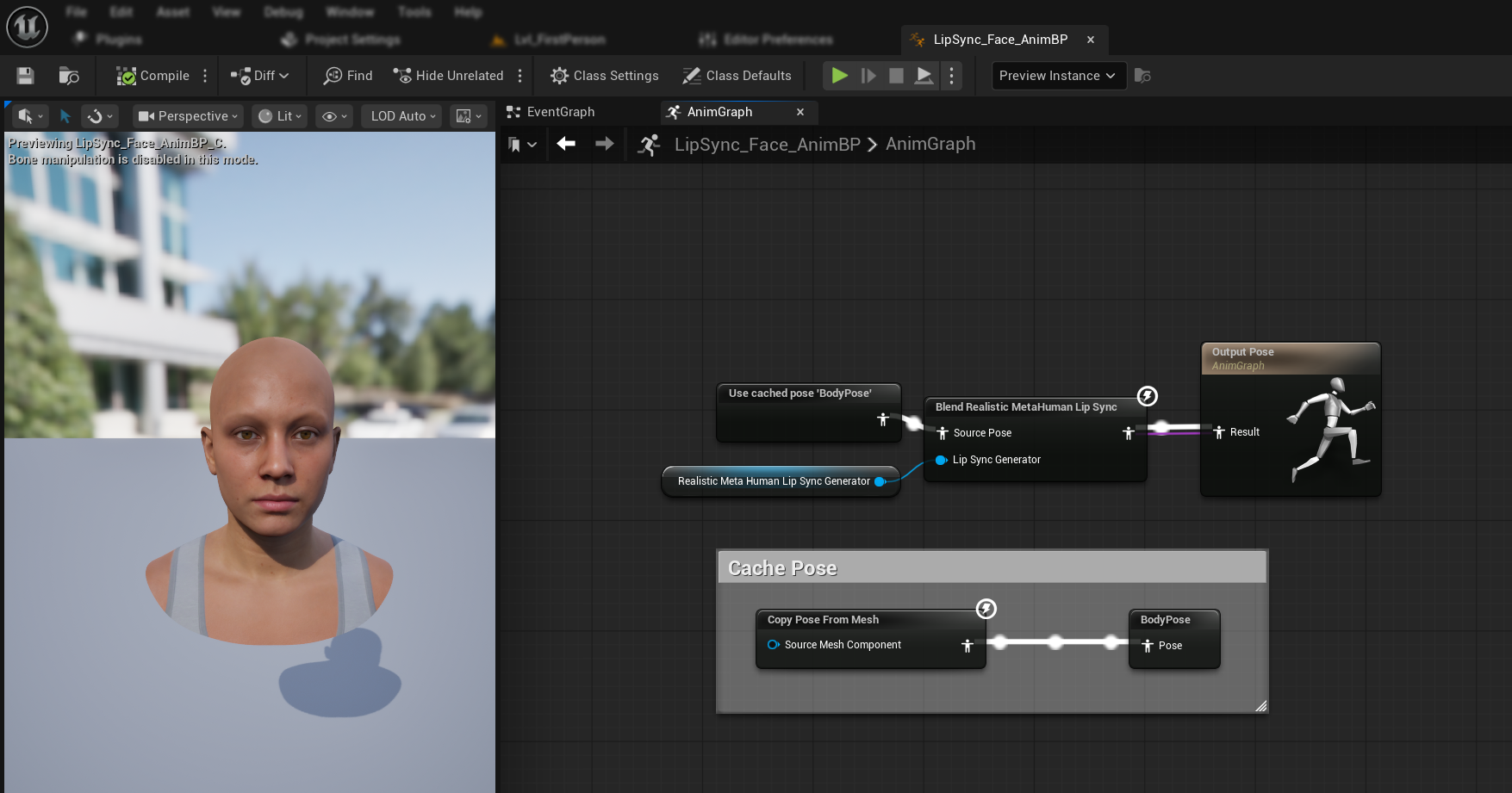

A partir do UE 5.6, o novo sistema MetaHuman Creator foi introduzido. Para estes personagens, o plugin fornece um Animation Blueprint facial localizado em:

Content/LipSyncData/LipSync_Face_AnimBP

Este Animation Blueprint está localizado na pasta de conteúdo do plugin e será substituído a cada atualização do plugin. Para evitar perder suas personalizações:

- Copie este ativo para a pasta Content do seu projeto (por exemplo, para

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - Use sua versão copiada na configuração do seu personagem

- Faça todas as suas modificações na versão copiada

Usando o Face Animation Blueprint do Plugin:

- Localize a classe Blueprint do seu personagem do MetaHuman Creator

- Abra o Blueprint do personagem e encontre o componente Face

- Altere a propriedade Anim Class para o

LipSync_Face_AnimBPdo plugin - Continue com os próximos passos para configurar a funcionalidade Runtime MetaHuman Lip Sync

Passo 2: Configuração do Event Graph

Abra seu Face Animation Blueprint e mude para o Event Graph. Você precisará criar um gerador que processará dados de áudio e gerará animação de sincronização labial.

- Modelo Padrão

- Modelo Realista

- Modelo Realista com Humor

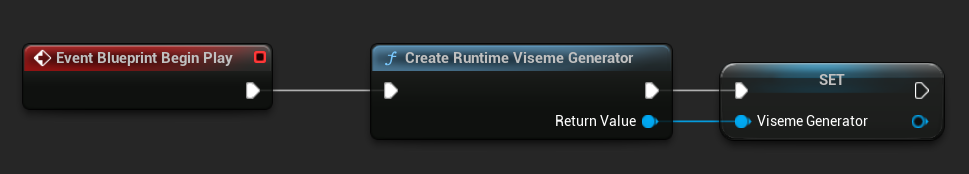

- Adicione o nó

Event Blueprint Begin Playse ele não existir ainda - Adicione o nó

Create Runtime Viseme Generatore conecte-o ao evento Begin Play - Salve a saída como uma variável (ex: "VisemeGenerator") para uso em outras partes do grafo

Para opções de configuração detalhadas, consulte a seção Configuração do Modelo Padrão.

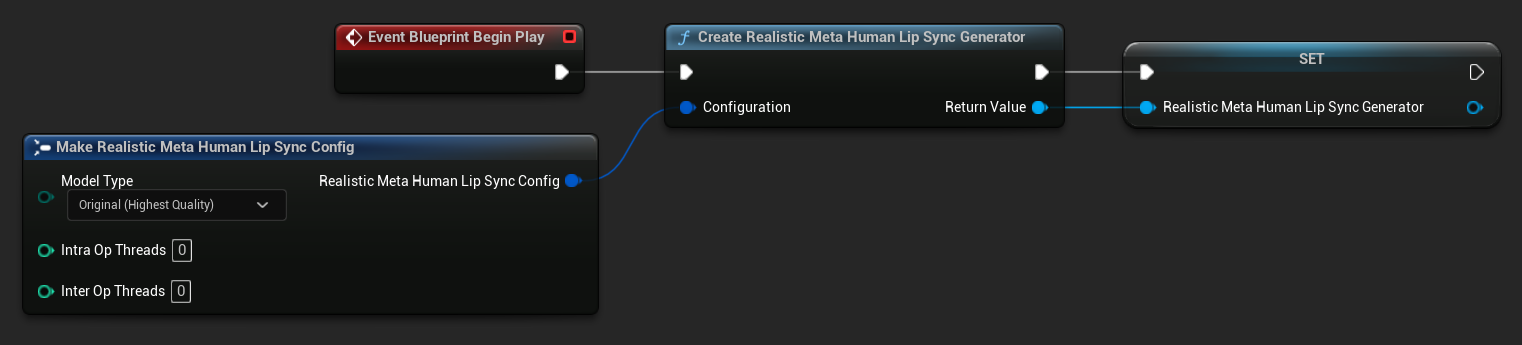

- Adicione o nó

Event Blueprint Begin Playse ele não existir ainda - Adicione o nó

Create Realistic MetaHuman Lip Sync Generatore conecte-o ao evento Begin Play - Salve a saída como uma variável (ex: "RealisticMetaHumanLipSyncGenerator") para uso em outras partes do grafo

- (Opcional) Configure as definições do gerador usando o parâmetro Configuration

Para opções de configuração detalhadas incluindo tipos de modelo, configurações de desempenho e parâmetros de processamento, consulte a seção Configuração do Modelo Realista.

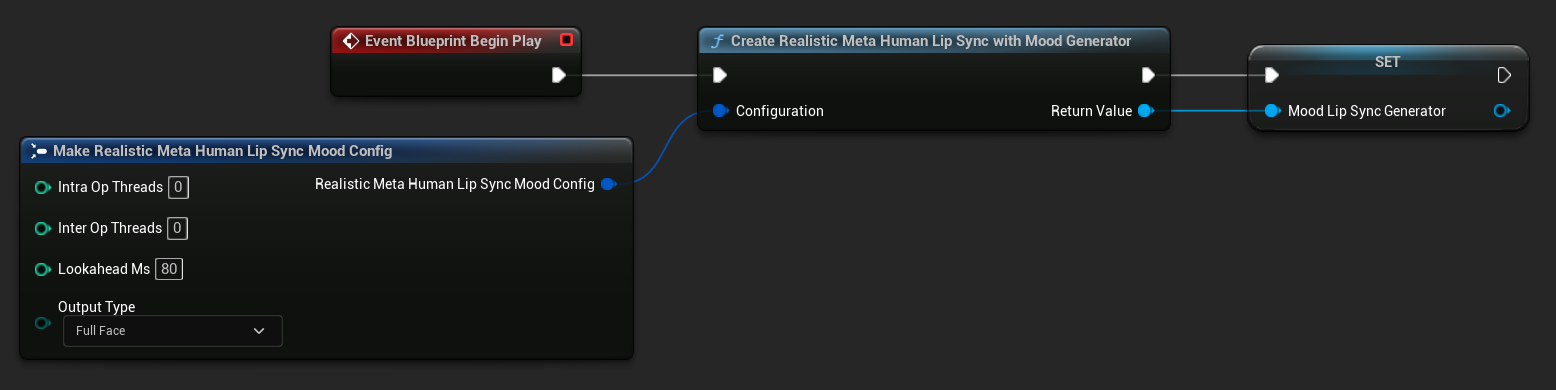

- Adicione o nó

Event Blueprint Begin Playse ele não existir ainda - Adicione o nó

Create Realistic MetaHuman Lip Sync With Mood Generatore conecte-o ao evento Begin Play - Salve a saída como uma variável (ex: "MoodMetaHumanLipSyncGenerator") para uso em outras partes do grafo

- (Opcional) Configure as definições do gerador usando o parâmetro Configuration

Para configuração de humor detalhada incluindo tipos de humor, configurações de intensidade, temporização de antecipação e seleção de tipo de saída, consulte a seção Configuração do Modelo Habilitado para Humor.

Etapa 3: Configuração do Anim Graph

Após configurar o Event Graph, mude para o Anim Graph para conectar o gerador à animação do personagem:

- Modelo Padrão

- Modelo Realista

- Modelo Realista Habilitado para Humor

- Localize a pose que contém o rosto do MetaHuman (normalmente de

Use cached pose 'Body Pose') - Adicione o nó

Blend Runtime MetaHuman Lip Sync - Conecte a pose ao

Source Posedo nóBlend Runtime MetaHuman Lip Sync - Conecte sua variável

VisemeGeneratorao pinoViseme Generator - Conecte a saída do nó

Blend Runtime MetaHuman Lip Syncao pinoResultdoOutput Pose

- Localize a pose que contém o rosto do MetaHuman (normalmente de

Use cached pose 'Body Pose') - Adicione o nó

Blend Realistic MetaHuman Lip Sync - Conecte a pose ao

Source Posedo nóBlend Realistic MetaHuman Lip Sync - Conecte sua variável

RealisticMetaHumanLipSyncGeneratorao pinoLip Sync Generator - Conecte a saída do nó

Blend Realistic MetaHuman Lip Syncao pinoResultdoOutput Pose

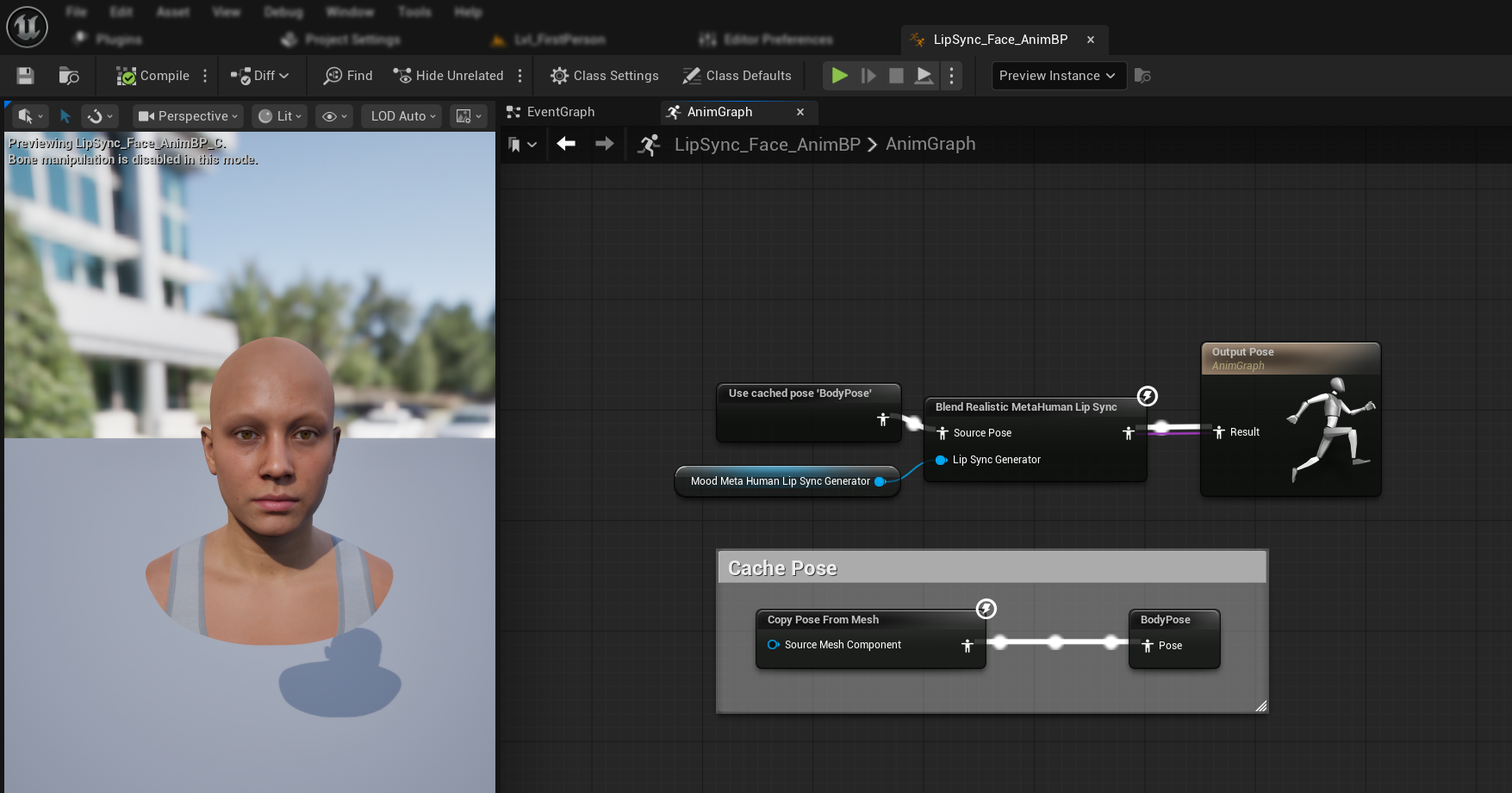

- Localize a pose que contém o rosto do MetaHuman (normalmente de

Use cached pose 'Body Pose') - Adicione o nó

Blend Realistic MetaHuman Lip Sync(mesmo nó do modelo realista regular) - Conecte a pose ao

Source Posedo nóBlend Realistic MetaHuman Lip Sync - Conecte sua variável

MoodMetaHumanLipSyncGeneratorao pinoLip Sync Generator - Conecte a saída do nó

Blend Realistic MetaHuman Lip Syncao pinoResultdoOutput Pose

Observação: O modelo habilitado para humor usa o mesmo nó de Animation Blueprint do modelo realista regular. A funcionalidade de humor é tratada internamente pelo gerador.

Próximos Passos

Agora que você concluiu a configuração básica do Animation Blueprint, será necessário configurar o processamento de entrada de áudio para alimentar os dados de áudio no seu gerador de sincronização labial.

Continue para o Guia de Processamento de Áudio para aprender como configurar diferentes métodos de entrada de áudio, incluindo captura de microfone, texto-para-voz e processamento de arquivos de áudio. Para opções avançadas de configuração e ajustes finos, consulte o Guia de Configuração.