Руководство по настройке

Это руководство проведет вас через базовый процесс настройки Runtime MetaHuman Lip Sync для ваших MetaHuman персонажей.

Примечание: Runtime MetaHuman Lip Sync работает как с MetaHuman, так и с пользовательскими персонажами. Подробные инструкции по настройке пользовательских персонажей смотрите в Руководстве по настройке пользовательских персонажей.

Предварительные требования

Перед началом убедитесь, что:

-

Требования к плагину MetaHuman:

- UE 5.5 и более ранние: Включите плагин MetaHuman в вашем проекте

- UE 5.6 и более поздние: Включите плагин MetaHuman Core Tech в вашем проекте

Дополнительные плагины MetaHumanВ зависимости от того, как вы создаете своих MetaHuman персонажей, вам могут понадобиться дополнительные плагины. Например, если вы планируете создать MetaHuman с новой системой MetaHuman Creator, представленной в UE 5.6, вам также нужно будет включить плагин MetaHuman Creator. Для получения дополнительной информации об этой системе см. документацию MetaHuman Creator.

-

У вас есть хотя бы один MetaHuman персонаж, загруженный и доступный в вашем проекте

-

Установлен плагин Runtime MetaHuman Lip Sync

Плагин расширения стандартной модели

Если вы планируете использовать Стандартную модель, вам нужно установить плагин расширения:

- Скачайте Standard Lip Sync Extension plugin с Google Drive

- Извлеките папку из загруженного архива в папку

Pluginsвашего проекта (создайте эту папку, если она не существует) - Убедитесь, что ваш проект настроен как C++ проект (даже если у вас нет кода на C++)

- Пересоберите ваш проект

- Это расширение требуется только если вы хотите использовать Стандартную модель. Если вам нужны только Реалистичные модели, вы можете пропустить этот шаг.

- Для получения дополнительной информации о том, как собирать плагины вручную, см. руководство по сборке плагинов

Дополнительные плагины

- Если вы планируете использовать захват аудио (например, ввод с микрофона), установите плагин Runtime Audio Importer.

- Если вы планируете использовать функциональность преобразования текста в речь:

- Для локального TTS (Стандартная модель и Реалистичная модель с поддержкой настроения), установите плагин Runtime Text To Speech.

- Для внешних TTS провайдеров (ElevenLabs, OpenAI, Google Cloud, Azure), установите плагин Runtime AI Chatbot Integrator.

Настройка Animation Blueprint

Шаг 1: Найдите и измените Blueprint анимации лица

- UE 5.5 и более ранние (или Legacy MetaHumans в UE 5.6+)

- Персонажи MetaHuman Creator в UE 5.6+

Вам необходимо изменить Animation Blueprint, который будет использоваться для лицевой анимации вашего персонажа MetaHuman. Стандартный Animation Blueprint лица MetaHuman находится по адресу:

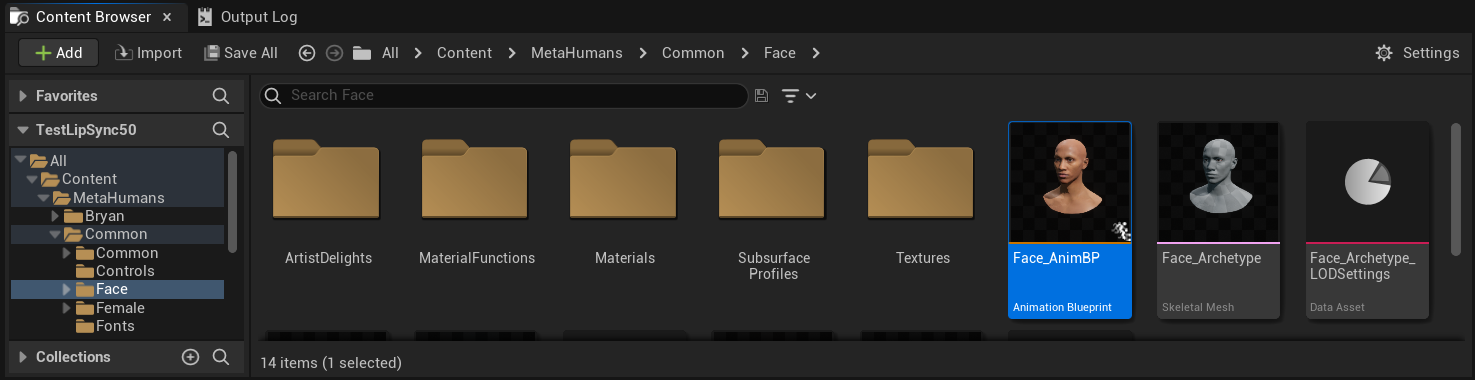

Content/MetaHumans/Common/Face/Face_AnimBP

У вас есть несколько вариантов для реализации функции синхронизации губ:

- Редактировать стандартный ассет (самый простой вариант)

- Создать дубликат

- Использовать пользовательский блюпринт анимации

Откройте стандартный Face_AnimBP напрямую и внесите свои изменения. Любые изменения затронут всех персонажей MetaHuman, использующих этот блюпринт анимации.

Примечание: Этот подход удобен, но повлияет на всех персонажей, использующих стандартный блюпринт анимации.

- Дублируйте

Face_AnimBPи дайте ему описательное имя - Найдите класс блюпринта вашего персонажа (например, для персонажа "Bryan", он будет находиться по пути

Content/MetaHumans/Bryan/BP_Bryan) - Откройте блюпринт персонажа и найдите компонент Face

- Измените свойство Anim Class на ваш новый дублированный блюпринт анимации

Примечание: Этот подход позволяет вам настроить синхронизацию губ для конкретных персонажей, оставляя других неизменными.

Вы можете реализовать смешивание синхронизации губ в любом блюпринте анимации, который имеет доступ к требуемым лицевым костям:

- Создайте или используйте существующий пользовательский блюпринт анимации

- Убедитесь, что ваш блюпринт анимации работает со скелетом, содержащим те же лицевые кости, что и стандартный

Face_Archetype_SkeletonMetaHuman

Примечание: Этот подход дает вам максимальную гибкость для интеграции с пользовательскими системами анимации.

Начиная с UE 5.6, была представлена новая система MetaHuman Creator. Для этих персонажей плагин предоставляет блюпринт анимации лица, расположенный по адресу:

Content/LipSyncData/LipSync_Face_AnimBP

Этот Animation Blueprint находится в папке контента плагина и будет перезаписываться при каждом обновлении плагина. Чтобы предотвратить потерю ваших настроек:

- Скопируйте этот ассет в папку Content вашего проекта (например, в

YourProject/Content/MetaHumans/LipSync_Face_AnimBP) - Используйте вашу скопированную версию в настройках персонажа

- Вносите все ваши модификации в скопированную версию

Использование Face Animation Blueprint плагина:

- Найдите Blueprint класс вашего персонажа из MetaHuman Creator

- Откройте Blueprint персонажа и найдите компонент Face

- Измените свойство Anim Class на

LipSync_Face_AnimBPплагина - Продолжите следующими шагами для настройки функциональности Runtime MetaHuman Lip Sync

Шаг 2: Настройка Event Graph

Откройте ваш Face Animation Blueprint и переключитесь на Event Graph. Вам нужно создать генератор, который будет обрабатывать аудиоданные и генерировать анимацию синхронизации губ.

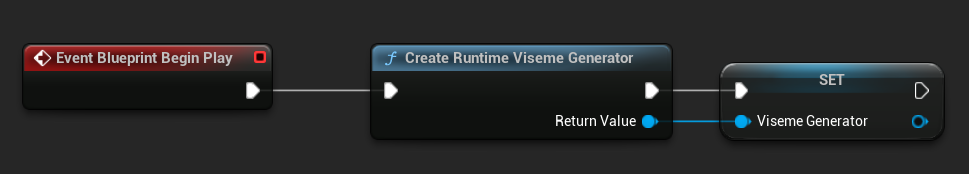

- Standard Model

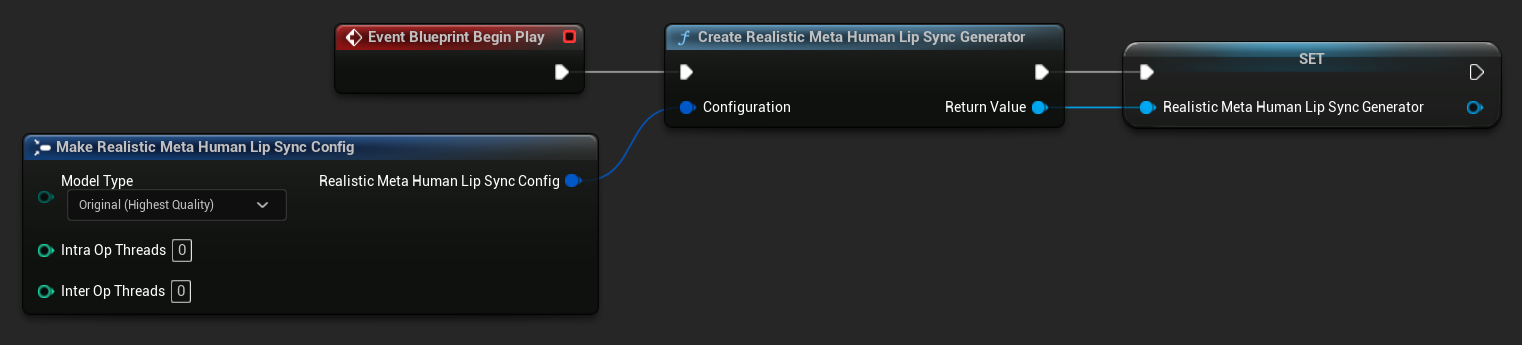

- Realistic Model

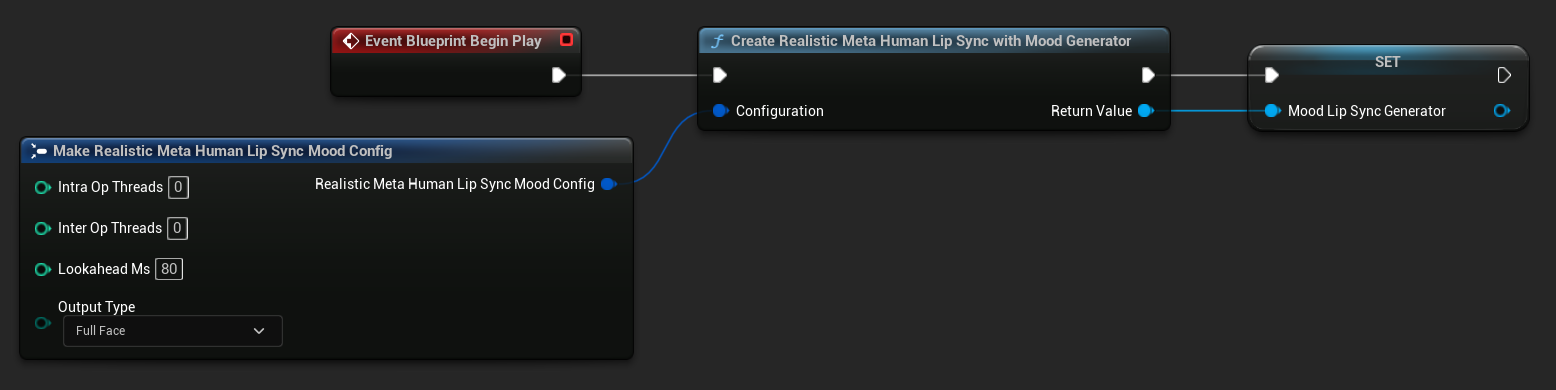

- Mood-Enabled Realistic Model

- Добавьте ноду

Event Blueprint Begin Play, если она еще не существует - Добавьте ноду

Create Runtime Viseme Generatorи подключите ее к событию Begin Play - Сохраните вывод в переменную (например, "VisemeGenerator") для использования в других частях графа

Подробные параметры конфигурации смотрите в разделе Конфигурация Standard Model.

- Добавьте ноду

Event Blueprint Begin Play, если она еще не существует - Добавьте ноду

Create Realistic MetaHuman Lip Sync Generatorи подключите ее к событию Begin Play - Сохраните вывод в переменную (например, "RealisticMetaHumanLipSyncGenerator") для использования в других частях графа

- (Опционально) Настройте параметры генератора с помощью параметра Configuration

Подробные параметры конфигурации, включая типы моделей, настройки производительности и параметры обработки, смотрите в разделе Конфигурация Realistic Model.

- Добавьте ноду

Event Blueprint Begin Play, если она еще не существует - Добавьте ноду

Create Realistic MetaHuman Lip Sync With Mood Generatorи подключите ее к событию Begin Play - Сохраните вывод в переменную (например, "MoodMetaHumanLipSyncGenerator") для использования в других частях графа

- (Опционально) Настройте параметры генератора с помощью параметра Configuration

Подробную настройку настроения, включая типы настроений, настройки интенсивности, время упреждения и выбор типа вывода, см. раздел Конфигурация модели с поддержкой настроений.

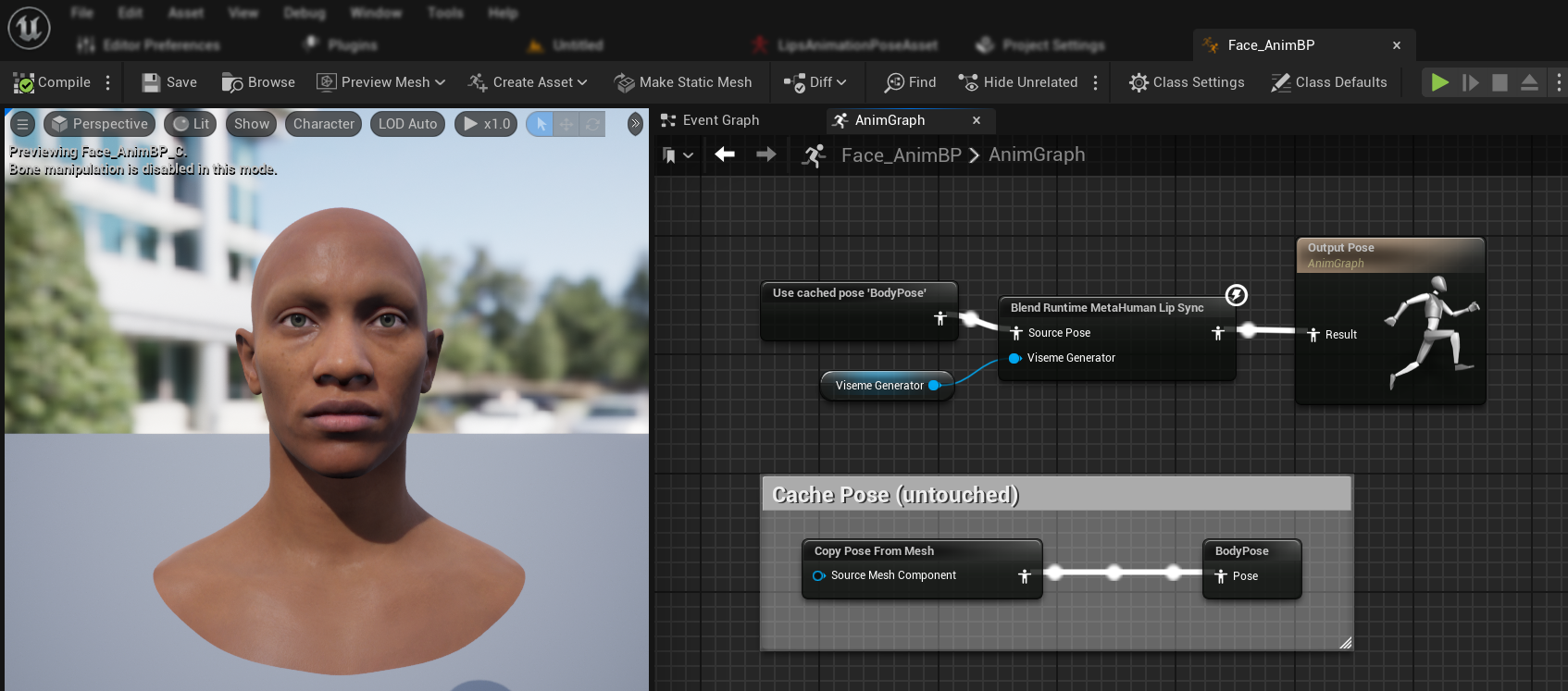

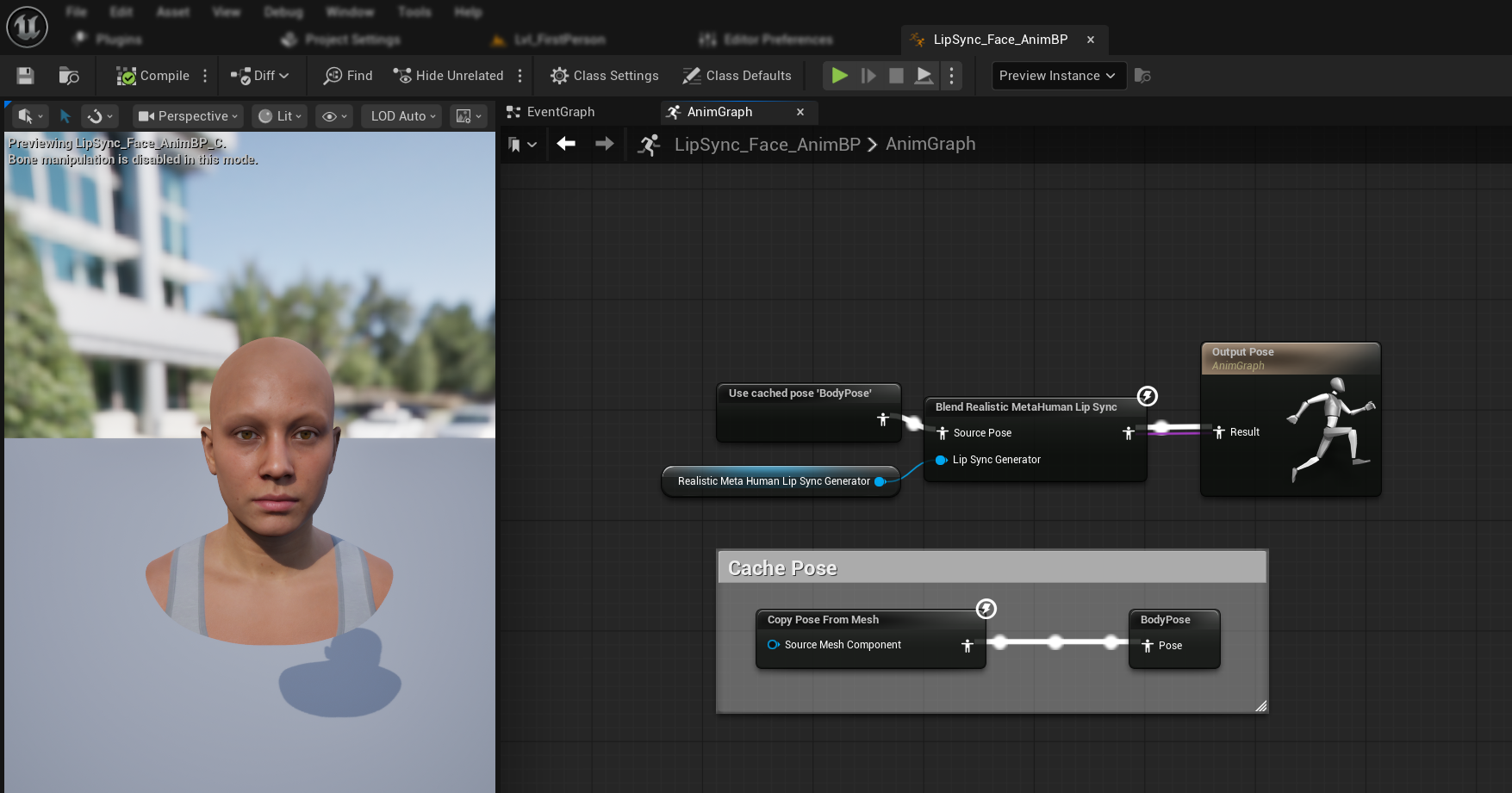

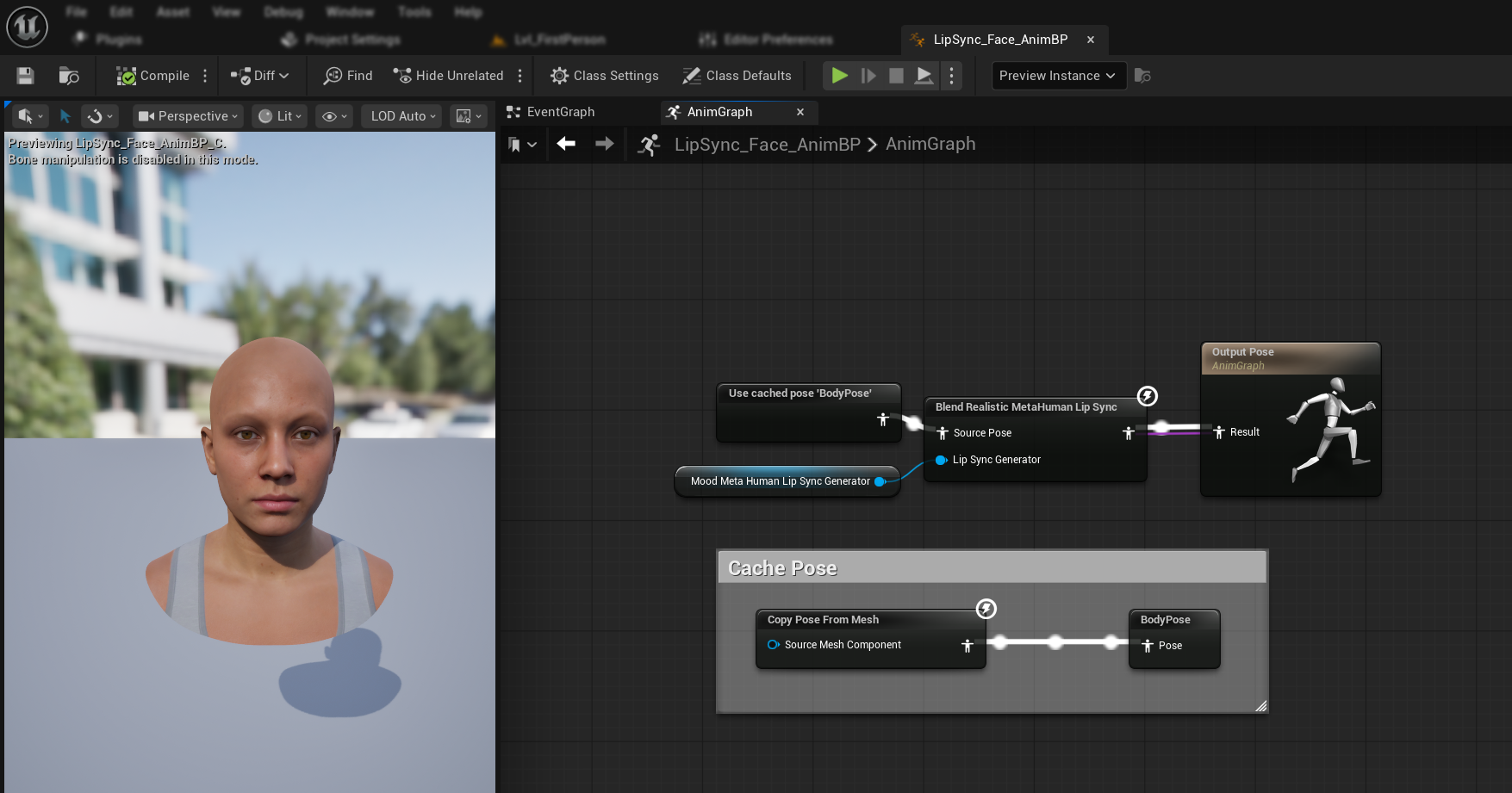

Шаг 3: Настройка Anim Graph

После настройки Event Graph переключитесь на Anim Graph, чтобы подключить генератор к анимации персонажа:

- Standard Model

- Realistic Model

- Mood-Enabled Realistic Model

- Найдите позу, содержащую лицо MetaHuman (обычно из

Use cached pose 'Body Pose') - Добавьте ноду

Blend Runtime MetaHuman Lip Sync - Подключите позу к входу

Source PoseнодыBlend Runtime MetaHuman Lip Sync - Подключите вашу переменную

VisemeGeneratorк пинуViseme Generator - Подключите выход ноды

Blend Runtime MetaHuman Lip Syncк пинуResultнодыOutput Pose

- Найдите позу, содержащую лицо MetaHuman (обычно из

Use cached pose 'Body Pose') - Добавьте ноду

Blend Realistic MetaHuman Lip Sync - Подключите позу к входу

Source PoseнодыBlend Realistic MetaHuman Lip Sync - Подключите вашу переменную

RealisticMetaHumanLipSyncGeneratorк пинуLip Sync Generator - Подключите выход ноды

Blend Realistic MetaHuman Lip Syncк пинуResultнодыOutput Pose

- Найдите позу, содержащую лицо MetaHuman (обычно из

Use cached pose 'Body Pose') - Добавьте ноду

Blend Realistic MetaHuman Lip Sync(та же нода, что и для обычной реалистичной модели) - Подключите позу к входу

Source PoseнодыBlend Realistic MetaHuman Lip Sync - Подключите вашу переменную

MoodMetaHumanLipSyncGeneratorк пинуLip Sync Generator - Подключите выход ноды

Blend Realistic MetaHuman Lip Syncк пинуResultнодыOutput Pose

Примечание: Модель с поддержкой настроений использует ту же ноду Animation Blueprint, что и обычная реалистичная модель. Функциональность настроений обрабатывается внутри генератора.

Следующие шаги

Теперь, когда базовая настройка Animation Blueprint завершена, вам нужно настроить обработку аудиовхода для подачи аудиоданных в ваш генератор синхронизации губ.

Перейдите к Руководству по обработке аудио, чтобы узнать, как настроить различные методы аудиоввода, включая захват с микрофона, преобразование текста в речь и обработку аудиофайлов. Для расширенных параметров конфигурации и тонкой настройки обратитесь к Руководству по конфигурации.