Çeviri Sağlayıcılar

AI Localization Automator, her biri benzersiz güçlü yönlere ve yapılandırma seçeneklerine sahip beş farklı AI sağlayıcısını destekler. Projenizin ihtiyaçlarına, bütçesine ve kalite gereksinimlerine en uygun sağlayıcıyı seçin.

Ollama (Yerel AI)

En iyi kullanım: Gizlilik hassasiyeti olan projeler, çevrimdışı çeviri, sınırsız kullanım

Ollama, AI modellerini makinenizde yerel olarak çalıştırır, API maliyeti veya internet gereksinimi olmadan tam gizlilik ve kontrol sağlar.

Popüler Modeller

- llama3.2 (Önerilen genel amaçlı)

- mistral (Verimli alternatif)

- codellama (Kod farkında çeviriler)

- Ve daha birçok topluluk modeli

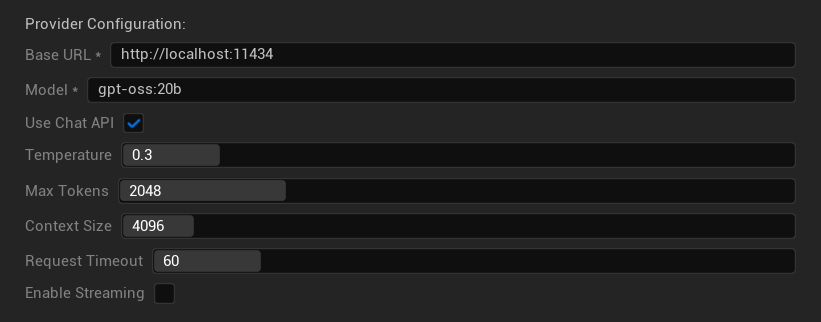

Yapılandırma Seçenekleri

- Temel URL: Yerel Ollama sunucusu (varsayılan:

http://localhost:11434) - Model: Yerel olarak yüklenmiş modelin adı (gerekli)

- Sohbet API'sini Kullan: Daha iyi sohbet işleme için etkinleştir

- Sıcaklık: 0.0-2.0 (0.3 önerilir)

- Maksimum Token: 1-8,192 token

- Bağlam Boyutu: 512-32,768 token

- İstek Zaman Aşımı: 10-300 saniye (yerel modeller daha yavaş olabilir)

- Akışı Etkinleştir: Gerçek zamanlı yanıt işleme için

Güçlü Yönler

- ✅ Tam gizlilik (hiçbir veri makinenizden ayrılmaz)

- ✅ API maliyeti veya kullanım sınırı yok

- ✅ Çevrimdışı çalışır

- ✅ Model parametreleri üzerinde tam kontrol

- ✅ Geniş topluluk modeli çeşitliliği

- ✅ Tedarikçi kilidi yok

Dikkat Edilmesi Gerekenler

- 💻 Yerel kurulum ve yetenekli donanım gerektirir

- ⚡ Genellikle bulut sağlayıcılarından daha yavaştır

- 🔧 Daha teknik kurulum gerektirir

- 📊 Çeviri kalitesi modele göre önemli ölçüde değişir (bazıları bulut sağlayıcılarını aşabilir)

- 💾 Modeller için büyük depolama gereksinimleri

Ollama Kurulumu

- Ollama'yı Yükle: ollama.ai adresinden indirin ve sisteminize kurun

- Modelleri İndir: Seçtiğiniz modeli indirmek için

ollama pull llama3.2kullanın - Sunucuyu Başlat: Ollama otomatik olarak çalışır veya

ollama serveile başlatın - Eklentiyi Yapılandır: Eklenti ayarlarında temel URL ve model adını ayarlayın

- Bağlantıyı Test Et: Eklenti, yapılandırmayı uyguladığınızda bağlantıyı doğrulayacaktır

OpenAI

En iyi kullanım: En yüksek genel çeviri kalitesi, kapsamlı model seçimi

OpenAI, en son GPT modellerini ve yeni Responses API formatını içeren, sektör lideri dil modellerini API'leri aracılığıyla sağlar.

Mevcut Modeller

- gpt-5 (En son amiral gemisi model)

- gpt-5-mini (Daha küçük, daha hızlı varyant)

- gpt-4.1 ve gpt-4.1-mini

- gpt-4o ve gpt-4o-mini (Optimize edilmiş modeller)

- o3 ve o3-mini (Gelişmiş akıl yürütme)

- o1 ve o1-mini (Önceki nesil)

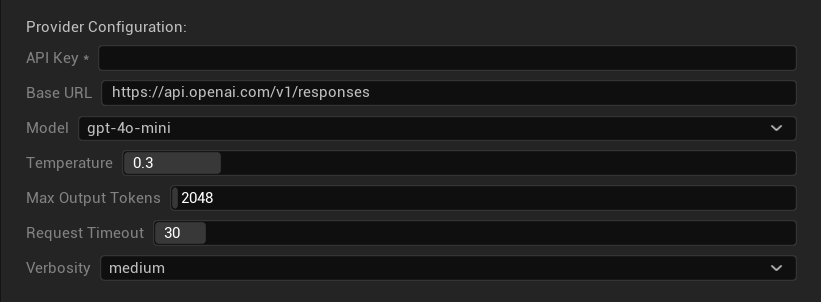

Yapılandırma Seçenekleri

- API Anahtarı: OpenAI API anahtarınız (gerekli)

- Temel URL: API uç noktası (varsayılan: OpenAI sunucuları)

- Model: Mevcut GPT modellerinden seçim yapın

- Sıcaklık: 0.0-2.0 (çeviri tutarlılığı için 0.3 önerilir)

- Maksimum Çıktı Tokenları: 1-128,000 token

- İstek Zaman Aşımı: 5-300 saniye

- Ayrıntı Düzeyi: Yanıt ayrıntı seviyesini kontrol edin

Güçlü Yönler

- ✅ Tutarlı yüksek kaliteli çeviriler

- ✅ Mükemmel bağlam anlama

- ✅ Güçlü biçim koruma

- ✅ Geniş dil desteği

- ✅ Güvenilir API çalışma süresi

Dikkat Edilmesi Gerekenler

- 💰 İstek başına daha yüksek maliyet

- 🌐 İnternet bağlantısı gerektirir

- ⏱️ Kademeye göre kullanım sınırları

Anthropic Claude

En İyi Kullanım: Nüanslı çeviriler, yaratıcı içerik, güvenlik odaklı uygulamalar

Claude modelleri bağlamı ve nüansları anlamada üstündür, bu da onları hikaye ağırlıklı oyunlar ve karmaşık yerelleştirme senaryoları için ideal kılar.

Mevcut Modeller

- claude-opus-4-1-20250805 (En son amiral gemisi)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (Hızlı ve verimli)

- claude-3-haiku-20240307

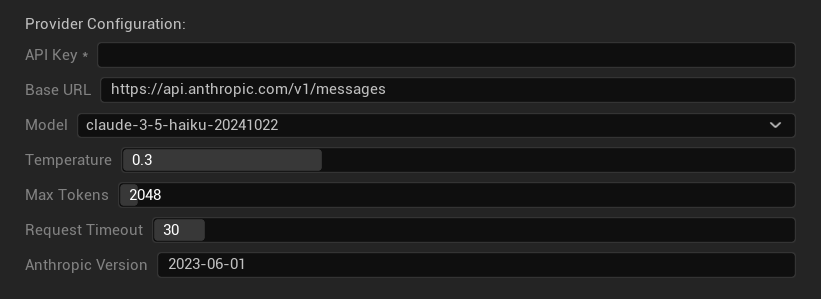

Yapılandırma Seçenekleri

- API Anahtarı: Anthropic API anahtarınız (gerekli)

- Temel URL: Claude API uç noktası

- Model: Claude model ailesinden seçim yapın

- Sıcaklık: 0.0-1.0 (0.3 önerilir)

- Maksimum Token: 1-64,000 token

- İstek Zaman Aşımı: 5-300 saniye

- Anthropic Sürümü: API sürüm başlığı

Güçlü Yönler

- ✅ Olağanüstü bağlam farkındalığı

- ✅ Yaratıcı/hikaye içeriği için harika

- ✅ Güçlü güvenlik özellikleri

- ✅ Detaylı akıl yürütme yetenekleri

- ✅ Mükemmel talimat takibi

Dikkat Edilmesi Gerekenler

- 💰 Premium fiyatlandırma modeli

- 🌐 İnternet bağlantısı gerektirir

- 📏 Token sınırları modele göre değişir

DeepSeek

En İyi Kullanım: Uygun maliyetli çeviri, yüksek iş hacmi, bütçe odaklı projeler

DeepSeek, diğer sağlayıcılara kıyasla çok daha düşük maliyetle rekabetçi çeviri kalitesi sunarak büyük ölçekli yerelleştirme projeleri için idealdir.

Mevcut Modeller

- deepseek-chat (Genel amaçlı, önerilir)

- deepseek-reasoner (Gelişmiş akıl yürütme yetenekleri)

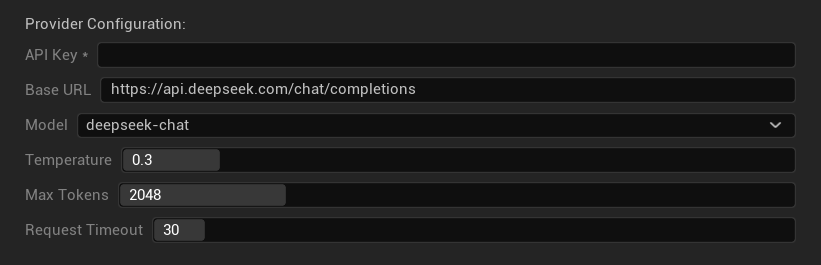

Yapılandırma Seçenekleri

- API Anahtarı: DeepSeek API anahtarınız (gerekli)

- Temel URL: DeepSeek API uç noktası

- Model: Sohbet ve akıl yürütme modelleri arasında seçim yapın

- Sıcaklık: 0.0-2.0 (0.3 önerilir)

- Maksimum Token: 1-8,192 token

- İstek Zaman Aşımı: 5-300 saniye

Güçlü Yönler

- ✅ Çok uygun maliyetli

- ✅ İyi çeviri kalitesi

- ✅ Hızlı yanıt süreleri

- ✅ Basit yapılandırma

- ✅ Yüksek oran sınırları

Değerlendirmeler

- 📏 Daha düşük token limitleri

- 🆕 Daha yeni sağlayıcı (daha az geçmiş performans)

- 🌐 İnternet bağlantısı gerektirir

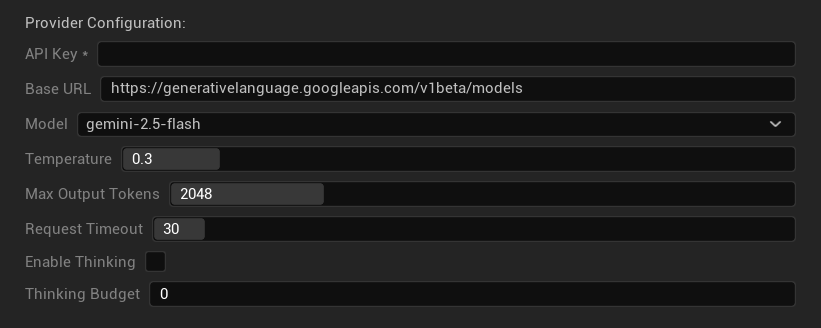

Google Gemini

En iyi kullanım alanı: Çok dilli projeler, uygun maliyetli çeviri, Google ekosistemi entegrasyonu

Gemini modelleri, gelişmiş akıl yürütme için düşünme modu gibi benzersiz özelliklerle, rekabetçi fiyatlandırma ve güçlü çok dilli yetenekler sunar.

Mevcut Modeller

- gemini-2.5-pro (Düşünme özellikli en son amiral gemisi model)

- gemini-2.5-flash (Hızlı, düşünme desteği ile)

- gemini-2.5-flash-lite (Hafif sürüm)

- gemini-2.0-flash ve gemini-2.0-flash-lite

- gemini-1.5-pro ve gemini-1.5-flash

Yapılandırma Seçenekleri

- API Anahtarı: Google AI API anahtarınız (gerekli)

- Temel URL: Gemini API uç noktası

- Model: Gemini model ailesinden seçim yapın

- Sıcaklık (Temperature): 0.0-2.0 (0.3 önerilir)

- Maksimum Çıktı Tokenları: 1-8,192 token

- İstek Zaman Aşımı: 5-300 saniye

- Düşünmeyi Etkinleştir: 2.5 modelleri için gelişmiş akıl yürütmeyi etkinleştir

- Düşünme Bütçesi: Düşünme token tahsisini kontrol edin

Güçlü Yönler

- ✅ Güçlü çok dilli destek

- ✅ Rekabetçi fiyatlandırma

- ✅ Gelişmiş akıl yürütme (düşünme modu)

- ✅ Google ekosistemi entegrasyonu

- ✅ Düzenli model güncellemeleri

Değerlendirmeler

- 🧠 Düşünme modu token kullanımını artırır

- 📏 Modele göre değişken token limitleri

- 🌐 İnternet bağlantısı gereklidir

Doğru Sağlayıcıyı Seçme

| Sağlayıcı | En İyi Kullanım Alanı | Kalite | Maliyet | Kurulum | Gizlilik |

|---|---|---|---|---|---|

| Ollama | Gizlilik/çevrimdışı | Değişken* | Ücretsiz | Gelişmiş | Yerel |

| OpenAI | En yüksek kalite | ⭐⭐⭐⭐⭐ | 💰💰💰 | Kolay | Bulut |

| Claude | Yaratıcı içerik | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | Kolay | Bulut |

| DeepSeek | Bütçe projeleri | ⭐⭐⭐⭐ | 💰 | Kolay | Bulut |

| Gemini | Çok dilli | ⭐⭐⭐⭐ | 💰 | Kolay | Bulut |

*Ollama için kalite, kullanılan yerel modele bağlı olarak önemli ölçüde değişir - bazı modern yerel modeller bulut sağlayıcılarıyla eşleşebilir veya onları aşabilir.

Sağlayıcı Yapılandırma İpuçları

Tüm Bulut Sağlayıcıları İçin:

- API anahtarlarını güvenli bir şekilde saklayın ve onları sürüm kontrolüne işlemeyin

- Tutarlı çeviriler için muhafazakar sıcaklık ayarları (0.3) ile başlayın

- API kullanımınızı ve maliyetlerinizi izleyin

- Büyük çeviri çalıştırmalarından önce küçük gruplarla test edin

Ollama İçin:

- Yeterli RAM olduğundan emin olun (daha büyük modeller için 8GB+ önerilir)

- Daha iyi model yükleme performansı için SSD depolama kullanın

- Daha hızlı çıkarım için GPU hızlandırmayı düşünün

- Üretim çevirileri için güvenmeden önce yerel olarak test edin