Ses İşleme Kılavuzu

Bu kılavuz, dudak senkronizasyonu üreteçlerinize ses verisi beslemek için farklı ses giriş yöntemlerini nasıl kuracağınızı kapsar. Devam etmeden önce Kurulum Kılavuzu'nu tamamladığınızdan emin olun.

Ses Giriş İşleme

Ses girişini işlemek için bir yöntem kurmanız gerekiyor. Ses kaynağınıza bağlı olarak bunu yapmanın birkaç yolu vardır.

- Mikrofon (Gerçek Zamanlı)

- Mikrofon (Oynatma)

- Metinden Sese (Yerel)

- Metinden Sese (Harici API'lar)

- Ses Dosyası/Arabelleğinden

- Akış Ses Arabelleği

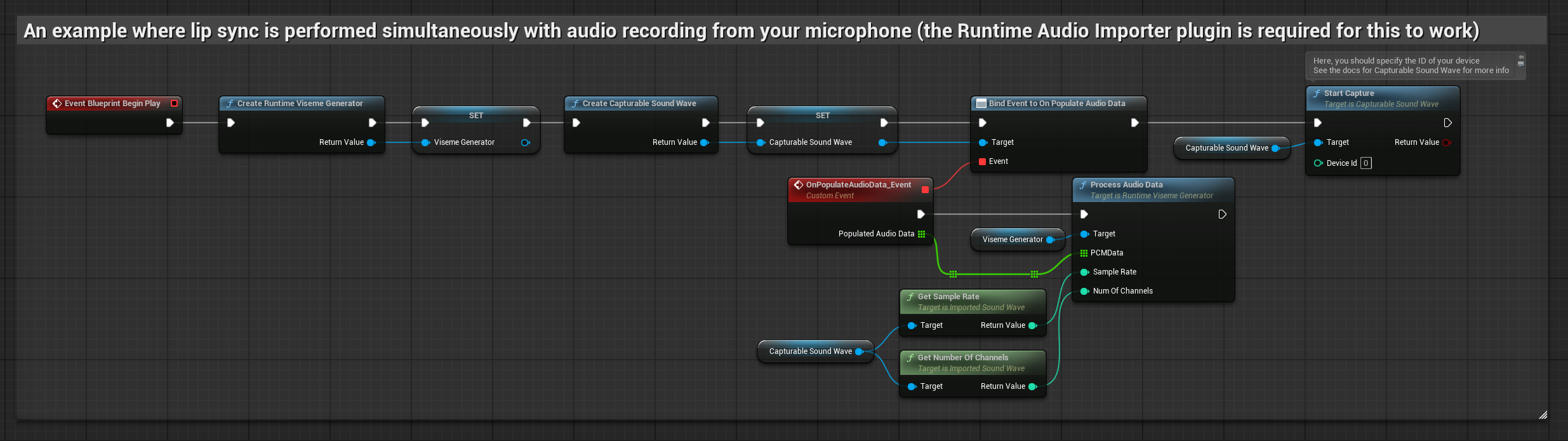

Bu yaklaşım, mikrofonla konuşurken dudak senkronizasyonunu gerçek zamanlı olarak gerçekleştirir:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Runtime Audio Importer kullanarak bir Capturable Sound Wave oluşturun

- Pixel Streaming ile Linux için, bunun yerine Pixel Streaming Capturable Sound Wave kullanın

- Ses yakalamaya başlamadan önce,

OnPopulateAudioDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın - Mikrofondan ses yakalamaya başlayın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

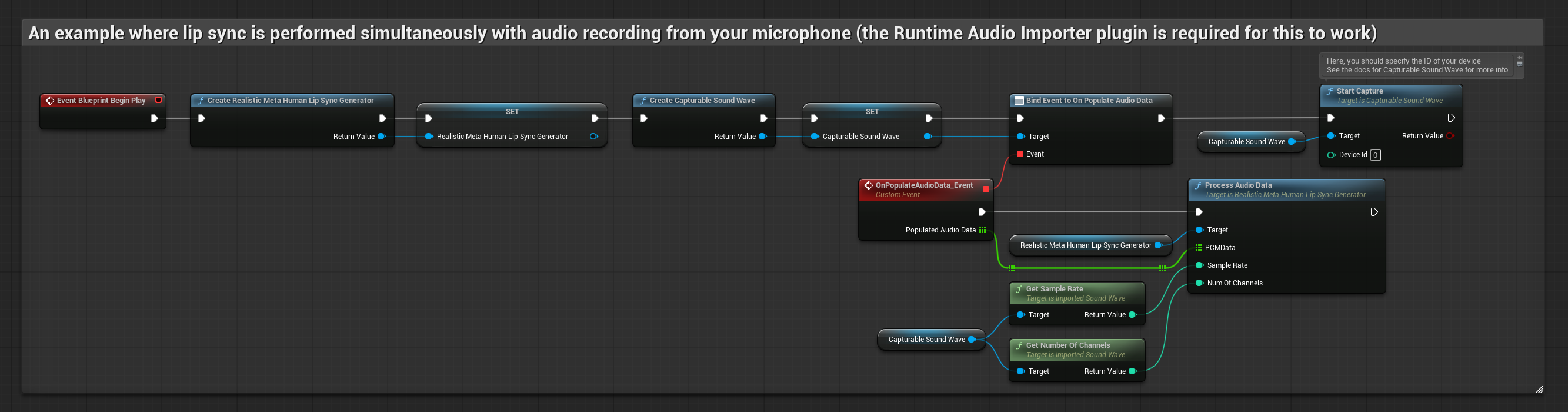

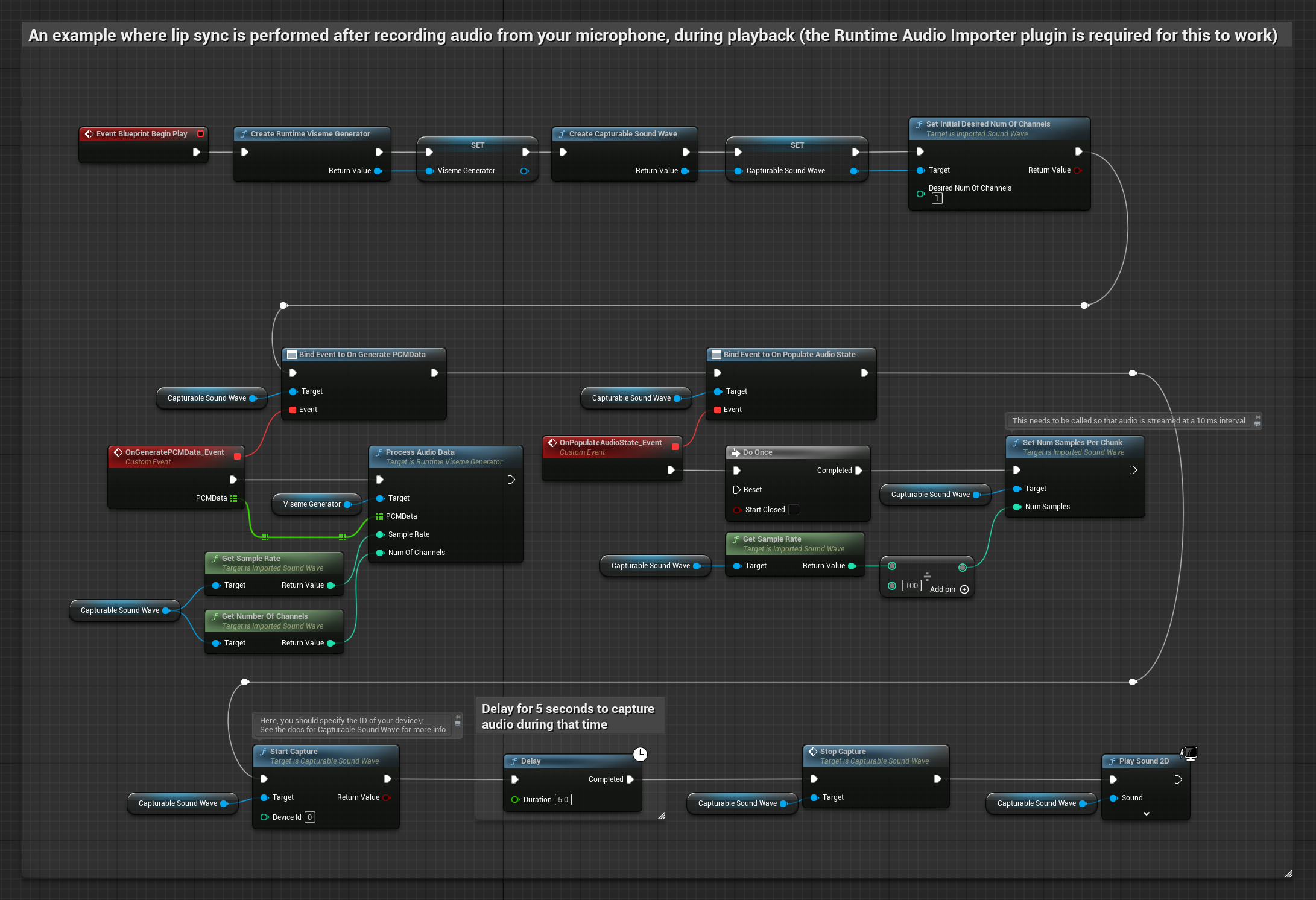

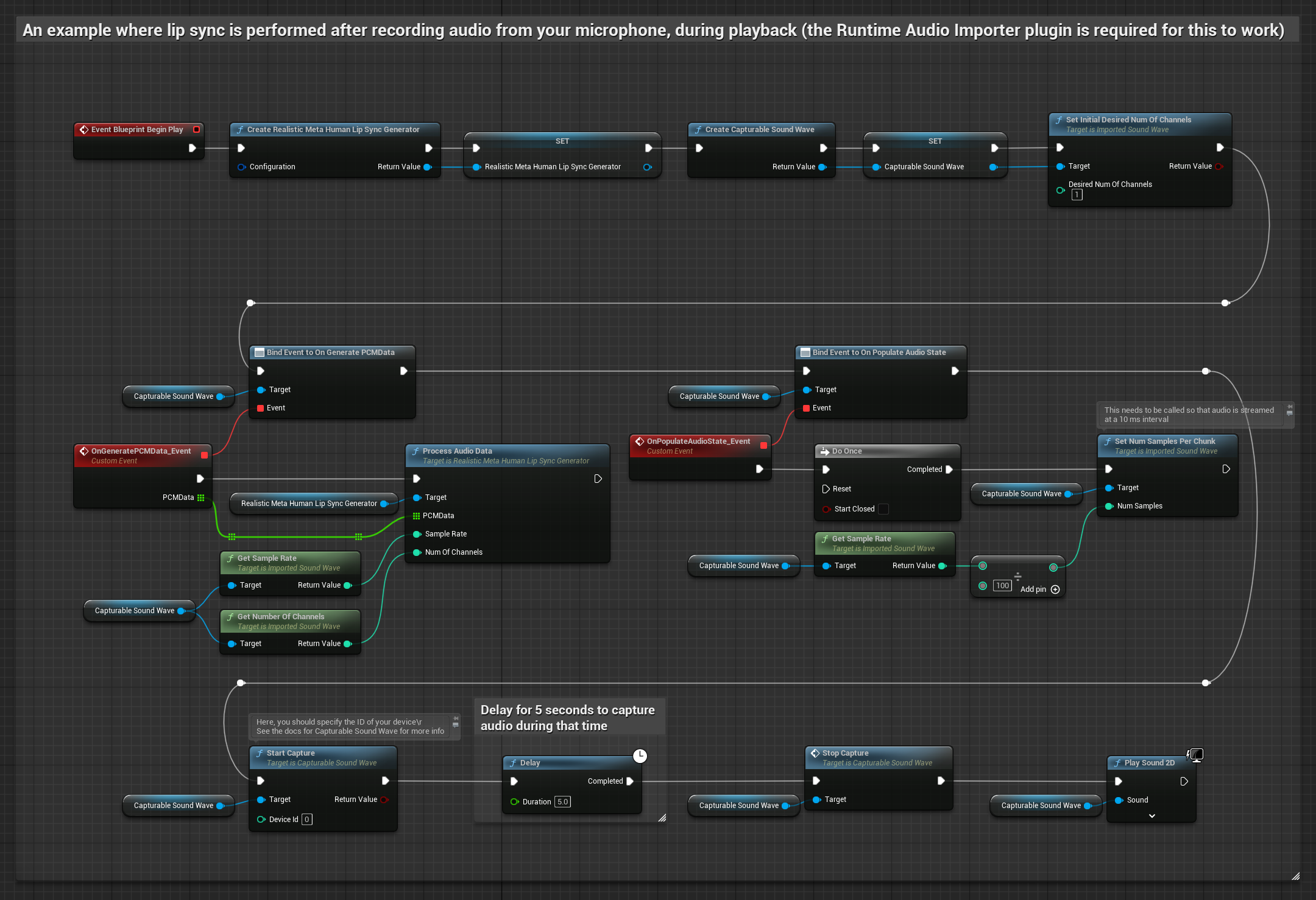

Bu yaklaşım, bir mikrofondan ses yakalar, ardından dudak senkronizasyonu ile oynatır:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Runtime Audio Importer kullanarak bir Capturable Sound Wave oluşturun

- Pixel Streaming ile Linux için, bunun yerine Pixel Streaming Capturable Sound Wave kullanın

- Mikrofondan ses yakalamaya başlayın

- Yakalanabilir ses dalgasını oynatmadan önce,

OnGeneratePCMDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

- Düzenli

- Akış

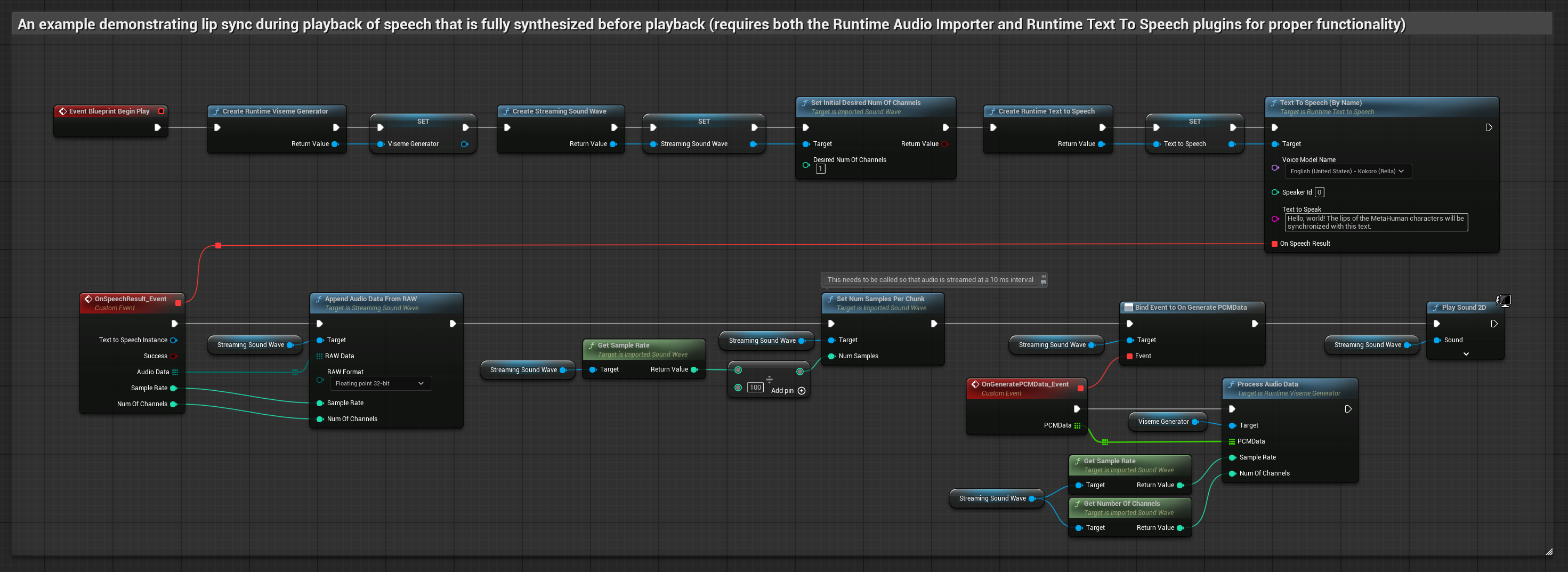

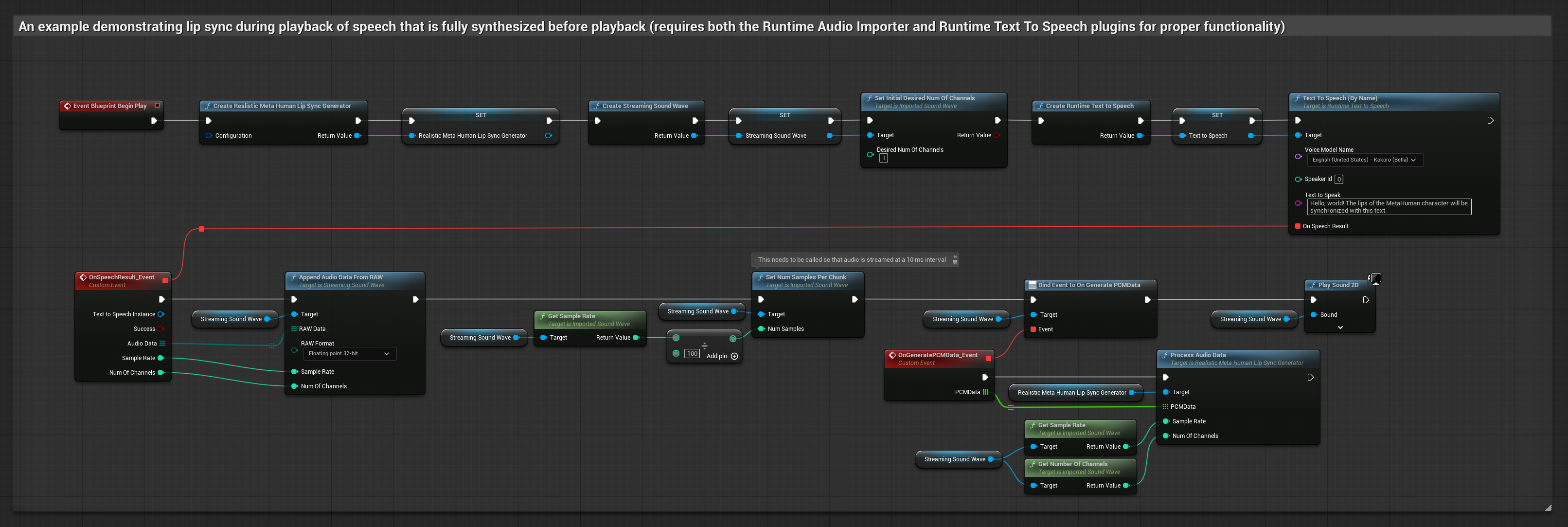

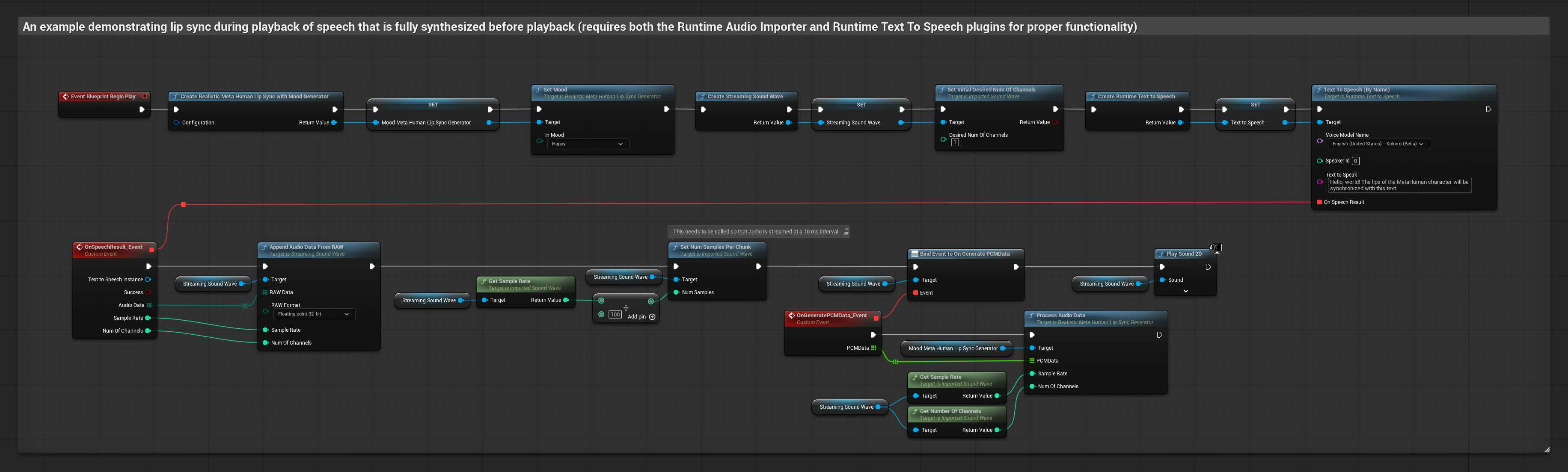

Bu yaklaşım, yerel TTS kullanarak metinden konuşma sentezler ve dudak senkronizasyonu gerçekleştirir:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Metinden konuşma oluşturmak için Runtime Text To Speech kullanın

- Sentezlenen sesi içe aktarmak için Runtime Audio Importer kullanın

- İçe aktarılan ses dalgasını oynatmadan önce,

OnGeneratePCMDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

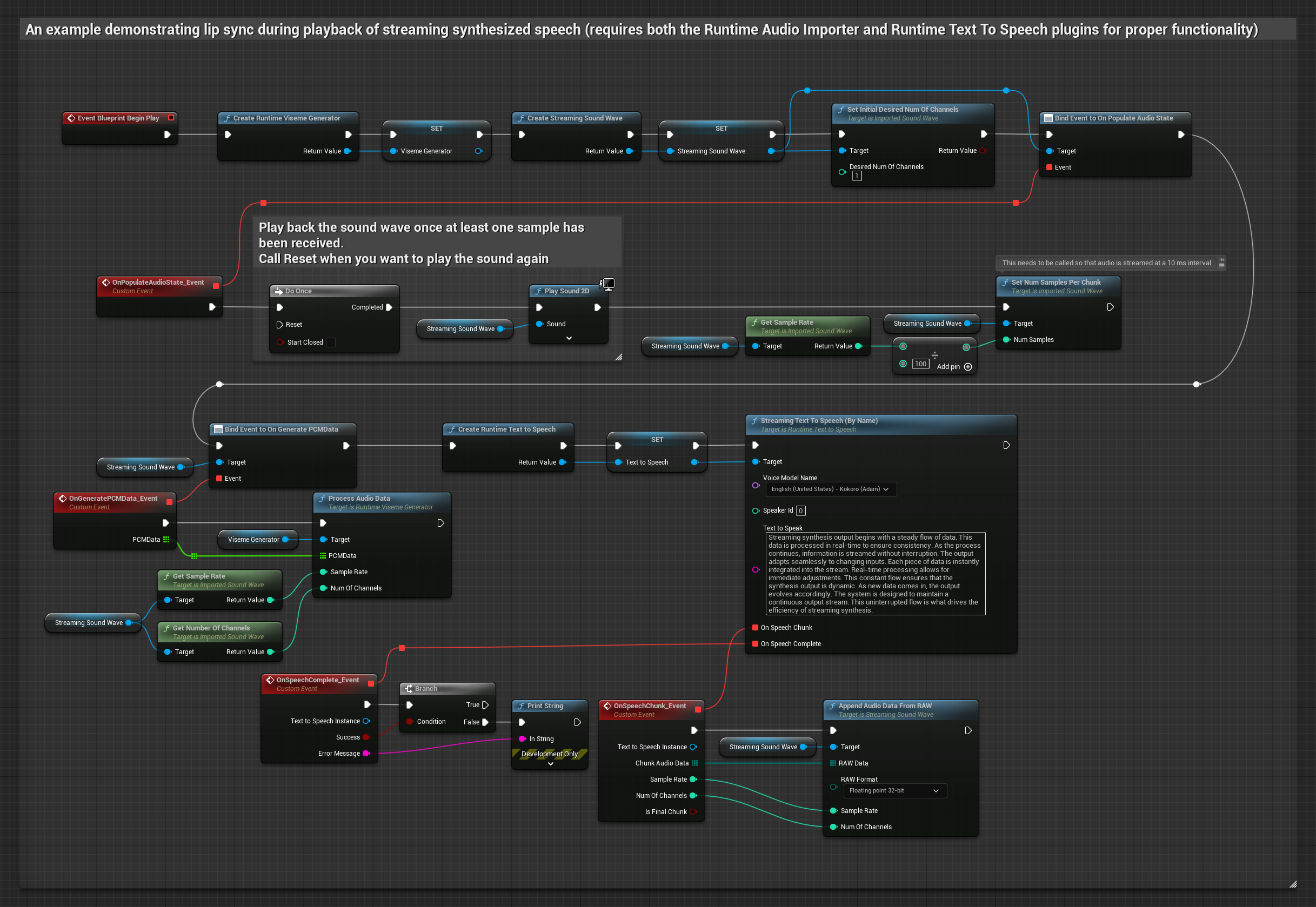

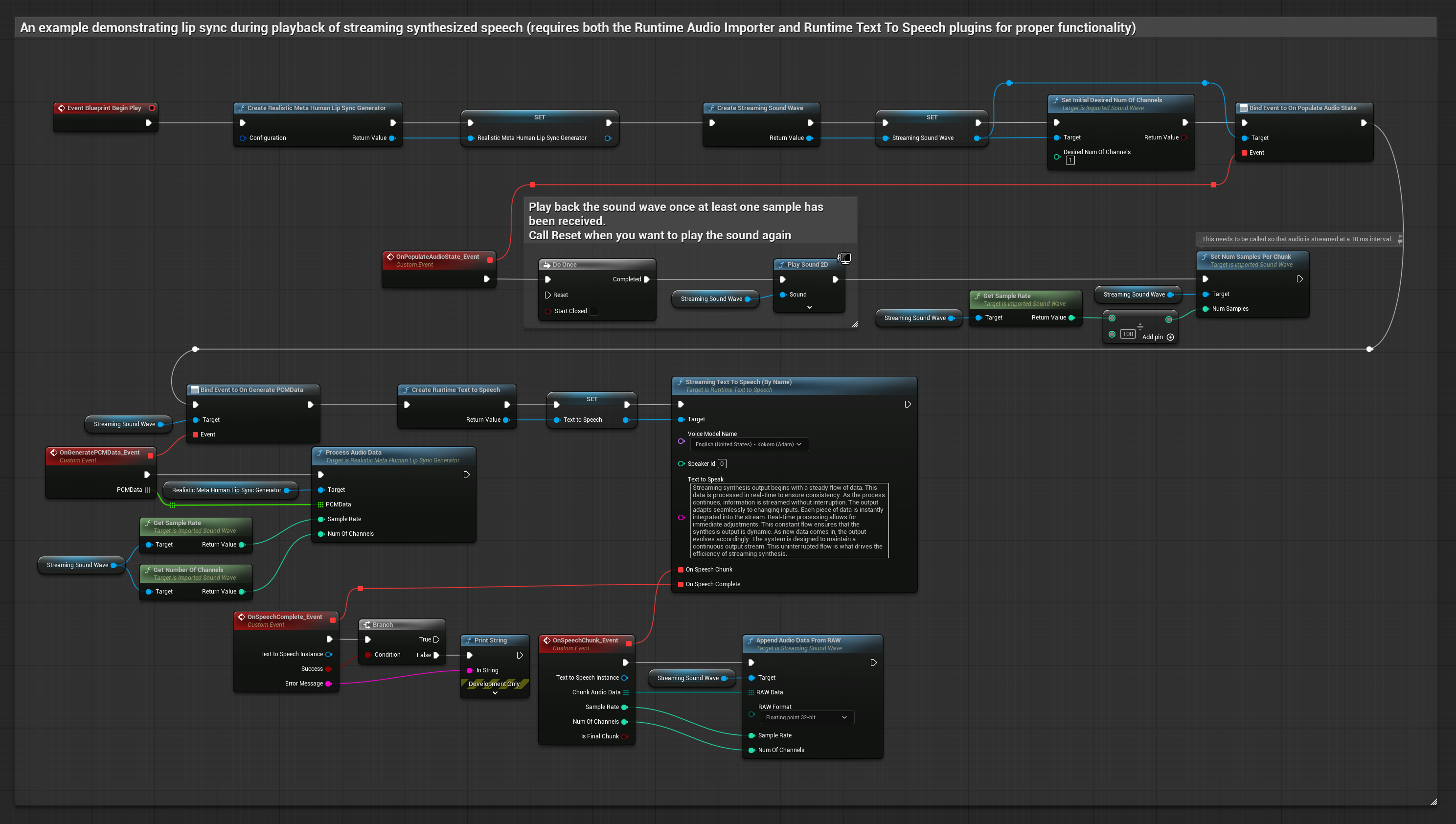

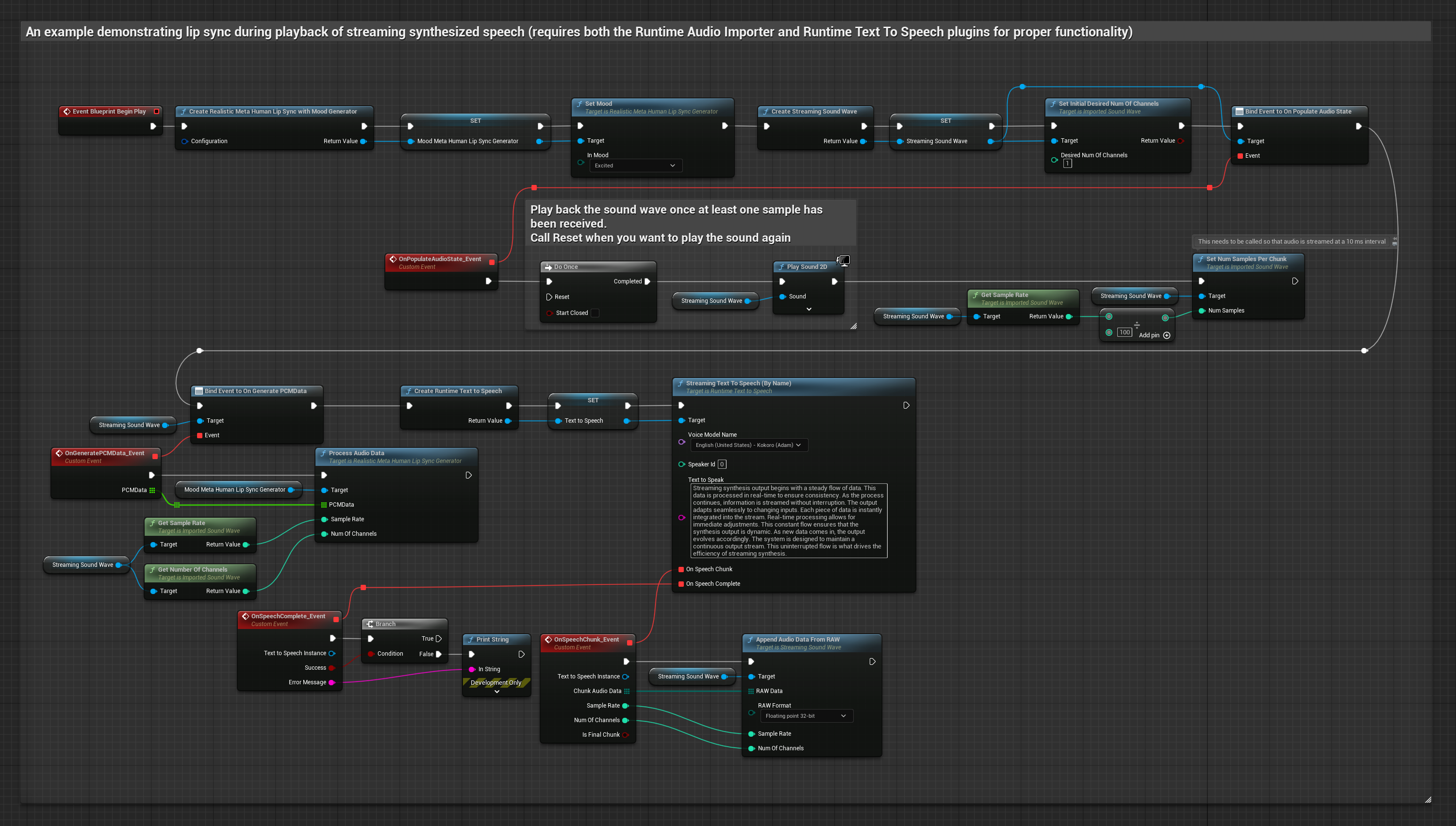

Bu yaklaşım, gerçek zamanlı dudak senkronizasyonu ile akış metinden sese sentezi kullanır:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Metinden akış konuşması oluşturmak için Runtime Text To Speech kullanın

- Sentezlenen sesi içe aktarmak için Runtime Audio Importer kullanın

- Akış ses dalgasını oynatmadan önce,

OnGeneratePCMDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

- Düzenli

- Akış

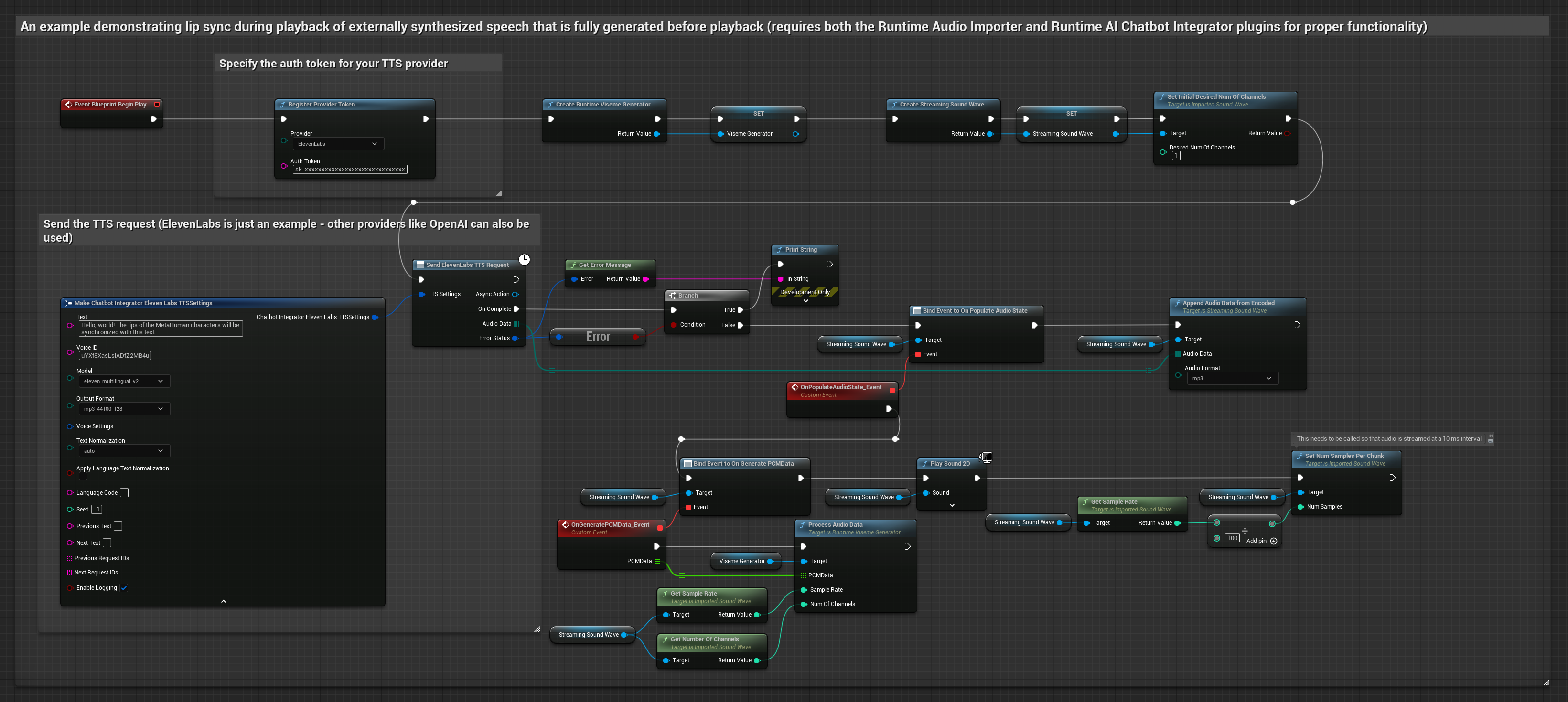

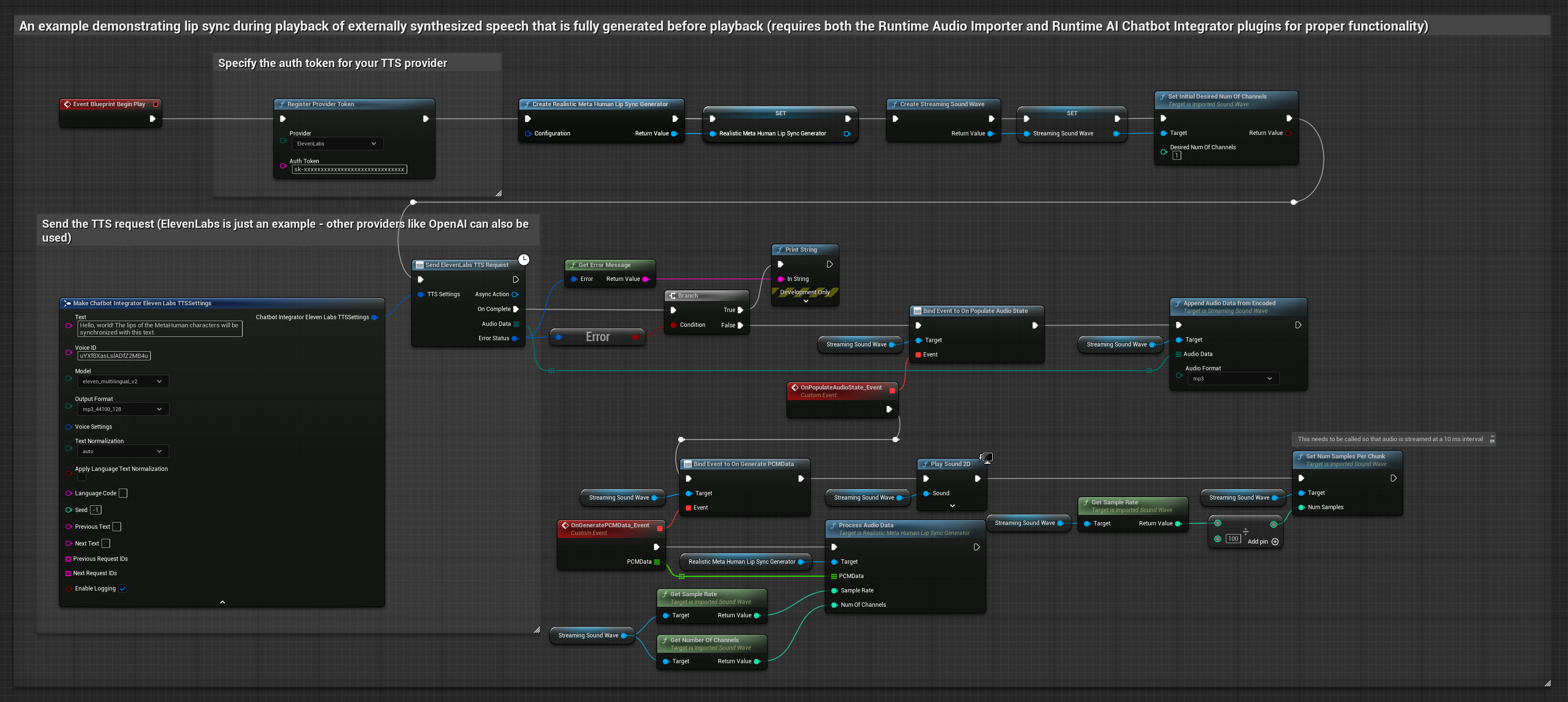

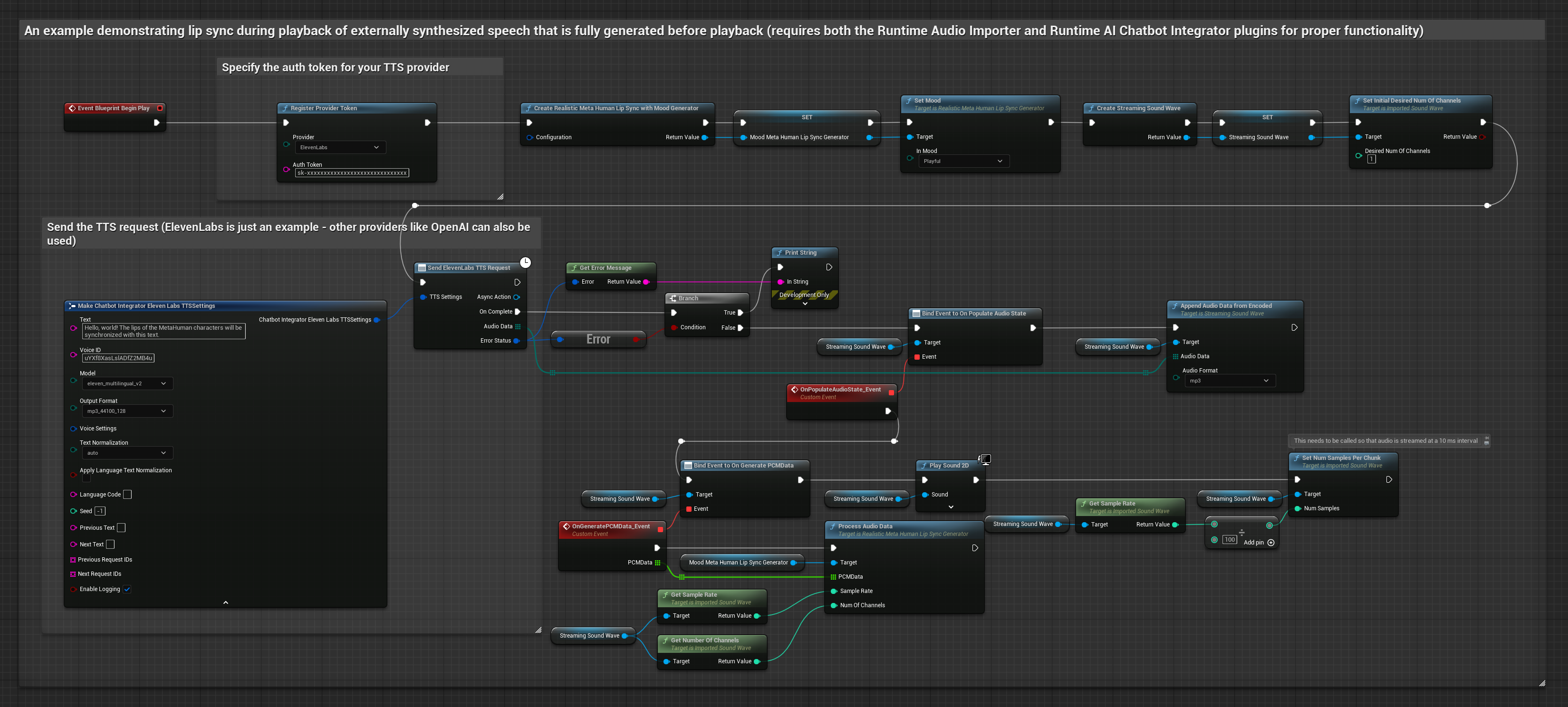

Bu yaklaşım, Runtime AI Chatbot Integrator eklentisini kullanarak AI servislerinden (OpenAI veya ElevenLabs) sentezlenmiş konuşma oluşturur ve dudak senkronizasyonu gerçekleştirir:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Harici API'lar (OpenAI, ElevenLabs, vb.) kullanarak metinden konuşma oluşturmak için Runtime AI Chatbot Integrator kullanın

- Sentezlenen ses verilerini içe aktarmak için Runtime Audio Importer kullanın

- İçe aktarılan ses dalgasını oynatmadan önce,

OnGeneratePCMDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

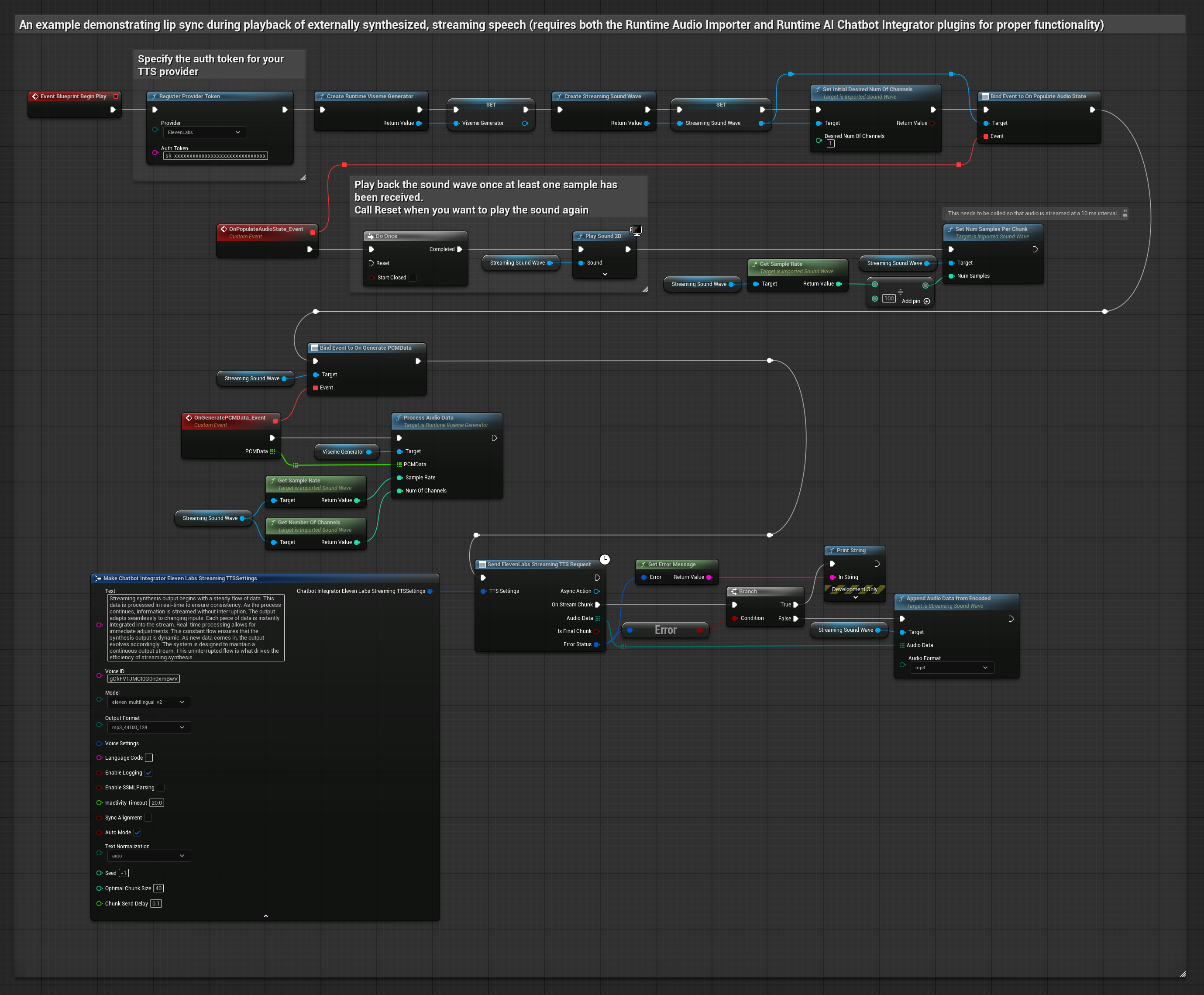

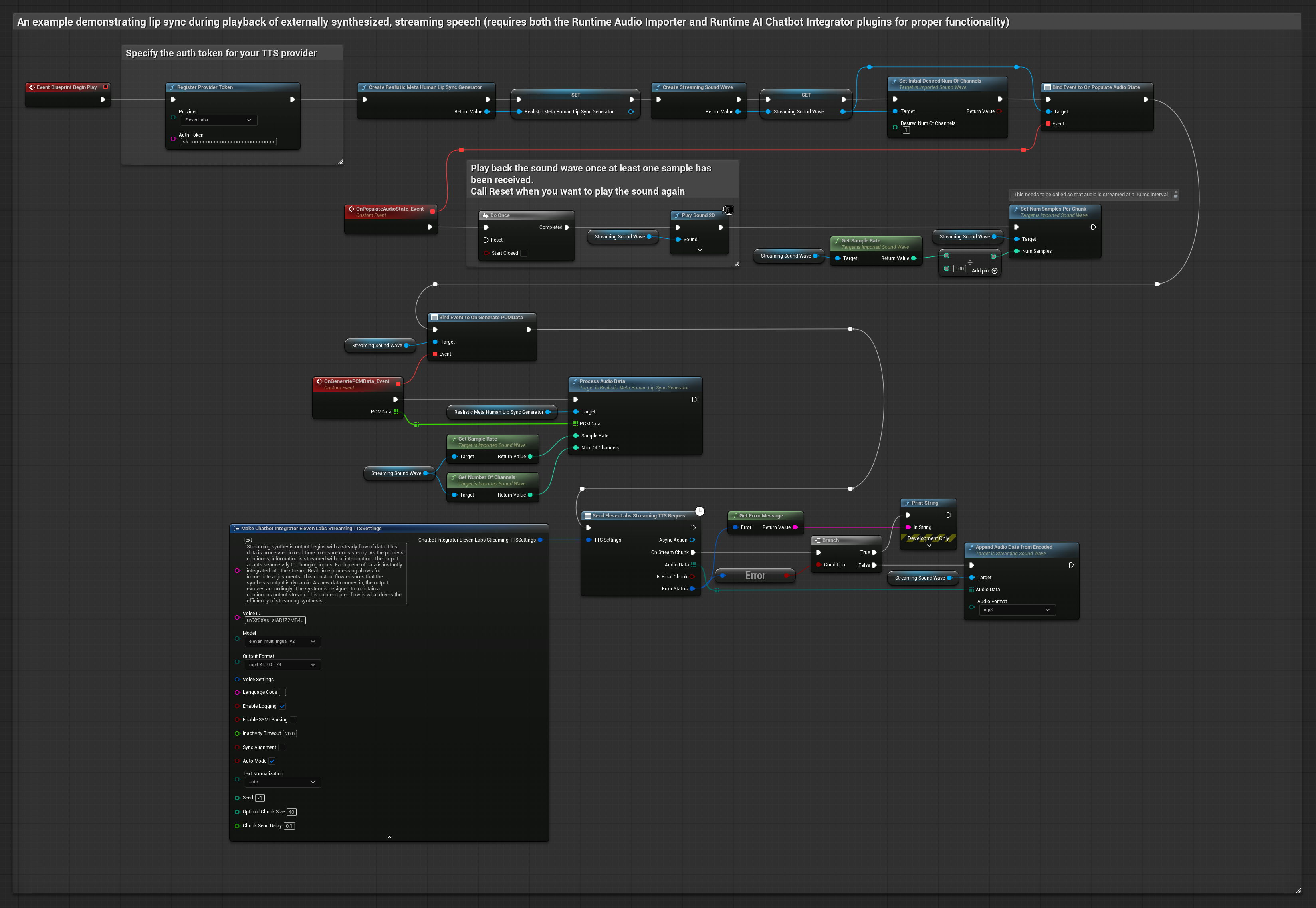

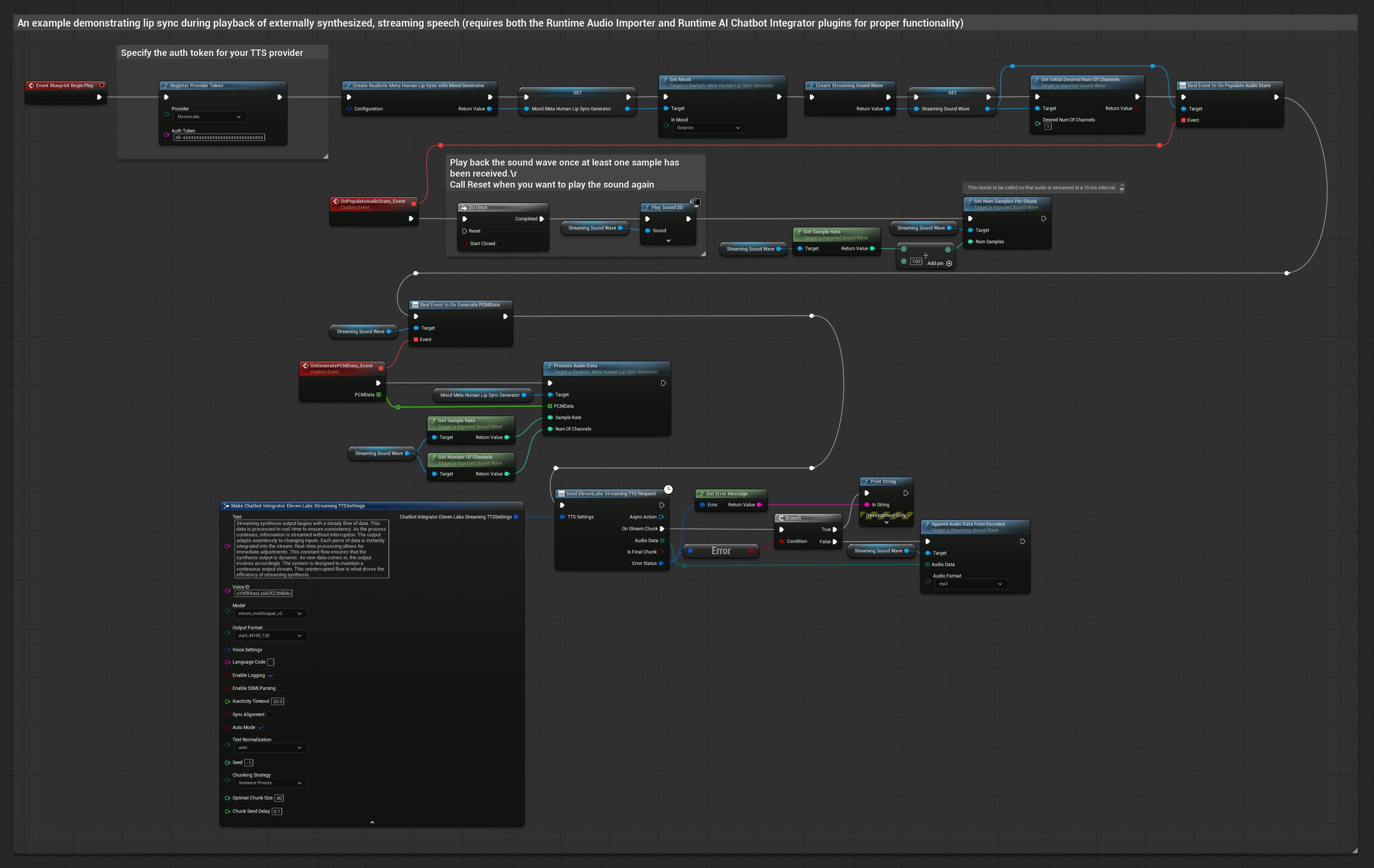

Bu yaklaşım, Runtime AI Chatbot Integrator eklentisini kullanarak AI servislerinden (OpenAI veya ElevenLabs) sentezlenmiş akış konuşması oluşturur ve dudak senkronizasyonu gerçekleştirir:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Akış TTS API'larına (ElevenLabs Streaming API gibi) bağlanmak için Runtime AI Chatbot Integrator kullanın

- Sentezlenen ses verilerini içe aktarmak için Runtime Audio Importer kullanın

- Akış ses dalgasını oynatmadan önce,

OnGeneratePCMDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

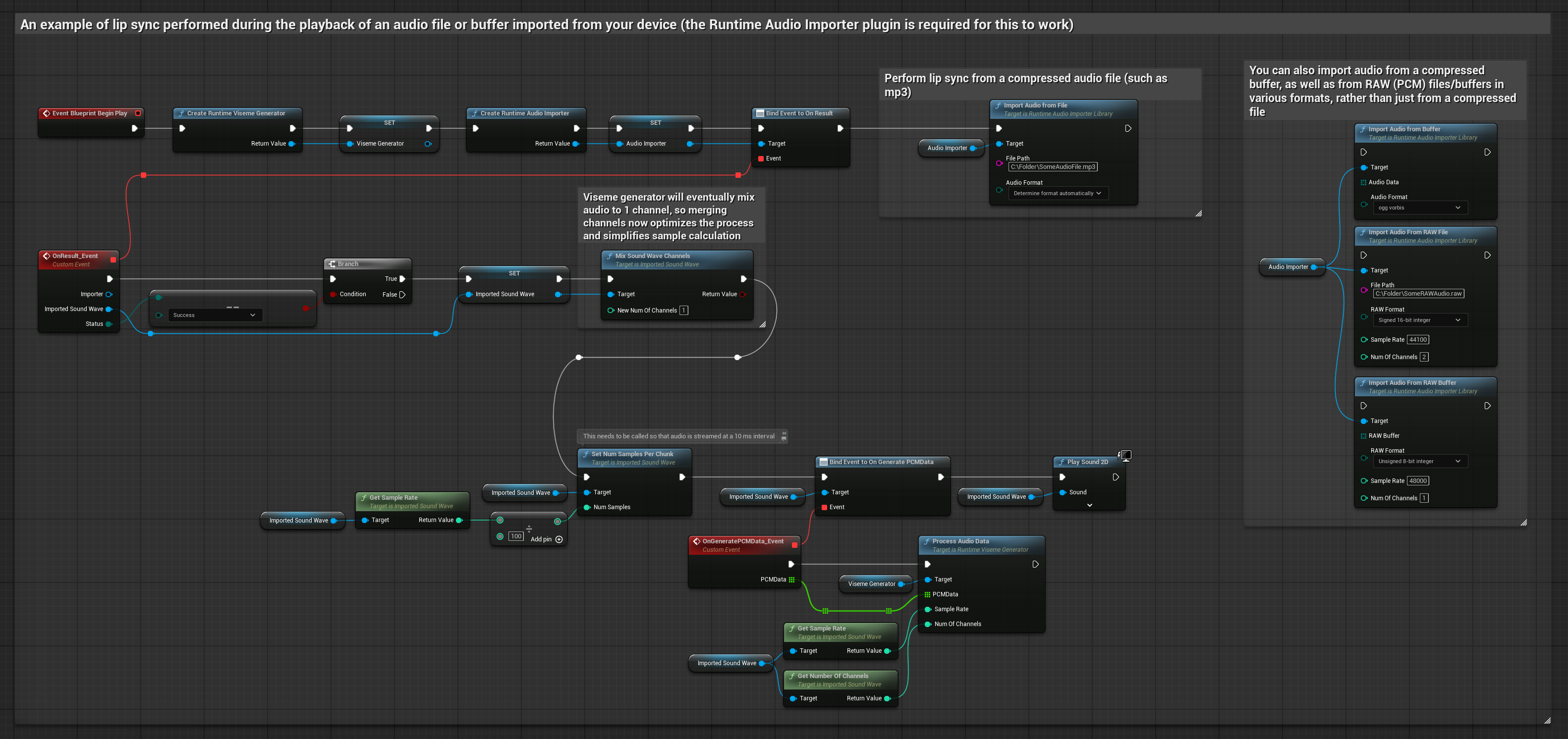

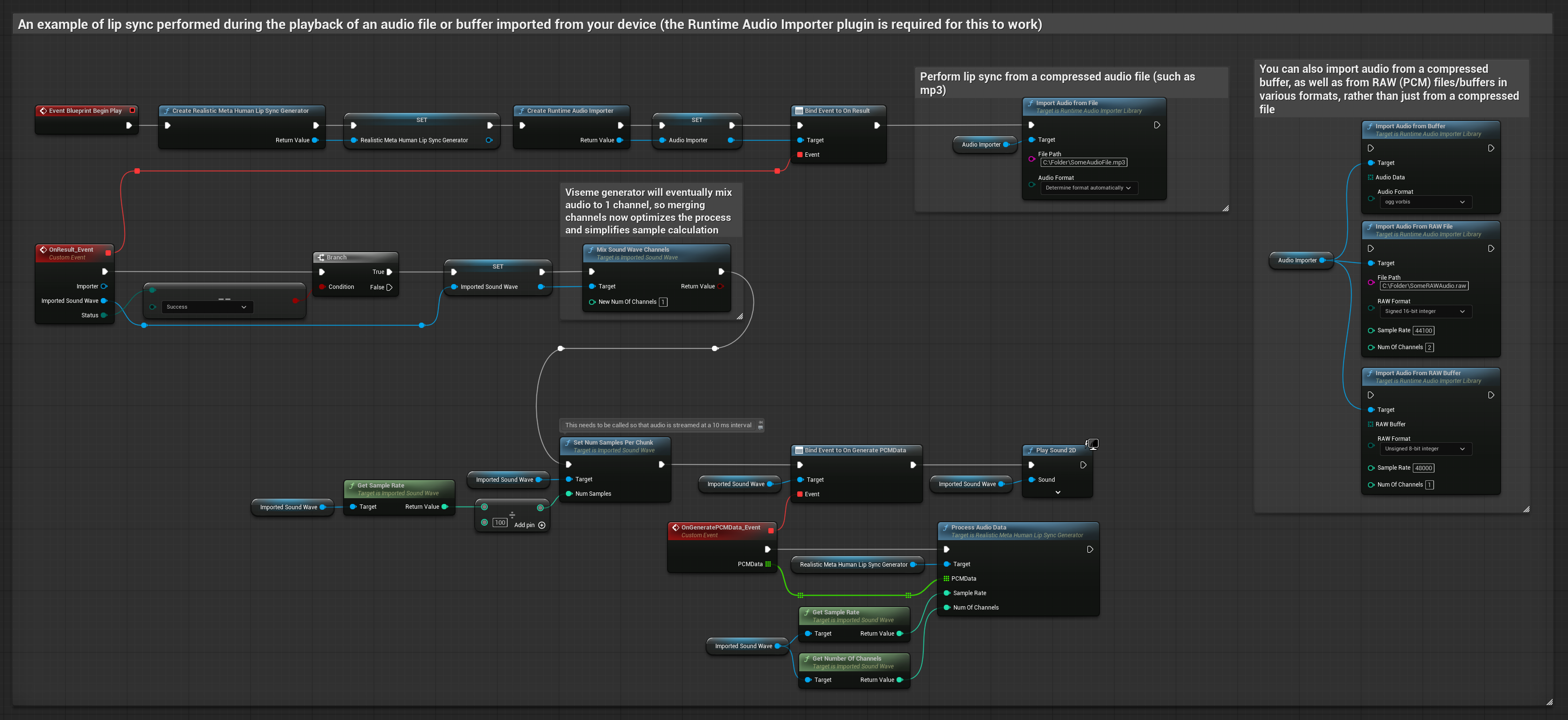

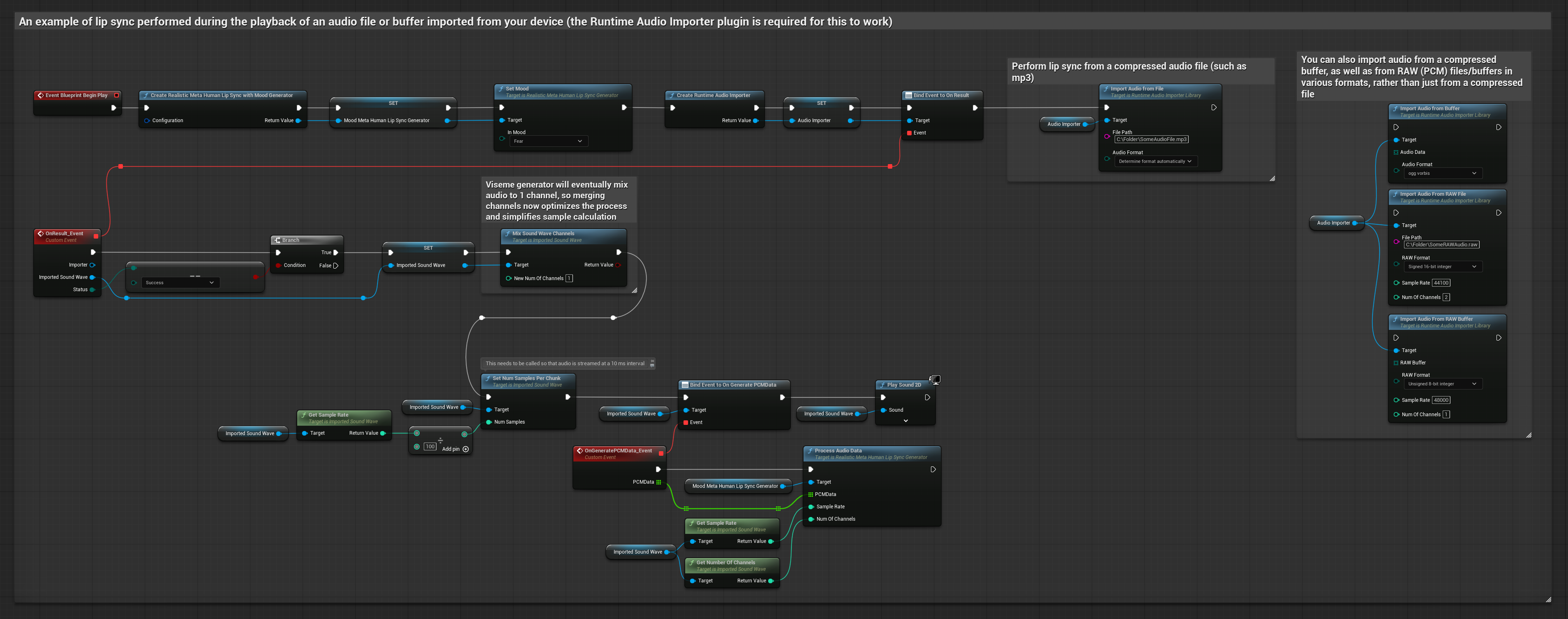

Bu yaklaşım, dudak senkronizasyonu için önceden kaydedilmiş ses dosyalarını veya ses arabelleklerini kullanır:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Diskten veya bellekten bir ses dosyasını içe aktarmak için Runtime Audio Importer kullanın

- İçe aktarılan ses dalgasını oynatmadan önce,

OnGeneratePCMDatatemsilcisine bağlanın - Bağlanan fonksiyonda, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu çağırın - İçe aktarılan ses dalgasını oynatın ve dudak senkronizasyonu animasyonunu gözlemleyin

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

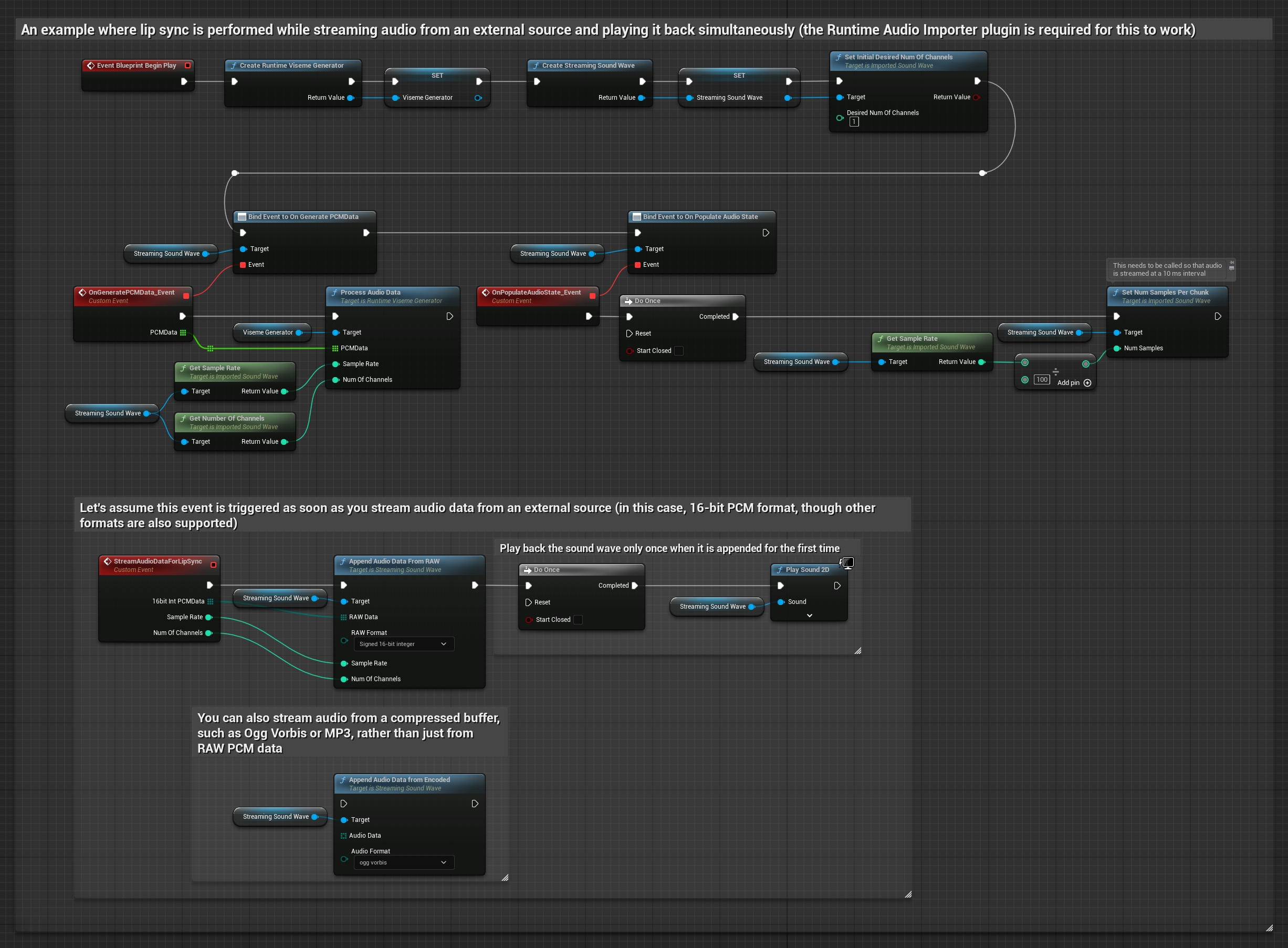

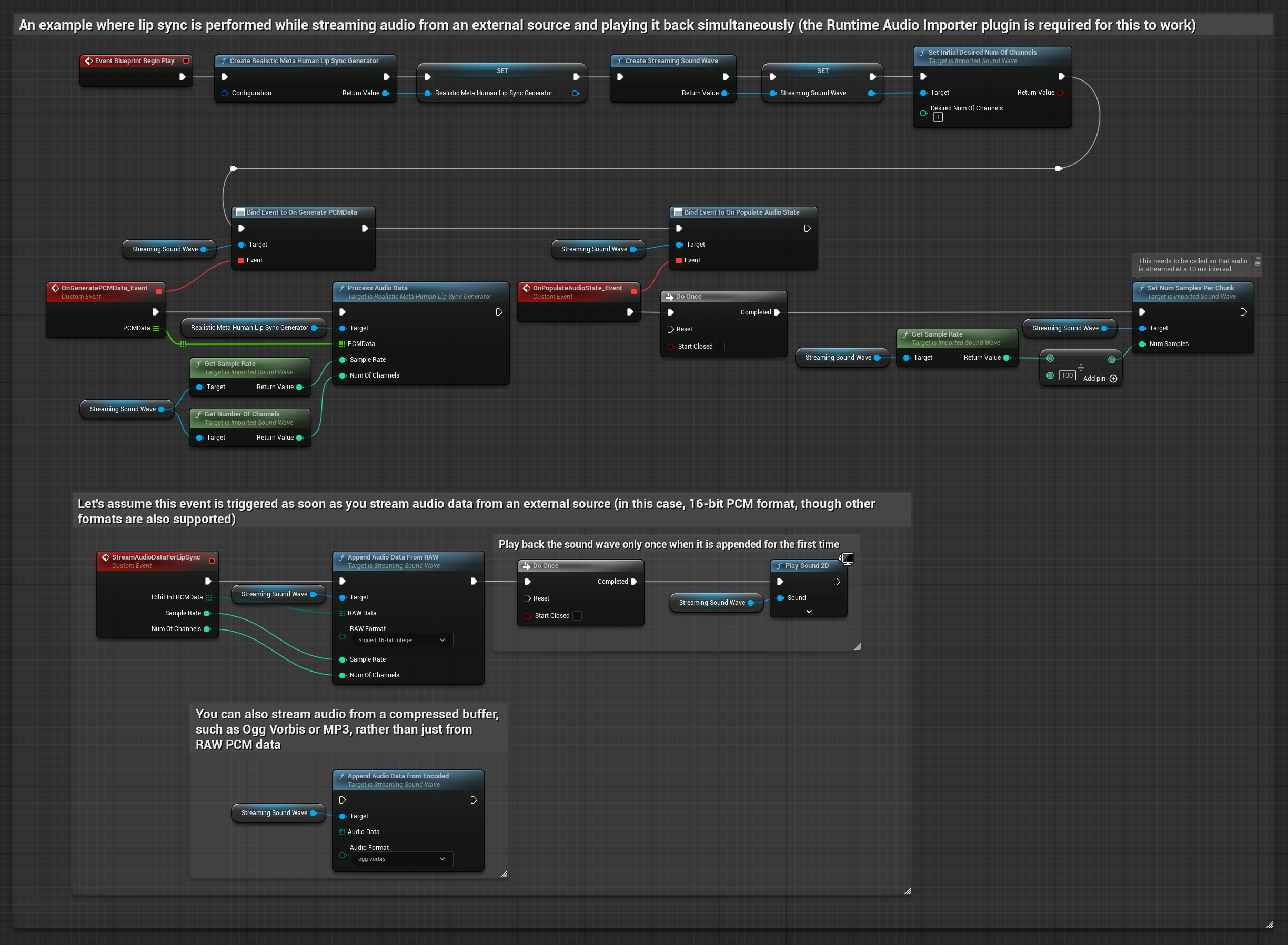

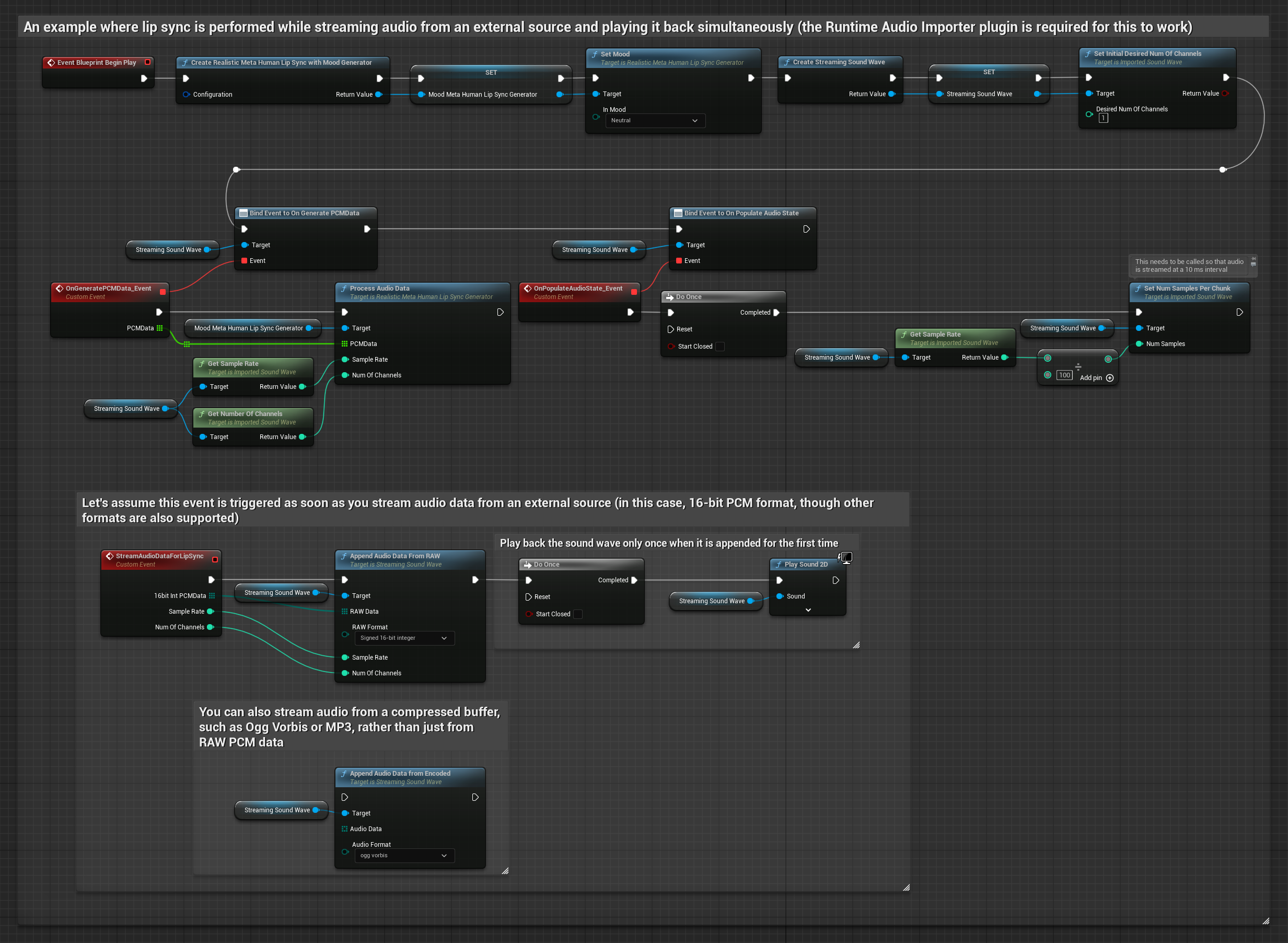

Bir arabellekten akış ses verisi için şunlara ihtiyacınız var:

- Standart Model

- Gerçekçi Model

- Ruh Hali Etkinleştirilmiş Gerçekçi Model

- Akış kaynağınızdan kayan nokta PCM formatında ses verisi (kayan nokta örneklerinden oluşan bir dizi) (veya daha fazla formatı desteklemek için Runtime Audio Importer kullanın)

- Örnekleme hızı ve kanal sayısı

- Ses parçaları mevcut oldukça, Runtime Viseme Generator'ınızdan

ProcessAudioDatafonksiyonunu bu parametrelerle çağırın

Gerçekçi Model, Standart Model ile aynı ses işleme iş akışını kullanır, ancak VisemeGenerator yerine RealisticLipSyncGenerator değişkeni ile.

Ruh Hali Etkinleştirilmiş Model aynı ses işleme iş akışını kullanır, ancak MoodMetaHumanLipSyncGenerator değişkeni ve ek ruh hali yapılandırma yetenekleri ile.

Not: Akış ses kaynakları kullanırken, bozuk oynatmayı önlemek için ses oynatma zamanlamasını uygun şekilde yönettiğinizden emin olun. Daha fazla bilgi için Streaming Sound Wave belgelerine bakın.

İşleme Performans İpuçları

-

Parça Boyutu: Daha duyarlı dudak senkronizasyonu için ses verilerini daha küçük parçalarda işlemek istiyorsanız,

SetNumSamplesPerChunkfonksiyonundaki hesaplamayı ayarlayın. Örneğin, örnekleme hızını 100'e bölmek (her ~10 ms'de akış) yerine 150'ye bölmek (her ~6.67 ms'de akış), daha sık dudak senkronizasyonu güncellemeleri sağlayacaktır. -

Arabellek Yönetimi: Ruh hali etkinleştirilmiş model, sesi 320 örnekli karelerde (16kHz'de 20ms) işler. Optimum performans için ses giriş zamanlamanızın buna uyumlu olduğundan emin olun.

-

Üreteç Yeniden Oluşturma: Gerçekçi modellerle güvenilir çalışma için, bir süre hareketsizlikten sonra yeni ses verisi beslemek istediğinizde üreteci her seferinde yeniden oluşturun.

Sonraki Adımlar

Ses işlemeyi kurduktan sonra şunları yapmak isteyebilirsiniz:

- Dudak senkronizasyonu davranışınızı hassas ayarlamak için Yapılandırma seçenekleri hakkında bilgi edinin

- Gelişmiş ifade için kahkaha animasyonu ekleyin

- Dudak senkronizasyonunu, Yapılandırma kılavuzunda açıklanan katmanlama tekniklerini kullanarak mevcut yüz animasyonlarıyla birleştirin