翻译服务提供商

AI Localization Automator支持五种不同的 AI 服务提供商,每种都有其独特的优势和配置选项。选择最适合您项目需求、预算和质量要求的提供商。

Ollama(本地 AI)

最适合:注重隐私的项目、离线翻译、无限制使用

Ollama 在您的机器上本地运行 AI 模型,提供完全的隐私和控制,无需 API 成本或互联网要求。

热门模型

- llama3.2(推荐的通用模型)

- mistral(高效替代方案)

- codellama(代码感知翻译)

- 以及更多社区模型

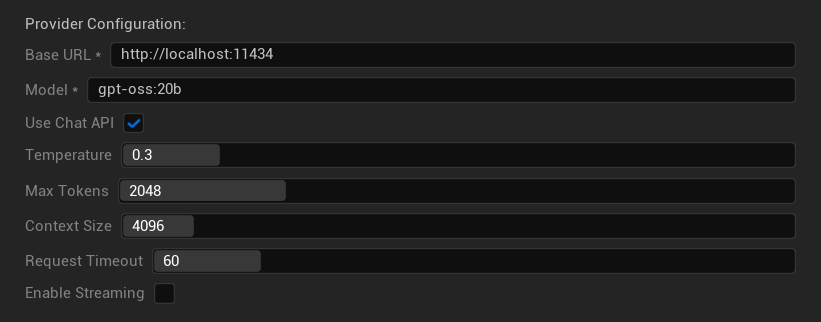

配置选项

- 基础 URL:本地 Ollama 服务器(默认:

http://localhost:11434) - 模型:本地安装的模型名称(必需)

- 使用聊天 API:启用以获得更好的对话处理

- 温度:0.0-2.0(推荐 0.3)

- 最大令牌数:1-8,192 个令牌

- 上下文大小:512-32,768 个令牌

- 请求超时:10-300 秒(本地模型可能较慢)

- 启用流式传输:用于实时响应处理

优势

- ✅ 完全隐私(数据不会离开您的机器)

- ✅ 无 API 成本或使用限制

- ✅ 可离线工作

- ✅ 完全控制模型参数

- ✅ 种类繁多的社区模型

- ✅ 无供应商锁定

注意事项

- 💻 需要本地设置和性能足够的硬件

- ⚡ 通常比云提供商慢

- 🔧 需要更多技术设置

- 📊 翻译质量因模型而异(有些可能超过云提供商)

- 💾 模型需要大量存储空间

设置 Ollama

- 安装 Ollama:从 ollama.ai 下载并安装到您的系统

- 下载模型:使用

ollama pull llama3.2下载您选择的模型 - 启动服务器:Ollama 会自动运行,或使用

ollama serve启动 - 配置插件:在插件设置中设置基础 URL 和模型名称

- 测试连接:应用配置时,插件将验证连接性

OpenAI

最适合:最高的整体翻译质量、广泛的模型选择

OpenAI 通过其 API 提供行业领先的语言模型,包括最新的 GPT 模型和新的 Responses API 格式。

可用模型

- gpt-5(最新的旗舰模型)

- gpt-5-mini(更小、更快的变体)

- gpt-4.1 和 gpt-4.1-mini

- gpt-4o 和 gpt-4o-mini(优化模型)

- o3 和 o3-mini(高级推理)

- o1 和 o1-mini(上一代)

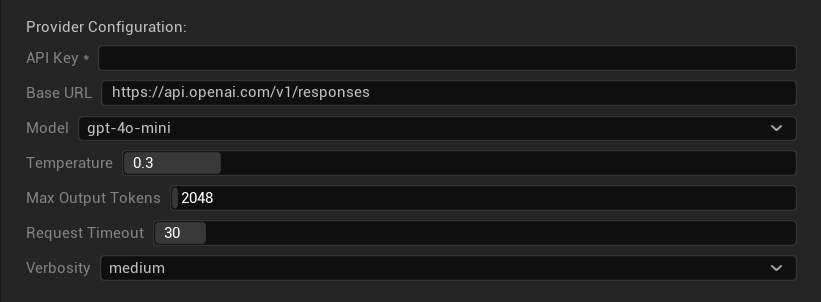

配置选项

- API Key: 您的 OpenAI API 密钥(必需)

- Base URL: API 端点(默认:OpenAI 服务器)

- Model: 从可用的 GPT 模型中选择

- Temperature: 0.0-2.0(推荐 0.3 以确保翻译一致性)

- Max Output Tokens: 1-128,000 个令牌

- Request Timeout: 5-300 秒

- Verbosity: 控制响应详细程度

优势

- ✅ 持续提供高质量的翻译

- ✅ 出色的上下文理解能力

- ✅ 强大的格式保留能力

- ✅ 广泛的语言支持

- ✅ 可靠的 API 正常运行时间

注意事项

- 💰 每次请求成本较高

- 🌐 需要互联网连接

- ⏱️ 使用限制基于订阅层级

Anthropic Claude

最适合:细致入微的翻译、创意内容、注重安全性的应用

Claude 模型擅长理解上下文和细微差别,使其成为叙事性强的游戏和复杂本地化场景的理想选择。

可用模型

- claude-opus-4-1-20250805 (最新旗舰版)

- claude-opus-4-20250514

- claude-sonnet-4-20250514

- claude-3-7-sonnet-20250219

- claude-3-5-haiku-20241022 (快速高效)

- claude-3-haiku-20240307

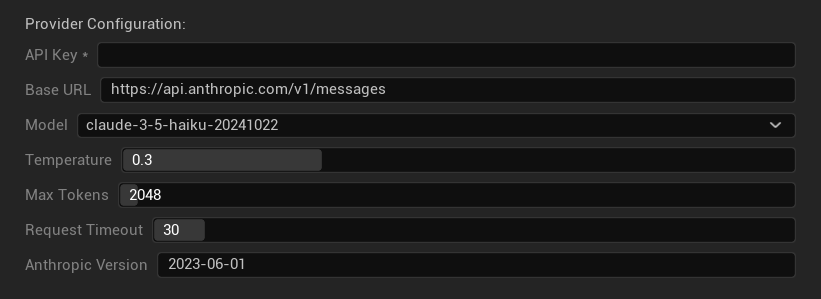

配置选项

- API Key: 您的 Anthropic API 密钥(必需)

- Base URL: Claude API 端点

- Model: 从 Claude 模型系列中选择

- Temperature: 0.0-1.0(推荐 0.3)

- Max Tokens: 1-64,000 个令牌

- Request Timeout: 5-300 秒

- Anthropic Version: API 版本标头

优势

- ✅ 卓越的上下文感知能力

- ✅ 非常适合创意/叙事内容

- ✅ 强大的安全功能

- ✅ 详细的推理能力

- ✅ 出色的指令遵循能力

注意事项

- 💰 高级定价模式

- 🌐 需要互联网连接

- 📏 令牌限制因模型而异

DeepSeek

最适合:经济高效的翻译、高吞吐量、预算敏感的项目

DeepSeek 以极具竞争力的价格提供优质的翻译质量,使其成为大规模本地化项目的理想选择。

可用模型

- deepseek-chat (通用型,推荐)

- deepseek-reasoner (增强的推理能力)

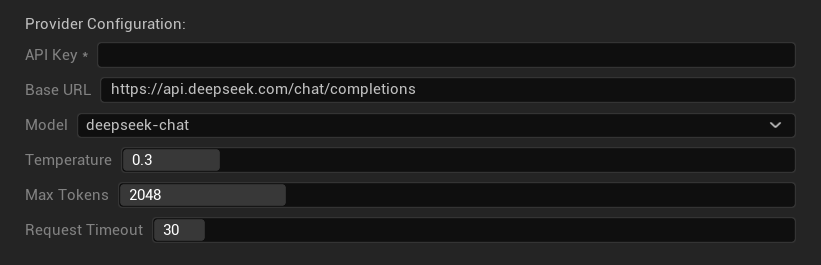

配置选项

- API Key: 您的 DeepSeek API 密钥(必需)

- Base URL: DeepSeek API 端点

- Model: 在聊天模型和推理模型之间选择

- Temperature: 0.0-2.0(推荐 0.3)

- Max Tokens: 1-8,192 个令牌

- Request Timeout: 5-300 秒

优势

- ✅ 非常经济高效

- ✅ 良好的翻译质量

- ✅ 快速的响应时间

- ✅ 配置简单

- ✅ 高频率限制

注意事项

- 📏 较低的 Token 限制

- 🆕 较新的提供商(记录较少)

- 🌐 需要互联网连接

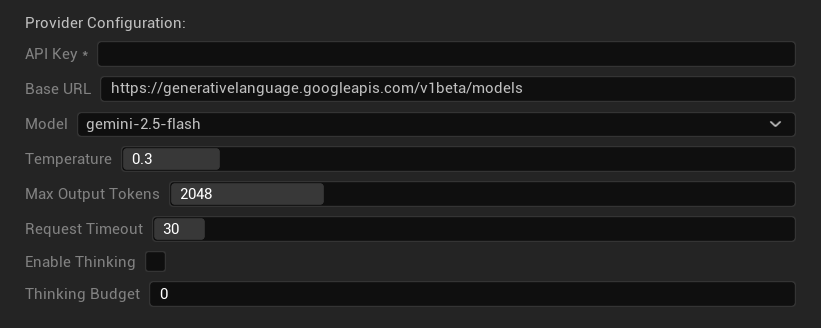

Google Gemini

最适合:多语言项目、经济高效的翻译、Google 生态系统集成

Gemini 模型提供强大的多语言能力,具有有竞争力的定价和独特功能,如用于增强推理的思考模式。

可用模型

- gemini-2.5-pro(最新的旗舰版,带思考功能)

- gemini-2.5-flash(快速,支持思考)

- gemini-2.5-flash-lite(轻量级变体)

- gemini-2.0-flash 和 gemini-2.0-flash-lite

- gemini-1.5-pro 和 gemini-1.5-flash

配置选项

- API 密钥:您的 Google AI API 密钥(必需)

- 基础 URL:Gemini API 端点

- 模型:从 Gemini 模型系列中选择

- 温度:0.0-2.0(推荐 0.3)

- 最大输出 Token 数:1-8,192 个 Token

- 请求超时:5-300 秒

- 启用思考:为 2.5 模型激活增强推理

- 思考预算:控制思考 Token 的分配

优势

- ✅ 强大的多语言支持

- ✅ 有竞争力的定价

- ✅ 高级推理(思考模式)

- ✅ Google 生态系统集成

- ✅ 定期模型更新

注意事项

- 🧠 思考模式会增加 Token 使用量

- 📏 不同模型的 Token 限制不同

- 🌐 需要互联网连接

选择合适的提供商

| 提供商 | 最适合 | 质量 | 成本 | 设置 | 隐私 |

|---|---|---|---|---|---|

| Ollama | 隐私/离线 | 可变* | 免费 | 高级 | 本地 |

| OpenAI | 最高质量 | ⭐⭐⭐⭐⭐ | 💰💰💰 | 简单 | 云端 |

| Claude | 创意内容 | ⭐⭐⭐⭐⭐ | 💰💰💰💰 | 简单 | 云端 |

| DeepSeek | 预算项目 | ⭐⭐⭐⭐ | 💰 | 简单 | 云端 |

| Gemini | 多语言 | ⭐⭐⭐⭐ | 💰 | 简单 | 云端 |

*Ollama 的质量因所使用的本地模型而有显著差异——一些现代本地模型可以匹配或超越云端提供商。

提供商配置提示

对于所有云端提供商:

- 安全存储 API 密钥,不要将其提交到版本控制中

- 从保守的温度设置(0.3)开始以获得一致的翻译

- 监控您的 API 使用情况和成本

- 在进行大规模翻译之前先进行小批量测试

对于 Ollama:

- 确保有足够的 RAM(推荐 8GB+ 以运行更大的模型)

- 使用 SSD 存储以获得更好的模型加载性能

- 考虑使用 GPU 加速以获得更快的推理速度

- 在依赖其进行生产翻译之前先在本地测试